随着AI在生成视频内容方面能力的不断提升,如何有效评估这些视频成为了一个重要的挑战。与静态图像或文本不同,视频内容涉及复杂的时空动态,这需要在视频呈现质量、语义信息传递、与人类意图的一致性以及与物理世界的虚拟现实一致性等方面进行更全面和系统的评估。本文调查了新兴的AI生成视频评估(AIGVE)领域,强调了评估AI生成视频与人类感知的一致性及其满足特定指令的重要性。我们对现有的可能用于评估AI生成视频的方法进行了结构化分析,概述了当前方法的优势和不足,并呼吁开发更加健全和细致的评估框架,以应对视频内容的复杂性。这些框架不仅包括传统的基于指标的评估,还涵盖当前涉及人类参与的评估以及未来以模型为中心的评估。本文旨在为来自学术界的研究人员和工业界的从业者建立一个基础知识库,促进未来AI生成视频内容评估方法的发展。

1 引言

随着大型生成模型如ChatGPT [172]、Sora [173]、LLaMA [231] 和最近的Meta Movie Gen [156] 的推出和广泛应用,AI生成内容在内容的生产和消费中变得越来越重要。在生产领域,文本和视频专业人员越来越多地使用生成工具来创建和增强内容,从剧本和文章到复杂的视觉序列,传统上这些内容的手工制作需要大量的时间和精力,而现在生成工具可以简化创意工作流程并提高生产效率 [103, 303, 7]。在消费方面,依赖生成模型输出也变得司空见惯,应用范围从信息检索到日常任务自动化。这一转变与2023年之前的时代形成了鲜明对比,当时这些任务主要是手动完成的。

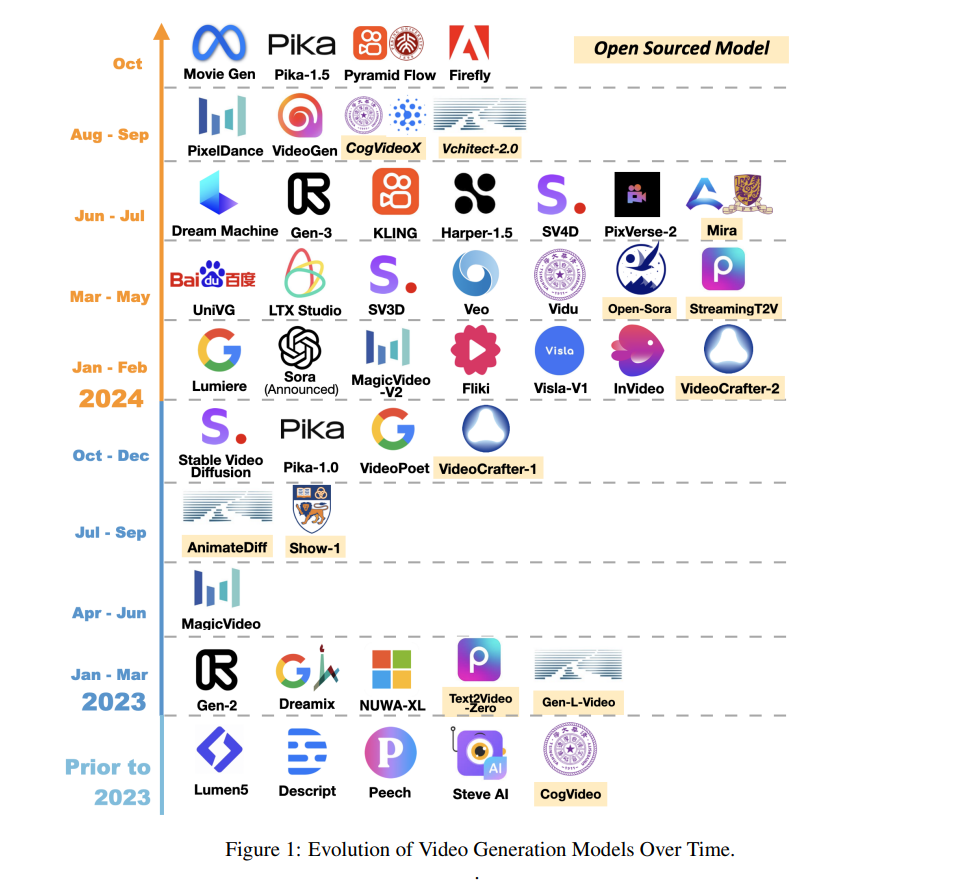

随着这一趋势的不断发展,能够自动评估这些AI生成内容的方法变得至关重要。这些方法有助于确保内容与人类的感知和指令保持一致。虽然AI生成文本和图像的评估已经通过多种技术得到了广泛研究,包括单词和像素匹配 [128, 73, 204, 178],复杂建模 [72, 292, 63],以及大规模/视觉语言模型的评估 [56, 109, 79, 294],但AI生成视频的评估面临着独特的挑战,目前尚未得到全面解决。这一差距突显了研究中的重要不足,尤其是在先进视频生成模型快速发展的当下,如图1所示,视频内容在专业和个人领域都日益占据重要地位。视频本质上结合了空间复杂性和时间动态,使其评估比静态图像或文本更为复杂。传统的视频质量评估(VQA)指标主要关注技术方面,如压缩效果、传输质量 [137, 40, 152, 181, 154]。最近的研究则更多关注用户生成的“野外”视频的感知质量,考虑了模糊、运动稳定性和噪声水平等因素 [266, 255, 104]。这些方法评估了视频是否能够有效向观众传达视觉信息。然而,在AI生成内容(AIGC)时代,另一个关键因素是生成内容是否符合创作者的指令,而这一点在当前的VQA框架中尚未得到充分探索。此外,当前关于AI生成视频评估的研究正在快速兴起,但仍缺乏结构化体系。随着新模型和评估指标的不断引入,识别全面资源的过程变得更加复杂,因为这些资源通常分散在不同领域。此外,这些方法关注不同的评估方面,这些方面可能重叠或完全脱节。因此,缺乏统一框架阻碍了该领域的进展,导致研究工作碎片化。因此,在这一快速发展的领域中,亟需一种更加连贯的研究方法。在本综述中,我们旨在突出一个新的研究领域,即AI生成视频评估(AIGVE)。为了深入探讨这一领域,我们收集并整合了相关领域的现有研究,以帮助学术研究人员和工业界从业者获取必要的基础知识。我们重点分析了与VQA [159]、多模态文本-视觉对齐 [278] 和最近出现的AIGVE评估方法 [139, 82, 157] 相关的现有研究。通过探索和分类与AIGVE相关的方法,我们希望为AI生成视频评估奠定坚实的基础,支持该领域未来的研究工作。本综述的主要贡献总结如下: * 强调新兴领域: 我们提出并强调了AI生成视频评估(AIGVE)这一新的研究领域的必要性。 * 现有评估方法的全面回顾: 本综述系统而全面地回顾了多个研究领域中与AIGVE相关的现有方法。我们对这些方法进行分类和分析,提供了一个结构清晰的现有研究概览。 * 未来研究方向的指导: 我们还指出了AIGVE领域中几个亟需进一步研究和发展的潜在方向。这些方向包括将评估框架与视觉语言模型相结合、增强评估分数的可解释性以及解决这些框架的伦理与安全问题。本综述旨在为研究人员和工业从业者提供基础资源,提供指导以推动AI生成视频内容的更有效和全面的评估方法的发展。

视频生成的进展

生成与现实世界一致并符合已知物理定律的视频,长期以来一直是一个备受关注且必要的研究课题。以往的大多数研究主要基于三类生成模型来执行视频生成任务:1) 生成对抗网络(GAN)[246, 237, 6, 18, 91, 283, 55, 230],2) 自回归Transformer [262, 59, 76, 102, 245, 275, 222],以及 3) 扩散模型 [75, 212, 74, 20, 287, 19, 129]。

基于GAN的模型: 在早期的视频生成探索中,基于GAN的模型曾是主流方法,可以视为图像GAN生成的时间延伸 [153, 192, 273, 288, 183, 92, 89]。具体而言,GAN生成模型包括生成器网络(即用于生成视频)和判别器网络(即用于区分哪些是生成的“伪”视频)。在模型的训练过程中,这种迭代持续进行,直到生成器能够生成高质量的视频并欺骗判别器,而判别器能够最大限度地识别出“伪造”生成的视频。Vondrick等人 [246] 首次利用GAN进行视频生成,将视频分为动态的前景时空卷积和静态的背景空间卷积。Tulyakov等人 [237] 进一步采用基于递归机制的运动和内容解耦表示,用以生成运动嵌入和CNN框架生成视频。与使用2D卷积或递归网络表示时间维度的方式不同,后续的几项工作 [6, 18] 也尝试使用3D卷积网络来协调视频生成的时间维度。除了建模时间表示之外,Karras等人 [91] 尝试通过从低分辨率图像开始,逐步在空间和时间方向上生成高分辨率视频。

基于自回归Transformer的模型: 与此同时,Transformer模型的广泛适应性 [242] 及其在多种任务上的有效性 [130, 65],使其成为视频生成的另一条可选途径。类似于在文本中使用Transformer的技术,视频生成也将输入模态(如文本和图像)转换为序列化的令牌,并通过编码器输入到模型中。然后,基于自回归的Transformer被训练用来解码生成视频的每一帧。Wu等人 [262] 首次使用VQ-VAE [241] 和三维稀疏注意力机制进行开放域文本到视频生成。Ge等人 [59] 提出结合时间无关的VQGAN生成图像与时间敏感的Transformer生成长视频。借鉴文本到图像生成中的预训练模型,Hong等人 [76] 提出了基于[48] 的多帧率层次训练策略,以更好地对齐文本和视频片段。

随着大规模语言模型(LLM)的出现和快速发展,一些工作 [102, 245, 275, 222] 开始探索如何利用LLM的强大能力进行视频生成。其中一个代表性工作,Kondratyuk等人 [102] 将所有模态(如文本、图像、深度+光流、掩码视频)编码为离散令牌空间,直接使用LLM架构进行视频生成。 扩散模型: 近年来,文本到图像生成领域取得的重大突破 [203, 53, 46, 169, 199, 57] 使得扩散模型成为了最近视频生成研究中的主流方法。受扩散模型在图像生成中成功应用的启发,许多研究开始尝试在视频生成中使用它们。扩散模型 [216] 依赖于从噪声分布中抽取的样本进行迭代去噪来生成最终结果。在文本到视频生成中,将噪声输入视频和相应的文本嵌入输入到去噪网络中。Ho等人 [75] 首次将标准的图像扩散架构扩展到视频数据,使用3D U-Net扩散模型架构对整个视频进行建模。Singer等人 [212] 使用伪3D卷积和注意力层扩展了文本到图像的扩散模型,每个空间2D卷积层后跟一个时间1D卷积层,减少了相较于计算3D卷积层所需的计算资源。在早期视频扩散模型的基础上,Ho等人 [74] 探索了使用空间超分辨率(SSR)和时间超分辨率(TSR)模型生成更高分辨率视频;Blattmann等人 [20] 将文本到图像的潜在扩散模型(LDM)Stable Diffusion扩展为生成高分辨率的长期视频。

Zhang等人 [287] 进一步结合了基于像素和潜在空间的文本到视频扩散模型(VDM)来生成视频:首先使用基于像素的VDM生成低分辨率视频,然后通过基于潜在空间的VDM对其进行上采样,生成高分辨率视频。Blattmann等人 [19] 展示了经过精心策划的预训练数据集对于生成高质量视频的重要性,并提出了系统的数据预处理流程,包括数据准备的字幕和过滤策略。最近的工作Lin等人 [129] 进一步调整了预训练的ControlNets [290] 以支持视频生成,包括视频控制、稀疏帧视频控制以及各种下游任务,如视频编辑和文本引导的运动控制。

上述基础技术的进展大大提升了最近视频生成模型的性能。这些模型在开源和商业领域都实现了快速增长,在生成内容的保真度和时长方面不断提升,如图2上半部分所示。

尽管如此,生成视频的质量仍面临重大挑战。如图2下半部分所示,生成的视频通常存在两个主要问题:(1)与人类感知预期不一致;(2)偏离创作者的指令,导致误导性输出。这些问题往往非常微妙,在初步审查时很难察觉。解决这些问题需要开发强有力的评估方法。然而,除了人工评估之外,目前尚缺乏系统且全面的自动化评估框架,来一致性地评估AI生成视频的质量。

AI生成视频评估

AI生成视频评估领域仍处于早期阶段。随着合成视频内容的日益普及,亟需有效的评估方法,以确保其符合创作者的意图和观众的感知。本文综述旨在为AI生成视频评估(AIGVE)提出一个初步框架,认识到随着该领域的成熟,我们的定义和理解将不断演变。

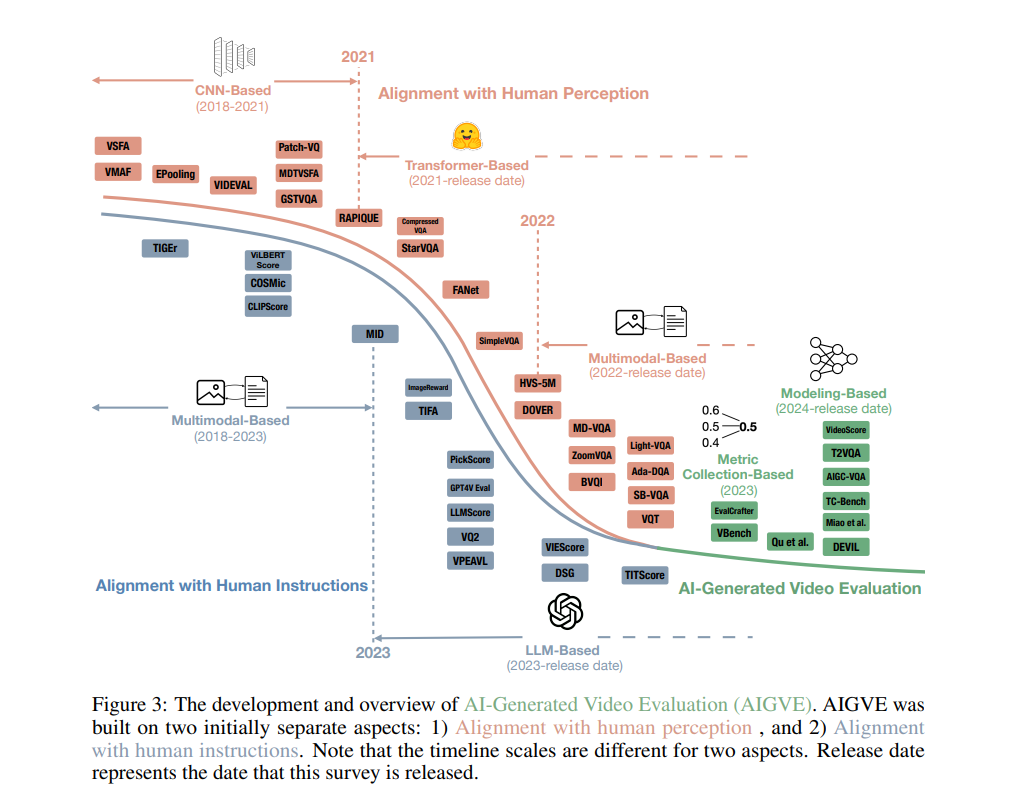

通过广泛审查和分类现有研究 [159, 266, 141, 139],我们建议AI生成的视频应满足两个主要标准:1)与人类感知的对齐;2)与人类指令的对齐。

与人类感知的对齐: 该方面强调通过评估传统指标来衡量视频质量,如高分辨率、清晰度和无噪声 [159]。此外,AI生成内容增加了额外的复杂性,因为视频还必须保持与物理世界的一致性 [205, 226]。这涉及逼真的纹理渲染、准确的色彩表现和对物理定律的遵守,确保视频不仅具有高质量,而且具有可信度和沉浸感。 与人类指令的对齐: 随着高级生成AI技术的引入,确保视频精确符合详细的人类指令这一新挑战也随之出现,目前这些指令主要基于文本。这要求生成的内容能够准确反映所描述的场景、动作和叙述,从而实现创作者的创意和沟通目标。此对齐确保视频内容不仅符合技术标准,还满足创作者的创意和沟通意图,使其成为人类指令的真实反映。

图3展示了这两个方面的发展概览,并强调了AIGVE的兴起。最初,评估视频与人类感知和指令的对齐是两个独立的研究领域。随着AI生成视频的兴起,在评估AI生成视频时需要同时考虑这两个领域。 在本节的其余部分中,我们介绍了AIGVE的发展。首先,介绍了基准数据集的创建过程,将视频-意见对转换为视频-指令-意见三元组,以进行更细致的评估。然后,评估方法分为两大主要方法:指标收集评估,使用现有指标来评估视频质量的各个方面;以及建模评估,通过在收集的数据集上开发和训练新模型来模拟人类判断。