【Tutorial】计算机视觉中的Transformer,98页ppt

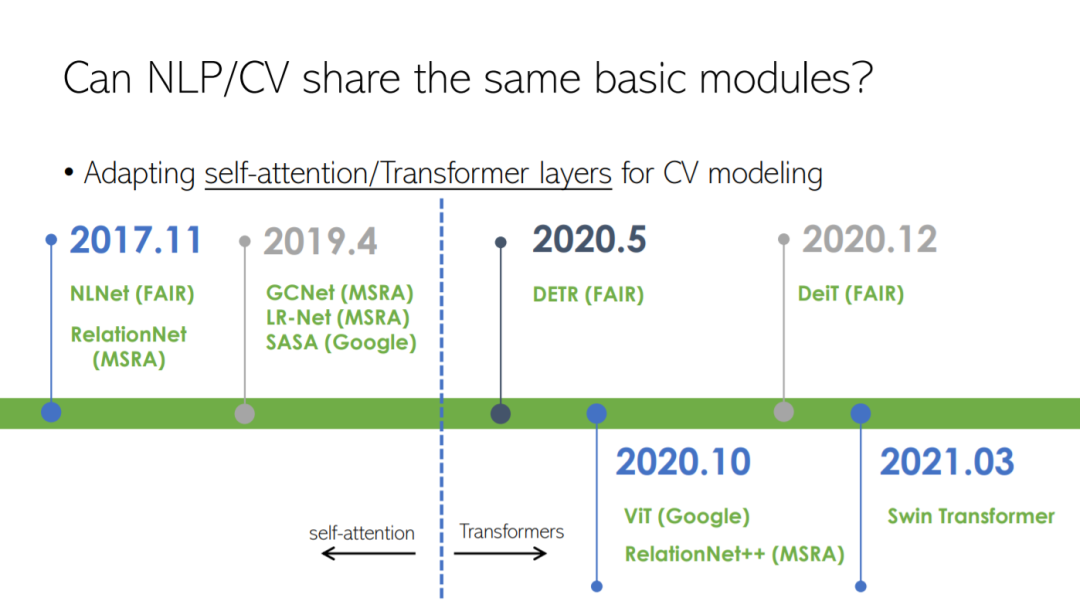

在2017年谷歌设计了Transformer,并在NLP社区显示出了效果之后,有大量的工作专注于将其应用到计算机视觉社区。本文首先简要介绍了计算机视觉中的Transformer。然后,介绍了Transformer模型在低/高级视觉任务、模型压缩和主干设计方面的一些代表性工作。

曹越,现任微软亚洲研究院视觉计算组主管研究员,分别于2014年和2019年在清华大学软件学院获得本科和博士学位,曾于2017年获微软学者奖学金、2018年获清华大学特等奖学金。至今在CVPR、ICCV、ICLR、ICML、NeurIPS等国际会议和期刊中发表论文20余篇,其中有三篇入围PaperDigest Most Influential Papers榜单,谷歌引用五千余次。目前主要的研究兴趣是自监督学习、多模态学习以及自注意力建模。

http://yue-cao.me

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“T98” 就可以获取《【Tutorial】计算机视觉中的Transformer,98页ppt》专知下载链接

登录查看更多

相关内容

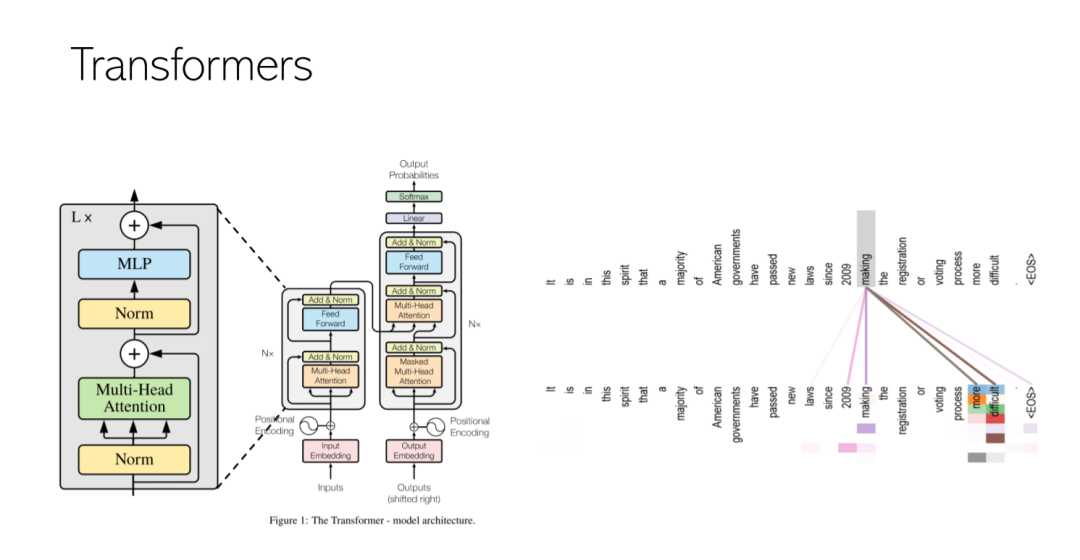

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

【CVPR 2019 | tutorial】视觉识别Visual Recognition and Beyond,Facebook|Ross Girshick,Justin Johnson(李飞飞高徒)

专知会员服务

29+阅读 · 2019年6月16日