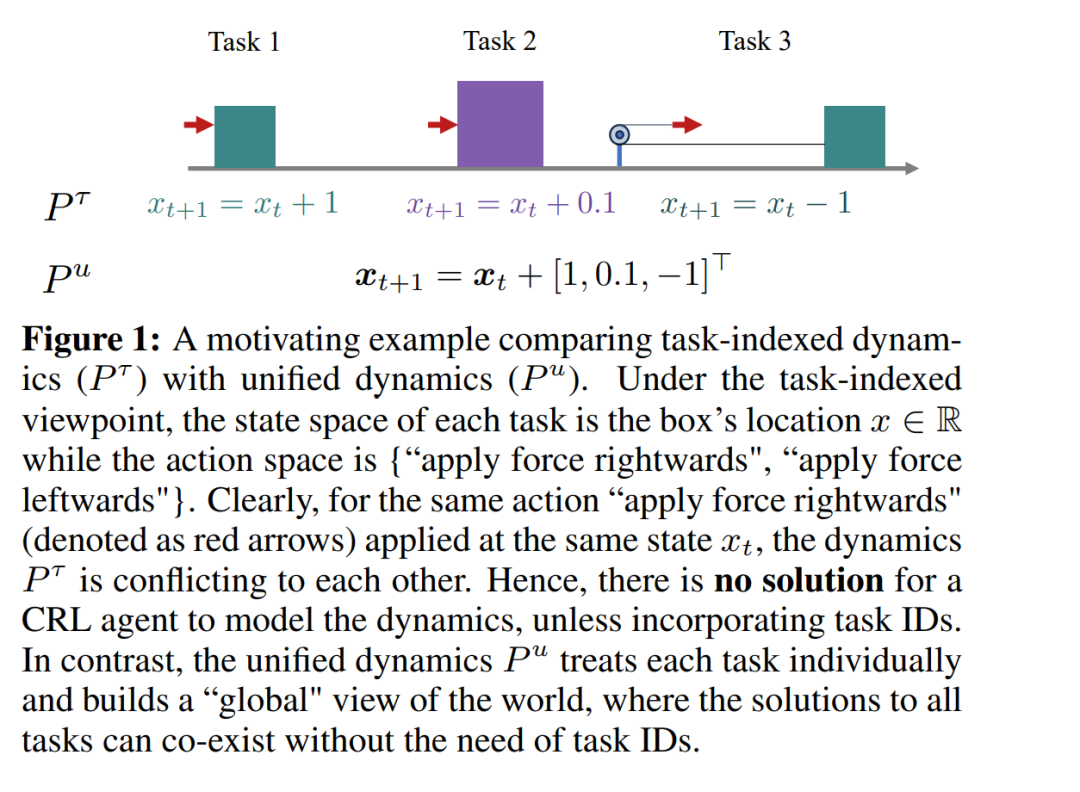

持续强化学习(CRL)指的是在一个自然的环境中,智能体需要通过不断地试错来解决顺序呈现的多个任务。CRL 面临的最大挑战之一是,当智能体学习新任务时,可能会忘记如何解决先前的任务,这种现象被称为灾难性遗忘。本文提出通过在线世界模型进行规划来应对这一挑战。具体而言,我们在线学习一个“跟随领导者”(Follow-The-Leader,FTL)浅层模型,以捕捉世界动态,在此基础上使用模型预测控制(MPC)进行规划,解决由任何奖励函数指定的一组任务。在线世界模型通过结构上的设计来防止遗忘,在温和假设下,具有 O(√K²D log(T)) 的已证明遗憾界限。该规划器仅根据最新的在线模型搜索动作,从而形成一个增量更新的 FTL 在线智能体(OA)。为了评估 OA,我们进一步设计了一个名为“持续基准”(Continual Bench)的环境专门用于 CRL,并在相同的模型规划算法框架下与几种强大的基准方法进行了比较。实验证明,OA 能够持续学习并解决新任务,同时不忘记旧技能,且优于基于深度世界模型和各种持续学习技术构建的智能体。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

152+阅读 · 2023年3月29日