量子计算机是下一代设备,有望完成经典计算机无法完成的计算。实现这一目标的一种主要方法是通过量子机器学习,特别是量子生成学习。由于量子力学固有的概率性质,我们有理由假设量子生成学习模型(QGLMs)可能会超越经典模型。因此,QGLMs 越来越受到量子物理和计算机科学领域的关注,各种可以在近期量子机上高效实现且具有潜在计算优势的QGLMs被提出。本文从机器学习的角度综述了QGLMs 的研究进展。特别地,我们解释了这些QGLMs ,包括量子电路Born机器、量子生成对抗网络、量子玻尔兹曼机器和量子自编码器,作为经典生成学习模型的量子扩展。在此背景下,我们探讨它们的内在联系和根本区别。我们进一步总结了QGLMs 在传统机器学习任务和量子物理中的潜在应用。最后,我们讨论了QGLMs 面临的挑战和进一步的研究方向。

https://www.zhuanzhi.ai/paper/10f0db3781222d991dcdde521af288f6

在过去的十年中,深度生成学习模型(GLM)彻底改变了经典世界[1],包括但不限于计算机视觉[2]、自然语言处理[3]和药物发现[4]。GLM的空前成功源于深度神经网络的强大力量,它可以有效地捕获训练数据的底层分布,然后从相同的分布中生成新的样本。由于这一特性,GLM最近被用于解决量子物理科学中的基本问题。也就是说,GLM被用来解决量子物理[5]中遇到的“维度诅咒”。与传统方法相比,该方法总体性能更好,泛化能力也有所提高。所有这些特征都有助于物理学家理解自然机制。

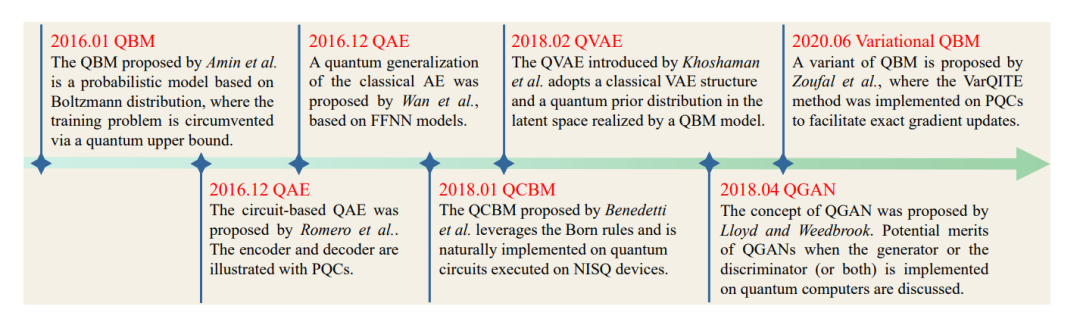

在设计先进的GLMs 和探索其潜在应用的同时,人工智能的另一个关键研究方向是寻找具有增强能力的下一代GLMs 。目前的挑战是克服GLMs 的计算开销,因为摩尔定律的极限接近[6]。为此,一个领先的解决方案是在量子计算机上执行GLMs ,这已经展示了强大的理论和实验性能[7,8]。在这方面,研究人员做了大量工作来设计量子生成学习模型(QGLMs),使其能够在具有计算优势的噪声中尺度量子机器[9]上高效地进行。迄今为止,大量的研究已经证明了GLMs 在不同学习任务中的可行性,例如图像生成[10]、量子态近似[11]和药物设计[12]。

QGLMs 的快速发展需要对现有的工作进行系统的回顾,这将有利于计算机科学和量子物理社区的研究人员。为此,在本综述中,我们通过深度生成学习的视角分析了QGLMs 的当前进展。最后,根据遗传算法的典型协议,我们将遗传算法分为四种类型:量子电路波恩机(QCBM)、量子生成对抗网络(QGAN)、量子玻尔兹曼机(QBM)和量子自编码器(QAE)。对于每种类型的QGLM,我们首先介绍其开创性工作及其与经典对应的固有关系,然后阐明其变体和在传统机器学习和量子物理的潜在应用。据我们所知,这是在量子生成学习的背景下的第一次回顾。我们相信这项调查可以帮助不同背景的观众了解QGLMs的发展。

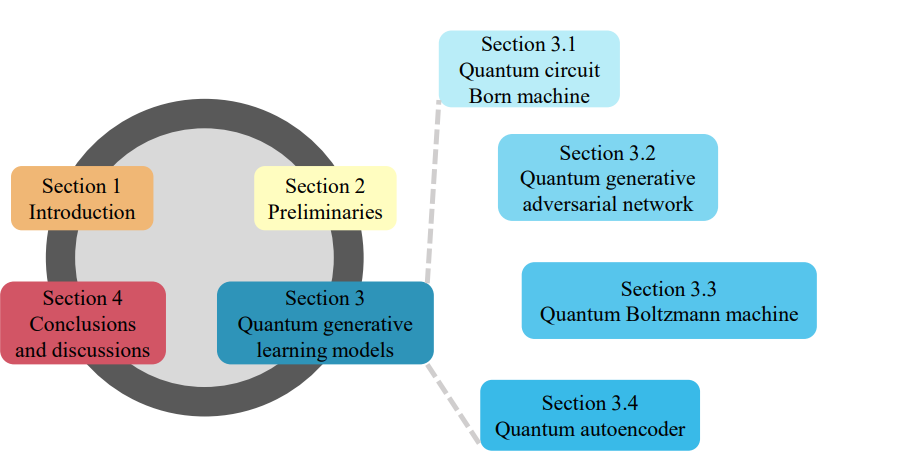

本次调研的结构如图1所示。在第2节中,我们介绍了深度神经网络的基本知识,典型的经典生成学习模型,量子计算和变分量子算法。在第3节中,我们系统地回顾了先前与QGLMs 相关的文献,并解释了它们与经典对应物的关系。根据QGLMs 的分类,本节包括四个子节,分别对QCBM、QGAN、QBM和QAE进行定位。在第4节中,我们讨论了量子生成学习的挑战和未来的方向。

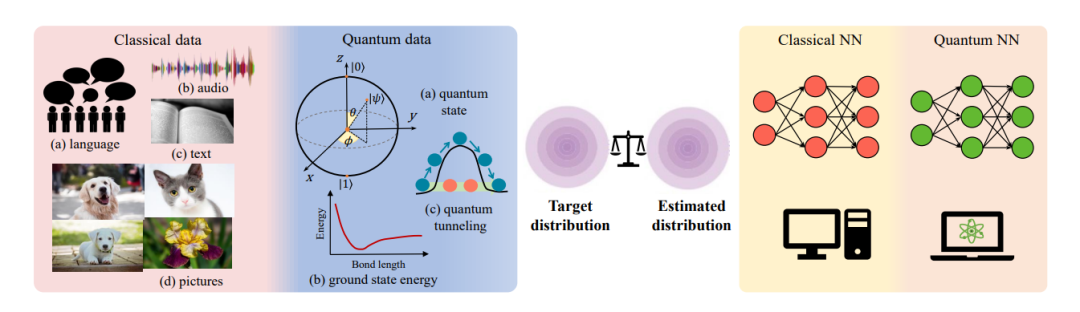

经典和量子生成学习模型概述。左边的面板说明了经典和量子生成学习的兴趣数据分布。右边的面板说明了经典和量子生成学习模型的类似工作机制(即,由经典神经网络和量子神经网络实现)。简而言之,两种学习模型的目的都是最小化它们生成的目标分布和估计分布之间的差异。最小化过程由经典优化器完成,该优化器不断更新学习模型的可训练参数。