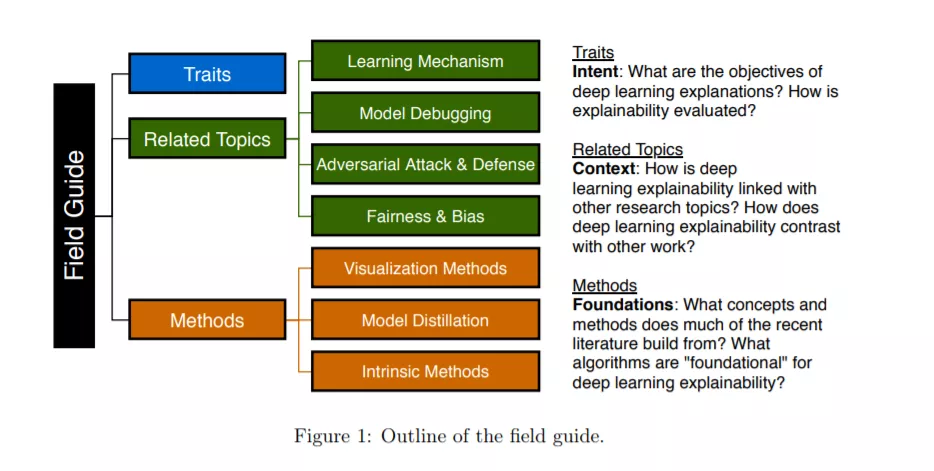

深度神经网络(DNN)是实现人类在许多学习任务上的水平的不可缺少的机器学习工具。然而,由于其黑箱特性,很难理解输入数据的哪些方面驱动了网络的决策。在现实世界中,人类需要根据输出的dna做出可操作的决定。这种决策支持系统可以在关键领域找到,如立法、执法等。重要的是,做出高层决策的人员能够确保DNN决策是由数据特征的组合驱动的,这些数据特征在决策支持系统的部署上下文中是适当的,并且所做的决策在法律上或伦理上是可辩护的。由于DNN技术发展的惊人速度,解释DNN决策过程的新方法和研究已经发展成为一个活跃的研究领域。在定义什么是能够解释深度学习系统的行为和评估系统的“解释能力”时所存在的普遍困惑,进一步加剧了这种复杂性。为了缓解这一问题,本文提供了一个“领域指南”,为那些在该领域没有经验的人提供深度学习解释能力指南: i)讨论了研究人员在可解释性研究中增强的深度学习系统的特征,ii)将可解释性放在其他相关的深度学习研究领域的背景下,iii)介绍了定义基础方法空间的三个简单维度。

成为VIP会员查看完整内容