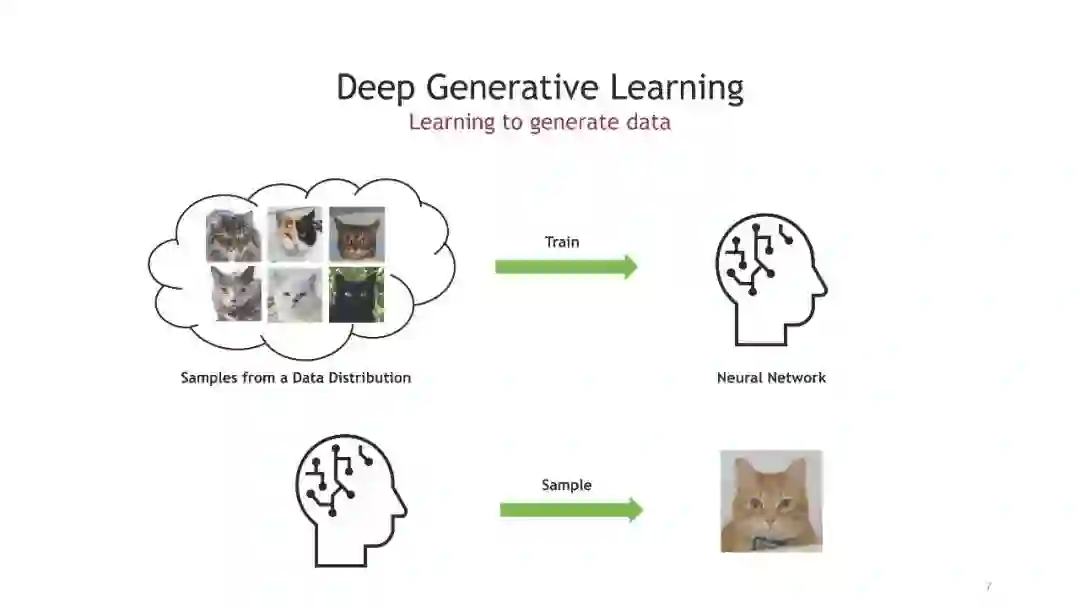

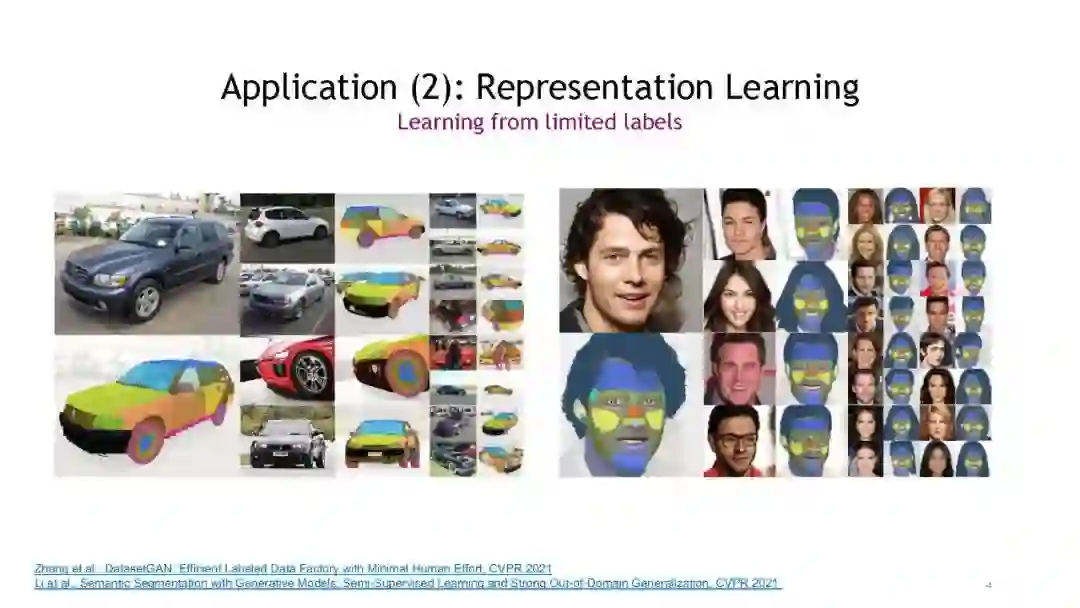

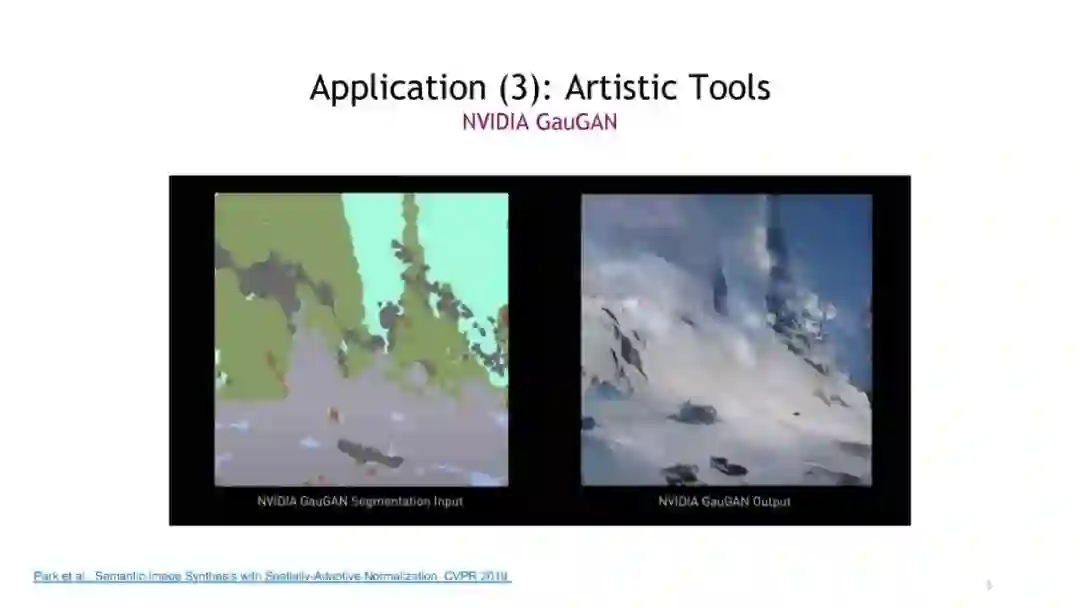

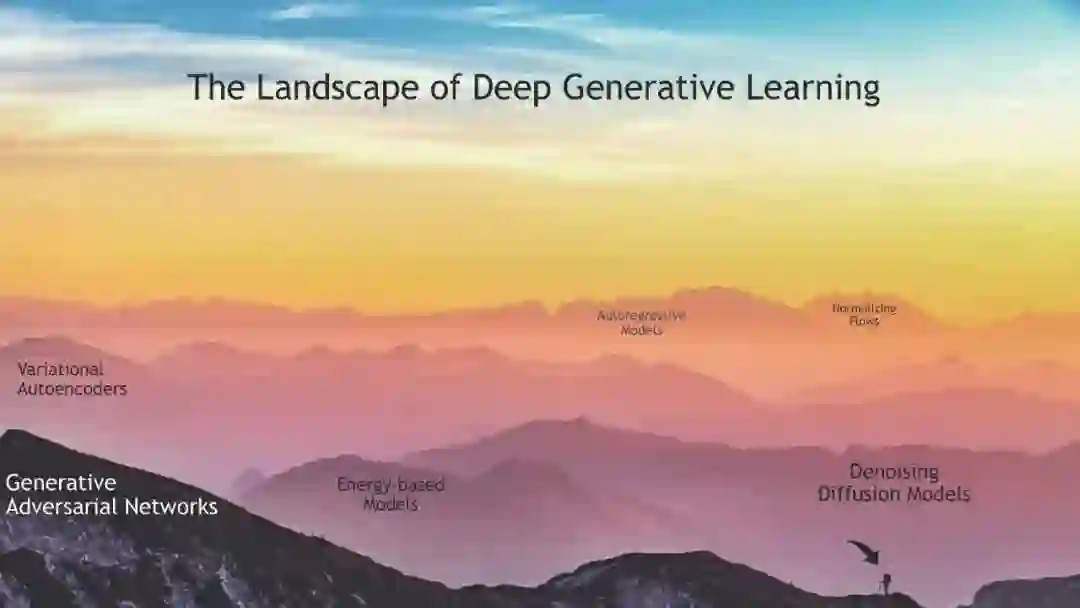

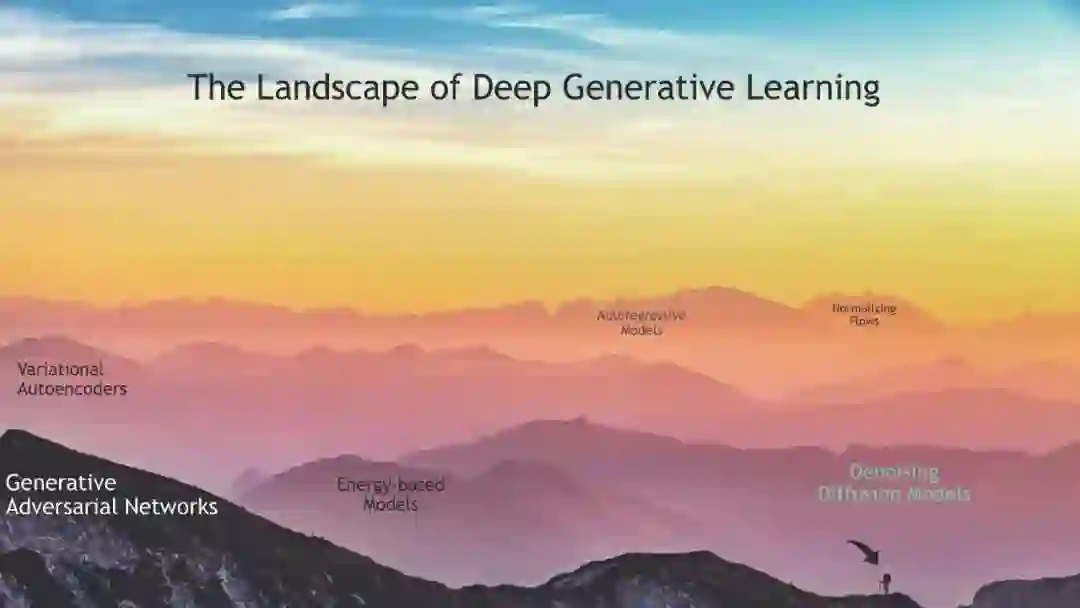

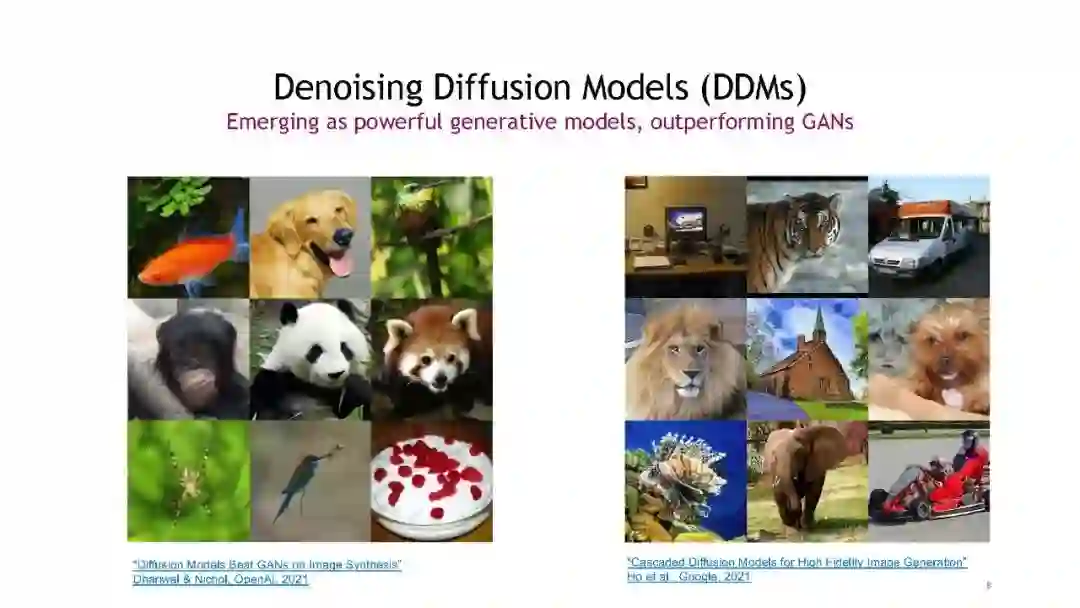

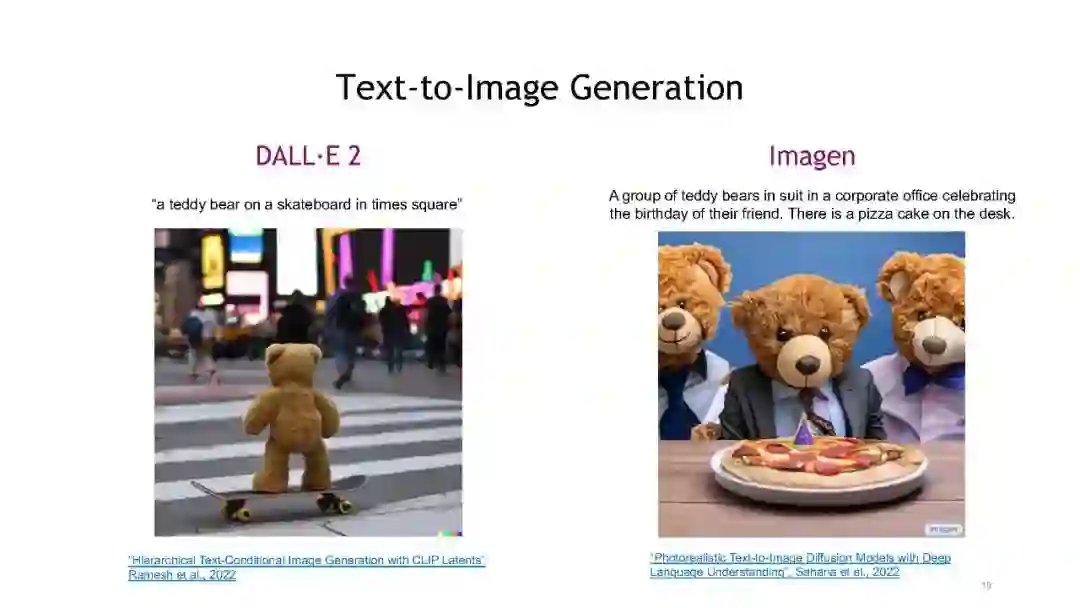

长期以来,生成学习领域(尤其是围绕图像生成的领域)被分为两派:(1)生成对抗网络(GANs)生成高质量的样本,代价是模式覆盖差和训练不稳定;(2)基于似然的模型,包括变分自动编码器(VAEs),归一化流和自回归模型,提供全模式覆盖往往以样本质量差为代价。最近,一种名为去噪扩散模型的新方法进入了生成学习领域,它以高样本质量和全面模式覆盖率解决了这两个学派的难题。然而,这也以样本生成速度慢为代价。在这次演讲中,我将简要回顾去噪扩散模型和我们最近在NVIDIA建立的一些成功的框架,使用这些模型,从文本到图像生成模型到3D形状模型和对抗鲁棒分类框架。然后,我将深入研究扩散模型的抽样挑战,并讨论我们为解决这些问题开发的三个框架。这些包括在潜在空间中训练扩散模型的基于潜在分数的生成模型,使用复杂多模态分布进行去噪的扩散GANs,以及以更少的步骤求解扩散模型中的抽样微分方程的高阶求解器。参考链接:

-- https://arxiv.org/abs/2106.05931: Score-based Generative Modeling in Latent Space

-- https://arxiv.org/abs/2112.07804: Tackling the Generative Learning Trilemma with Denoising Diffusion GANs

-- https://arxiv.org/abs/2210.05475 GENIE: Higher-Order Denoising Diffusion Solvers

CVPR2022开会了!英伟达&Google最新《基于扩散的去噪生成建模:基础与应用》教程,182页ppt带你学习高保真图像生成

Arash Vahdat是NVIDIA的首席研究科学家,专攻计算机视觉和机器学习。在加入NVIDIA之前,他是D-Wave Systems的一名研究科学家,在那里他致力于深度生成学习和弱监督学习。在D-Wave之前,Arash是西蒙弗雷泽大学(SFU)的一名研究教师,他领导了深度视频分析的研究,并教授大数据机器学习研究生水平的课程。在Greg Mori的指导下,Arash在SFU获得了视觉分析潜在变量框架的博士和硕士学位。他目前的研究领域包括深度生成学习、弱监督学习、高效神经网络和概率深度学习。