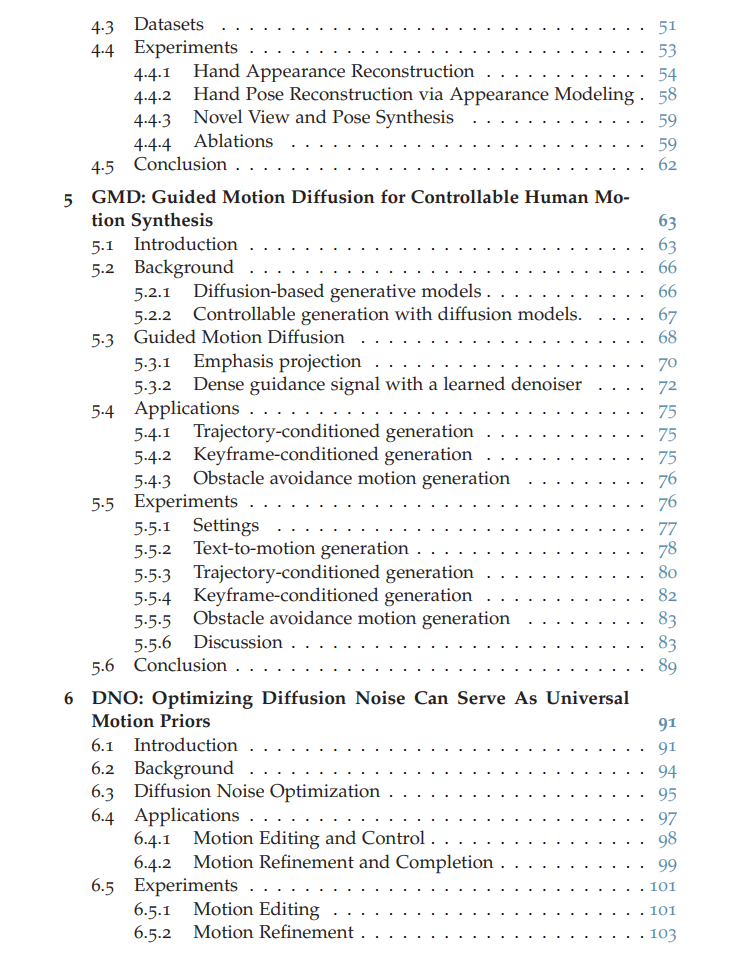

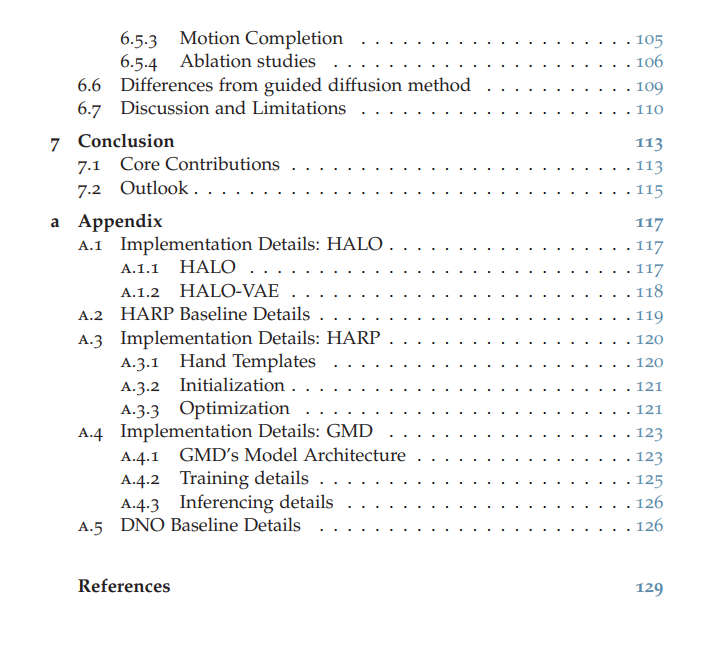

《人类动作与交互的生成式建模》世界的快速数字化深刻改变了日常生活的方方面面。从虚拟现实到自动驾驶,能够理解并驾驭三维空间的智能机器在这一进程中变得愈发重要。为了确保物理与数字空间的无缝交互,这些系统必须精确捕捉环境细节,并理解人类如何与周围世界互动。这一挑战的核心在于人类动作与交互的建模。人类行为受多种因素影响——无论是与不同物体的互动,还是环境布局的差异,都使得动作的多样性与环境的复杂性成为学习算法的重大挑战。此外,环境中无数可能微妙影响行为的细节,使得覆盖所有潜在场景的完整数据采集变得几乎不可能。本论文通过开发通用生成式建模框架应对上述挑战,这些框架能抽象化单个场景的具体特征,同时轻松适配新环境。我们重点研究人类交互的两大核心要素:手部动作与全身运动。核心贡献手部建模突破HALO(手部关节占据模型):弥合了基于骨骼与基于网格的手部模型间的鸿沟,通过关键点低维空间实现手部姿态的生成式建模,同时保留对手部交互至关重要的高保真表面细节。HARP(手部重建与个性化系统):通过单目视频还原手部外观细节,进一步提升了手部表观建模能力。全身运动生成引导运动扩散模型(GMD):基于去噪扩散模型(在图像生成中已获成功),开发了注重可控性的运动生成模型。GMD将稀疏空间约束有效融入运动合成,确保生成动作符合物理规律,适用于需要精确空间控制的游戏与虚拟现实应用。动态环境适配扩散噪声优化(DNO):将训练好的扩散模型转化为通用运动先验,无需针对每项任务重新训练模型即可支持运动编辑、去噪、混合及环境适配。DNO通过消除逐任务微调需求大幅降低训练成本,扩展了生成模型的应用场景。研究意义本论文通过提升生成式建模的真实感与适应性,推动了人类动作与交互建模的发展。我们的目标不仅是增强数字环境中人类动作的复现能力,更为理解人类行为及未来三维世界导航应用的开发奠定基础。