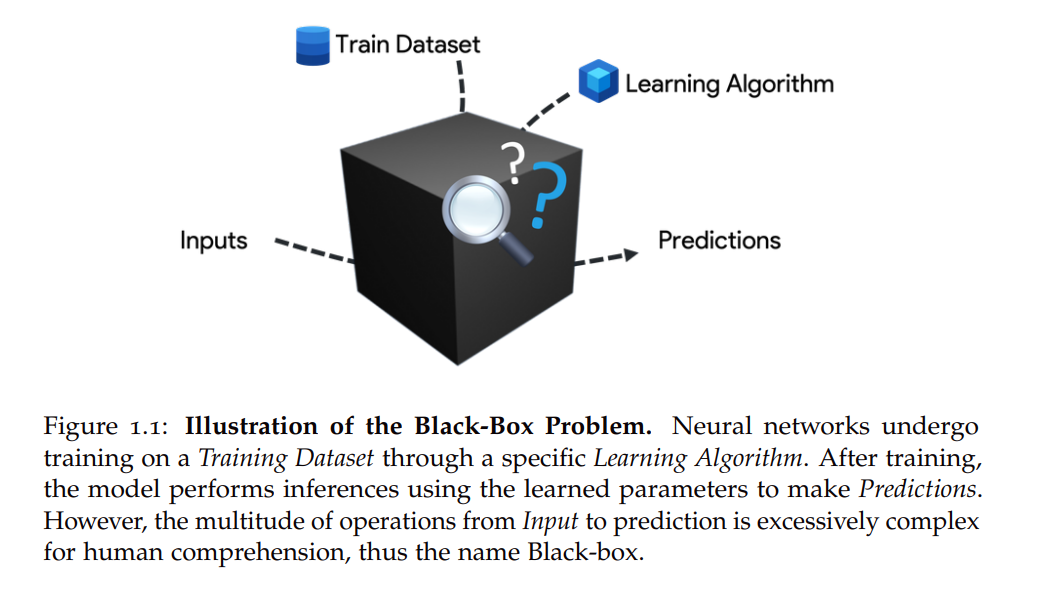

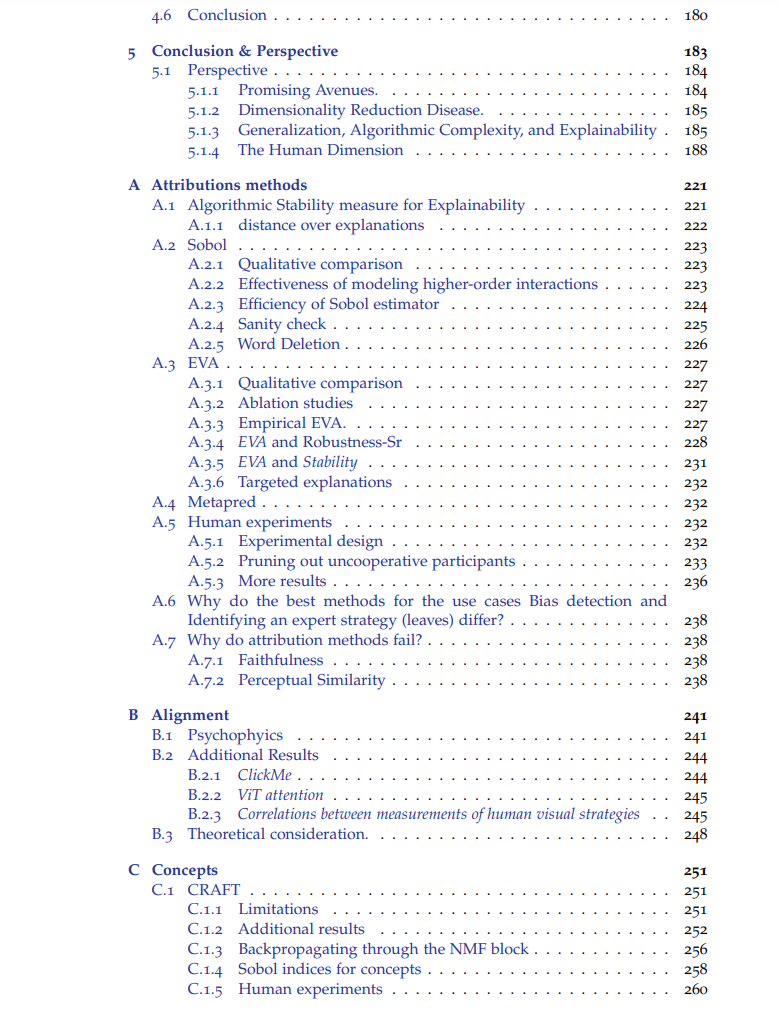

本论文旨在推动计算机视觉领域中可解释性技术的前沿发展,并开发相应的工具集,专注于增强我们对目前在视觉任务中使用的深度神经网络特征的理解。可解释性是改进人类与人工智能系统之间交互的关键领域,从科学角度来看,它也有助于解读一种全新的智能形式:人工智能。更具体地说,这些模型的复杂性和缺乏透明性构成了它们在关键系统中应用的主要障碍,并提出了一些重要问题,如果其机制能够被解码,可能会在我们理解智能的过程中带来显著进展。通过本论文,我们探索了几种可解释性方法,它们各自有助于提高视觉模型的可解释性,同时也承认其各自的局限性。 我们首先对归因方法(又称显著性图或热力图)进行了详细分析。这些技术通过热力图揭示模型在做出决策时关注的区域。第一篇论文提出了一种受算法稳定性启发的度量,该度量基于这些归因来评估模型提供的解释质量,从而识别出那些提供最佳解释的模型。接下来,我们介绍了一种受全局敏感性分析(Global Sensitivity Analysis)启发的新归因方法,该方法基于Sobol指标。这个黑箱方法,凭借坚实的理论基础,通过使用准蒙特卡罗序列,使得计算时间比现有方法减少了一半。然后,我们继续介绍第一个具有正式保证的归因方法——EVA,该方法依赖于已验证的扰动分析。 令人惊讶的是,在与实际用户进行的真实使用案例测试中,这些方法在帮助理解模型方面效果甚微。具体来说,在复杂场景中,这些技术表现不佳,而在简单场景中,它们足以揭示偏差。于是,我们提出了两个假设来应对这些挑战:第一个假设认为需要将计算机视觉模型与人类推理对齐,从而对模型本身提出质疑;第二个假设认为现有的归因方法不足,不能揭示足够的信息。这些假设将在专门的章节中进行探讨。 为了解决第一个假设,我们提出了一种新的训练方法,该方法不仅旨在最小化常规的代价函数,还旨在模仿人类的解释,换句话说,要求模型能做到“正确的原因,正确的结果”。令人惊讶的是,模型不仅成功地借鉴了人类的策略并进行泛化,而且它们的准确性也得到了提升。接着,我们探索了第二种方法,该方法通过约束而非正则化来对齐模型,通过在1-Lipschitz函数的限制功能空间中优化模型。分析表明,具有1-Lipschitz属性的模型的鲁棒性与它们提供与人类推理一致的解释能力之间存在联系。 接下来,我们探讨了第二个假设,即现有的归因方法不足,因为它们仅揭示了模型关注的“位置”,而没有具体说明模型感知到了什么。我们采用了一种基于概念的可解释性方法,从关注“何处”转向理解模型感知的“何物”。这一转变通过CRAFT方法得以实现,该方法自动提取模型使用的概念,然后评估每个提取概念的重要性。我们深入分析了当前概念提取方法的组成部分,并证明它们包括两个阶段:提取阶段和重要性评估阶段。随后,我们通过展示提取阶段可以被概念化为字典学习问题,并且重要性评估阶段隐式地使用了归因方法,统一了文献中不同的方法。通过建立这一统一框架,我们介绍了MACO,一种特征可视化方法,我们将其应用于概念上,允许可视化提取的概念。最后,我们将这些方法整合到一个互动展示中,提供对ResNet模型的1000个ImageNet类别最重要概念的探索和理解。 论文最后对所开发的方法、取得的进展以及遇到的挑战进行了深入反思,并为人工智能可解释性领域的未来研究方向开辟了新视角。我们强调继续寻找不同方法之间协同作用的重要性,并展望充分利用可解释人工智能潜力的前景。