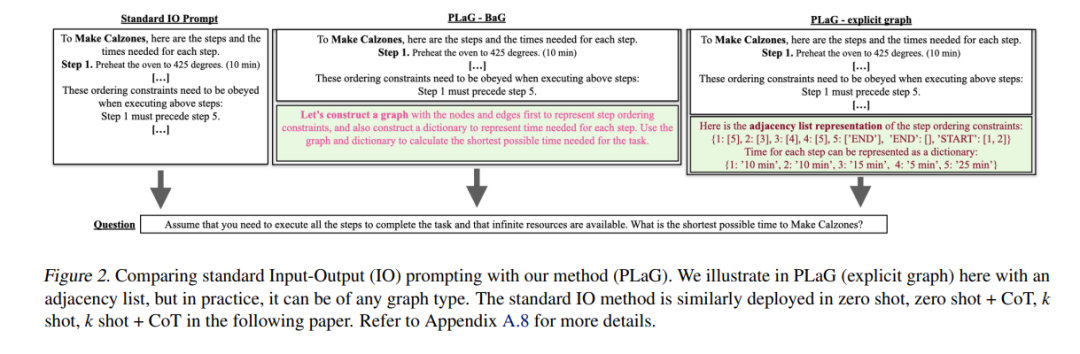

![]() 关于异步计划的推理具有挑战性,因为它需要序列和并行计划来优化时间成本。大型语言模型(LLMs)能否在这项任务上取得成功?在这里,我们展示了第一个大规模研究来调查这个问题。我们发现,一组代表性的闭源和开源LLMs,包括GPT-4和LLaMA-2,在我们的AsyncHow基准测试中,如果没有提供关于任务解决过程的说明,表现很差。我们提出了一种名为“像图一样计划”(PLaG)的新技术,该技术将图与自然语言提示结合起来,并实现了最先进的结果。我们展示了尽管PLaG可以提升模型性能,但当任务复杂性增加时,LLMs仍然遭受剧烈退化,这突出了利用LLMs模拟数字设备的限制。我们将我们的研究视为使用LLMs作为高效自主代理的激动人心的一步。

关于异步计划的推理具有挑战性,因为它需要序列和并行计划来优化时间成本。大型语言模型(LLMs)能否在这项任务上取得成功?在这里,我们展示了第一个大规模研究来调查这个问题。我们发现,一组代表性的闭源和开源LLMs,包括GPT-4和LLaMA-2,在我们的AsyncHow基准测试中,如果没有提供关于任务解决过程的说明,表现很差。我们提出了一种名为“像图一样计划”(PLaG)的新技术,该技术将图与自然语言提示结合起来,并实现了最先进的结果。我们展示了尽管PLaG可以提升模型性能,但当任务复杂性增加时,LLMs仍然遭受剧烈退化,这突出了利用LLMs模拟数字设备的限制。我们将我们的研究视为使用LLMs作为高效自主代理的激动人心的一步。

![]()