本教程针对的是对人工智能和ML技术感兴趣的研究人员和从业人员,这些技术用于从非结构化文本源中提取结构信息(IE)。特别是,本教程将通过解决几个重要的研究问题,系统地介绍IE的最新进展。这些问题包括 (i) 如何利用少量的、有噪声的训练数据开发一个鲁棒的IE系统,同时保证其预测的可靠性?(ii)如何通过增强系统的跨语言、跨领域、跨任务、跨模式的可移动性来培养IE的通用性? (iii)如何支持提取极细粒度和多样化标签的结构信息? (iv) 如何利用其他NLP任务(如NLI、QA或总结,以及预先训练的语言模型)的间接监督来进一步提高IE ?(v)在IE系统中如何获取知识来指导推理?我们将讨论解决这些挑战的前沿研究的几个线,并将通过概述进一步调查的方向来结束教程。

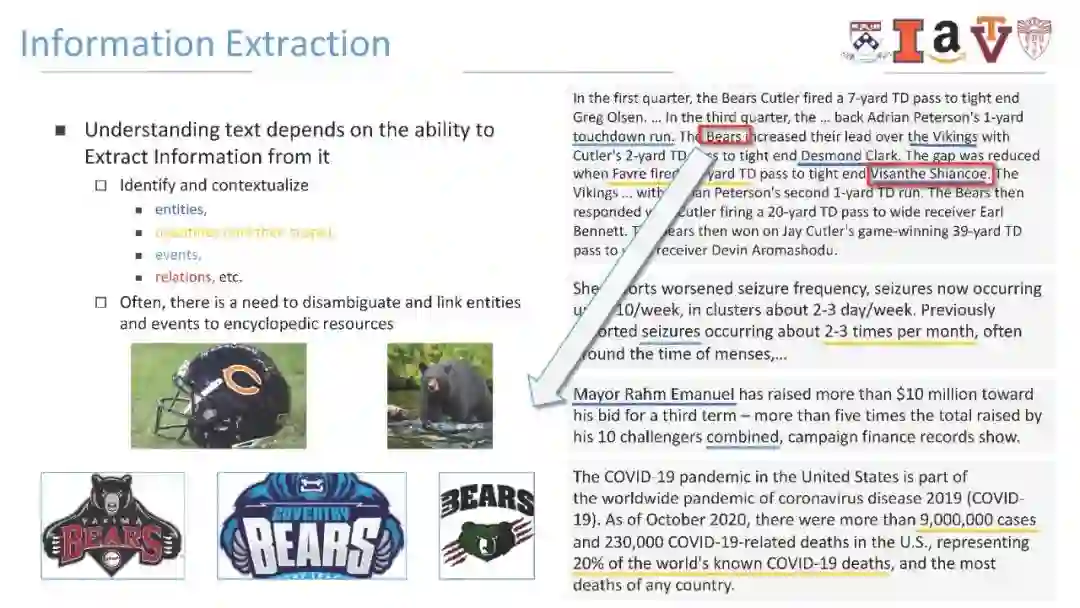

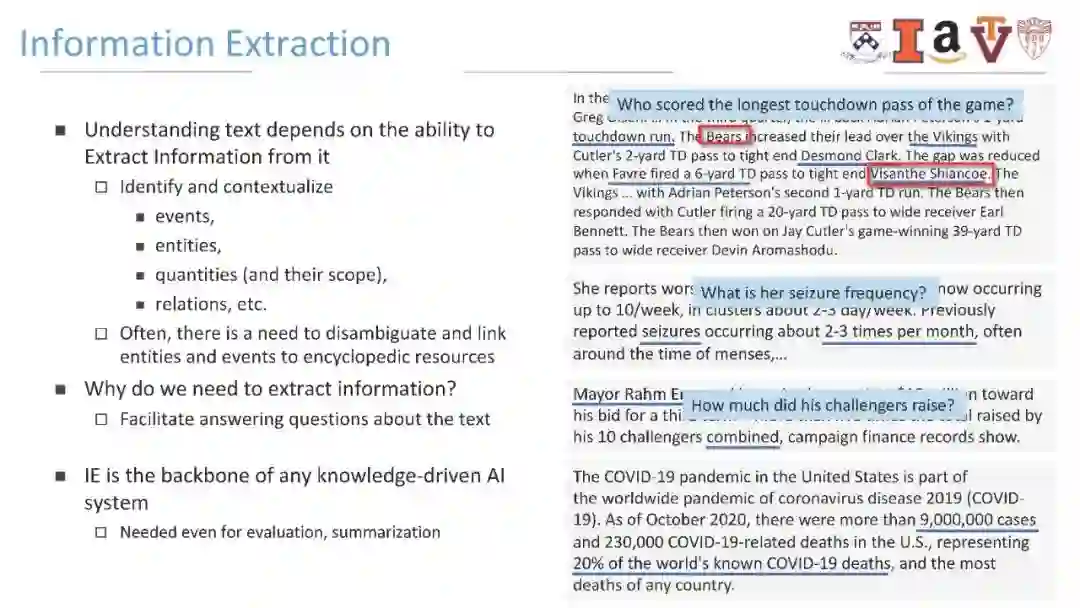

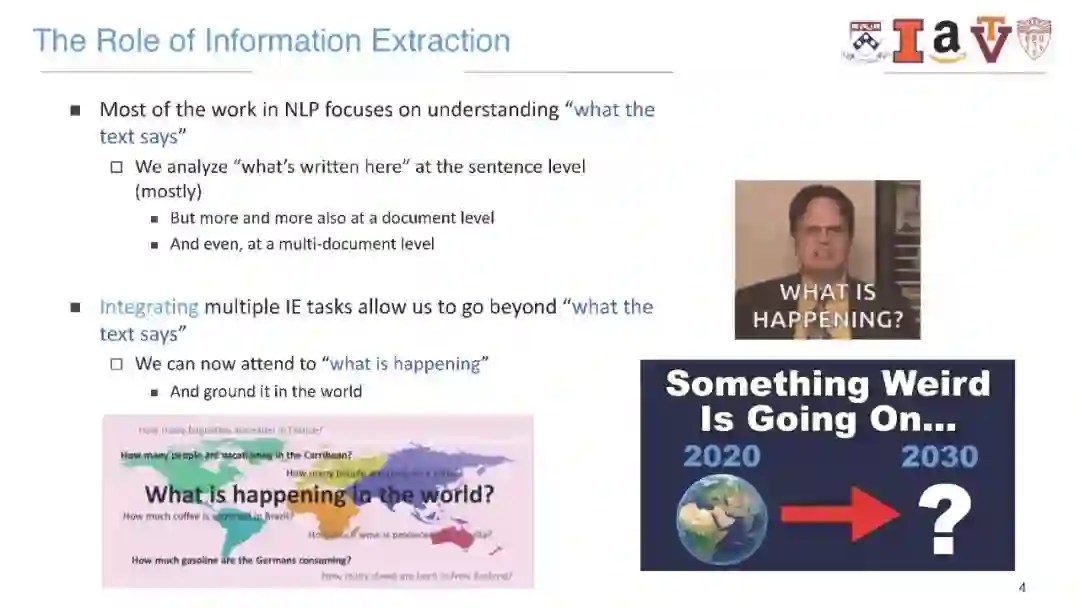

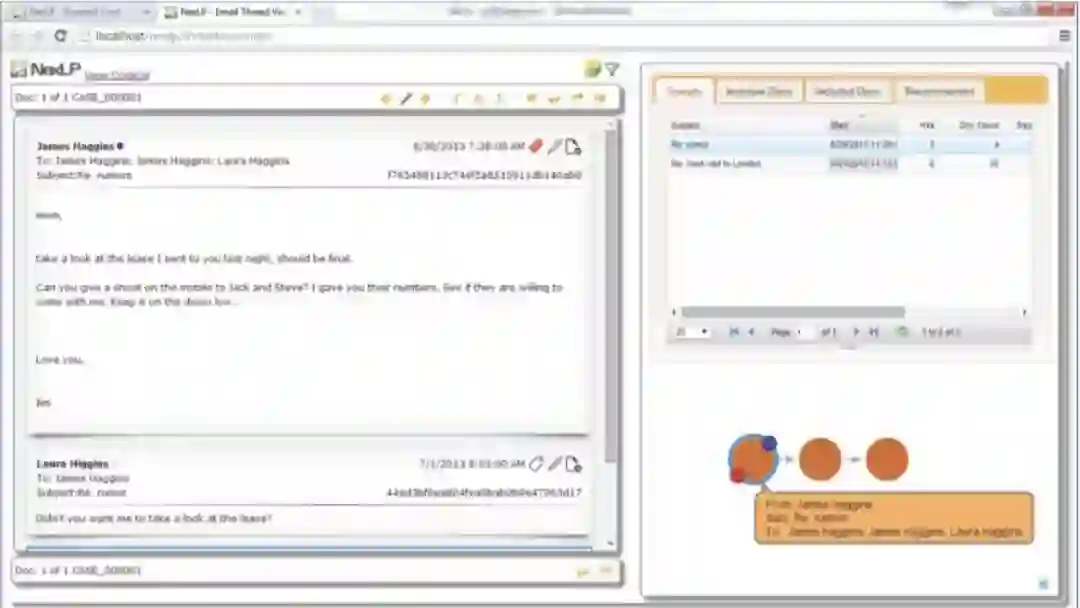

信息抽取(Information extraction, IE)是指从非结构化或半结构化数据中自动提取结构化信息的过程。它通过识别和解析文本中描述的概念、实体、事件,并推断它们之间的关系,为自然语言理解提供了必要的支持。在各种应用领域中,IE自动化了领域特定知识表示的昂贵获取过程,而这些知识表示是任何知识驱动AI系统的支柱。例如,自动化知识库的构建依赖于以实体为中心的IE技术。事件和事件链的提取可以帮助机器完成叙事预测和总结任务。医学IE也有利于重要但昂贵的临床任务,如药物发现和再利用。尽管如此,IE的前沿研究仍然面临着几个关键的挑战。第一个挑战是使用语言建模表示的现有主流方法不能充分地获取IE任务所需的基本知识和结构。第二个挑战是开发监督较少的细粒度信息提取模型,考虑到在未标记数据上获得结构性注释的成本非常高。第三个挑战是在现实场景中扩展IE系统的可靠性和通用性,在这些场景中,数据源经常包含不正确的、无效的或无法识别的输入,以及包含看不见的标签和混合模式的输入。最近,通过解决这些关键的挑战,最近的文献正在导致IE系统开发的原则和方法的变革性的进步。我们认为有必要及时呈现一个教程,全面总结IE研究的新前沿,并指出值得进一步研究的新挑战。

在本教程中,我们将系统地回顾开发鲁棒、可靠和自适应学习系统以提取丰富的结构化信息的几条前沿研究路线。除了介绍用于无监督去噪、约束捕获和新异检测的鲁棒学习和推理方法外,我们还将讨论利用来自自然语言推理和生成任务的间接监督来改进IE的最新方法。我们还将回顾最近用于训练IE模型的最小监督方法,该方法与语言模式、语料库统计数据或语言建模目标有一定距离的监督。此外,我们将说明如何在一个封闭域上训练的模型能够可靠地适应从不同域、语言和模式的数据源中产生提取,或获取全局知识(例如,事件模式),以指导在高度多样化的开放标签空间上的提取。与会者将了解本主题的最新趋势和新出现的挑战,获得现成模型的代表性工具和学习资源,以及相关技术如何使最终用户的NLP应用受益。

介绍

我们将定义主要的研究问题,并通过介绍几个真实世界的自然语言处理和IE技术的知识驱动AI应用,以及该领域前沿研究的几个关键挑战来激发这个主题。

IE的间接和最小监督

我们将介绍对IE使用间接监督的有效方法,即利用相关任务的监督信号来弥补特定训练数据在数量和全面性方面的不足。常见的间接监督来源包括问题回答和阅读理解、自然语言推理和生成。我们还将讨论作为间接来源的结构性文本(如维基百科)。随着大规模预训练语言模型的突破,人们提出了探索语言模型目标作为IE的间接监督的方法。为此,我们将涉及的方法包括直接探测,以及最近使用远程信号进行预训练。

面向IE的鲁棒学习与推理

我们将介绍提高工业工程学习系统在学习和推理阶段的鲁棒性的方法。这些方法包括基于共正则化知识蒸馏、标签重加权和标签平滑的自监督去噪技术,用于训练噪声鲁棒的IE模型。此外,我们还将讨论用于out- distribution (OOD)检测的无监督技术、带有回避的预测和新颖性类检测,这些技术试图帮助IE模型在推理阶段识别无效输入或带有语义转移的输入。具体来说,为了演示模型如何确保提取的全局一致性,我们将介绍自动捕获关系之间的逻辑约束的约束学习方法,以及在推断中强制约束的技术。

Knowledge-guided即

从大规模语料库中提取的全局知识表示可以指导对知识要素之间复杂联系的推理,并有助于修正提取错误。我们将引入跨任务和跨实例的统计约束知识、常识知识和全局事件模式知识,这些知识有助于联合提取实体、关系和事件。

IE系统的可迁移性

开发IE系统的一个重要挑战在于预定义模式(例如,预定义类型的实体、关系或事件)的覆盖范围有限,以及对人工注释的严重依赖。当转向新的类型、领域或语言时,我们必须从头开始,创建注释并重新训练提取模型。在这部分教程中,我们将介绍在提高IE可转移性方面的最新进展,包括:(1)通过利用对抗训练、语言不变表示和资源、预训练的多语言模型以及数据投影进行跨语言迁移;(2)跨类型迁移,包括通过学习原型、阅读定义、回答问题,包括零样本和少样本的IE;(3)跨不同基准数据集迁移。最后,我们还将讨论IE终身学习的进展,以实现知识在增量更新模型之间的转移。

跨模态IE

跨模态IE旨在从多种模态中提取结构化知识,包括非结构化和半结构化的文本、图像、视频、表格等。我们将从从图像和视频中提取视觉事件和论点开始。提取多媒体事件的关键是识别跨模态的相互参照和链接,并在共同的语义空间中表示文本和视觉知识。我们还将介绍从半结构化数据和表格数据中提取信息的方法。

未来的研究方向

工业工程是支持知识获取的关键组成部分,它影响着广泛的知识驱动AI应用。在本教程的最后,我们将介绍进一步的挑战和潜在的研究主题,包括识别提取内容的可信度、定量推理IE、跨文档IE、标签语义建模,以及从语料库中获取潜在的但重要的信息(可能涉及报告偏见)的挑战。