![]()

摘要——随着大型模型的迅速发展,得益于它们通过大规模预训练在学习和泛化方面的卓越能力,人工智能(AI)领域的格局发生了巨大变化。这些模型现在已经成为多种应用的基础,包括对话式AI、推荐系统、自动驾驶、内容生成、医学诊断和科学发现。然而,它们的广泛部署也使其面临显著的安全风险,引发了关于模型的鲁棒性、可靠性和伦理问题的担忧。本文对当前的大型模型安全研究进行了系统性综述,涵盖了视觉基础模型(VFMs)、大型语言模型(LLMs)、视觉-语言预训练模型(VLP)、视觉-语言模型(VLMs)、扩散模型(DMs)和基于大型模型的智能体等领域。我们的贡献总结如下:(1)我们提出了一个关于这些模型安全威胁的全面分类,包括对抗性攻击、数据投毒、后门攻击、越狱和提示注入攻击、能耗-延迟攻击、数据与模型提取攻击,以及新兴的智能体特定威胁。(2)我们回顾了针对各类攻击提出的防御策略(如果有),并总结了用于安全研究的常用数据集和基准。(3)在此基础上,我们识别并讨论了大型模型安全面临的开放性挑战,强调了对全面安全评估、可扩展且有效的防御机制以及可持续数据实践的需求。更重要的是,我们突出了研究社区和国际合作的共同努力的必要性。我们的工作可为研究人员和从业者提供有价值的参考,促进全面防御系统和平台的持续发展,以保障AI模型的安全。 ![]()

关键词——大型模型安全,人工智能安全,攻击与防御 ![]() 1 引言人工智能(AI)已经进入大型模型的时代,典型的代表包括视觉基础模型(VFMs)、大型语言模型(LLMs)、视觉-语言预训练模型(VLP)、视觉-语言模型(VLMs)以及图像/视频生成扩散模型(DMs)。通过在大规模数据集上进行预训练,这些模型在从语言理解和图像生成到复杂问题解决和决策制定等任务中,展现出了前所未有的能力。它们在理解和生成类人内容(例如文本、图像、音频和视频)方面的能力,使得它们在客户服务、内容创作、医疗保健、教育等领域得到了广泛应用,突显了它们在商业和社会领域的变革潜力。然而,大型模型的部署也带来了显著的挑战和风险。随着这些模型越来越多地应用于关键领域,关于它们在面对对抗性攻击、越狱攻击、后门攻击、数据隐私泄露及生成有害或误导性内容等方面的脆弱性,已经引发了广泛的关注。这些问题构成了重大威胁,包括系统行为异常、隐私泄露以及有害信息的传播。确保这些模型的安全至关重要,以防止此类不良后果,保持公众信任并促进负责任的AI使用。为了应对这些挑战,AI安全研究领域得到了扩展,涵盖了多种攻击方法、防御策略和评估基准,旨在识别和缓解大型模型的脆弱性。鉴于各种大型模型的安全相关技术迅速发展,我们的目标是提供一项全面的调查,重点介绍这些技术的优势、劣势和空白,同时推动研究和促进合作。鉴于我们调查的广泛范围,本文的结构考虑了以下几个方面,以增强清晰度和组织性:模型:我们聚焦于六类广泛研究的模型,包括VFMs、LLMs、VLPs、VLMs、DMs和智能体,分别审查每类模型的攻击与防御方法。这些模型代表了各领域最受关注的大型模型。组织结构:对于每类模型,我们将回顾的工作分为攻击与防御两部分,并识别10种攻击类型:对抗攻击、后门攻击、数据投毒、越狱攻击、提示注入攻击、能耗-延迟攻击、成员推断攻击、模型提取攻击、数据提取攻击和智能体攻击。当某一模型类别同时存在后门攻击和数据投毒攻击时,我们将其归为“后门与数据投毒”类别,因这两种攻击具有相似性。我们在介绍每种攻击类型后,紧接着回顾对应的防御策略。分类法:对于每种攻击或防御,我们采用两级分类法:类别 → 子类别。类别根据威胁模型(如白盒、灰盒、黑盒)或特定子任务(如检测、净化、鲁棒训练/调优和鲁棒推理)进行区分。子类别则基于技术手段提供更详细的分类。粒度:为了确保清晰度,我们简化了每篇文献的介绍,仅突出其核心观点。我们的调查方法结构如下。首先,我们进行了基于关键词的搜索,针对特定模型类型和威胁类型,筛选出相关论文。接着,我们手动剔除了与安全无关或非技术性的论文。对于每篇剩余的论文,我们通过分析其设置和攻击/防御类型,将其提出的方法或框架分类,并分配到合适的类别和子类别中。最终,我们共收集了390篇技术论文,并通过图1展示了它们在年份、模型类型和攻击/防御策略上的分布。正如所示,自2023年ChatGPT发布以来,大型模型的安全研究显著增加。在模型类型中,LLMs和DMs受到了最多关注,占据了被调查论文的60%以上。关于攻击类型,越狱攻击、对抗攻击和后门攻击是研究最广泛的。在防御方面,越狱攻击的防御受到了最多关注,其次是对抗攻击的防御。图2呈现了模型类型和攻击/防御类别的时间趋势,详细分解了所回顾的工作。值得注意的是,攻击研究占据了研究总量的60%。在防御方面,尽管防御研究只占40%,这一显著差距突显了防御策略亟待更多关注的必要性。本文的总体结构如图3所示。与现有综述的区别:大型模型安全是一个迅速发展的领域,已有多篇综述文献推动了该领域的研究。近期,Slattery等人[406]提出了一个AI风险框架,系统性地涵盖了所有类型的风险。相比之下,我们的重点是技术层面,特别是文献中提出的攻击和防御技术。表1列出了我们所识别的技术性综述,它们分别聚焦于特定类型的模型或威胁(例如LLMs、VLMs或越狱攻击/防御)。与这些工作相比,我们的综述提供了更广泛的范围——涵盖了更多的模型类型和威胁,并且从更高层次的角度,专注于整体方法论,而非具体的技术细节。

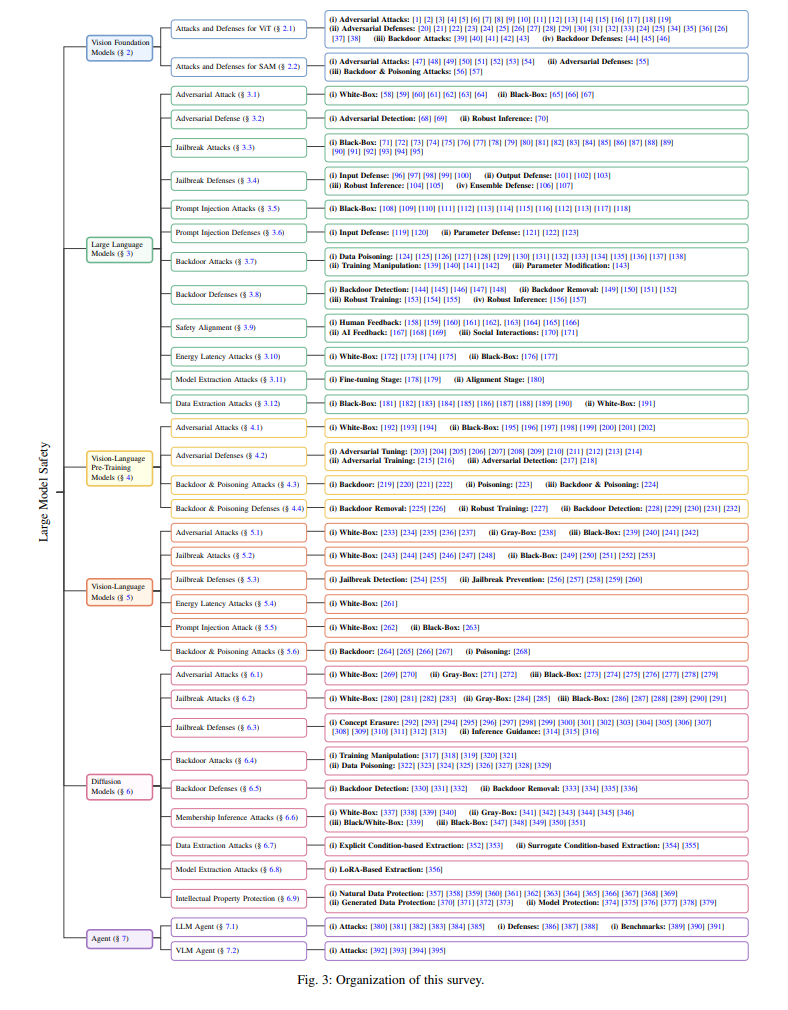

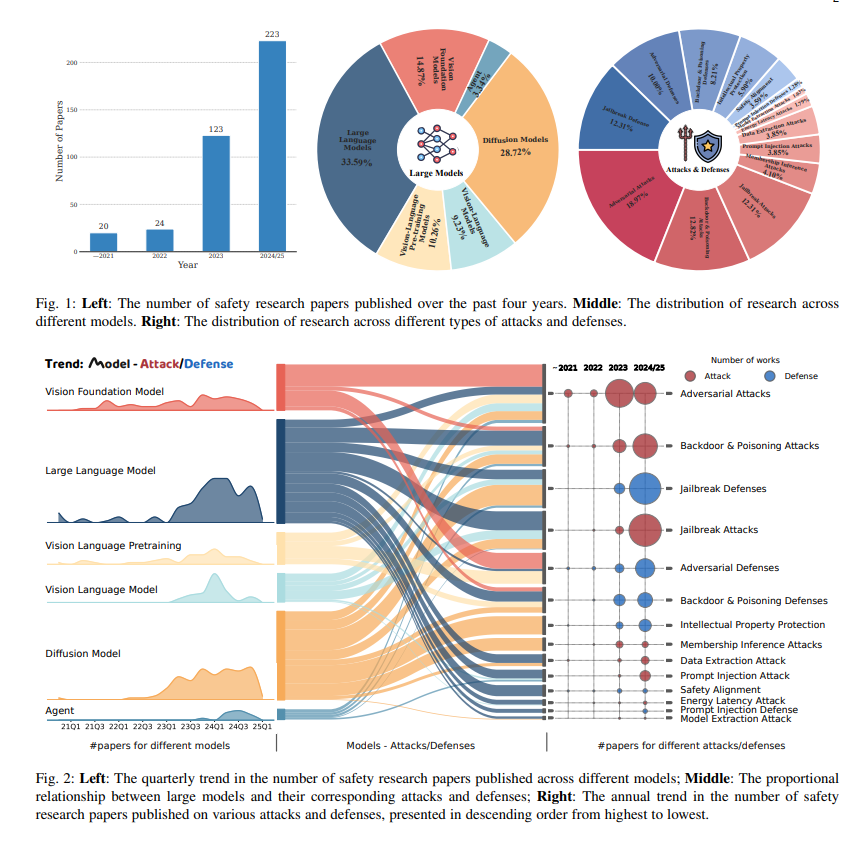

1 引言人工智能(AI)已经进入大型模型的时代,典型的代表包括视觉基础模型(VFMs)、大型语言模型(LLMs)、视觉-语言预训练模型(VLP)、视觉-语言模型(VLMs)以及图像/视频生成扩散模型(DMs)。通过在大规模数据集上进行预训练,这些模型在从语言理解和图像生成到复杂问题解决和决策制定等任务中,展现出了前所未有的能力。它们在理解和生成类人内容(例如文本、图像、音频和视频)方面的能力,使得它们在客户服务、内容创作、医疗保健、教育等领域得到了广泛应用,突显了它们在商业和社会领域的变革潜力。然而,大型模型的部署也带来了显著的挑战和风险。随着这些模型越来越多地应用于关键领域,关于它们在面对对抗性攻击、越狱攻击、后门攻击、数据隐私泄露及生成有害或误导性内容等方面的脆弱性,已经引发了广泛的关注。这些问题构成了重大威胁,包括系统行为异常、隐私泄露以及有害信息的传播。确保这些模型的安全至关重要,以防止此类不良后果,保持公众信任并促进负责任的AI使用。为了应对这些挑战,AI安全研究领域得到了扩展,涵盖了多种攻击方法、防御策略和评估基准,旨在识别和缓解大型模型的脆弱性。鉴于各种大型模型的安全相关技术迅速发展,我们的目标是提供一项全面的调查,重点介绍这些技术的优势、劣势和空白,同时推动研究和促进合作。鉴于我们调查的广泛范围,本文的结构考虑了以下几个方面,以增强清晰度和组织性:模型:我们聚焦于六类广泛研究的模型,包括VFMs、LLMs、VLPs、VLMs、DMs和智能体,分别审查每类模型的攻击与防御方法。这些模型代表了各领域最受关注的大型模型。组织结构:对于每类模型,我们将回顾的工作分为攻击与防御两部分,并识别10种攻击类型:对抗攻击、后门攻击、数据投毒、越狱攻击、提示注入攻击、能耗-延迟攻击、成员推断攻击、模型提取攻击、数据提取攻击和智能体攻击。当某一模型类别同时存在后门攻击和数据投毒攻击时,我们将其归为“后门与数据投毒”类别,因这两种攻击具有相似性。我们在介绍每种攻击类型后,紧接着回顾对应的防御策略。分类法:对于每种攻击或防御,我们采用两级分类法:类别 → 子类别。类别根据威胁模型(如白盒、灰盒、黑盒)或特定子任务(如检测、净化、鲁棒训练/调优和鲁棒推理)进行区分。子类别则基于技术手段提供更详细的分类。粒度:为了确保清晰度,我们简化了每篇文献的介绍,仅突出其核心观点。我们的调查方法结构如下。首先,我们进行了基于关键词的搜索,针对特定模型类型和威胁类型,筛选出相关论文。接着,我们手动剔除了与安全无关或非技术性的论文。对于每篇剩余的论文,我们通过分析其设置和攻击/防御类型,将其提出的方法或框架分类,并分配到合适的类别和子类别中。最终,我们共收集了390篇技术论文,并通过图1展示了它们在年份、模型类型和攻击/防御策略上的分布。正如所示,自2023年ChatGPT发布以来,大型模型的安全研究显著增加。在模型类型中,LLMs和DMs受到了最多关注,占据了被调查论文的60%以上。关于攻击类型,越狱攻击、对抗攻击和后门攻击是研究最广泛的。在防御方面,越狱攻击的防御受到了最多关注,其次是对抗攻击的防御。图2呈现了模型类型和攻击/防御类别的时间趋势,详细分解了所回顾的工作。值得注意的是,攻击研究占据了研究总量的60%。在防御方面,尽管防御研究只占40%,这一显著差距突显了防御策略亟待更多关注的必要性。本文的总体结构如图3所示。与现有综述的区别:大型模型安全是一个迅速发展的领域,已有多篇综述文献推动了该领域的研究。近期,Slattery等人[406]提出了一个AI风险框架,系统性地涵盖了所有类型的风险。相比之下,我们的重点是技术层面,特别是文献中提出的攻击和防御技术。表1列出了我们所识别的技术性综述,它们分别聚焦于特定类型的模型或威胁(例如LLMs、VLMs或越狱攻击/防御)。与这些工作相比,我们的综述提供了更广泛的范围——涵盖了更多的模型类型和威胁,并且从更高层次的角度,专注于整体方法论,而非具体的技术细节。