摘要——在过去的十年中,深度神经网络取得了令人振奋的突破,数据增强作为一种正则化技术在缺乏大规模标注数据的情况下越来越受到关注。在现有的数据增强方法中,Mixup 及相关的数据混合方法通过凸组合选定样本及其对应的标签生成数据依赖的虚拟数据,广泛应用于各种领域并取得了优异的性能。本综述对基础的Mixup方法及其应用进行了全面的回顾。我们首先详细阐述了包含Mixup增强的训练流程,作为一个包含模块的统一框架。一个重构的框架可以容纳各种Mixup方法,并给出直观的操作步骤。然后,我们系统地研究了Mixup增强在视觉下游任务、各种数据模态上的应用,以及Mixup的分析与定理。同时,我们总结了当前Mixup研究的现状和局限性,并指出了进一步提升Mixup增强有效性和效率的研究方向。本综述可以为研究者提供Mixup方法的最新进展,并在Mixup领域中提供一些洞见和指导作用。本综述的在线项目可在 https://github.com/Westlake-AI/Awesome-Mixup 获取。 关键词——数据增强,Mixup,分类,自监督学习,计算机视觉,自然语言处理,图结构

深度神经网络(DNNs),如卷积神经网络(CNNs)和Transformers,由于其强大的特征表示能力,已成功应用于诸多任务,如图像分类、目标检测和自然语言处理(NLP)等。为了完成越来越具有挑战性的任务,DNNs使用了大量可学习的参数,这意味着如果没有大量的训练数据,模型容易过拟合,无法很好地泛化。然而,在某些情况下,训练数据难以获得且收集成本高昂。如何让DNNs在有限的训练数据之外实现泛化,是深度学习中的一个基本问题。

为了解决数据需求量大的问题,研究人员提出了数据增强(DA)技术。与“模型中心”和正则化方法相比,DA是一种“数据中心”的正则化技术,它通过合成虚拟训练数据来防止过拟合。DA通过构建同一样本的不同版本引入有用的不变特征。DA带来的数据集大小增加和归纳偏差的引入也起到了一定的正则化效果,缓解了过拟合问题。最近,数据增强已被证明能够提高深度学习模型的泛化能力,成为实现最先进性能的关键因素。数据增强可以通过对比组合、Mixup和生成等方式合成新数据。

在本综述中,我们聚焦于一个新兴领域——Mixup。Mixup [1] 通过对两个样本及其对应的one-hot标签进行插值来生成增强样本。本质上,基于Mixup的方法通过混合多个样本来生成增强数据。与大多数现有的增强技术修改单个样本但不改变其唯一标签的做法不同,Mixup通过来自两个或多个示例生成增强样本,导致多个标签的产生,从而更好地反映现实世界的情况。此外,Mixup在不同的数据集和领域中表现出很强的可迁移性。相比之下,其他组合方法通常需要大量时间来确定合适的增强策略。生成方法在应用于大数据集时具有挑战性,因为它需要额外的生成器和判别器,从而限制了可迁移性和应用场景。而Mixup不依赖于保留标签的操作,而是通过可学习的方法来创建更有效的增强样本。与传统的数据增强方法处理单个样本不同,Mixup通过混合多个样本生成虚拟训练数据,无需领域知识即可生成大量的训练数据。目前,Mixup已成功应用于多种任务和训练范式,包括监督学习(SL)、自监督学习(SSL)、半监督学习(Semi-SL)、自然语言处理(NLP)、图结构和语音处理等领域。

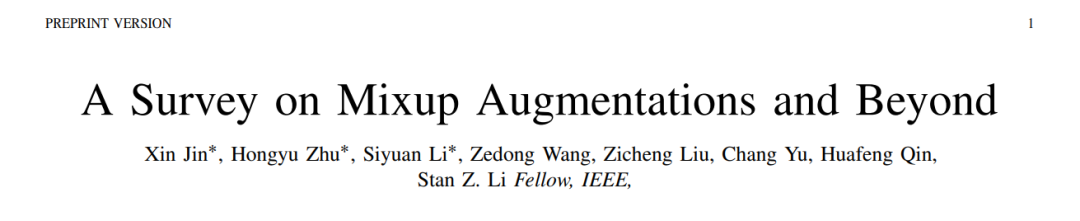

在图1中,我们总结了这些训练范式和数据模态下的一些主流方法的时间轴:

-

SL(样本):2018年,Mixup [1] 提出了静态线性插值的样本混合方法。2019年,CutMix [2] 和 Manifold Mixup [3] 提出了基于切割和特征的Mixup改进。这些是特定的增强方法。但从2020年到2023年,许多方法进一步在静态线性、切割和特征基础上改进了Mixup,甚至逐步转向自适应方式。到2024年,DiffuseMix [4] 结合了生成模型和Mixup方法。

-

SL(标签):2019年,AdaMixup [5] 发现混合比例λ会影响模型性能,这被称为“流形入侵”。因此,从2020年到2024年,许多基于CNNs或Vision Transformers(ViTs)的方法涌现出来,优化这些比例。此外,CAMixup [6] 在2021年和RankMixup [7] 在2023年提出了增强模型校准的方法。

-

SSL(CL)与SSL(MIM):对比学习(CL)在图像分类任务中表现出强大的能力。为了提高模型性能,研究人员提出了大量结合Mixup的CL方法,这些方法通过Mixup获得“半正样本”以捕捉更多特征。CL + Mixup 通常会修改其损失项以适应SSL任务。遮掩图像建模(MIM)通过从混合样本中重建样本,认为混合样本将共享更多特征,能够学习一些高维信息。MixMAE [8] 和MixedAE [9] 在2023年展示了这一观点。

-

Semi-SL:可以利用标注和未标注的信息。2019年,MixMatch [10] 使用这种方法提高了模型性能,并使其更具鲁棒性,因为混合样本可以作为带噪声图像的干净图像使用。对于PUL,P3Mix [11] 在2021年通过混合来自决策边界附近的样本获得了更好的准确性。DecoupledMix [12] 在2023年提出了通过解耦样本预测来获得更干净的伪标签。

-

数据模态:不仅限于图像领域。对于NLP,WordMixup & SenMixup [13] 在2019年提出了两种文本混合方式,分别基于句子混合和嵌入混合。基于这两种基本方法,许多带有特定修改的方法被提出。例如,SeqMix [14] 在2021年提出了基于显著性的嵌入混合,TreeMix [15] 通过使用成分句法分析将句子分解为子结构,并通过混合重新组合成新句子。对于图结构,GraphMix [16] 和 ProGCL [17] 在2021年和2022年提出了结合Mixup方法的图分类,并提出了一些结合Mixup和图结构的新损失项,用于困难样本挖掘。GraphMixup [18]、G-Mixup [19] 和iGraphMix [20] 在2022年和2024年通过显著性信息获得混合图样本,以提高模型的分类能力和鲁棒性。对于语音,BC [21] 和Contrastive-mixup [22] 通过线性插值直接混合语音数据。

总体而言,与已发表的三篇关于Mixup的综述[23]、[24]和[25]相比,我们的贡献包括:

-

我们提供了及时的文献回顾,并使用SL作为示例,提出了两种不同的Mixup改进策略(样本和标签)的综合框架。这两种策略可以对应不同的训练范式和数据模态。

-

我们仔细回顾并讨论了各种Mixup方法的技术细节,如静态线性、显著性和基于注意力的方式,以便研究人员能够更好地了解所涉及的方法,进而获得更深入的理解和洞见。

-

我们对Mixup方法在下游任务中的应用进行了系统性的综述,提出了技术挑战,并进一步展示了它们在视觉任务之外的广泛适用性,如音频、语音、图形、生物学等领域。

-

我们进一步将Mixup方法总结为一种可训练的范式,相比于其他综述中将其作为数据增强工具和方法的处理方式,我们呼吁研究人员贡献一个统一的Mixup框架,以解决多种任务,而不是离散的任务特定修改。

Mixup框架模块 在本小节中,我们将详细说明Mixup方法流程中的各个模块功能,如图2所示。

-

初始化:在进行Mixup之前,一些方法会选择mini-batch中的原始样本来筛选适合混合的样本。例如,Co-Mix [26] 在mini-batch中选择适合的样本,以最大化所获得的混合样本的多样性。除了筛选样本外,一些基于显著性的方式利用预训练模型定位并获取样本的特征图。最后,各种方法从Beta分布中获取Mixup比例λ。

-

样本Mixup策略:在监督学习中,我们将策略分为9类,详细信息展示在图A1中。静态线性方法使用λ基于插值线性混合两个或多个样本。基于特征的方法使用由fθ(⋅)f_θ(·)fθ(⋅)获得的原始样本特征图,并以插值线性的方式进行混合。切割方法通过不同方式(如切割、调整大小或堆叠)混合样本,混合比例λ来自掩码区域。K样本Mixup方法使用两个以上的样本进行混合。随机策略方法结合了多种不同的数据增强方法和一些手工制作的Mixup方法,策略的选择由每种方法的权重因子决定。基于风格的混合方法通过额外的风格提取器从样本的风格和内容中进行混合。显著性方法使用样本特征图来定位显著性信息,并获得最大特征混合样本。基于注意力的方法类似于显著性方法,利用注意力得分而非显著图。生成样本的方法使用生成模型,如基于GAN的模型[27]和基于扩散的模型[28]生成混合样本。

-

标签Mixup策略:在监督学习中,我们将策略分为8类,并在图A1中展示了详细内容。校准优化方法使用ECE指标对混合样本进行排序,以提高分类性能和模型校准。基于区域的方法使用掩码区域重新定义混合比例λ。损失对象方法重新定义新的Mixup分类损失或提出新的损失作为正则化方法。随机策略方法将其他增强方法与Mixup方法结合或为Mixup提出新的训练策略。混合比例优化方法使用可学习的参数作为λ,通过不同的混合样本获得可靠的混合比例。生成标签方法通过混合样本生成混合标签,而不是使用one-hot标签。注意力得分方法使用原始样本的注意力图来获得比例,或者使用混合样本的注意力图通过每个样本的得分计算混合比例。显著性Token方法使用每个原始样本的显著图并将其划分为tokens,通过tokens计算混合比例。

-

采样:一些方法仅专注于样本策略,以提高模型的性能和能力。它们采用其他策略来固定比例λ或标签,一些方法计算掩码上的所有像素并固定λ,而另一些方法为混合样本设置权重因子。

-

通道Mixup策略:与样本或标签不同,通道具有大量高级特征。Manifold Mixup [3] 通过插值线性获得混合样本,Catch up-Mix [29] 通过选择一些特征图进一步提高滤波器能力,获得混合样本。

Mixup方法的主要步骤

如图2顶部所示,Mixup方法遵循以下步骤:

- 从训练数据集中加载mini-batch原始样本;

- 对于一些下游任务,包括选择原始样本和保留可靠样本,一些基于显著性或注意力的方法通过加载预训练模型获得特征区域或tokens。然后,定义从Beta分布或均匀分布采样的混合比例λ;

- 初始化后,原始样本通过样本Mixup策略与其他样本混合。我们在3.1小节中展示了这些策略;

- 当生成混合样本x^\hat{x}x^ 后,有两种选择:一种是采样,一些方法通过掩码M的总像素更新混合比例,一些方法选择混合样本以保留更多的多样性或具有挑战性的样本,另一些方法重新定义混合比例。另一种是标签Mixup策略,我们在3.2小节中展示了这些策略并进一步挖掘标签y^\hat{y}y^;

- 最后一步是通道Mixup策略,混合样本x^\hat{x}x^ 通过网络编码并映射到高维潜在空间,一些方法相互插值或选择特征图用于高维特征z^\hat{z}z^。然后继续对特征向量进行编码以执行不同的任务,并根据不同的损失函数优化网络。

结论

在本综述中,我们将Mixup方法重新表述为一个统一的框架,并总结了这些方法在2018年至2024年间在各种任务中的技术细节和数据模态。此外,我们将Mixup分为两大类:样本Mixup策略和标签Mixup策略,这两类可以涵盖Mixup的不同改进版本,并在图A1和图A2中总结了本综述中的所有Mixup方法。我们还总结了Mixup方法中经常使用的各种数据集类型,以及在常用数据集上基于主流模型进行图像分类任务的主流Mixup方法的分类结果,显示在表A2、表A3和表A4中。最后,我们讨论了现有问题和未来有价值的研究方向,旨在为研究人员提供该领域中的一些前沿想法和思路。