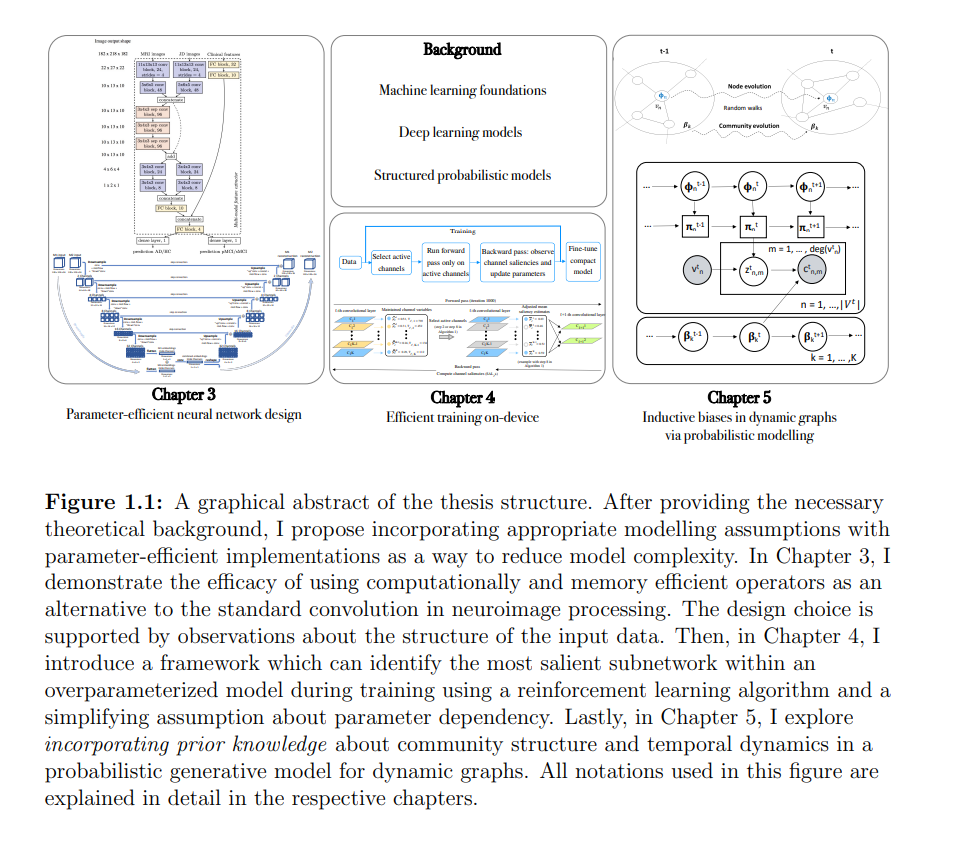

深度学习的发展导致了在各种应用领域的各种任务上的显著性能提升,这些应用领域包括计算机视觉、自然语言处理、强化学习、生成模型,以及最近从图结构数据中进行的关系学习。这一成功的主要原因是计算能力的提高,这允许深度和高度参数化的神经网络架构,这些架构可以从原始数据中学习复杂的特征转换。然而,深度神经网络的高表示能力往往是以高模型复杂度为代价的,这指的是高参数化,以及与深度学习相关的内存和计算负担。**在本文中,我依靠参数有效的神经算子,对数据的适当建模假设和网络结构的归纳偏差,在几个应用领域提出更简单的神经网络模型。**对于我工作的每个应用领域,我使用这些效率原则的组合来设计新颖的方法。首先,在医学图像处理的背景下,我观察到空间对齐的神经图像比自然图像表现出更少的自由度,这证明使用低容量卷积算子是合理的。我通过应用参数高效的卷积变体来实现这一点。我展示了早期阿尔茨海默病预测的最先进结果,同时使用的参数减少了多达125倍,乘累加操作减少了17倍以上。对于设计用于识别受试者亚型的神经图像的无监督方法也得出了类似的结论。其次,我着手缓解从零开始训练参数高效的深度模型的挑战。这可以减少在资源受限的"边缘"设备上训练深度模型的不可行性。所提方法基于一个简化的网络结构假设,即参数无关性,允许在组合多臂匪徒的背景下建模问题。该方法可以动态地,即在训练期间,在遵循预定义的内存使用预算的同时,在超参数化模型中识别高性能紧凑的子网络。这是通过将显著性指标与每个神经元相关联来实现的,然后用于驱动参数激活,类似于门控机制,同时学习参数。因此,深度神经网络训练和推理过程中的计算和内存负担都显著减少。最后,提出一种深度概率模型,用于学习动态图中的无监督节点和社区嵌入。基于网络固有的社团结构,引入了关于边形成机制的结构归纳偏差。此外,我还假设节点和社区都是平滑的时间演化,其灵感来自于数据中缺乏破坏性事件。本文提出一种该方法的参数高效实现,在各种动态预测任务上优于最先进的图卷积网络。