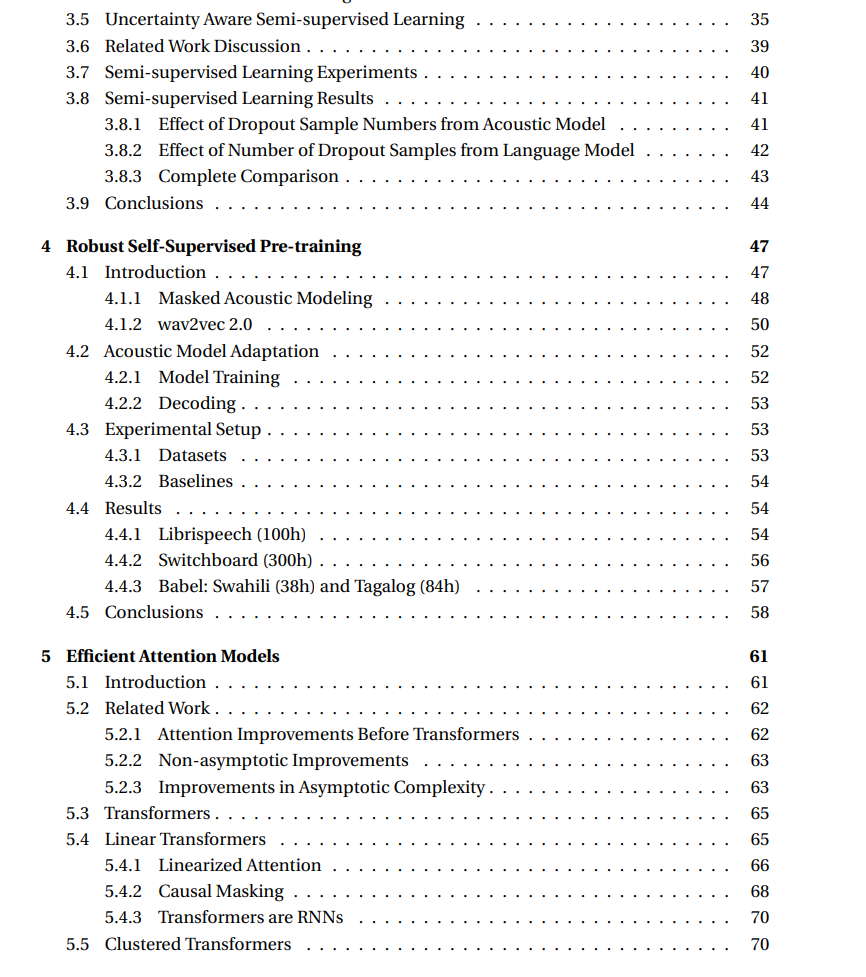

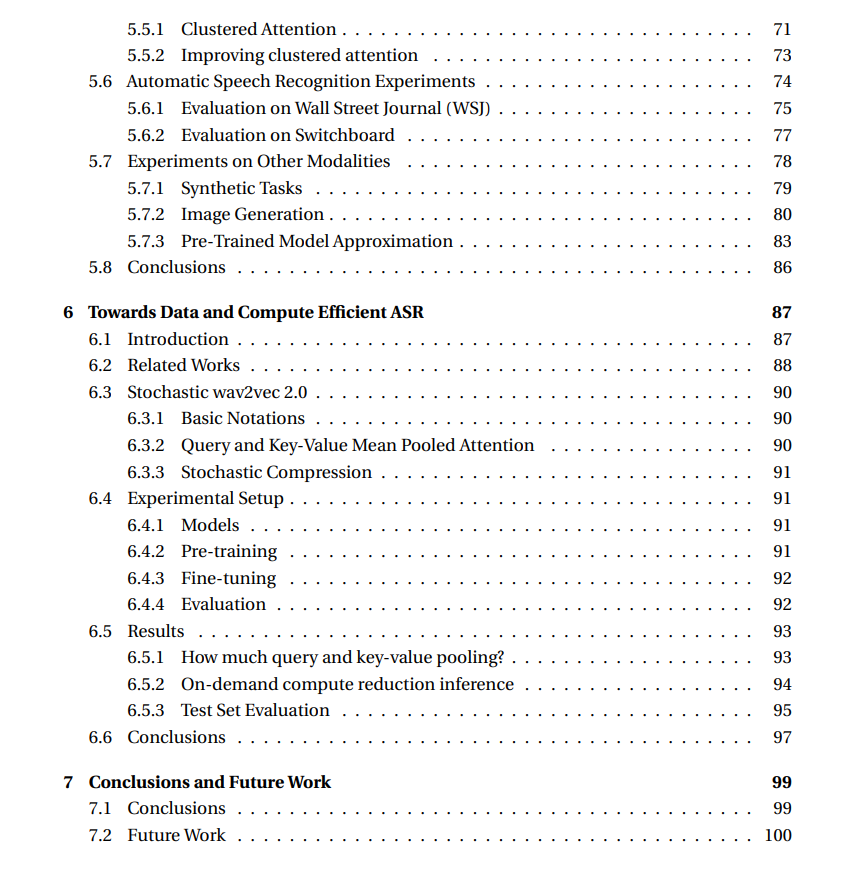

**训练基于深度神经网络的自动语音识别(ASR)模型通常需要数千小时的转录数据,将其限制在少数语言中。此外,目前最先进的声学模型基于Transformer架构,该架构随着序列长度的二次增长,阻碍了其对长序列的使用。本文旨在减少(a)数据和(b)开发最先进的ASR系统的计算需求,只有几百小时或更少的转录数据。本文的第一部分着重于减少训练这些模型所需的转录数据量。本文提出一种使用dropout进行不确定性感知半监督学习的方法。该方法为未标记数据的训练产生了更好的假设。研究了两种流行的自监督预训练方法的域外和跨语言泛化:掩码声学建模和wav2vec 2.0。两种预训练方法都可以泛化到未见过的域,并明显优于仅用监督数据训练的模型。https://infoscience.epfl.ch/record/297304?ln=en在第二部分中,专注于减少Transformer模型的计算需求,(a)通过设计高效的注意力计算形式,(b)通过减少注意力计算的输入上下文长度。**本文首次提出"线性"注意力,使用注意力的核公式将自回归transformer表示为递归神经网络,并将序列长度的计算复杂度从二次降低到线性。提出"聚类"注意力,通过对输入序列进行聚类并使用质心进行计算来近似自注意力。在给定的计算预算下,聚类注意力优于普通注意力。对于ASR,我们发现线性注意力导致词错误率下降,而聚类在处理较短序列时引入了开销。为解决这一限制,本文开发了一种方法,用均值池化对输入进行随机下采样,以实现高效的wav2vec 2.0训练。这使得在推理过程中可以在不同的压缩因子下使用相同的模型。对wav2vec 2.0预训练的随机压缩,能够为转录数据有限的语言建立计算高效的ASR模型。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年4月6日