【牛津大学博士论文】深度学习中的结构与不确定性,205页pdf

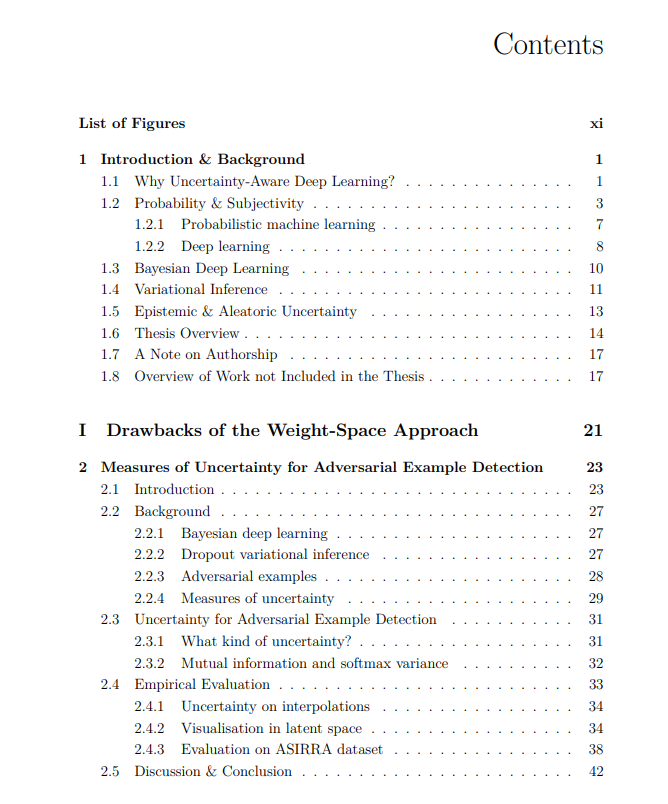

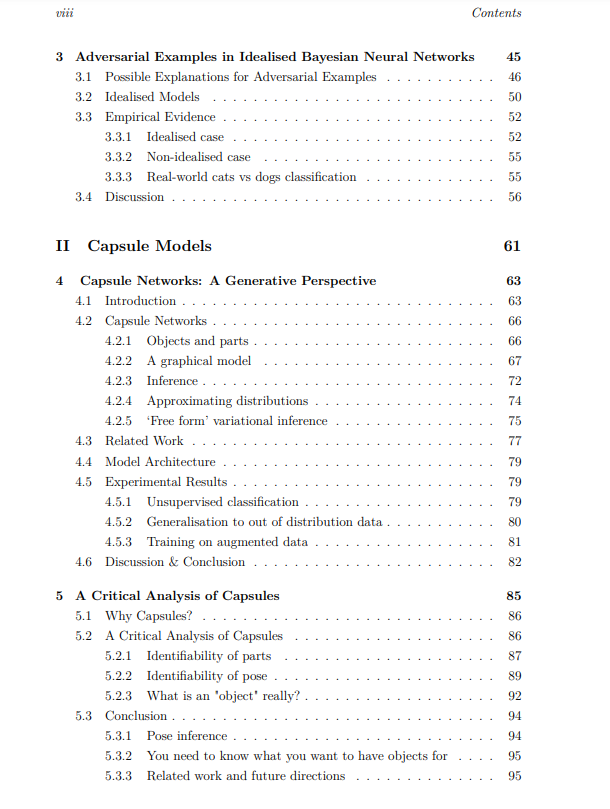

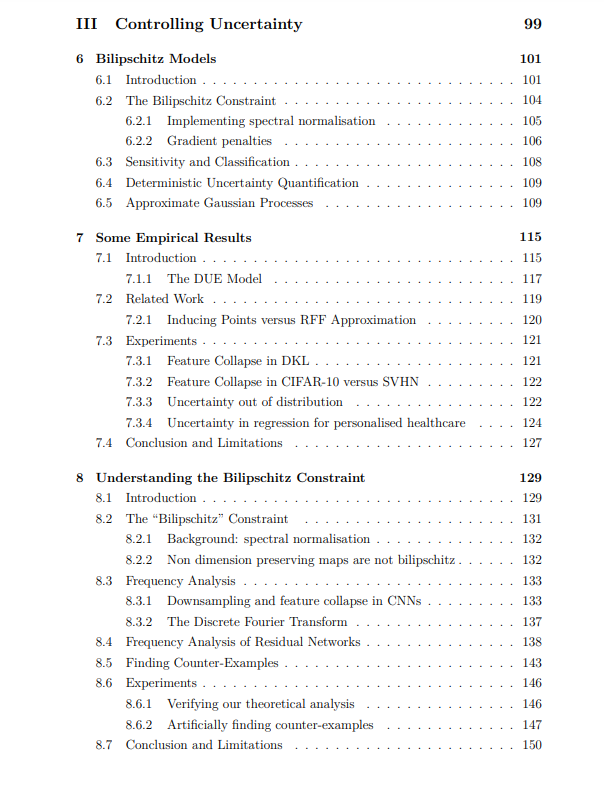

设计具有不确定性的深度学习模型,使其能够在预测的同时提供合理的不确定性,一直是部分机器学习社区的目标。从业者也经常需要这样的模型。最普遍和最明显的方法是采用现有的深层架构,并尝试将现有的贝叶斯技术应用于它们,例如,将神经网络的权重作为贝叶斯框架中的随机变量处理。本文试图回答这个问题: 现有的神经网络架构是获得合理不确定性的最佳方式吗?在本文的第一部分,我们提出了在对抗环境下贝叶斯神经网络的不确定性行为的研究,这表明,虽然贝叶斯方法在数据分布附近的确定性网络上有显著的改进,但外推行为是不受欢迎的,因为标准神经网络架构在结构上偏向于自信外推。基于此,我们探索了两种标准深度学习架构的替代方案,试图解决这一问题。首先,我们描述了一种新的胶囊网络生成公式,它试图通过对场景结构的强假设来将结构强加到学习任务中。然后,我们使用这个生成模型来检查这些潜在的假设是否有用,并论证它们实际上存在重大缺陷。其次,我们探索了bilipschitz模型,这是一种解决深度神经网络中确保先验回归这一更有限目标的体系结构。这些方法基于深度核学习,试图通过使用最终分类层来控制神经网络的行为,当与支持向量集的距离增加时,分类层会恢复到先验值。为了在使用神经特征提取器的同时保持这一特性,我们为这些模型描述了一种新的“bilipschitz”正则化方案,该方案基于通过施加由可逆网络上的工作激发的约束来防止特征崩溃。我们描述了这些模型的各种有用的应用,并分析了为什么这种正则化方案似乎仍然有效,即使它背后的原始动机不再成立,特别是在特征维度低于输入的情况下。我们的结论是,虽然胶囊网络可能不是一个有前途的方向,但本文最后部分讨论的模型是未来研究的一个富有成果的领域,在许多应用中作为标准贝叶斯深度学习方法的一个有前途的潜在替代方案。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SUDL” 就可以获取《【牛津大学博士论文】深度学习中的结构与不确定性,205页pdf》专知下载链接