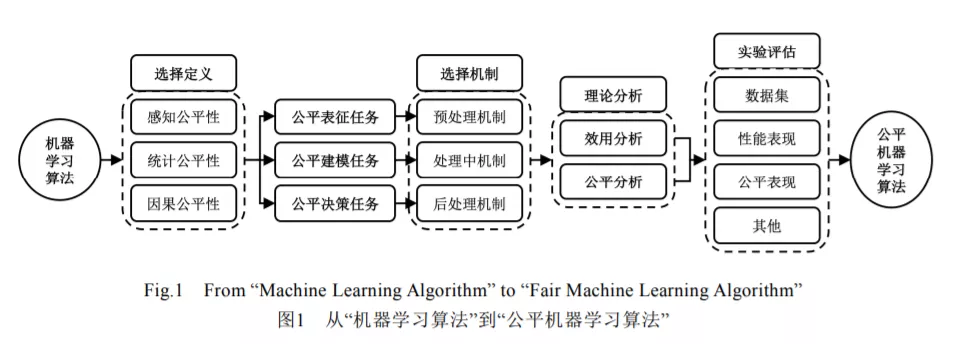

人工智能在与人类生活息息相关的场景中自主决策时,正逐渐面临法律或伦理的问题或风险.可信机器学习是建立安全人工智能系统的核心技术,是人工智能领域的热门研究方向,而公平性是可信机器学习的重要考量.公平性旨在研究机器学习算法决策对个人或群体不存在因其固有或后天属性所引起的偏见或偏爱.本文从公平表征、公平建模和公平决策三个角度出发,以典型案例中不公平问题及其危害为驱动,分析数据和算法中造成不公平的潜在原因,建立机器学习中的公平性抽象定义及其分类体系,进一步研究用于消除不公平的机制.可信机器学习中的公平性研究在人工智能多个领域中处于起步阶段,如计算机视觉、自然语言处理、推荐系统、多智能体系统和联邦学习等.建立具备公平决策能力的人工智能算法,是加速推广人工智能落地的必要条件,且极具理论意义和应用价值.

成为VIP会员查看完整内容