人工智能(AI)的历史见证了高质量数据对各种深度学习模型的重大影响,例如ImageNet对于AlexNet和ResNet。最近,AI社区的关注点已从设计更复杂的神经结构(即模型为中心的方法)转移到了数据为中心的方法,这种方法重点在于更好地处理数据以增强神经模型的能力。图学习,操作于无处不在的拓扑数据上,也在深度学习时代中起到了重要作用**。在这次综述中,我们从数据为中心的角度全面回顾了图学习方法,并旨在回答两个关键问题**:(1)何时修改图数据以及(2)如何修改图数据以发掘各种图模型的潜力。因此,我们提出了一个基于图学习流程中的阶段的新分类法,并强调了图数据中不同数据结构的处理方法,即拓扑、特征和标签。此外,我们分析了嵌入在图数据中的一些潜在问题,并讨论了如何以数据为中心的方式解决它们。最后,我们为数据为中心的图学习提供了一些建议的未来方向。

https://arxiv.org/abs/2310.04987

最近在非欧几里得领域的进展引起了人工智能(AI)社区的大量关注。图,作为典型的非欧几里得数据,在现实世界中无处不在,并已在许多领域中得到广泛应用,例如推荐、安全、生物信息学等。在过去的十年中,由于图模型的创新,图相关研究得到了推动,从图核心[1][2]到图嵌入[3][4],再到最新的图神经网络(GNNs)[5][6]。相反,关于图数据的固有方面的研究较少,包括质量、多样性、安全性等。 通常,AI的革命始终是由大量高质量数据的可用性引发的,随后是强大的模型。一个显著的例子是ImageNet[7]的成功,它为深度卷积神经网络的发展做出了重要贡献,例如AlexNet[8]和ResNet[9]。随着数据的重要性得到越来越多的认可,最近,AI社区的关注点从以模型为中心的方法转移到了以数据为中心的方法[10][11]。

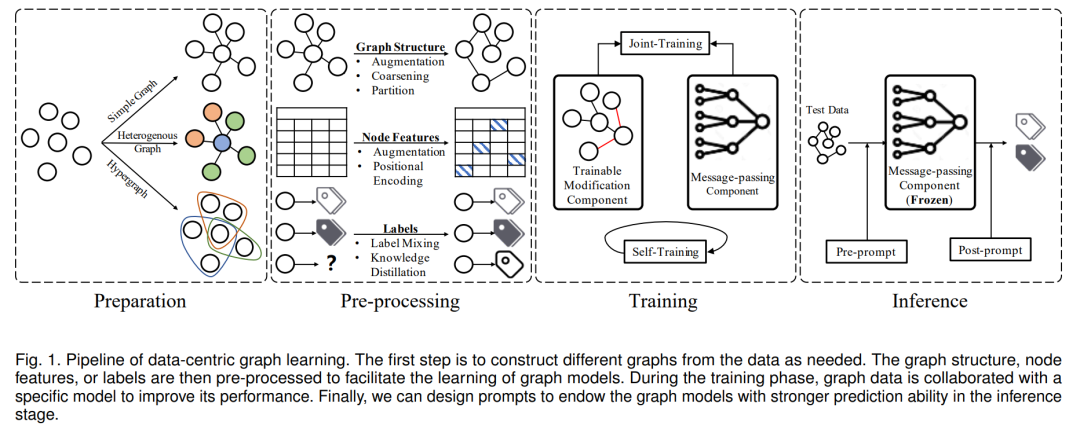

新兴的以数据为中心的AI强调产生适当的数据以提高给定模型的性能。“如何处理图数据以发挥图模型的全部潜力?”一个了解情况的答案可以帮助我们理解图数据与图模型之间的关系。然而,与图像和表格数据等欧几里得数据不同,图的不规则性为以数据为中心的图学习提出了几个问题:首先,在什么时候我们应该修改图数据以使图模型受益?数据修改可能会在图学习的不同阶段发生。例如,我们可以在训练之前启发式地扰动边,而在训练期间我们也可以从节点表示中估计新的图结构。其次,我们应该修改图数据的哪一部分?图数据涉及各种结构,包括边、节点、特性和标签,每一个都在图表示学习中起到了重要作用。第三,如何防止图模型受到有问题的图数据的影响?由于手工定义的关系和特性,图数据可能不可避免地引入噪声和偏见,这使得模型变得不可靠。 本综述系统地调研和分类了从数据中心的角度存在的图学习方法。具体地说,为了回答第一个问题,我们将图学习过程分为四个阶段:准备、预处理、训练和推断,如图1所示。我们讨论了每个阶段对图数据的重要性。接下来,我们进一步从结构的角度对现有方法进行分类,以解决第二个问题。具体来说,我们考虑如何处理图数据的拓扑、特征和标签。最后,我们分析了现有图数据中的潜在问题,包括脆弱性、不公平性、选择偏见和异质性。并进一步讨论如何从数据为中心的方式解决这些问题。

本文的贡献可以总结如下:

• 新的分类法。我们按图学习流程中的各个阶段对现有的数据中心图学习方法进行分类,包括预处理、训练和推理。对于每个阶段,我们都介绍了其在数据中心图学习中的目标和重要性。 • 多角度观察。我们强调如何处理图数据中的不同数据结构,包括拓扑、特征和标签,以发挥给定图模型的潜力。 • 全面的讨论。我们分析了有问题的图数据对图模型的潜在影响,并讨论了如何以数据为中心的方式缓解这些问题。此外,我们提出了四个可能的数据中心图学习的未来方向,这可能有助于这个领域的发展。 组织. 本调查的其余部分组织如下:第2节概述了数据中心图学习的背景,并描述了如何手动处理图数据。第3-5节分别介绍了预处理、训练和推理阶段的数据中心图学习方法。第6节介绍了图数据的潜在问题,并讨论了如何处理这些问题。最后,第7节对本文进行了总结,并提出了一些有前途的未来方向。

2. 预处理阶段

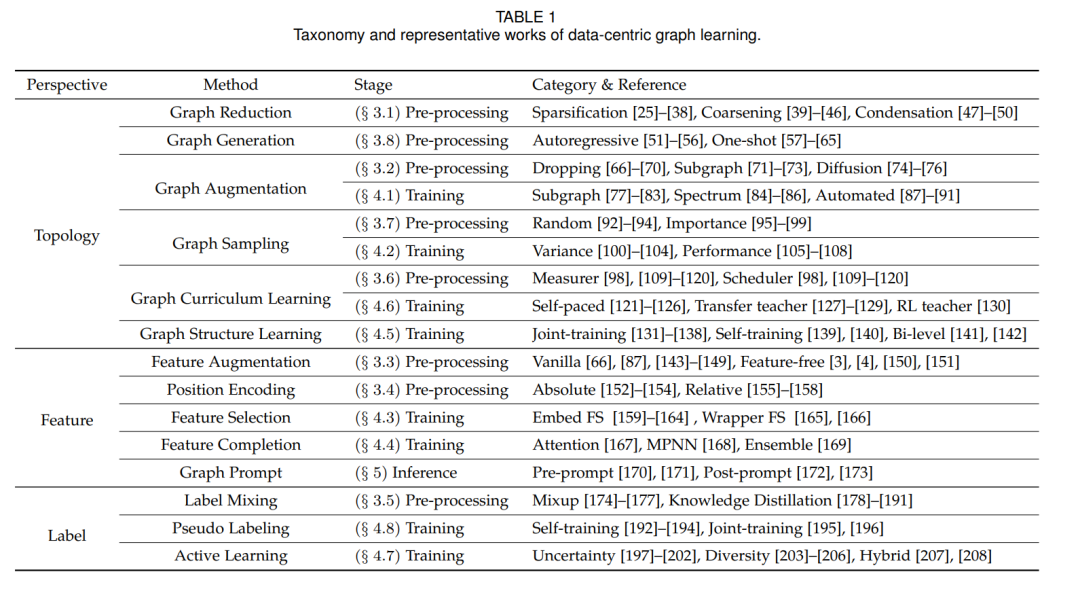

在本节中,我们将讨论图数据预处理阶段的数据中心方法。具体来说,我们将现有的方法分为两类:基于修改的方法和基于分布的方法。第一类旨在通过修改图数据实例来提高图模型的性能。第二类则着重于帮助图模型捕捉数据集的分布,同时保持图实例不变。此外,我们还考虑了不同的数据结构,包括拓扑、特征和标签。相关方法列示在表1中。

图的简化 (Graph Reduction)

随着图的规模的增大,其计算所消耗的时间和空间也会增加。因此,如何在不失去太多有用信息的前提下减少图的节点或边成为了一个有价值的问题。图的简化可以加速模型的训练,减少过拟合,并允许在更简单的硬件条件下对模型进行训练。图的简化可以分为两大类:边的简化和节点的简化。边的简化指的是图的稀疏化,而节点的简化包括图的粗糙化和图的凝缩。

图的增强 (Graph Augmentation)

在深度学习中,数据增强被认为是非常重要的。由于图数据的稀缺性和稀疏性相当严重,因此一个好的增强方法的重要性更为明显。与其他数据形式相比,直接操作图结构的图增强是最具特色的图数据增强类型。在这里,我们将介绍一些脱离训练的启发式方法。它们可能很简单,但证明是非常有效和受欢迎的。 特征增强 (Feature Augmentation)

通过创建或修改节点特征,特征增强可以使后续模型避免过拟合并提高其性能。 对于已经有特征的图,我们可以做一些直观的调整来加强它们,例如特征损坏 [143]-[145],特征洗牌,特征掩码 [66], [87], [146],特征添加,特征重写 [147], [148],特征传播,特征混合 [149]等 [15]。 对于最初没有特征的节点,有适当生成特征的方法。为了获取结构信息,Perozzi 提出了基于 word2vec [150] 的 deepwalk [3],它从每个节点开始,多次随机走动,最后使用所有路径为节点通过 word2vec [150]c 生成节点嵌入。接着,node2vec [4] 来自 deepwalk [3],它为节点添加了一个随机行走的概率。另一条与随机行走无关的线是 SDNE [151]。他们通过编码器-解码器架构得到图的结构。具体来说,他们将邻接矩阵的每一列作为初始节点嵌入,这是编码器的输入。并计算模型在初始嵌入和解码嵌入之间的损失。 在非标记图中,特征增强是通过无监督学习实现的。例如,GREET [211] 将原始图分割成两个子图,一个包含同质边,另一个包含异质边,然后通过两个单独的 GNN 得到子图嵌入,再连接这些子图嵌入来获取节点特征。 总的来说,特征增强是多种多样和任意的,特殊的特征增强可以根据特定问题的需要进行定制。 位置编码 (Position Encoding)

众所周知,信息传递神经网络 (MPNNs) 的表达能力受到1-Weisfeiler-Lehman (WL) 测试的限制,不能区分同构图 [212]。为了打破这个限制,一个受欢迎的方法是用一些位置信息来增强节点特征,这被称为位置编码。在本节中,我们将介绍两种类型的位置编码:绝对方法和相对方法。 标签混合 (Label Mixing)

标签混合旨在将带有标签或嵌入的两个不同实例混合为一个新的实例,并使用这些混合的实例来训练模型。这样得到的模型更具泛化性,不容易过拟合。 Mixup 在图分类和节点分类任务中都扮演着重要的角色。一方面,面对图分类任务,我们可以采用各种方法来增强模型。一种方法 [174] 涉及混合多个预先存在的图嵌入。或者,我们可以随机选择一个子图,并用另一个图中的相应子图替代它,同时保留原始图的嵌入,使模型更好地集中于数据的相关方面 [175], [176]。另一方面,一些工作 [177] 提议将邻近节点的标签或嵌入进行混合,用于节点分类任务。 图的课程学习 (Graph Curriculum Learning) 课程学习 (CL) [215] 是一种模仿人类学习过程的训练策略,主张模型从简单样本开始学习,然后逐渐过渡到复杂样本。这种策略可以帮助模型更快地收敛,并提高模型的泛化能力。图的课程学习 (Graph CL) [216] 是一种基于图的课程学习方法,主要用于图神经网络的训练和优化。大多数 CL 方法有两个重要功能,难度测量器和训练调度器。难度测量器可以评估训练数据的难度,以给予学习优先权,而训练调度器决定如何从简单到困难地进行学习。根据这两者是否自动设计,CL 方法可以分为两类,即预定义的 CL 和自动的 CL。在本节中,我们将介绍预定义的 Graph CL。 图采样 (Graph Sampling) 图采样方法使用不同的策略对节点进行采样,并在计算节点的表示时仅聚合部分节点的信息,这加速了模型的收敛并减少了内存开销。在这部分中,我们将讨论启发式采样方法,这些方法可以进一步划分为两个类别:随机采样和重要性采样。 图生成 (Graph Generation) 在现实世界中,某些图数据集对于图模型来说太小,无法有效地理解其分布。图生成器 [219], [220] 可以通过生成额外的图数据来帮助缓解这个问题。图生成的方法可以分为两种类型:自回归 (autoregressive) 和一次性生成 (one-shot)。 3. 训练阶段 (TRAINING STAGE)

在本节中,我们介绍了训练阶段的图数据修改方法,其中数据修改模块和信息传递模块合作以提高性能。具体而言,我们介绍了三种模型-数据协同的训练范式,包括联合训练 (joint training)、自训练 (self training) 和双层训练 (bi-level training)。相关方法可以在表格 1 (Table 1) 中查看。 4. 推断阶段 (INFERENCE STAGE)

推断阶段是指使用预训练的图模型进行下游任务的阶段。在这个阶段,我们重新定义下游任务为一个统一的模板,以与我们的预训练模型对齐。这有助于弥合我们的预文本任务与下游任务之间的差距,实现高质量的知识转移和多任务适应。此外,推断数据是指在预训练模型的推断阶段使用的图数据。从数据中心的角度看,调整推断数据作为提示可以帮助在不改变模型参数的情况下获得期望的目标。在本节中,我们讨论了在图的背景下逐渐受到欢迎的提示学习方法。为了详细说明,我们将现有的图提示方法分为两类:预提示 (pre-prompt) 和后提示 (post-prompt),这取决于任务特定的提示是在信息传递模块之前还是之后操作,如图 1 (Figure 1) 所示。 结论 (CONCLUSION)

在这篇综述中,我们对数据中心的图学习进行了全面的回顾。我们从两个角度对现有方法进行分类:一个是学习阶段,包括预处理、训练和推断;另一个是数据结构,包括拓扑、特征和标签。通过这两个视角,我们仔细解释了何时修改图数据以及如何修改图数据,以释放图模型的潜力。此外,我们还介绍了图数据的一些潜在问题,并讨论了如何用数据中心的方法解决它们。最后,我们提出了该领域的几个有前景的未来方向。总的来说,我们相信数据中心的人工智能是通向一般人工智能的可行路径,并且数据中心的图学习将在图数据挖掘中发挥重要作用。