**面向可信赖推荐系统:构建可解释且无偏的推荐系统

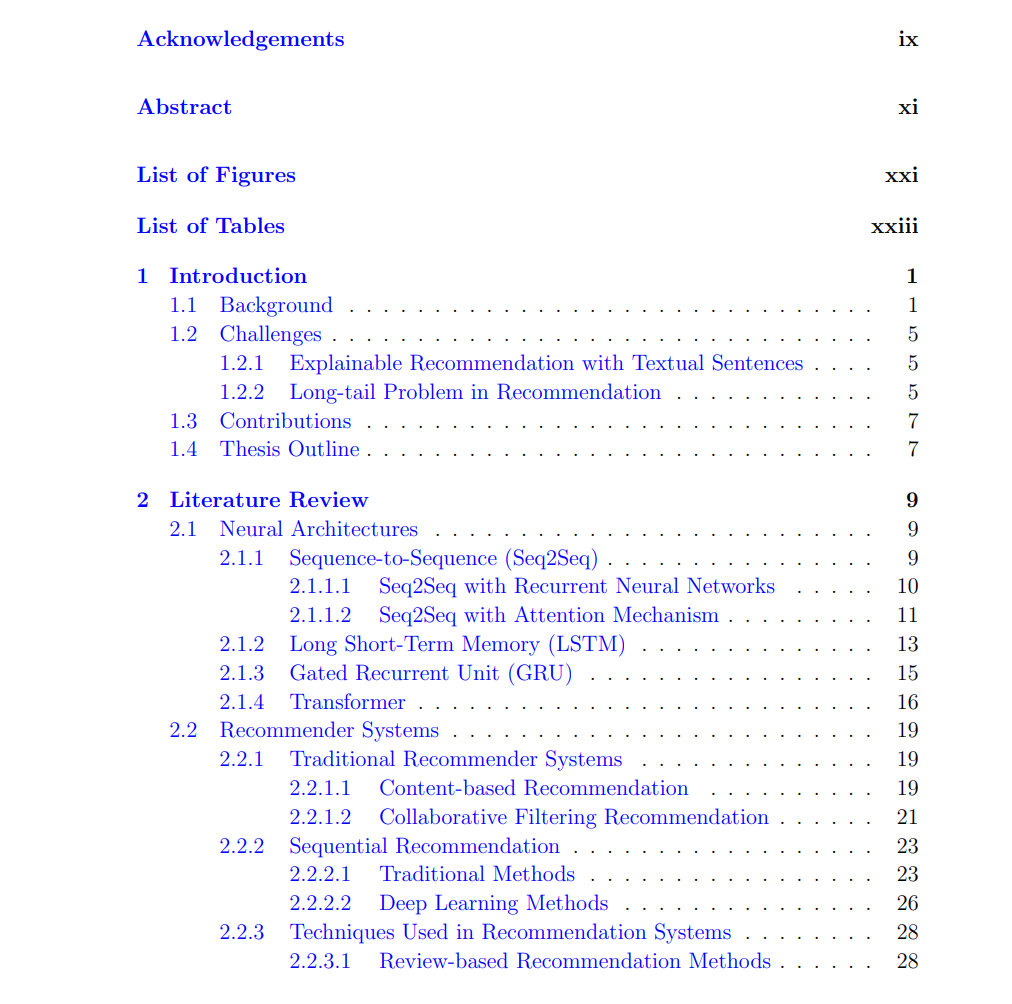

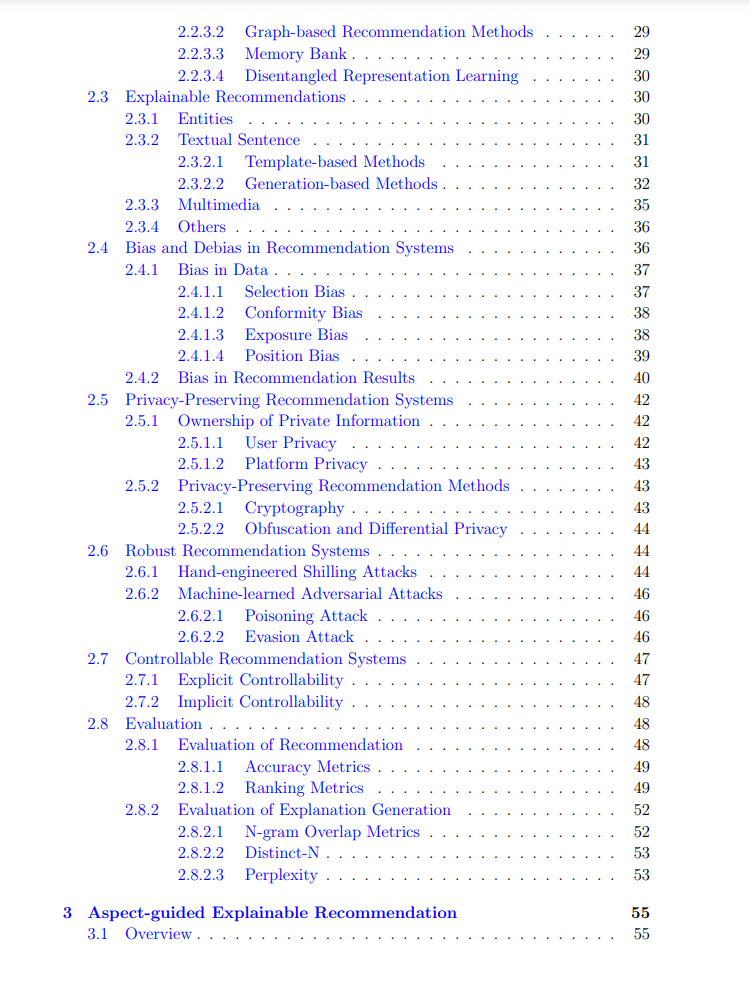

https://dr.ntu.edu.sg/handle/10356/175790 随着在线内容的爆炸性增长,如电子商务平台(如亚马逊、淘宝)上的商品曝光量不断增加,用户在大量选项中挑选合适商品或信息变得异常困难。推荐系统作为解决此问题的强大工具,能够通过向用户推荐相关商品或信息列表,帮助其进行决策。然而,推荐系统的推荐结果缺乏透明性,以及其对特定商品(如热门商品)的潜在偏袒,可能会削弱用户对系统的信任和满意度。因此,市场对可信赖推荐系统(Trustworthy Recommendation Systems,TRS)的需求日益增加。这类系统不仅需要提供准确的推荐,还应遵循可解释性、公平性、隐私性、鲁棒性和可控性等核心原则。

本研究重点探讨了可信赖推荐系统中的两个重要方面:可解释性和公平性,并旨在开发一个透明且无偏的推荐系统,以提高推荐系统的透明度和公平性。推荐系统中存在的多种偏差可能会导致不公平的推荐,因此,可解释性和公平性成为TRS研究中的关键挑战。以下总结了本文中提出的创新性解决方案,以解决当前推荐系统面临的三大挑战:

1. 可解释推荐的挑战

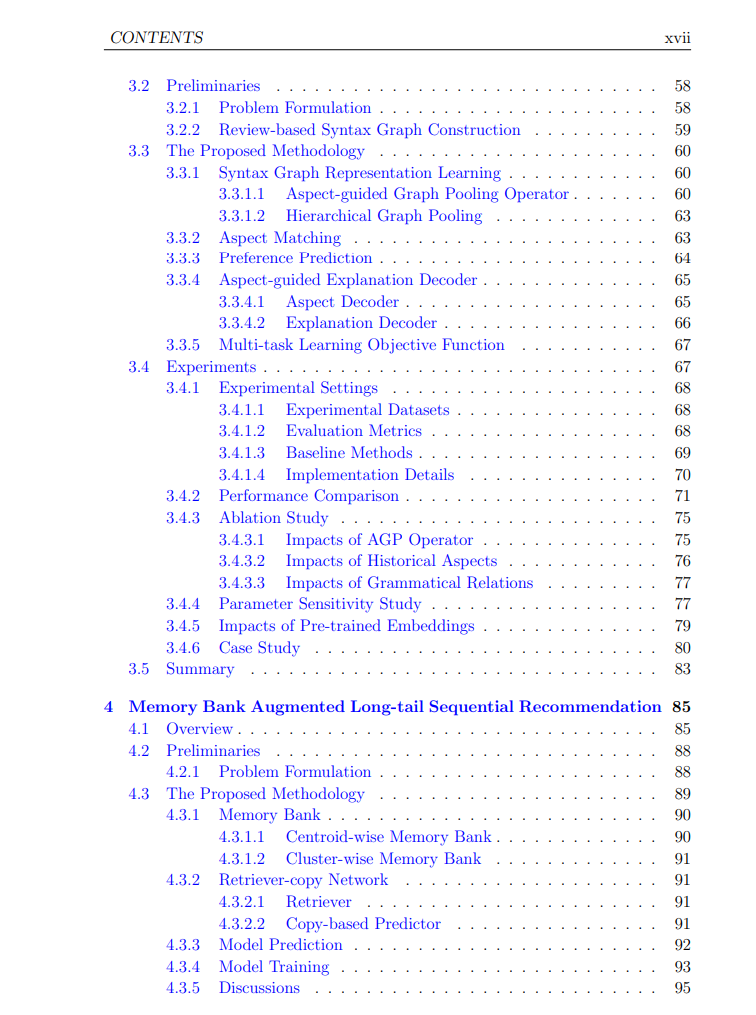

现有的可解释推荐方法往往未充分考虑用户在不同商品方面的偏好,导致生成的解释信息不连贯或无关。这种局限性源于缺乏生成信号。为此,我们提出了基于语法图的Aspect-guided Explanation generation with Syntax Graph (AESG) 方法。AESG通过基于评论的语法图,从整体上呈现用户或商品的详细信息,并引入了一个基于方面的图池化操作符,以从语法图中提取与方面相关的信息,从而在方面层面建模用户对商品的偏好。实验结果表明,AESG在单方面和多方面解释生成任务中均优于现有方法,并在偏好预测准确性上表现出色。

2. 长尾问题中的挑战

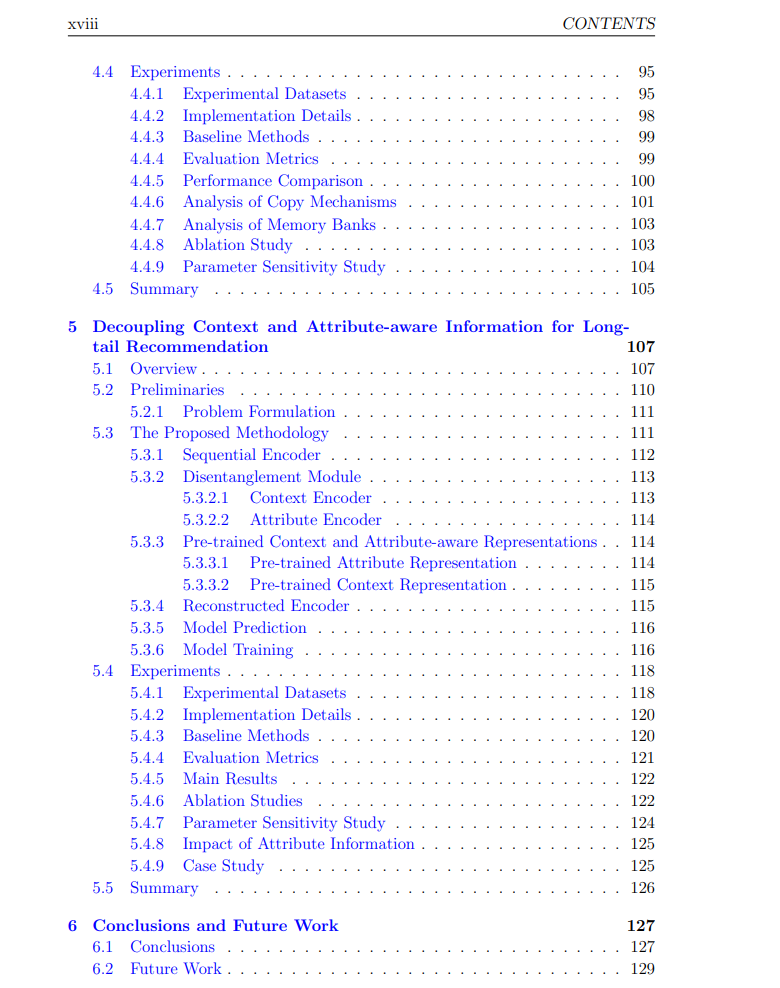

为应对长尾问题,我们提出了一个名为**MASR(Memory Bank Augmented Long-tail Sequential Recommendation)**的创新型序列推荐框架。MASR采用“开放书”模型,将记忆库与检索复制网络相结合,以减轻长尾问题。在推理阶段,设计的检索复制网络从训练样本中检索相关序列并复制有用信息,提升长尾商品的推荐性能。两种设计的记忆库通过记忆训练阶段出现的历史样本,为检索复制网络提供参考。实验结果显示,MASR在五个真实数据集上均优于基准方法,显著提升了长尾商品的推荐表现。

3. 序列推荐中的上下文与属性分离

传统的序列推荐模型在处理长尾数据时,往往由于数据稀疏性对稀有商品(长尾商品)产生偏见。为此,我们提出了**DCAIR(Decoupling Context and Attribute-aware Information for Long-tail Recommendations)**框架,通过分离上下文和属性特征来提升商品表示,尤其是长尾商品。DCAIR采用细粒度的分离模块,将顺序特征分解为上下文和属性特征,以更精确地表示商品。同时,我们利用预训练的提示模型学习多种属性,使得属性特定知识得以整合。实验结果表明,DCAIR在四个真实数据集上显著优于六种最新基准方法,尤其在长尾商品的推荐性能上取得了显著进步。 综上所述,本文通过探讨可信赖推荐系统的可解释性与公平性,提出了一系列方法以提升推荐系统的透明性和公平性,为推荐系统在实际应用中的更广泛应用提供了理论支持和实践指导。希望这些研究成果能够激励未来的研究工作,推动推荐系统朝着更可信赖和负责的方向发展。