大型基础模型在实现人工智能领域的最新突破中发挥了核心作用。通过同时将数据集和模型规模扩展到前所未有的水平,这些基础模型在蛋白质结构预测、图像/视频生成、代码生成、聊天机器人等许多领域表现出色。然而,它们的计算和内存成本也急剧增长,使得这些基础模型在实际应用中的部署变得困难,尤其是在资源受限的边缘设备上。此外,巨大的训练成本也显著阻碍了新基础模型的发展,并引发了对巨大能源消耗和二氧化碳排放的担忧。为了解决这些问题,构建有效的模型加速技术对于缩小计算供需之间的差距至关重要。 本论文将涵盖模型加速的三个重要方面。首先,我们将讨论高效表示学习,包括用于高分辨率视觉的EfficientViT(一种新的视觉Transformer架构)和用于条件图像生成的条件感知神经网络(一个新的控制模块)。其次,我们将介绍硬件感知的加速技术,以创建针对不同硬件平台和效率限制的专用神经网络。第三,我们将介绍TinyTL,这是一种内存高效的迁移学习技术,用于实现设备上的模型定制。通过我们的设计,我们可以显著提高深度神经网络在硬件上的效率,而不损失准确性,使它们更易于访问并降低其服务成本。例如,我们的模型在A100 GPU上实现了48.9倍的吞吐量提升,同时在零样本实例分割性能上略微优于最新的模型。在条件图像生成方面,我们的方法实现了52倍的计算成本降低,而性能没有下降。

大型基础模型在许多人工智能领域(包括自然语言处理[1], [2]、计算机视觉[3]–[5]、科学领域的AI应用[6]等)引发了革命性的变化。通过扩大模型规模并在网络规模的数据集上训练,这些基础模型展示了惊人的少样本/零样本学习能力,能够解决复杂的任务。这些卓越的表现引发了在实际应用中使用这些基础模型的热潮,将人工智能引入了我们的工作和日常生活。 然而,由于模型规模和计算成本的增加,这些基础模型的训练和推理成本非常高昂。例如,GPT-3[7]模型拥有1750亿个参数,仅存储它就已经超出了目前最强大的GPU(如NVIDIA H100 GPU)的容量。这对在云平台上提供这些模型服务或在边缘设备上部署它们提出了巨大挑战。此外,高昂的训练成本还导致了巨大的能源消耗和二氧化碳排放,引发了对这些AI基础模型的可持续性问题的担忧。 在本论文中,我们旨在研究模型加速技术,以提高深度神经网络的效率,从而应对这一挑战。我们的方法从三个方面加速深度神经网络。首先,我们将讨论高效的表示学习,旨在构建高效的构建模块/神经网络架构,从原始数据中提取有用信息。其次,我们将讨论硬件感知的加速方法,旨在为不同的硬件平台和效率约束定制专用的神经网络,以获得精度和硬件效率之间的最佳平衡。第三,我们将讨论高效的模型定制,允许内存高效的设备端学习,以提供定制化的AI服务而不牺牲隐私。我们总结了本论文的主要内容如下:

**1.1 论文大纲

-

第2章 描述了高效表示学习的技术。内容基于[8]和[9]。首先,Transformer架构是当前大型基础模型的核心组件。然而,Transformer架构在处理长序列时表现不佳,因为其计算成本随着输入序列长度的增加而呈二次增长。我们提出了EfficientViT,这是一种用于高分辨率视觉的新型视觉Transformer架构。它通过仅使用硬件高效的操作,达到了全局感受野和强大的容量。EfficientViT在不同的硬件平台上提供了显著的性能提升。其次,添加控制是将图像/视频生成模型转化为人类生产工具的关键步骤。我们提出了条件感知神经网络(CAN),这是一种为图像生成模型添加控制的新方法。与以往的条件控制方法并行,CAN通过动态操控神经网络的权重来控制图像生成过程。CAN在扩散Transformer模型中持续带来显著改进。

-

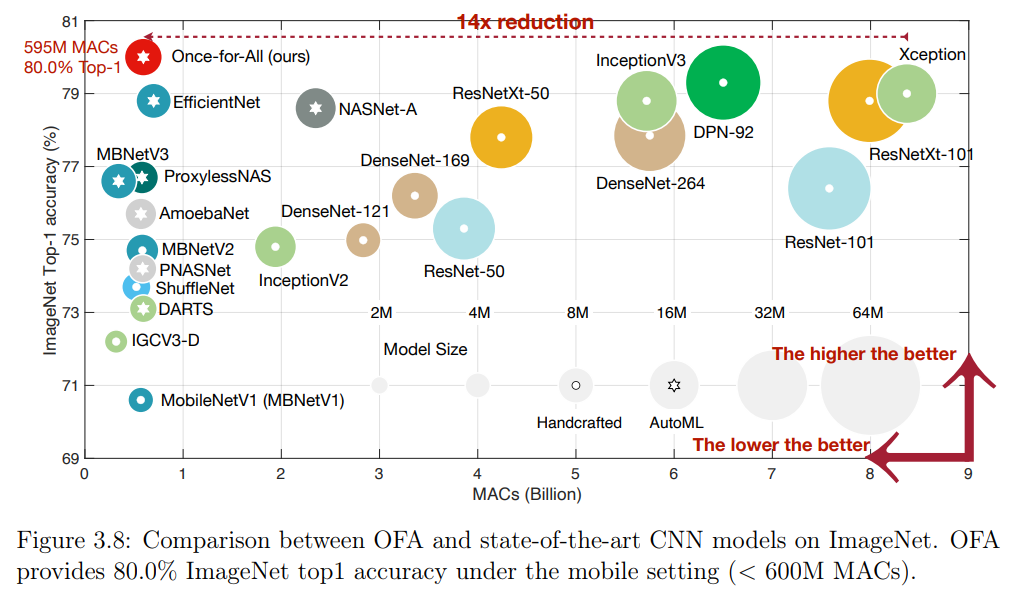

第3章 介绍了硬件感知的AutoML技术,以有效地为不同的硬件平台和效率约束定制专用的深度神经网络。内容基于[10]和[11]。不同的硬件平台具有不同的属性(例如并行度、缓存大小、带宽等)。针对不同的目标硬件平台和不同的效率约束,我们需要定制化的神经网络以实现性能与效率之间的最佳平衡。然而,手动为每个案例定制神经网络是不可扩展的。因此,我们提出了硬件感知的AutoML技术来应对这一挑战。我们的方法在不同的硬件平台上提供了显著的加速,包括手机、CPU、GPU、FPGA等。此外,我们的方法在多个低功耗计算机视觉挑战赛中获得了第一名。

-

第4章 介绍了TinyTL[12],一种用于内存高效的设备端学习技术。TinyTL冻结了权重,只学习内存高效的偏置模块,因此不需要存储中间激活。为了保持适应能力,我们引入了一种新的内存高效偏置模块,即轻量残差模块,通过学习小的残差特征图来优化特征提取器,仅增加了3.8%的内存开销。广泛的实验表明,TinyTL在与微调整个网络相比仅有微小的准确性损失的情况下,显著节省了内存。