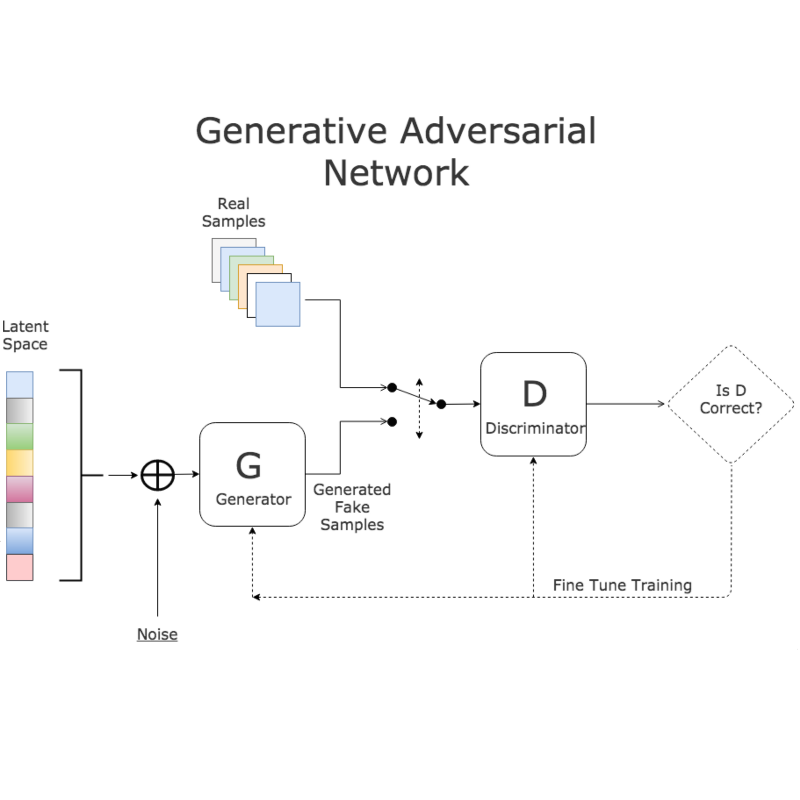

**生成建模承诺为学习图像和视频等高维数据分布提供一种优雅的解决方案——但我们如何揭示和利用这些模型发现的丰富结构呢?**除了生成新样本之外,智能体还能如何利用 p(x) 作为了解世界运作方式的知识来源呢?本论文探讨了可扩展的归纳偏差,解锁了生成模型对视觉数据的解耦理解,从而实现更丰富的交互和控制。 首先,我提出了一种将场景表示为特征“斑块”集合的方案,在这种方案中,生成对抗网络(GAN)无需任何标签就能学会将每个斑块绑定到其生成的图像中的不同对象上。这使得GAN能够更优雅地建模组合场景,而典型的无条件模型则受限于高度对齐的单对象数据。经过训练的模型表示可以很容易地进行修改,以反事实地操纵生成和真实图像中的对象。

https://www2.eecs.berkeley.edu/Pubs/TechRpts/2024/EECS-2024-65.html

接下来,我考虑了在训练期间不对架构施加瓶颈的方法,从而使这些方法能够应用于更多样化、未经过滤的数据。我展示了扩散模型的内部可以被用于有意义地引导新样本的生成,而无需进一步的微调或监督。从去噪器激活的一小组原始属性中得出的能量函数可以组合起来,对迭代扩散采样过程施加任意复杂的条件。这使得能够控制任何可以用文本描述的概念的属性,例如位置、形状、大小和外观。 我还证明,文本到图像模型学习到的分布可以被蒸馏以生成组合性3D场景。主流方法专注于孤立地创建3D对象,而不是包含多个实体交互的场景。我提出了一种架构,在对其进行优化使其输出位于图像生成器的流形上时,可以生成分解为其包含对象的3D场景。这为模型仅通过2D图像观察到的世界推断实际3D结构提供了证据。最后,我以一个视角总结了涌现、控制、可解释性和规模之间的相互作用,并尝试将这些主题与对智能的追求联系起来。