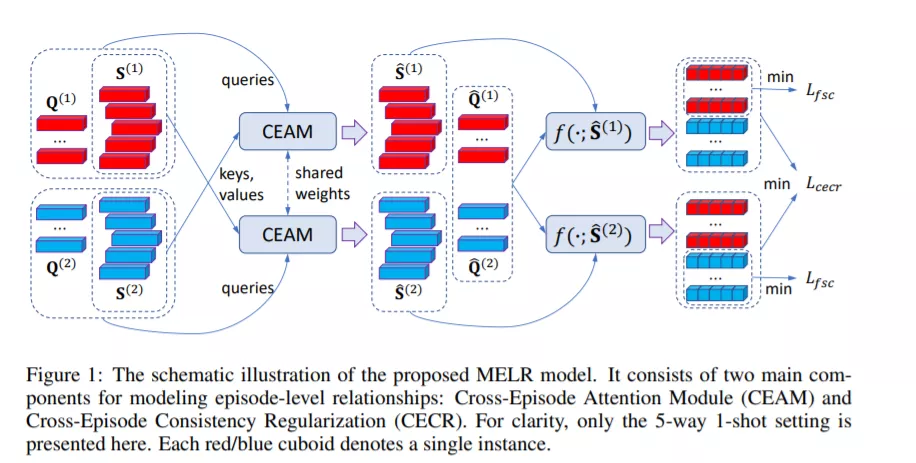

最近的小样本学习方法几乎都是基于场景式(元任务式)训练,即为了模仿测试时的情况,每个元任务中对于每个类只采样少量训练样本(支撑样本)。然而,这种严格仿照测试情况的训练方式有个副作用,即训练得到的模型容易受到少量支撑样本的坏采样的影响。在本工作中,我们第一次以探索场景之间关系的方式来尝试解决该问题。特别地,我们提出了一个新颖的建模场景级别关系的元学习(MELR)框架:通过采样两个拥有相同类别集合的场景用于元训练,MELR用来保证训练得到的模型在元测试阶段对于质量不高的支撑样本的存在是鲁棒的。这可以通过设计两个关键部件来实现:(1)一个跨场景注意力模块(CEAM)来提高模型减少坏采样支撑样本带来的反作用的能力;(2)一个跨场景一致性正则(CECR)来保证分别在两个场景下独立得到的两个分类器有一致的表现。在两个基准数据集上,大量标准小样本学习实验显示我们的MELR相比于我们使用的基准方法(原型网络)取得了1.0%- 5.0%的性能提升,而且在相同设置下打败了最新的方法。

https://openreview.net/forum?id=D3PcGLdMx0

成为VIP会员查看完整内容