可解释人工智能

·

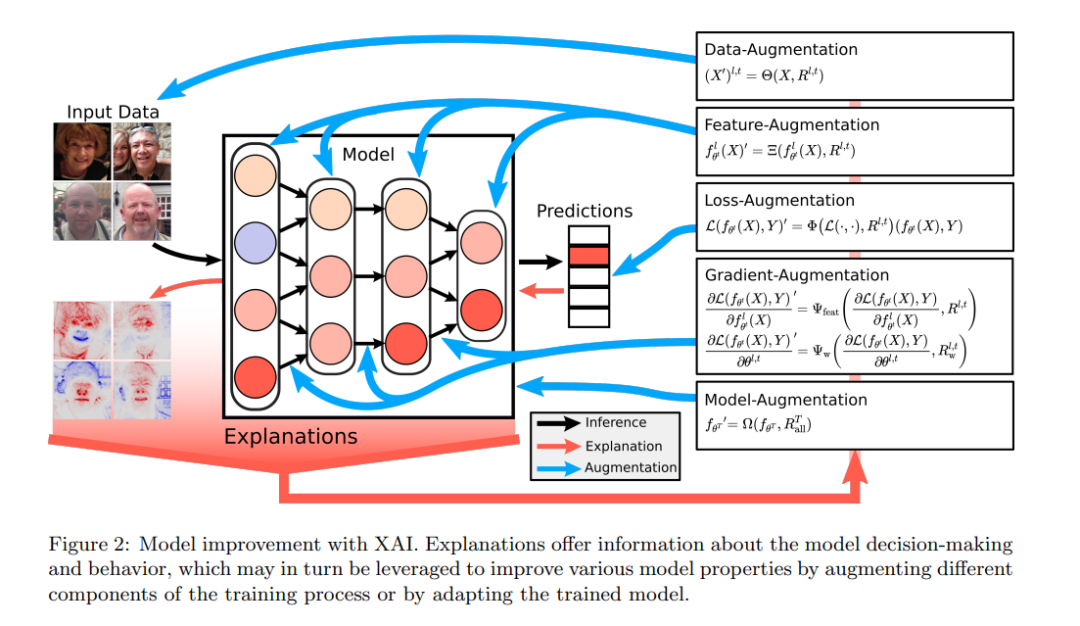

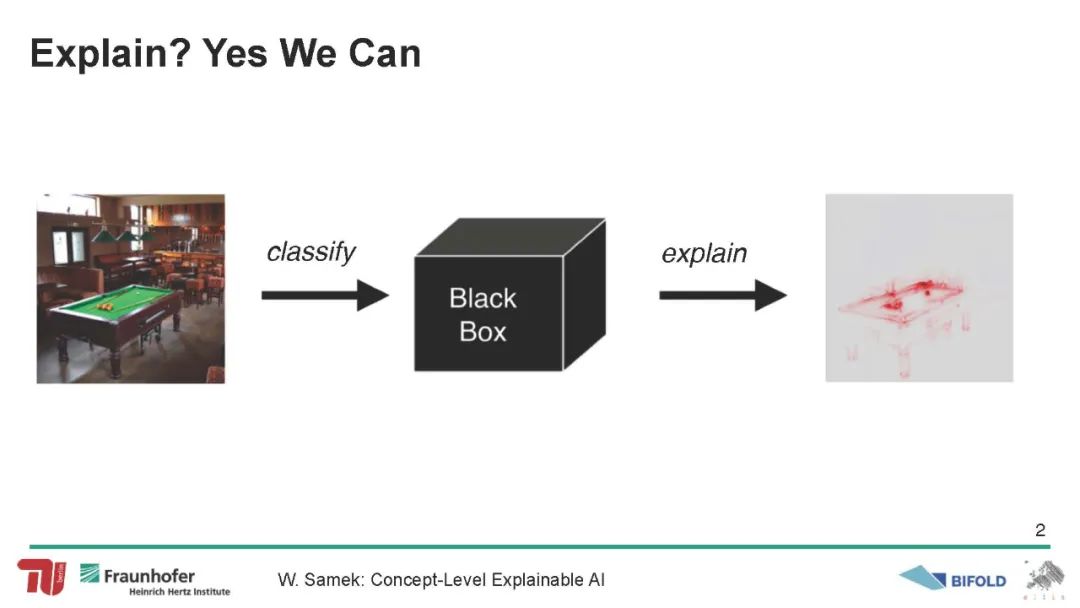

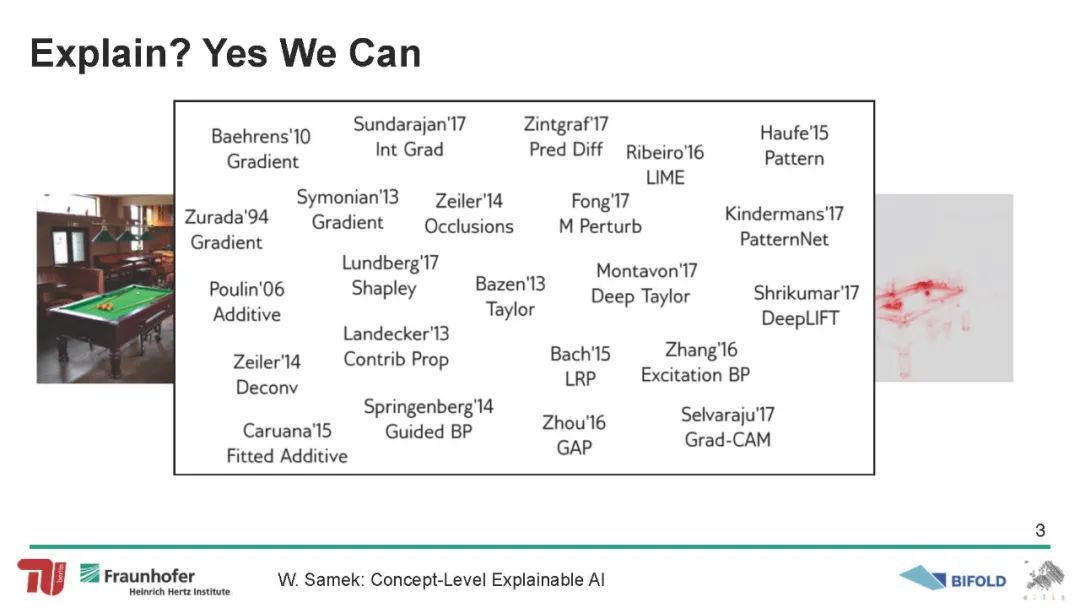

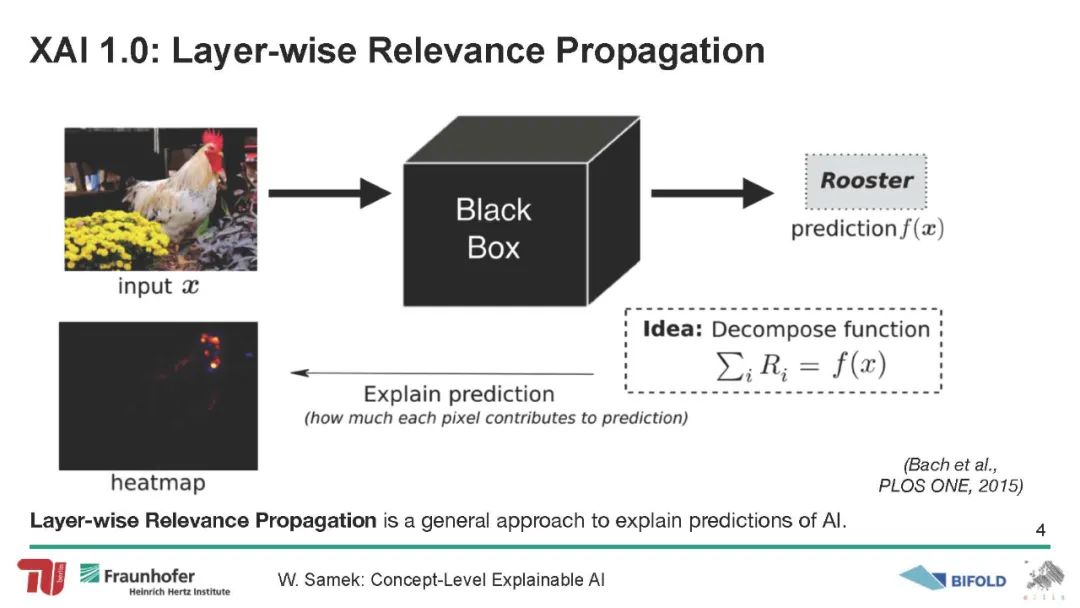

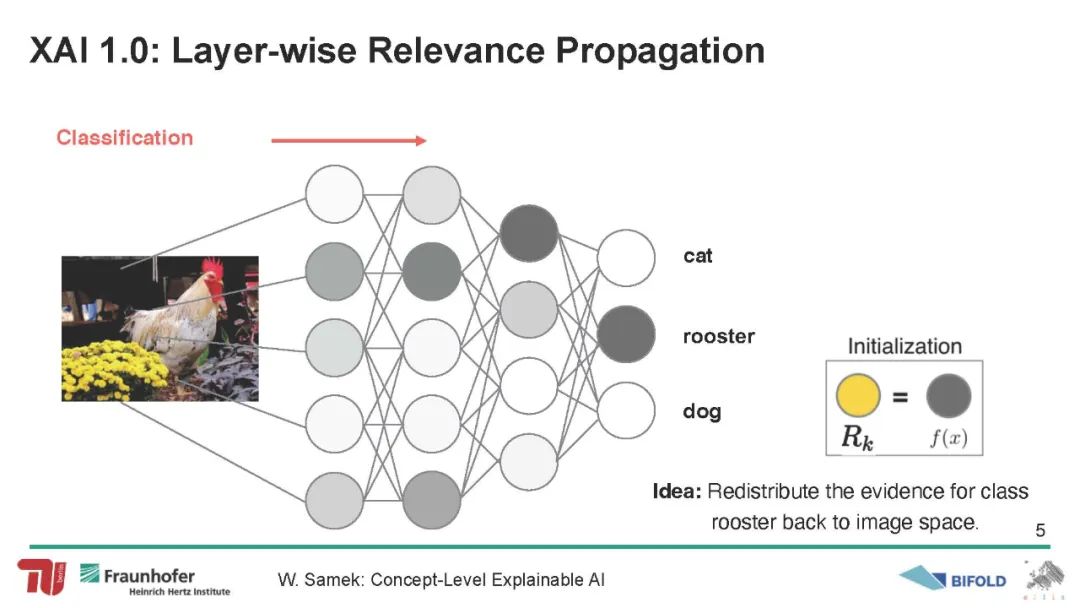

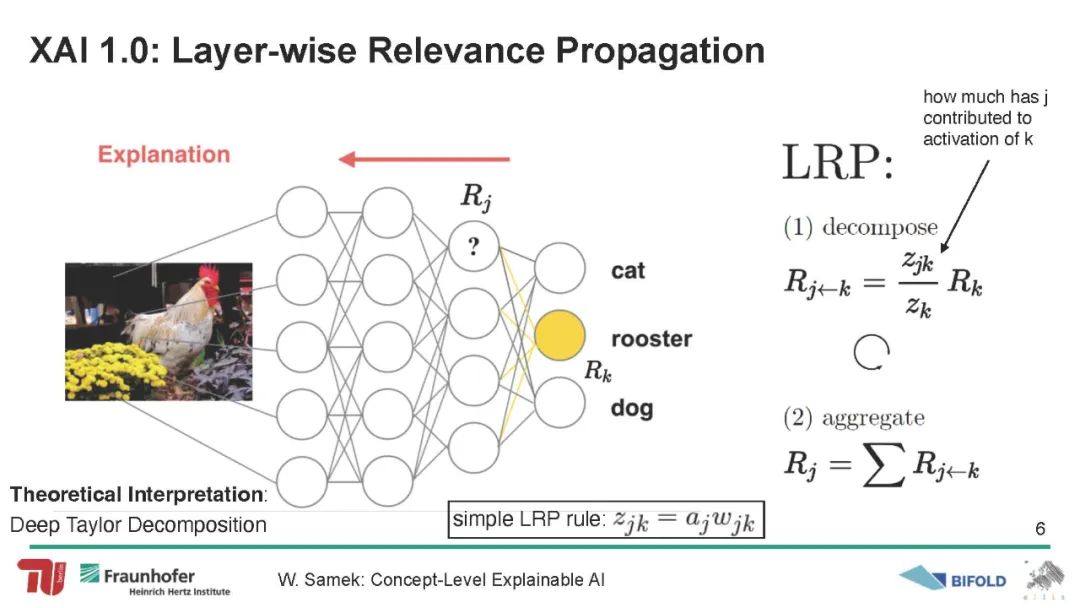

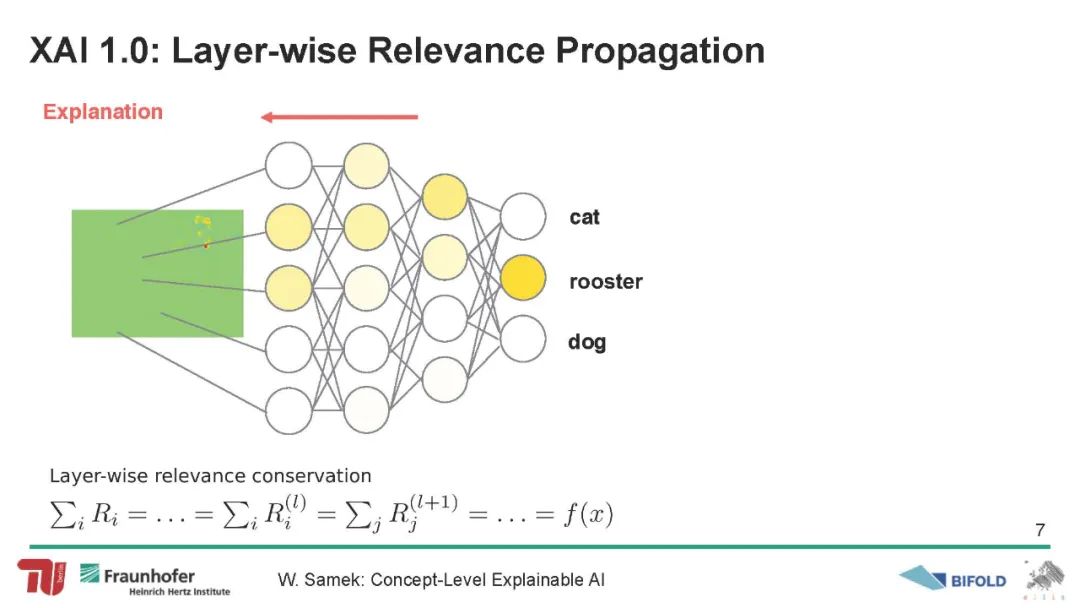

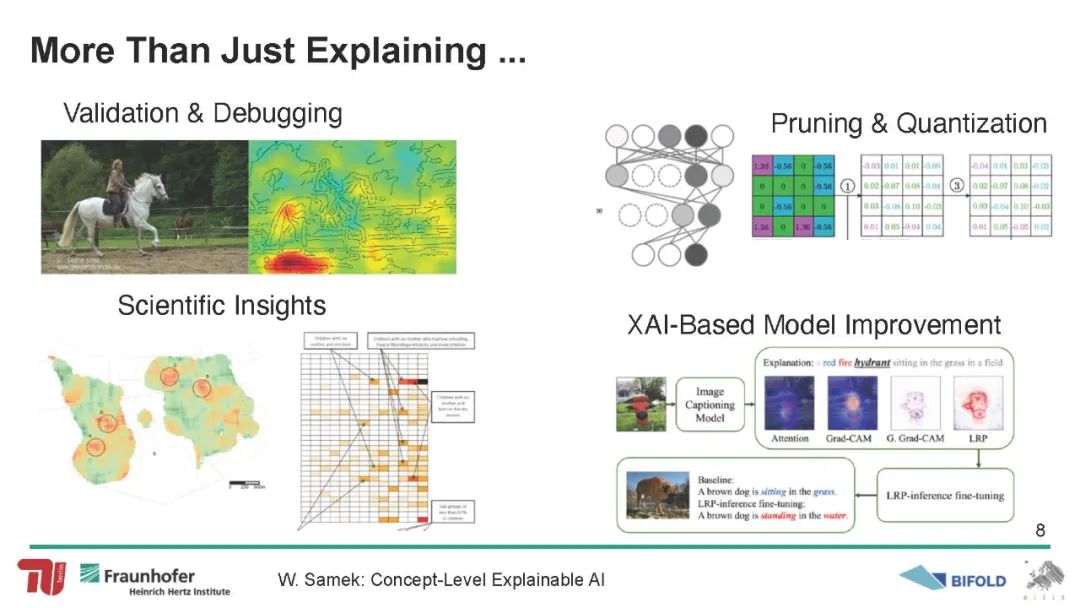

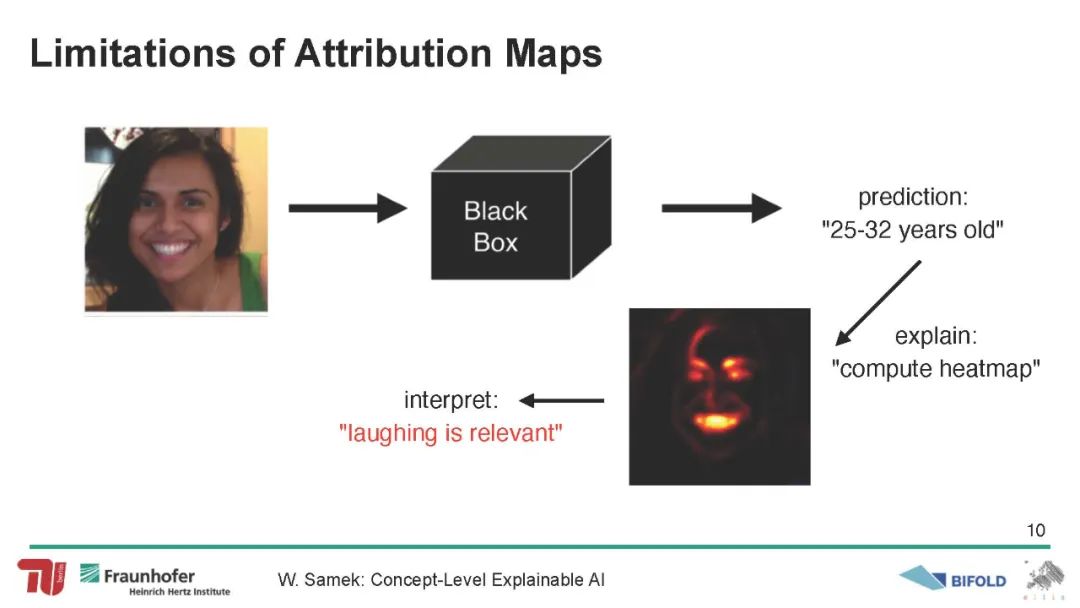

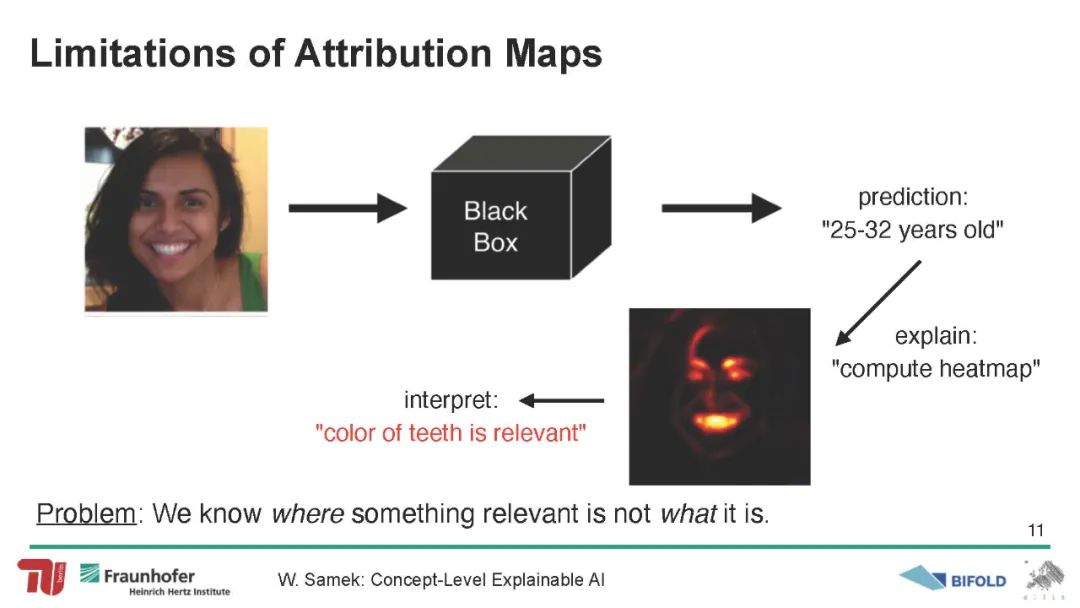

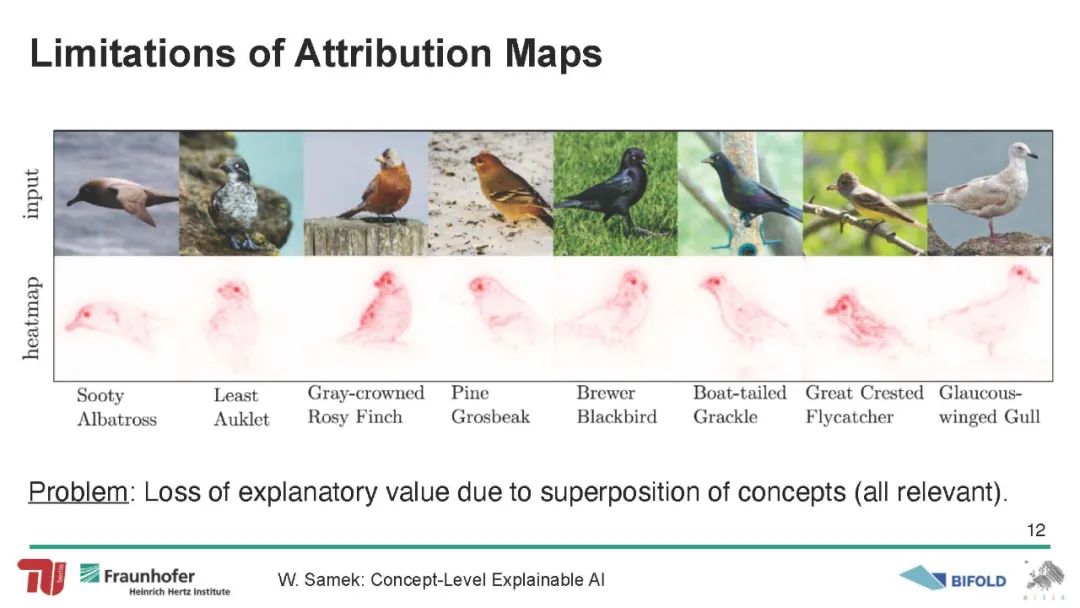

可解释人工智能(XAI)是一个新兴的研究领域,为高度复杂和不透明的机器学习(ML)模型带来了透明度。尽管近年来发展了多种方法来解释黑盒分类器的决策,但这些工具很少用于可视化目的之外。直到最近,研究人员才开始在实践中使用解释来实际改进模型。本文对实际应用XAI以获得更好的机器学习模型的技术进行了全面的概述,并系统地对这些方法进行了分类,比较了它们各自的优缺点。本文为这些方法提供了一个理论视角,并通过在toy和现实场景上的实验,实证地展示了解释如何有助于改善模型泛化能力或推理等属性。进一步讨论这些方法的潜在注意事项和缺点。我们的结论是,虽然基于XAI的模型改进甚至可以对复杂的和不容易量化的模型属性产生显著的有益影响,但这些方法需要谨慎应用,因为它们的成功取决于许多因素,例如使用的模型和数据集,或采用的解释方法。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年4月13日

Arxiv

0+阅读 · 2023年4月13日

Arxiv

0+阅读 · 2023年4月12日

Arxiv

0+阅读 · 2023年4月10日