机器学习正在成为现代世界运行中不可或缺的一部分。随着数字技术的进步,数据的收集量呈指数级增长,机器学习的力量也在不断发展。机器学习模型从这些现在可用的巨大数据库中学习和改进。模型变得越来越强大,在许多情况下,它们执行任务的效率和效率比人类同行更高。随着越来越多的组织和企业采用机器学习技术,可解释性变得越来越重要。

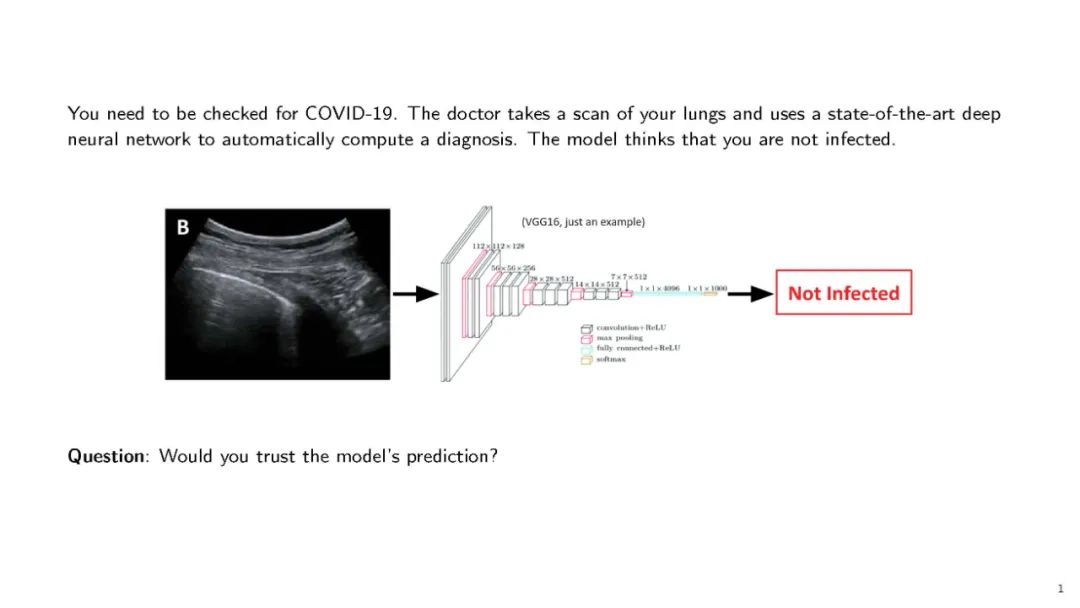

模型被用于自动化任务和发现数据中的新趋势和模式。这些算法直接从数据中学习,而不是由人类开发人员创建。这意味着系统将在没有直接人类互动的情况下进化和发展。因此,理解模型为什么会做出决策在最初可能是不清楚的,特别是对于没有数据科学经验的涉众来说。对于深度学习等更复杂的机器学习技术来说,这可能尤其困难。深度学习模型的多层神经结构使得决策的透明度变得更加复杂。

与组织中的任何决策工具一样,一定程度的问责制是必要的。机器学习模型已经被用于自动化资源密集型的管理工作和做出复杂的业务决策。在决策将受到审查的领域,解释机器学习模型做出决策的原因的能力至关重要。例如,机器学习在金融领域的应用方式多种多样。算法可以用来自动化和简化贷款决策,甚至可以根据市场波动自动化股票训练。在这两个例子中,可解释性都是整个过程的组成部分。

本指南探讨了机器学习中的可解释性主题,包括它是什么,为什么它是重要的,以及实现模型可解释性的不同技术。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年10月6日

Arxiv

0+阅读 · 2022年10月4日

Arxiv

0+阅读 · 2022年9月30日