在过去十年中,自动驾驶在研发方面取得了重大的里程碑。人们有兴趣在道路上部署自行操作车辆,这预示着交通系统将更加安全和生态友好。随着计算能力强大的人工智能(AI)技术的兴起,自动驾驶车辆可以高精度地感知环境,做出安全的实时决策,在没有人为干预的情况下运行更加可靠。

然而,在目前的技术水平下,自动驾驶汽车中的智能决策通常不为人类所理解,这种缺陷阻碍了这项技术被社会接受。因此,除了做出安全的实时决策外,自动驾驶汽车的AI系统还需要解释这些决策是如何构建的,以便在多个政府管辖区内符合监管要求。

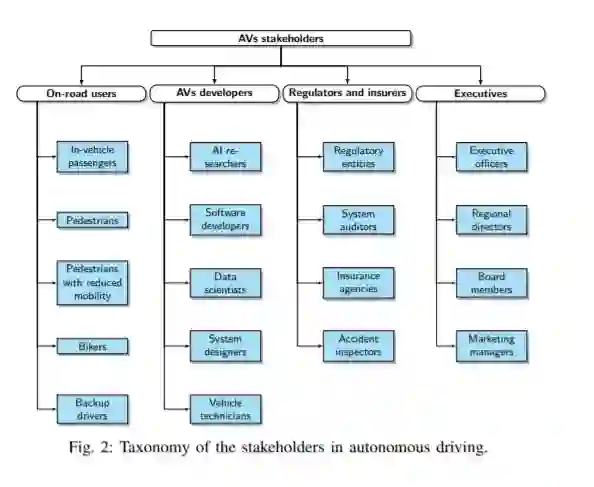

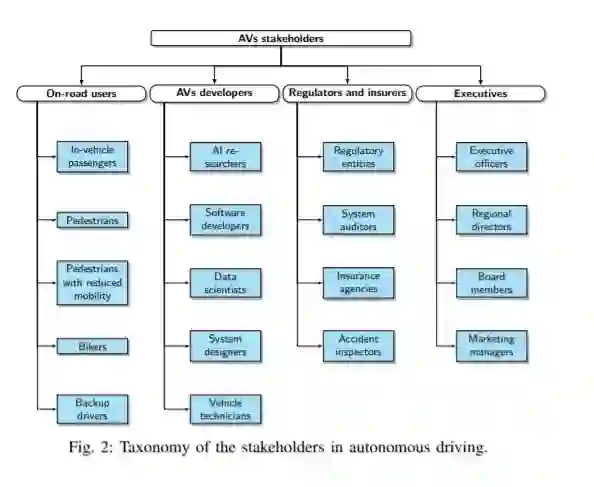

该研究为开发自动驾驶车辆的可解释人工智能(XAI)方法提供了全面的信息。首先,全面概述了目前最先进的自动驾驶汽车行业在可解释方面存在的差距。然后,展示该领域中可解释和可解释受众的分类。第三,提出了一个端到端自动驾驶系统体系结构的框架,并论证了XAI在调试和调控此类系统中的作用。最后,作为未来的研究方向,提供自主驾驶XAI方法的实地指南,提高操作安全性和透明度,公开获得监管机构、制造商和所有密切参与者的批准。

https://www.zhuanzhi.ai/paper/9810a4af041ac0189ca8750d0a25958c

成为VIP会员查看完整内容