关键词——对齐、直接偏好优化、大型语言模型、基于人类反馈的强化学习。

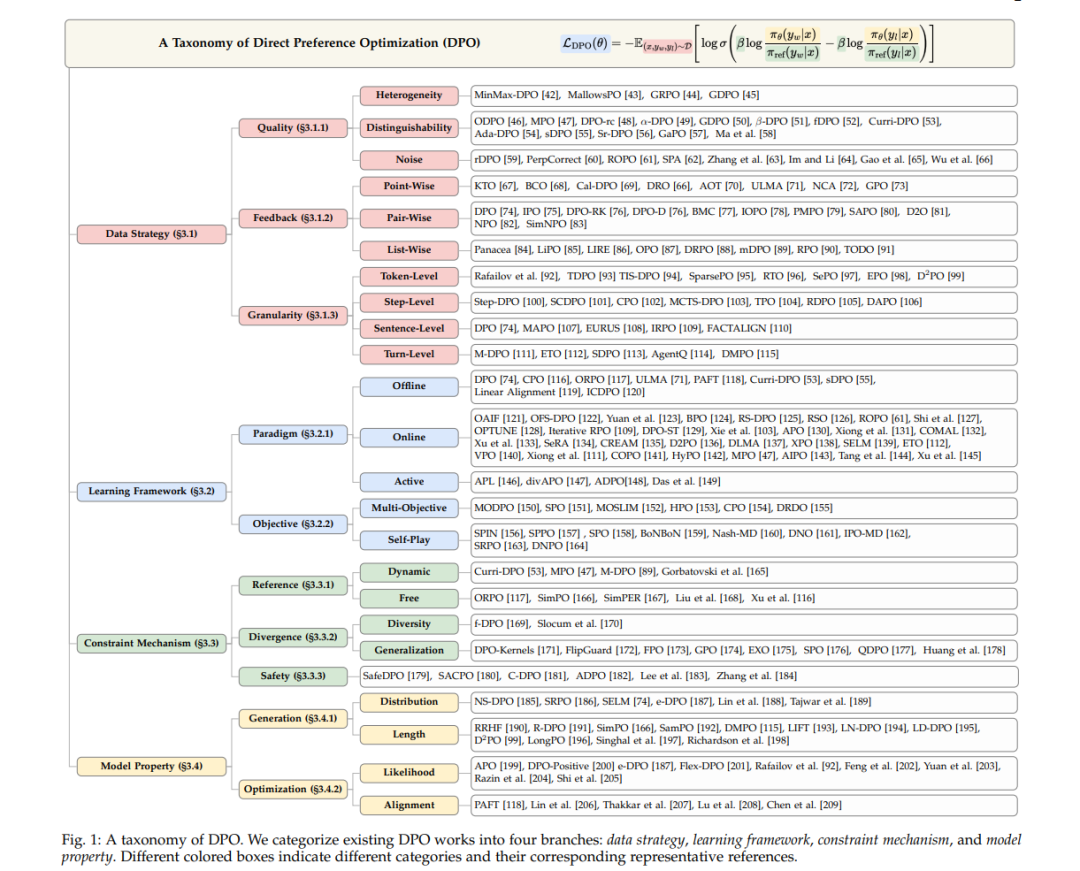

1 引言 大型语言模型(LLMs)的快速发展已经彻底改变了人工智能领域 [1, 2, 3, 4, 5, 6, 7, 8],在对话系统 [9, 10]、代码生成 [11, 12, 13] 和医疗诊断 [14, 15, 16, 17] 等多种应用中展现了前所未有的生成能力。诸如 OpenAI-o1 [18] 和 DeepSeekR1 [19] 等模型在理解和生成类人文本方面表现出色,超越了传统的语言处理技术 [20]。然而,其强大的能力也带来了显著的风险:LLMs 可能无意中生成有害内容(例如越狱建议)[21]、表现出幻觉行为(例如错误信息)[22],或传播社会文化偏见(例如带有偏见的推荐)[23]。因此,确保这些模型与人类价值观对齐(生成有益、无害且诚实的输出)已成为负责任的人工智能开发的基石 [24]。 将 LLMs 与人类价值观对齐的关键挑战在于将抽象的伦理原则编码为具体模型行为的复杂性 [25, 26, 27]。传统方法,如基于规则的过滤或对精选数据集进行监督学习,往往因无法在多样化情境中泛化或适应不断变化的社会规范而显得不足 [28]。基于偏好的对齐范式的出现解决了这些局限性,它将问题重新定义为优化人类反馈而非僵化的启发式方法 [29, 30, 31, 32]。这一转变认识到,LLM 的决策通常涉及竞争价值之间的微妙权衡,因此需要能够融入主观人类偏见的灵活框架 [33]。 基于这些见解,基于人类反馈的强化学习(RLHF)[34, 35] 已成为主流对齐范式,利用人类偏好来指导模型优化。在 RLHF 流程中,人类标注者首先对语言模型生成的输出进行排序,这些比较数据用于训练一个量化人类偏好的奖励模型。随后,语言模型通过强化学习(RL)在该奖励模型的指导下进行微调,从而使其能够通过最大化预测奖励来与人类价值观对齐。RLHF 在 ChatGPT [36, 37] 和 Claude [38, 39] 等模型对齐中的成功凸显了其实用性。通过将主观的人类偏好转化为客观的奖励信号,RLHF 促进了模型行为的优化以实现价值对齐。然而,RLHF 范式在计算复杂性和训练稳定性方面存在显著局限性。训练单独的奖励模型需要大量的计算资源和高质量的人类偏好数据,这在不同领域的扩展性较差。此外,RL 阶段常常面临优化挑战,例如奖励黑客攻击 [40] 和模式崩溃 [41]。 这些局限性促使研究者开始关注绕过奖励建模但仍保留基于偏好的学习优势的替代对齐方法。直接偏好优化(DPO)[74, 210] 代表了这一方向的突破性进展。与 RLHF 不同,DPO 将对齐问题重新定义为监督学习问题,直接利用偏好数据优化 LLM 策略,而无需显式的奖励建模。通过利用奖励函数与最优策略之间的闭式映射,DPO 消除了迭代 RL 训练的需求,从而减少了计算开销并提高了稳定性。由于其固有的优势,DPO 迅速吸引了研究界的广泛关注。现有研究在数据策略(例如点对点反馈与成对反馈)[67, 211]、学习框架(例如离线学习与在线学习)[121, 122, 126]、约束机制(例如不同的散度约束)[169, 171] 和模型特性(例如长度偏差)[191, 195] 等方面存在显著差异。DPO 变体的最新进展在增强模型与人类偏好的对齐方面展现了显著的效果,在多个领域取得了前所未有的成功 [32]。这些发展使基于 DPO 的方法成为传统 RLHF 范式在偏好对齐任务中的有力替代方案。然而,尽管前景广阔,DPO 研究领域仍然较为分散。 近年来,已有几篇与 DPO 相关的综述发表,但它们在范围和分析上存在显著局限性。(1)范围局限。虽然早期综述 [212] 对基于偏好的 RL 方法进行了全面概述,但其发表于 DPO 出现之前,并未涉及其在现代 LLMs 中的应用。最近关于对齐的综述 [24, 26, 213, 214] 提供了 LLM 对齐技术的广泛概述,但仅对 DPO 相关方法进行了简要总结,缺乏深入分析。同样,关于从人类反馈中学习的综述 [30, 215, 216, 217] 也仅简要提及 DPO 作为一种潜在替代方案。(2)分类缺陷。Gao 等人 [29] 和 Winata 等人 [32] 提出了偏好学习的简化分类法,但忽略了其广泛分类中的技术细节。相比之下,Wang 等人 [31] 尝试从强化学习、奖励建模、反馈和优化等维度对偏好学习进行分类。然而,这种分类法存在显著的概念重叠(例如强化学习本质上涉及优化)。Xiao 等人 [210] 最近的一项研究通过孤立的研究问题对 DPO 研究进行分类,虽然有助于问题识别,但割裂了方法之间的联系。本综述通过首次专门针对 DPO 的全面分析填补了这些空白。本综述的主要贡献总结如下: * 提出新的分类法:我们引入了一种新的分类法,将现有 DPO 研究分为四个关键维度:数据策略、学习框架、约束机制和模型特性(如图 1 所示)。该分类法为理解 DPO 的方法演进提供了系统框架,并突出了不同变体之间的关键区别。 * 严格的实证分析:我们对 DPO 变体在标准化基准上进行了严格的实证分析,揭示了其在多样化场景中的性能表现。该分析为 DPO 变体提供了全面评估,并为实践者提供了实用指导。 * 实际应用与未来方向:我们讨论了 DPO 的实际应用,并强调了其通过实现跨领域高效且可扩展的偏好学习来推动对齐研究民主化的潜力。我们还概述了 DPO 研究的开放挑战和未来方向,强调了对稳健且可推广的对齐范式的需求。

本综述的其余部分结构如下:第 2 节介绍了 DPO 的背景和公式化;第 3 节提出了 DPO 的分类法,基于关键维度对现有研究进行分类;第 4 节描述了评估 DPO 方法的标准化基准并展示了实证结果;第 5 节讨论了 DPO 的实际应用及其潜力;第 6 节概述了 DPO 研究的开放挑战和未来方向;最后,第 7 节总结了本综述。