大规模混合专家(MoE)模型的出现标志着人工智能领域的一项重大进展,通过条件计算提供了更强的模型容量和计算效率。然而,这些模型的部署和推理在计算资源、延迟和能效方面提出了显著的挑战。本综述系统地分析了当前混合专家模型推理优化技术的全貌,涵盖了整个系统堆栈。我们首先建立了一个分类框架,将优化方法分为模型级、系统级和硬件级优化。 在模型级别,我们考察了包括高效专家设计、注意力机制、修剪、量化、知识蒸馏等各种压缩技术,以及动态路由策略和专家合并方法等算法改进的架构创新。系统级别上,我们研究了分布式计算方法、负载平衡机制和高效调度算法,这些方法使得可扩展部署成为可能。此外,我们还深入探讨了硬件特定的优化和协同设计策略,以最大化吞吐量和能效。 本综述不仅提供了现有解决方案的结构化概述,还识别了混合专家推理优化中的关键挑战和有前景的研究方向。我们的全面分析为研究人员和从事大规模 MoE 模型资源受限环境部署的实践者提供了宝贵的资源。为了便于后续更新和分享 MoE 推理优化研究的最新进展,我们已建立了一个公开的资源库,网址为:https://github.com/MoE-Inf/awesome-moe-inference/

1 引言

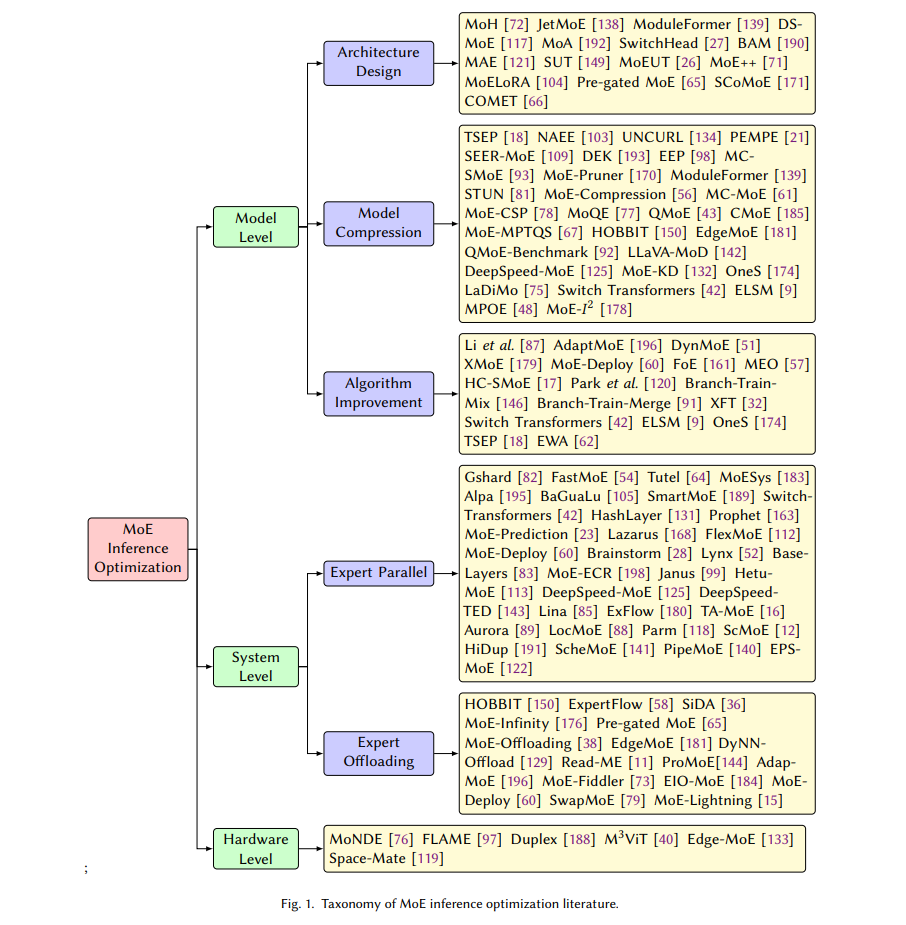

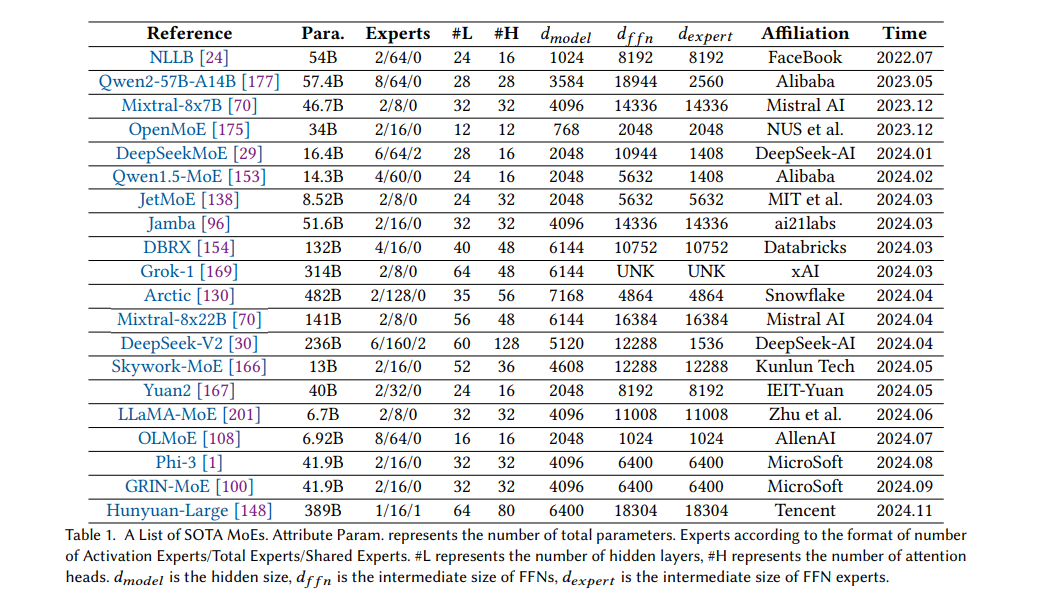

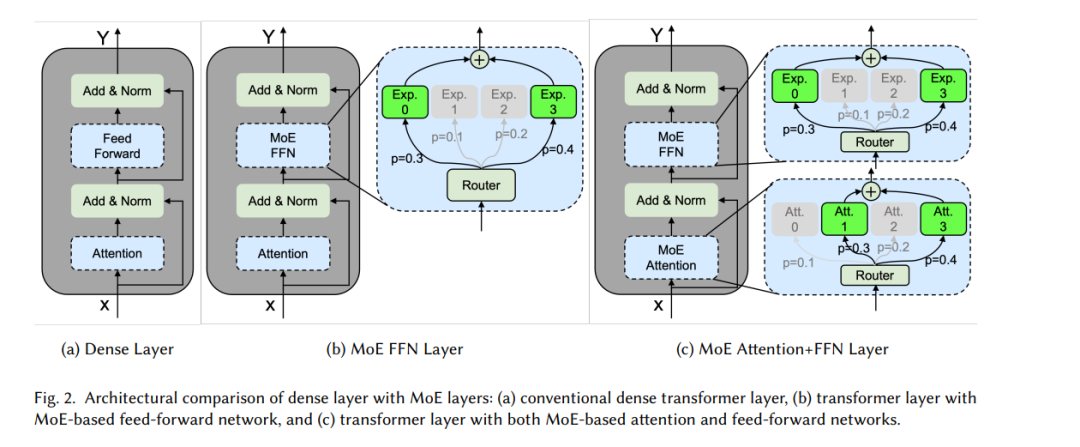

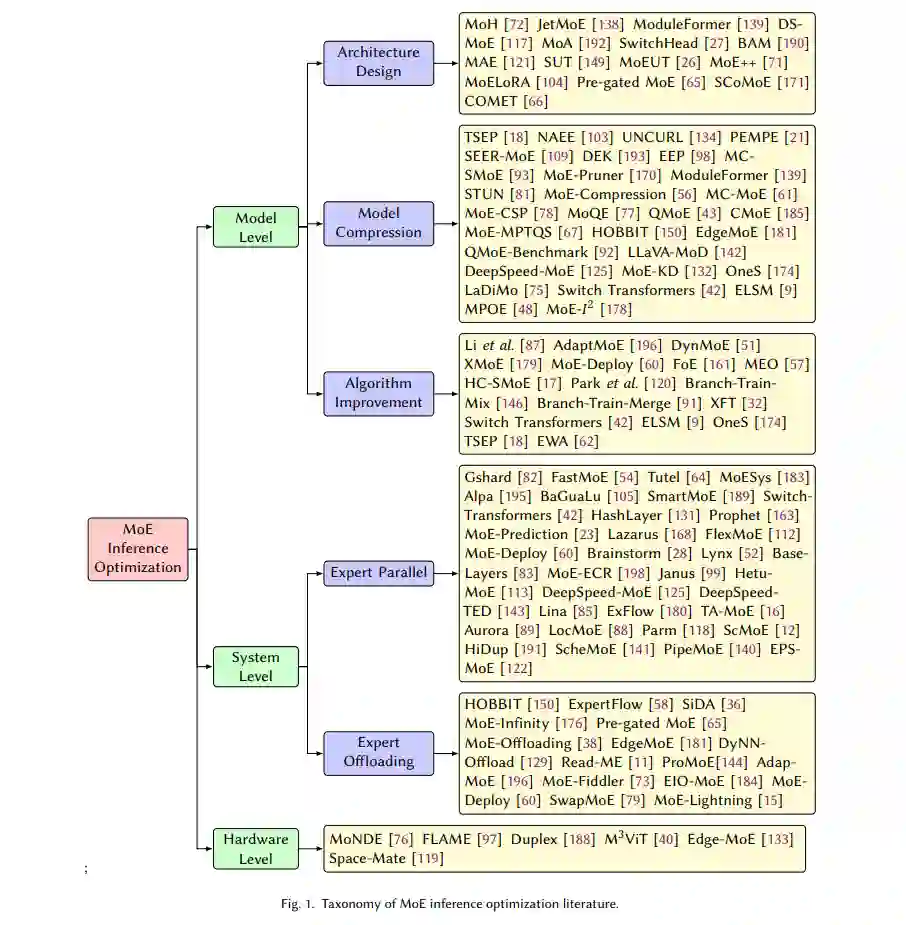

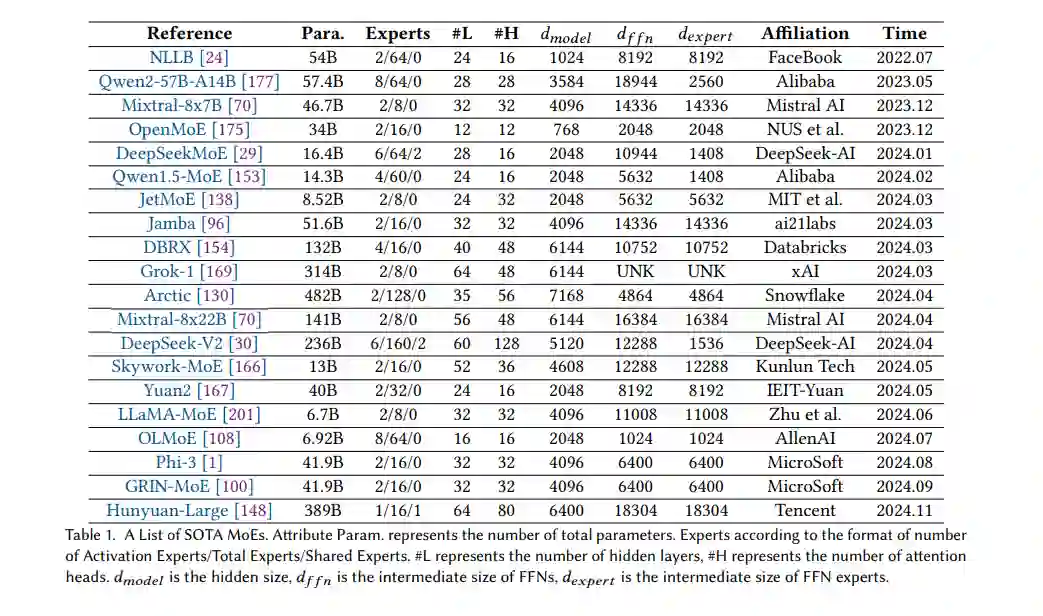

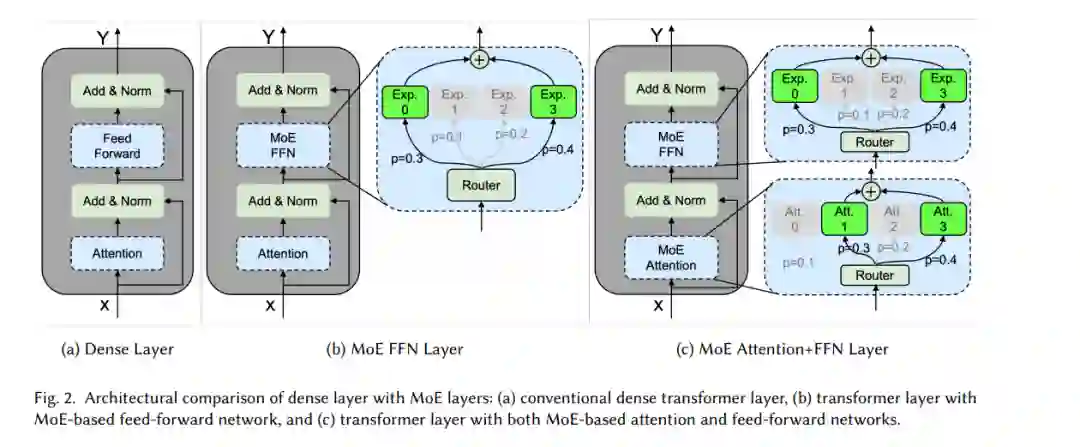

大规模语言模型(LLM)已经彻底改变了人工智能领域,展示了在多个领域,包括自然语言处理[20, 115, 157]、计算机视觉[31, 33, 194]以及多模态任务[86, 123, 162]中的前所未有的能力。像GPT-4[2]、Claude[8]和Gemini[151]这样的模型,在从自然语言理解到复杂推理和代码生成等任务上,取得了显著的成绩。这些模型的出色能力主要归功于其庞大的规模,包括模型参数的数量和训练过程中投入的计算资源。实践中,越来越多的实证研究表明,随着模型规模的增大,性能不断提高,这一现象在语言建模和其他领域的多种扩展规律中得到了体现[5, 19, 74]。然而,这一发展趋势在推理阶段(尤其是实际部署中)面临着巨大的计算效率和资源利用挑战[10, 173, 187, 199]。 混合专家(MoE)模型作为一种有前景的架构解决方案,已经出现并在一定程度上解决了机器学习中的扩展性问题[137]。最早由Jacobs等人[68]于1990年代初提出,作为一种在神经网络中学习子任务的方法,许多基于MoE的模型[37, 53, 155]也在多年的发展中相继问世。在大规模语言模型的时代,MoE再次迎来了复兴[1, 29, 70, 148]。MoE的核心原则是通过一个学习的门控机制将模型的容量分配到多个专门化的子网络或专家上,每次仅激活与当前输入相关的专家。这种方法允许模型保持较大的参数规模,同时通过稀疏激活保持计算开销的可控性。近期的实现,如Mixtral 8x7B[70]、Switch Transformers[42]和GShard[82]等,已经证明了这一策略在将语言模型扩展到万亿级参数的同时,仍能保持合理的计算需求。 MoE在扩展模型方面的成功,使其被广泛应用于各种前沿系统中。例如,谷歌的GLaM[35]在推理时使用显著更少的计算资源就超过了GPT-3的表现。类似地,最近的开源MoE模型Mixtral 8x7B[70],尽管模型规模远小于密集型模型,但仍表现出与更大模型相媲美的竞争性能,并保持了高效的推理特性。表1总结了近年来备受关注的前沿开源MoE模型,进一步突显了MoE架构的巨大潜力。这些成功的案例引发了学术界和工业界对MoE的广泛关注,促使了模型设计[22, 164, 192]、训练技术[34, 47, 101]以及部署策略[15, 16, 183]等方面的创新。 然而,MoE模型在推理中的高效部署仍然面临独特而严峻的挑战[65, 150, 181, 196]。专家激活模式的动态性引入了资源管理和调度的复杂性,这是传统密集型模型所没有的。这些挑战涵盖了多个层面:在模型级别,专家架构和路由机制的设计直接影响推理性能;在系统级别,分布式计算和负载平衡的管理变得日益复杂;而在硬件级别,需要专门的加速技术来处理稀疏计算模式。 为了解决MoE部署和推理中的这些挑战,已经提出了许多方法[72, 125, 133, 170]。尽管这一领域的研究快速增长并显示出其重要性,但也使得识别关键趋势和最佳实践变得困难。现有文献中的一个关键空白是缺乏一个系统化的框架,用于分析和开发综合性的MoE推理优化解决方案。 为了弥补这一空白,本文提供了一个关于MoE模型推理优化技术的全面综述。我们提出了一个分类框架,将优化方法分为模型级、系统级和硬件级优化,如图1所示。这个框架提供了一个结构化的方法来理解和比较不同的优化技术。尽管已有关于大规模语言模型效率[10, 84, 90, 156, 159, 173, 187, 199]和MoE架构[13, 41, 158]的相关综述,但我们的工作是首个专门聚焦于MoE模型推理优化技术的综述。我们系统地分析了从模型架构到硬件加速的不同抽象层级的优化方法,为研究人员和实践者提供了一个宝贵的资源,帮助他们将MoE模型部署到不同的实际应用中。

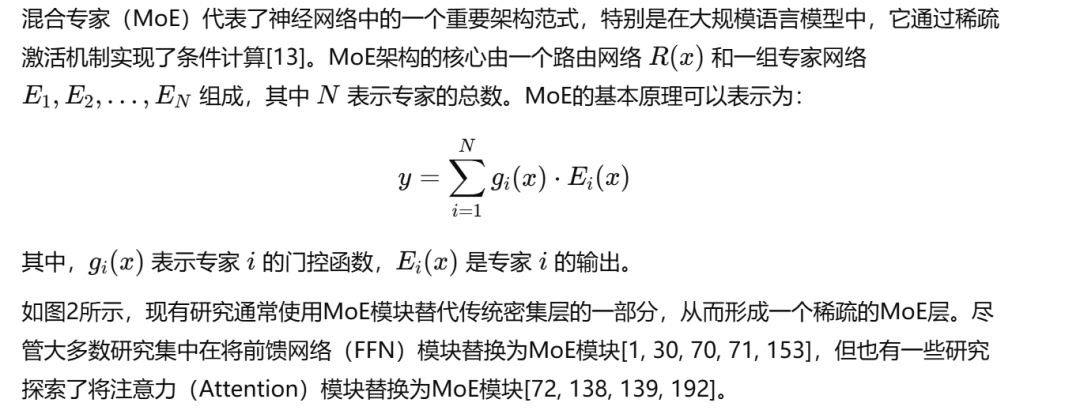

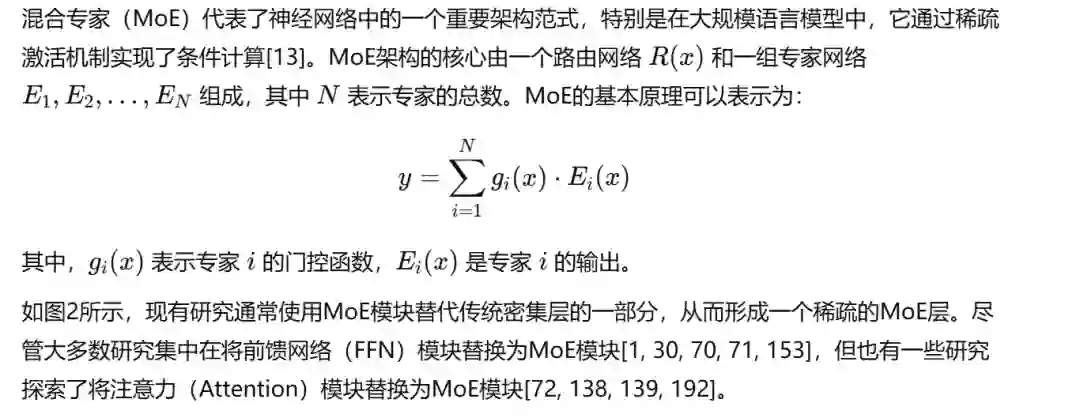

本综述的其余部分组织如下:第2节介绍了MoE模型及其推理特性;第3至第5节分别详细介绍了模型级、系统级和硬件级的优化技术;第6节讨论了未来的挑战和机遇;第7节对综述进行了总结。 混合专家(MoE)的基本原理

模型层级优化

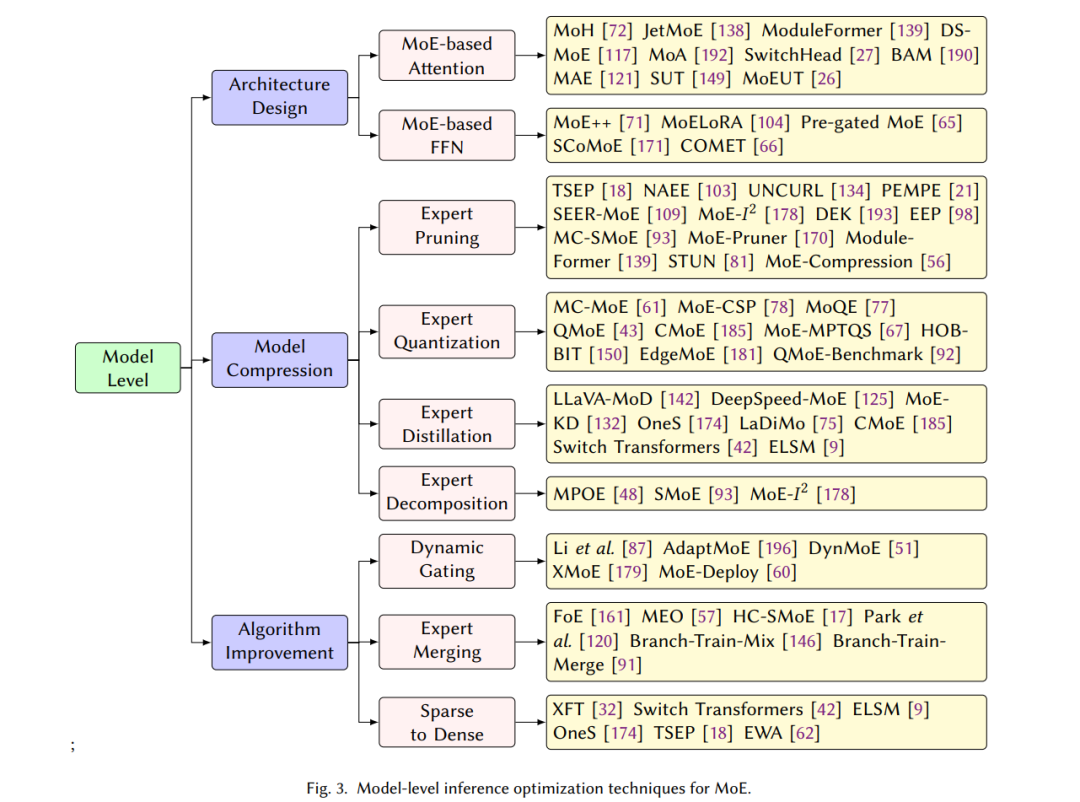

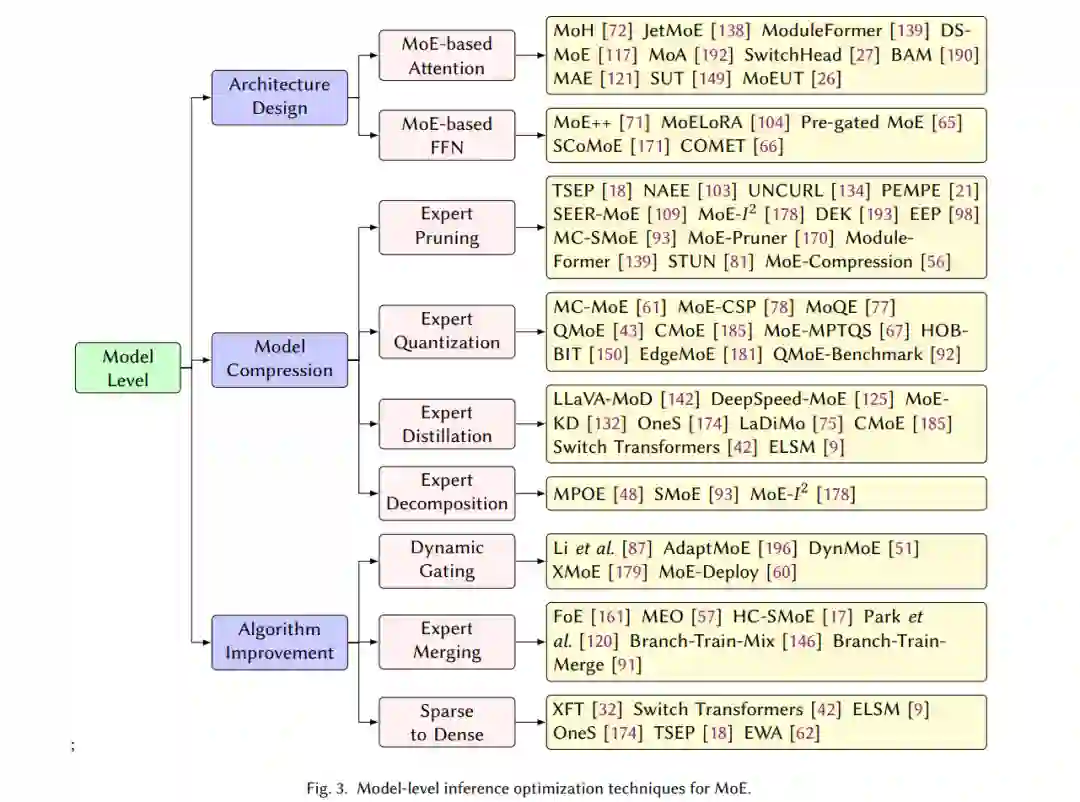

模型层级优化旨在通过架构、参数优化和算法设计的系统性改进,增强MoE模型的固有结构和效率。这些优化可以大致分为三个主要领域:高效的模型架构设计、模型压缩技术和算法改进。架构设计侧重于开发更高效的专家和注意力结构,压缩技术则通过剪枝、量化和知识蒸馏等方法,减少模型大小和内存占用。算法改进则集中在提升MoE模型的动态特性,包括路由机制和专家组合策略。图3展示了本节的详细结构。

系统层级优化

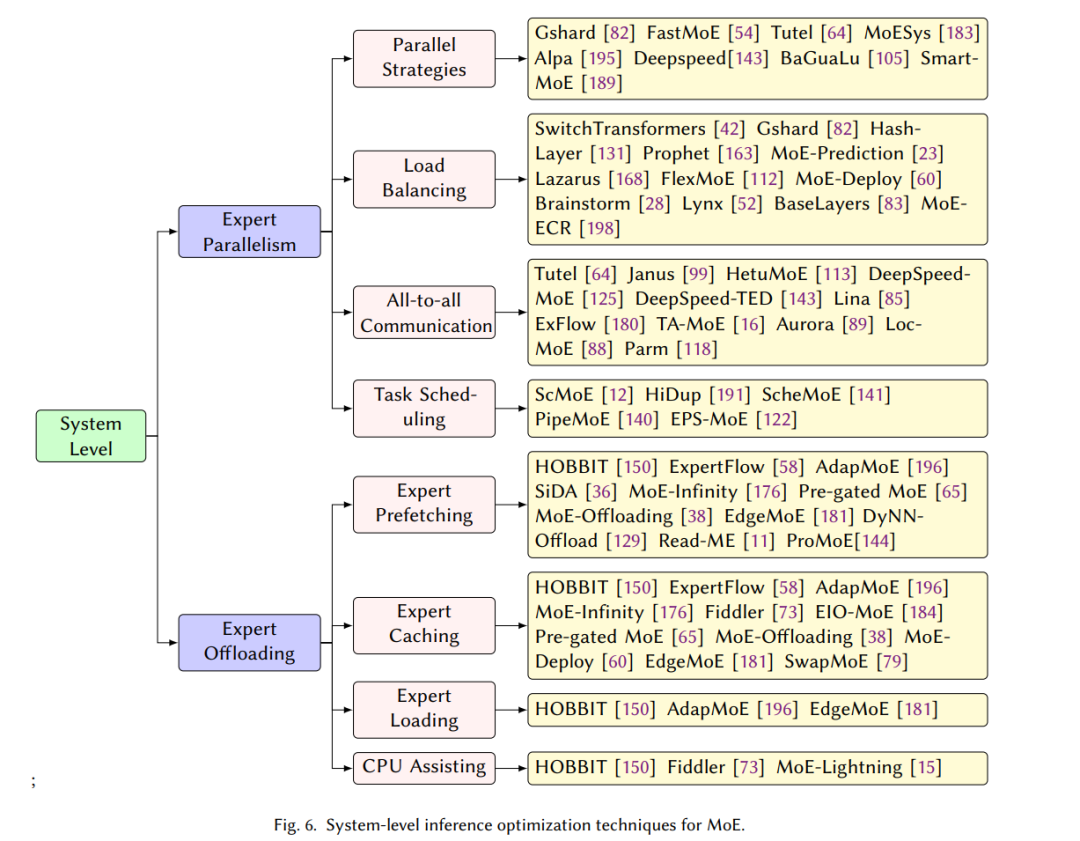

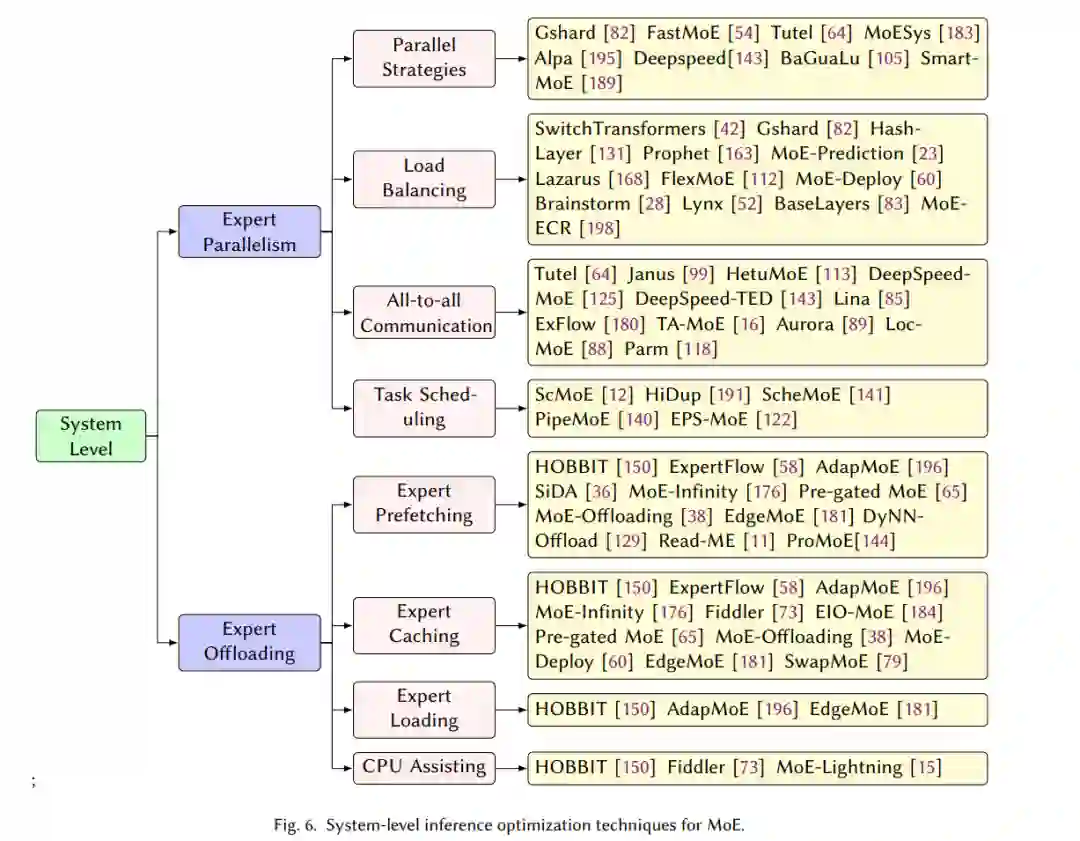

由于MoE架构的独特结构,许多研究集中在通过利用该架构固有的稀疏激活模式来加速推理过程,尤其是在系统层级。通常,MoE模型在两种场景下部署:云环境中的多个服务器和边缘环境中的单个设备。在云集群中,MoE模型分布在多个设备上,以实现并行执行。除了传统的并行化技术,如数据并行、张量并行和流水线并行[69, 110, 126],专家并行是专门为MoE模型量身定制的特殊方法。在边缘设备上,受限于GPU内存,往往无法容纳MoE模型的所有参数,因此需要将部分参数卸载到CPU内存或SSD存储中。为了解决这一问题,专家卸载技术被开发出来,以充分利用专家的稀疏激活模式,实现高效执行。图6展示了本节的详细结构。

硬件层级优化

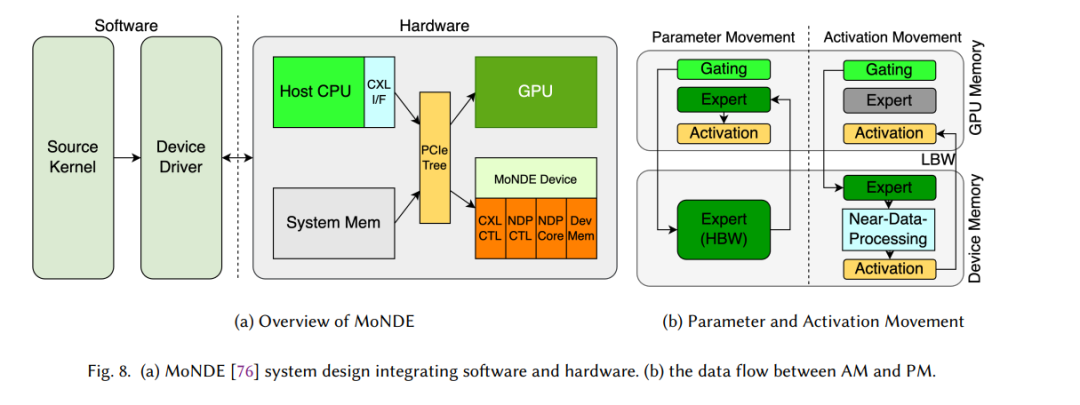

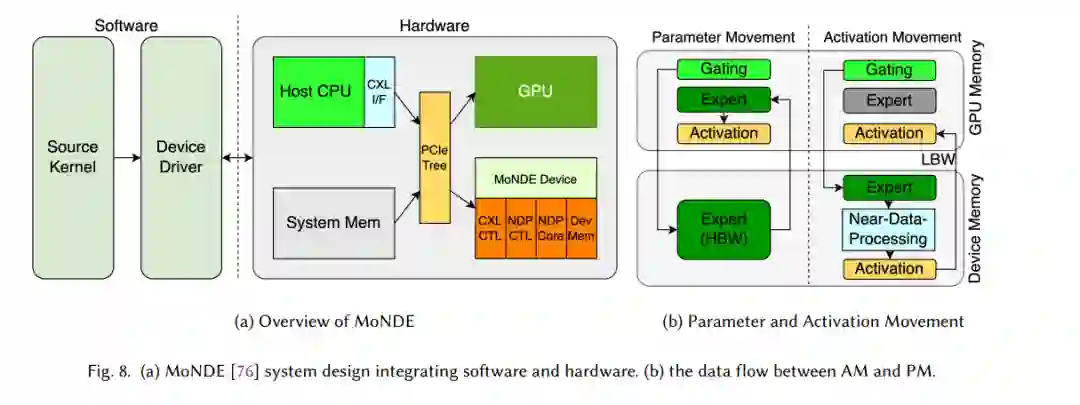

最近针对MoE推理的硬件优化通过新颖的架构和共设计方法解决了关键挑战。这些优化主要针对每字节操作数(Op/B)效率、异构计算单元和内存访问模式等关键问题。以下讨论了硬件层级解决方案中的一些重要进展。 MoNDE [76] 引入了一种近数据处理(NDP)解决方案,旨在解决稀疏激活和专家参数传输开销的问题(图8)。该架构将基于CXL(计算扩展链接)的NDP控制器与专用的NDP核心结合,用于内存中的计算,利用LPDDR SDRAM(低功耗双倍数据速率同步动态随机存储器)提供高带宽和能效。系统实现了一种混合计算策略,其中GPU处理频繁访问的“热”专家,而NDP单元处理“冷”专家,通过激活移动范式而非传统的参数移动来实现并行执行。 FLAME [97] 是第一个完全利用MoE稀疏性加速变换器在FPGA上的框架。在模型的参数级别,FLAME采用M:N剪枝来减少不必要的计算,这可以在列平衡结构剪枝和无结构剪枝之间取得平衡;在专家级别,通过CEPR(循环专家预测)进行稀疏激活预测。通过改变专家激活路径的模式,可以有效提高专家预测的准确性。然后,使用双缓冲机制在计算前一个专家的同时加载预测的专家,以提高专家部署效率。 M3ViT [40] 和 Edge-MoE [133] 基于多任务场景中的注意力计算重排序构建了它们的FPGA架构。对于推理,M3ViT 只激活与任务相关的稀疏“专家”路径,以提高效率,并通过硬件级共设计实现任务之间的零开销切换。Edge-MoE 是首个用于多任务ViT的端到端FPGA实现,提出了一些激进的技术,包括一种近似方法来解决FPGA上GELU函数计算的复杂性,以及一个统一的线性层模块,以实现硬件资源的高效重用。 Duplex [188] 为每个层级执行选择适合的目标设备,该设备结合了xPU和逻辑PIM(内存中处理)。这意味着它可以集成两种类型的处理单元,共享设备内存。由于这两种处理单元之间在计算和内存访问方面的瓶颈,能够在同一设备上同时实现高计算和内存访问利用率。此外,它还引入了一种替代PIM微架构。逻辑PIM通过逻辑芯片上的强大处理单元以及更多的硅通孔(TSVs)优化了低Op/B操作,从而实现了DRAM芯片和逻辑芯片之间的高带宽通信。此外,它可以并行执行专家和注意力阶段,以最大化推理效率。 Space-mate [119] 提供了其在移动设备上用于SLAM(同时定位与建图)任务的加速器设计。主要包括一个无序(OoO)SMoE路由器,用于缓解低延迟的数据传输,以及单跳(SS)和双跳(DS)异构核心架构,利用相同专家中相似零模式导致的粗粒度稀疏性,以实现高吞吐量和能效。