大型语言模型(LLMs)在推动通用人工智能(AGI)方面取得了显著进展,促使诸如GPT-4和LLaMA-405B等越来越大的模型相继问世。然而,模型规模的扩大导致计算成本和能源消耗呈指数级增长,使得这些模型对于资源有限的学术研究人员和企业而言变得不切实际。同时,小模型(SMs)在实际应用中经常使用,但其重要性目前被低估了。这引发了关于小模型在大型语言模型时代中作用的重要问题,而这一主题在以往研究中受到了较少的关注。在本工作中,我们从协作和竞争这两个关键角度系统地研究了LLMs和SMs之间的关系。我们希望本次调研能为从业者提供有价值的见解,帮助加深对小模型贡献的理解,并促进更高效的计算资源使用。代码可在以下网址获取:

https://github.com/tigerchen52/role_of_small_models

1 引言

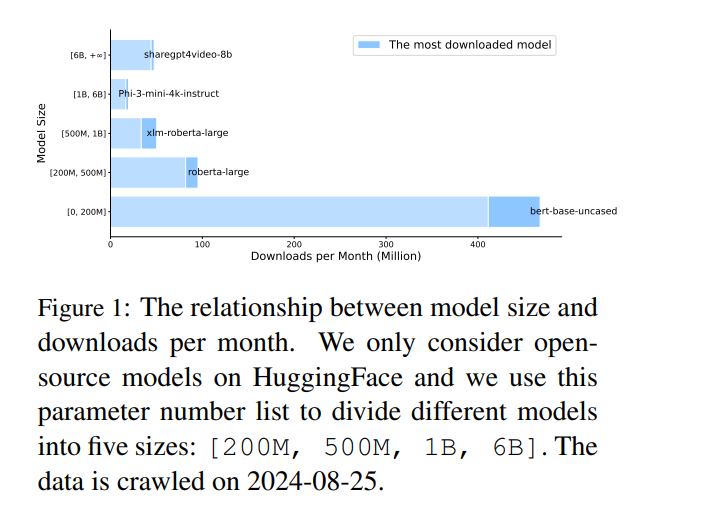

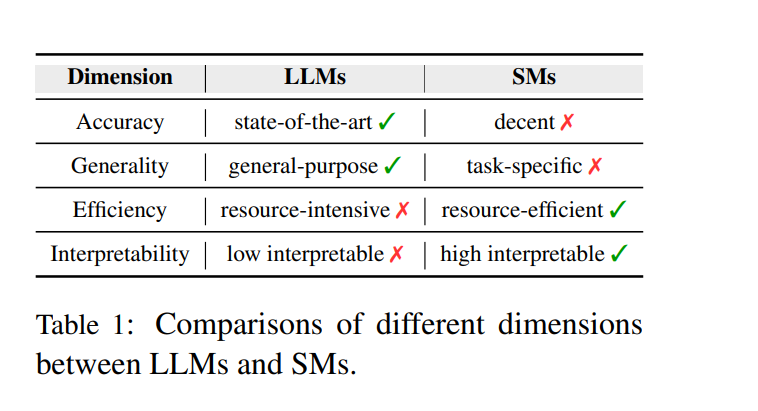

近年来,大型语言模型(LLMs)的快速发展彻底改变了自然语言处理(NLP)。预训练语言模型如ELMo(Peters等,2018)和BERT(Devlin等,2019)验证了“预训练-微调”范式,即通过预训练学习通用的语言表示,并通过微调将这些知识迁移到特定的NLP任务中以提升表现(Min等,2023a)。这一方法逐渐演变为基于提示的推理,如GPT家族模型所示(Radford等,2019;Brown等,2020),其中在模型执行任务之前,提示中提供了少量示例(Liu等,2023a)。 这些范式在一系列任务中展示了卓越的性能,包括语言生成(Dong等,2023)、语言理解(Wang等,2019)以及在编码(Jiang等,2024b)、医学(He等,2023)和法律(Sun,2023)等领域的特定应用。此外,关于“涌现能力”的理论表明,随着模型规模的扩大,某些推理能力得到了增强,某些能力仅在较大的模型中出现(Wei等,2022a)。这促使了越来越大的模型开发,例如GPT-4(Achiam等,2023)、Mixtral 8x22B(Jiang等,2024a)、PaLM-340B(Anil等,2023)和LLaMA-405B(Dubey等,2024)。因此,大型语言模型变得非常流行,数据显示,至2024年3月,ChatGPT(OpenAI,2024)已达到大约1.8亿用户。 尽管LLMs在通用人工智能(AGI)方面取得了重大进展,其能力伴随着巨大的开销。模型规模的扩大导致计算成本和能源消耗呈指数级增加(Wan等,2023)。此外,训练和部署LLMs对于资源有限的学术研究人员和企业而言通常是不可行的。因此,开始出现转向小型语言模型(SLMs)的趋势,如Phi-3.8B(Abdin等,2024)和Gemma-2B(Team等,2024),这些模型在参数显著减少的情况下能够实现相当的性能。 有人可能会认为,像Phi-3.8B和Gemma-2B这样的模型并不是真正的小模型,而像BERT这样真正的小模型已经不再占据主导地位。然而,我们的研究发现,在实际应用中,小模型的使用被显著低估。如图1所示,我们分析了HuggingFace上不同规模的开源模型下载数量,结果显示,特别是BERT-base这样的较小模型仍然非常受欢迎。这引发了关于小模型在LLMs时代作用的重要问题,而这一主题在以往研究中很少被关注。 作为LLMs的对照,小模型(SMs)通常指具有相对较少参数的模型,涵盖了不仅仅是语言模型,还有简单的统计模型和浅层神经网络。然而,尚无明确的定义来区分大模型和小模型。在本研究中,我们采用相对的模型规模概念。例如,BERT(1.1亿参数)(Devlin等,2019)相对于LLaMA-8B(Dubey等,2024)被认为是小模型,而LLaMA-8B相对于GPT-4(1750亿参数)(Achiam等,2023)又被认为是小模型。此相对定义提供了灵活性,并确保随着更大模型的发展,相关概念仍然有效。 为了评估小模型的作用,必须相对于LLMs比较它们的优劣。表1列出了四个关键维度:

- 准确性。由于拥有大量参数并在多样化的数据集上进行了广泛训练,LLMs在各种NLP任务中表现出色(Raffel等,2020;Kaplan等,2020)。尽管SMs总体上在性能上落后,但通过知识蒸馏等技术(Xu等,2024a)可以实现相当的结果。

- 通用性。LLMs具有高度的通用性,能够处理广泛的任务并且只需极少的训练示例(Dong等,2023;Liu等,2023a)。相比之下,SMs往往更加专注于特定任务,研究表明,通过在领域特定数据集上微调SMs,有时可以在特定任务中超越通用LLMs(Hernandez等,2023;Juan José Bucher和Martini,2024;Zhang等,2023a)。

- 效率。LLMs在训练和推理中需要大量计算资源(Wan等,2023),导致高昂的成本和延迟,使得它们在实时应用(如信息检索(Reimers和Gurevych,2019))或资源受限的环境(如边缘设备(Dhar等,2024))中不太实用。相比之下,SMs需要较少的训练数据和计算能力,在大大减少资源需求的同时提供了有竞争力的性能。

- 可解释性。与更大、更深的模型相比,较小、较浅的模型往往更透明、易解释(Gilpin等,2018;Barceló等,2020)。在医疗保健(Caruana等,2015)、金融(Kurshan等,2021)和法律(Eliot,2021)等领域,由于决策需要非专家(如医生、财务分析师)能够轻松理解,小模型通常更受青睐。

在本研究中,我们从两个关键角度系统地研究了小模型在LLMs时代的作用:(1) 协作(§ 2)。LLMs提供了更高的准确性并且能够处理广泛的任务,而SMs更加专业且成本效益更高。在实际应用中,LLMs和SMs的协作可以在性能和效率之间找到平衡,使得系统在保持高性能和灵活性的同时,实现资源高效、可扩展、可解释且成本效益高的解决方案。(2) 竞争(§ 3)。SMs具有独特的优势,如简单性、成本低和更强的可解释性,并且在某些领域具有市场。根据任务或应用的具体需求,审慎评估LLMs和SMs之间的权衡至关重要。

****

2 协作

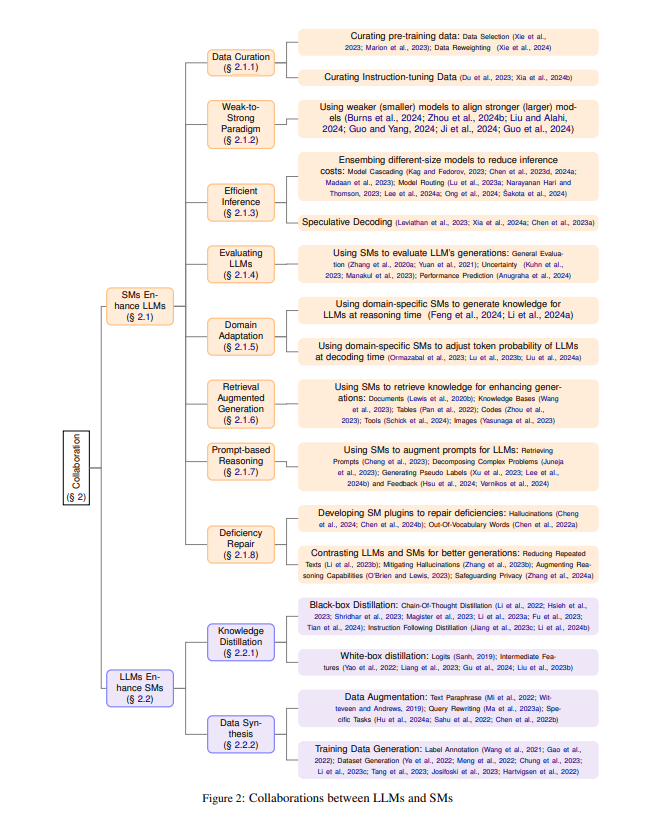

在接下来的部分中,我们展示了小模型(SMs)和大型语言模型(LLMs)如何协作以优化资源使用:小模型增强LLMs(§ 2.1)以及LLMs增强小模型(§ 2.2)。整体协作框架如图2所示。

**2.1 小模型增强LLMs

2.1.1 数据策划 在本节中,我们从两个方面展示如何利用小模型来策划数据:预训练数据和指令调优数据。 预训练数据策划

LLMs的推理能力很大程度上归因于它们在广泛和多样化数据集上的预训练,这些数据通常来源于网络抓取、书籍和科学文献。由于扩展这些训练数据集的数量和多样性可以增强LLMs的泛化能力,已有大量努力致力于编制大规模和多样化的预训练语料库,如C4(Raffel等,2020)和Pile(Gao等,2021)。此外,扩展法则(Kaplan等,2020)表明,模型性能在很大程度上依赖于模型参数的规模和训练数据集的大小。这可能意味着,为了开发更强大的模型,应该尽可能多地使用数据进行预训练。 然而,这种方法面临一个重大挑战:数据的可用性是有限的,公众可获取的人类文本数据可能很快就会被耗尽(Villalobos等,2024)。此外,并非所有数据对模型性能都有同样的贡献;网络抓取的内容通常包含噪音和低质量的文本。这导致了从单纯关注数据数量转向优先考虑数据质量的范式转变。最近的研究支持“少即是多”的理念(Marion等,2023),提倡通过数据选择或修剪技术从大数据集中策划高质量的子集,从而提升模型性能(Albalak等,2024)。 现有的数据策划方法通常依赖于基于规则的启发式方法,如黑名单过滤和MinHash去重(Raffel等,2020;Tirumala等,2024;Penedo等,2023;Wenzek等,2020)。然而,考虑到原始文本数据的规模和复杂性,这些手动的基于规则的方法变得越来越不适用。一个常见的替代方法是使用专门训练的小模型来评估文本质量,从而选择高质量的子集。例如,可以训练一个简单的分类器来评估内容质量,重点是去除噪音、攻击性和隐私数据(Brown等,2020;Du等,2022;Chowdhery等,2023;Xie等,2023)。另一种技术是使用代理语言模型计算的困惑度分数来选择更可能是高质量的数据(Wenzek等,2020;Marion等,2023)。 除了数据选择之外,数据重新加权是一种为特定领域分配权重的策略,通过调整不同文本来源的采样概率来增强预训练模型在各领域的泛化能力(Xie等,2024)。 指令调优数据策划

LLMs通过预训练获得了大量知识,指令调优旨在使这些模型能力与人类偏好对齐(Ouyang等,2022;Bai等,2022a)。虽然早期研究集中于使用大规模指令数据集对LLMs进行调优,最近的研究表明,通过较小的数据集也可以实现良好的对齐。特别是,研究《Less is More for Alignment》表明,微调仅1,000个精心策划的指令示例就可以生成一个高度对齐的模型(Zhou等,2024a)。这强调了选择高质量数据以有效进行指令调优的重要性(Longpre等,2023;Chen等,2023c)。 模型导向的数据选择(MoDS)(Du等,2023)是一种利用小型语言模型DeBERTa(He等,2021)根据质量、覆盖率和必要性评估指令数据的方法。此外,LESS框架(Xia等,2024b)展示了小模型不仅可以用于为大模型选择有影响力的数据,还可以为不同家族的模型选择数据。这凸显了使用有针对性的数据选择技术来优化指令调优过程的潜力。 总结与未来方向 鉴于人类可以创建的数据量即将达到极限,专注于策划现有数据并拥抱“少即是多”的原则至关重要。在本节中,我们探讨了小模型在预训练和微调过程中如何在数据选择和重新加权中发挥重要作用。

未来方向

(1) 尽管数据策划具有显著优势,LLMs仍然有生成幻觉内容和有害内容的倾向。此外,删除低质量或有害文本可能会削弱模型的某些能力,如通用性(Longpre等,2024)。因此,定义更细致的评估数据质量的标准至关重要,包括事实性、安全性和多样性等维度(Wettig等,2024;Liu等,2024b)。探索使用小模型来开发有效且高效的数据选择方法是一个有价值的研究方向。 (2) 合成数据是对有限的人类生成数据的有力补充(Long等,2024),但小模型在策划合成数据方面的潜力尚未被充分探索。

**2.1.2 弱到强范式

LLMs通常通过基于人类反馈的强化学习(RLHF)与人类价值观对齐,其中符合人类偏好的行为会被奖励,而不受欢迎的行为则会受到惩罚(Shen等,2023)。然而,随着LLMs不断发展并在各项任务中超越人类能力,它们逐渐成为“超人模型”,能够执行复杂且富有创造性的任务,甚至可能超出人类的理解范围。例如,这些模型可以生成成千上万行的专业代码、进行复杂的数学推理,以及创作长篇且富有创造性的小说。对于人类评估者而言,评估此类输出的正确性和安全性变得极具挑战性。这种情况引入了一个新的对齐范式,称为弱到强泛化(weak-to-strong generalization),该范式利用较弱(较小)模型作为较强(较大)模型的监督者(Burns等,2024)。在这种方法中,强大的大模型通过较弱的、能力较低的模型生成的标签进行微调,从而使强模型能够超越弱监督者的局限性进行泛化。 基于弱到强泛化的概念,最近提出了几种变体。例如,Liu和Alahi(2024)建议使用一组多样化的专门弱教师,而不是依赖单一的通用模型,共同监督强学生模型。Guo和Yang(2024)提出了一种通过整合多个弱模型提供的答案的可靠性估计来增强弱到强泛化的方法。该方法通过过滤不确定的数据或调整可靠数据的权重来改进对齐过程。除了数据标注之外,弱模型还可以在推理阶段与大模型协作,以进一步增强对齐。Aligner(Ji等,2024)采用小模型来学习偏好和不偏好的响应之间的校正残差,从而直接应用于各种上游的LLMs,以便与人类偏好对齐。Weak-to-Strong Search(Zhou等,2024b)将大模型的对齐视为测试时的贪婪搜索,旨在最大化经过微调和未微调小模型之间的对数似然差异,分别作为密集的奖励信号和批评者。弱到强范式不仅限于语言模型,还扩展到了视觉基础模型(Guo等,2024)。 总结与未来方向

随着大模型的迅速发展,我们正逐步迈向“超人模型”出现的未来,这使得人类有效监督变得越来越困难。弱到强范式表明,弱监督者可以从强模型中提取知识,从而开发出确保安全可靠对齐的超人奖励模型。 未来方向

(1) 尽管弱到强框架在从强模型中引出知识方面表现出色,但在缩小弱模型和强模型之间的性能差距方面仍存在很大不足。关键是要确保强模型对任务有深入的、直观的理解,能够纠正弱模型的错误,并自然地与任务目标保持一致(Burns等,2024)。未来的工作应专注于识别有助于实现这一目标的属性和方法。 (2) 当前对弱到强泛化的理解仍然有限。研究人员应深入研究对齐方法成功或失败的潜在机制,例如理论分析(Lang等,2024)、弱监督中的错误(Guo和Yang,2024),以及利用扩展法则推断泛化误差(Kaplan等,2020)。

**2.1.3 高效推理

模型集成

较大的模型通常更强大,但同时也带来了显著的成本,包括较慢的推理速度和更昂贵的价格(如API费用)。除了财务成本外,使用较大的模型也会带来巨大的环境和能源影响(Wu等,2022)。相比之下,尽管小模型的性能可能较差,但它们在成本较低和推理速度更快方面具有优势。鉴于用户查询的复杂性差异很大——从小模型可以处理的简单问题到需要更大模型解决的复杂问题——可以通过利用不同规模的模型集成来实现成本效益优化的推理。模型集成方法可分为两类:模型级联和模型路由。 模型级联

模型级联涉及依次使用多个模型来进行预测或决策,每个模型在级联中具有不同的复杂度。一个模型的输出可能会触发下一个模型的激活(Varshney和Baral,2022;Viola和Jones,2004;Wang等,2011)。这种方法允许不同规模的模型协作,使得小模型可以处理较简单的输入查询,而将更复杂的任务转移给大模型。该过程中关键的一步是确定给定模型是否有能力解决输入问题。这种方法有效地优化了推理速度并降低了财务成本。 一些现有技术训练小型评估器来评估模型输出的正确性(Kag和Fedorov,2023;Chen等,2020,2023d)、置信度(Chen等,2024a)或质量(Ding等,2024b),从而决定是否将查询上升到更复杂的模型。鉴于LLMs可以进行自我验证(Dhuliawala等,2023)并提供其响应的置信度水平(Tian等,2023),AutoMix(Madaan等,2023)使用验证提示多次查询模型,利用这些响应的一致性作为置信度分数的估算值。该框架然后决定是否接受当前模型的输出,或者是否将查询转发给其他模型以提高性能。 模型路由

模型路由通过动态将输入数据定向到最合适的模型来优化不同规模模型的部署,从而在实际应用中提高效率和效果。这一方法的核心组件是开发一个路由器,将输入分配给池中一个或多个合适的模型。 一种简单的方法是考虑所有模型的输入输出对,并选择表现最好的一个(Jiang等,2023a)。然而,这种全面的集成策略并未显著减少推理成本。为了解决这一问题,一些方法训练高效的、基于奖励的路由器,在不需要访问模型输出的情况下选择最佳模型(Lu等,2023a;Narayanan Hari和Thomson,2023)。OrchestraLLM(Lee等,2024a)引入了基于检索的动态路由器,该路由器假设具有相似语义嵌入的实例具有相同的难度级别。根据测试实例与专家池中实例的嵌入距离来选择合适的专家。类似地,RouteLLM(Ong等,2024)利用人类偏好数据和数据增强训练一个小型路由模型,有效降低推理成本并增强跨领域泛化能力。FORC(Šakota等,2024)提出了一种元模型(回归模型),无需执行任何大模型,即可将查询分配给最合适的模型。该元模型通过查询和模型性能分数的现有配对进行训练。此外,最近已经建立了用于模型路由的基准(Hu等,2024b;Shnitzer等,2023),这为大型语言模型的更具成本效益的部署提供了便利。 推测解码

这种技术旨在加速生成模型的解码过程,通常涉及使用一个较小且更快的辅助模型与主要较大的模型并行运行。辅助模型快速生成多个候选标记,然后由更大、更准确的模型进行验证或精细调整。这种方法允许更快地进行初步预测,随后由计算要求更高的模型验证(Leviathan等,2023;Xia等,2024a;Chen等,2023a)。 总结与未来方向

大型模型或API的推理成本可能相当可观,但异构模型的协作可以有效降低这些经济成本并加速推理过程。本节中,我们介绍了模型集成和推测解码作为优化推理过程的策略。 未来方向

(1) 现有的集成方法通常依赖于有限的、预定义的模型列表,而现实世界包括开放领域和不断发展的LLMs,如HuggingFace上提供的模型库。探索如何利用这些广泛的模型库来创建智能且高效的系统具有巨大的潜力(Shen等,2024)。 (2) 在当前的推测解码方法中,辅助模型通常限制在与主模型同一模型家族内,如不同尺寸的GPT。然而,探索来自不同来源的模型之间的协作将是有利的。

**2.1.6 检索增强生成(RAG)

大型语言模型(LLMs)展现了强大的推理能力,但其记忆特定知识的能力有限。因此,LLMs在处理需要领域特定专业知识或最新信息的任务时可能表现欠佳。为了应对这些局限性,检索增强生成(RAG)通过使用轻量级的检索器从外部知识库、文档集合或其他工具中提取相关文档片段来增强LLMs(Gao等,2023;Lewis等,2020b)。通过整合外部知识,RAG有效减少了生成事实不准确内容(常被称为幻觉)的问题(Shuster等,2021)。根据检索来源的性质,RAG方法可大致分为三类。 文本文档

文本文档是RAG方法中最常用的检索来源,包括Wikipedia(Trivedi等,2023;Asai等,2023)、跨语言文本(Nie等,2023)和领域特定语料库(如医学(Xiong等,2024)和法律(Yue等,2023)领域)。这些方法通常使用轻量级检索模型,如稀疏的BM25(Robertson等,2009)和基于BERT的密集检索器(Izacard等,2021),从这些来源中提取相关文本。 结构化知识

结构化知识包括知识库和数据库等来源,这些通常经过验证并能提供更精确的信息。例如,KnowledgeGPT(Wang等,2023)使LLMs能够从知识库中检索信息,而T-RAG(Pan等,2022)通过将检索到的表格与查询拼接在一起来增强答案。StructGPT(Jiang等,2023b)进一步通过从混合来源(包括知识库、表格和数据库)中检索信息来增强生成。这些方法中的检索器可以是轻量级的实体链接器、查询执行器或API。 其他来源

其他来源包括代码、工具,甚至图像,能够帮助LLMs利用外部信息增强推理能力。例如,DocPrompting(Zhou等,2023)在代码生成之前使用BM25检索器获取相关的代码文档。类似地,Toolformer(Schick等,2024)表明,语言模型可以通过简单的API自学使用外部工具,如翻译器、计算器和日历,从而显著提高性能。 总结与未来方向

检索增强生成显著扩展了LLMs的知识边界,其中小模型主要作为检索器在此过程中发挥作用。通过使用轻量级检索器,各种类型的信息——如文档、结构化知识、代码和实用工具——都可以被高效访问,以增强模型的能力。 未来方向

(1) 检索增强文本生成的性能对检索质量非常敏感(Yoran等,2023)。因此,开发稳健的方法来整合噪音检索文本是非常重要的。 (2) RAG可以扩展到超越文本信息的多模态场景,如图像(Yasunaga等,2023)、音频(Zhao等,2023)等。

**2.1.7 基于提示的学习

基于提示的学习是LLMs中的一种流行范式,提示的设计旨在促进少样本甚至零样本学习,使模型能够在没有或几乎没有标注数据的情况下适应新场景(Liu等,2023a)。这种方法利用了上下文学习(ICL)的强大功能(Dong等,2023),无需执行参数更新,而是依赖于包含一些示例的提示上下文,这些示例结构在自然语言模板中。 在此学习过程中,小模型可以用于增强提示,从而提高大模型的性能。例如,Uprise(Cheng等,2023)优化了一个轻量级检索器,用于自动检索零样本任务的提示,从而最大限度地减少提示工程所需的手动工作。类似地,DaSLaM(Juneja等,2023)使用小模型将复杂问题分解为需要更少推理步骤的子问题,从而在多个推理数据集上提升大模型的性能。其他方法包括微调小模型以生成输入的伪标签(Xu等,2023;Lee等,2024b),其结果比原始ICL的表现更好。此外,小模型还可以用于验证(Hsu等,2024)或重写(Vernikos等,2024)LLMs的输出,从而在无需微调的情况下实现性能提升。 总结与未来方向

基于提示的学习能够通过使用嵌入在提示模板中的少量示例来处理各种复杂任务。为了进一步增强这一过程,可以使用小模型通过重构问题和生成反馈来增强提示。这种高效的增强方式允许在不进行参数更新的情况下改善LLMs的性能。 未来方向

最近的研究集中于利用小模型在基于提示学习范式中增强大模型的推理能力。同样重要的是,探索如何使用小模型开发可信、安全和公平的LLMs。

**2.1.8 缺陷修复

强大的LLMs可能生成重复、不真实和有害的内容,小模型可以用来修复这些缺陷。我们介绍两种实现此目标的方法:对比解码和小模型插件。 对比解码

对比解码通过选择最大化大模型(专家)和小模型(新手)之间对数似然差异的标记来利用它们的对比性。现有的研究探索了LLMs和SMs的logits协同使用,以减少重复文本(Li等,2023b)、缓解幻觉(Sennrich等,2024)、增强推理能力(O’Brien和Lewis,2023),以及保护用户隐私(Zhang等,2024a)。由于微调LLMs计算密集,代理调优提出了微调小模型并对比原始LLMs和小模型之间的差异,以适应目标任务(Liu等,2024a)。 小模型插件

小模型插件通过微调一个专门的小模型来解决大模型的一些不足。例如,LLMs在遇到未见过的词汇(词汇外,OOV)时性能可能下降。为了解决这一问题,我们可以训练一个小模型来模仿大模型的行为,并填充未见词汇的表示(Pinter等,2017;Chen等,2022a)。通过这种方式,我们可以以较低成本使大模型更加稳健。此外,LLMs可能生成幻觉文本,我们可以训练一个小模型来检测幻觉(Cheng等,2024)或校准置信度分数(Chen等,2024b)。 总结与未来方向

尽管语言模型非常强大,但它们有一些需要解决的弱点,如幻觉、毒性等。在这里,我们提出了对比解码和开发小模型插件,以使LLMs更加稳健和安全。 未来方向

我们可以将使用小模型修复大模型缺陷的模式扩展到其他问题上。例如,LLMs的数学推理非常脆弱,甚至在面对基本的数学问题时可能崩溃,例如ChatGPT错误地认为9.11大于9.9。