利用更多的测试时计算增强大语言模型推理能力

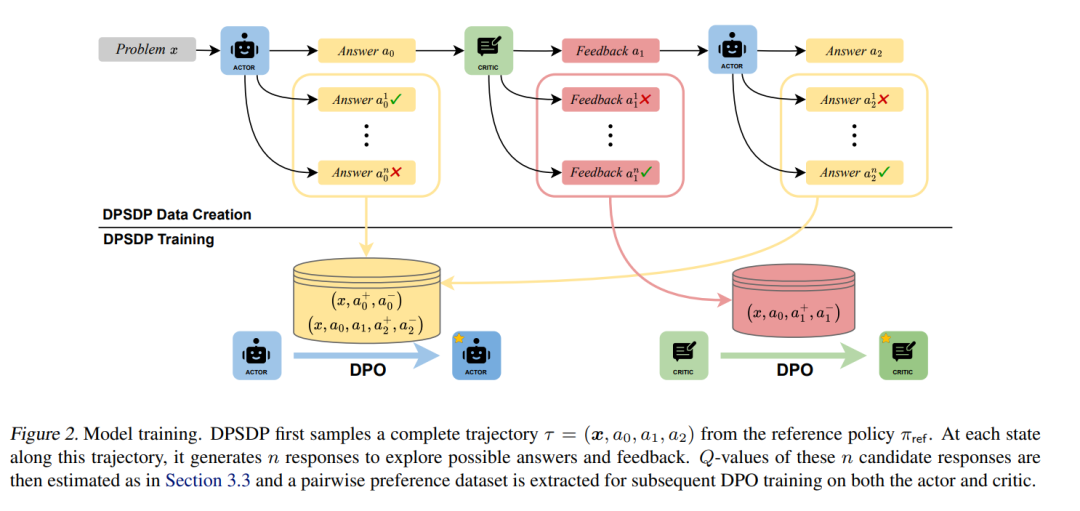

已证明,利用更多的测试时计算是一种有效的方法,可以提升大语言模型(LLMs)的推理能力。在多种方法中,验证与改进(verify-and-improve)范式尤为突出,因为它使得模型能够进行动态的解决方案探索并整合反馈。然而,现有的方法通常面临反馈空间受限和缺乏不同方协调训练的问题,导致性能不尽如人意。为了应对这一挑战,我们将这一多回合的改进过程建模为一个马尔可夫决策过程(MDP),并引入了DPSDP(通过动态规划的直接策略搜索),一种强化学习算法,它训练一个演员-评论员(actor-critic)大语言模型系统,通过在自生成数据上进行直接偏好学习,迭代地改进答案。 从理论上讲,DPSDP能够在训练分布内匹配任何策略的性能。通过实证研究,我们使用不同的基础模型实例化DPSDP,并展示了在内外分布基准测试中的改进。例如,在MATH 500基准测试中,通过五轮改进步骤进行多数投票,使用基于Ministral的模型将首次准确率从58.2%提高到63.2%。一项消融研究进一步确认了多智能体协作和外部分布泛化的优势。

主要贡献

方法创新:提出了DPSDP算法,将多回合的推理过程建模为马尔可夫决策过程,并通过直接偏好学习进行答案改进。 1. 性能提升:在多个基准测试中,DPSDP方法显著提升了大语言模型的推理性能,尤其是在内外分布的任务上。 1. 多智能体协作:通过多智能体协作,进一步验证了该方法在面对复杂推理任务时的优势,尤其是在提高外部分布的泛化能力上。

成为VIP会员查看完整内容

相关内容

Arxiv

211+阅读 · 2023年4月7日