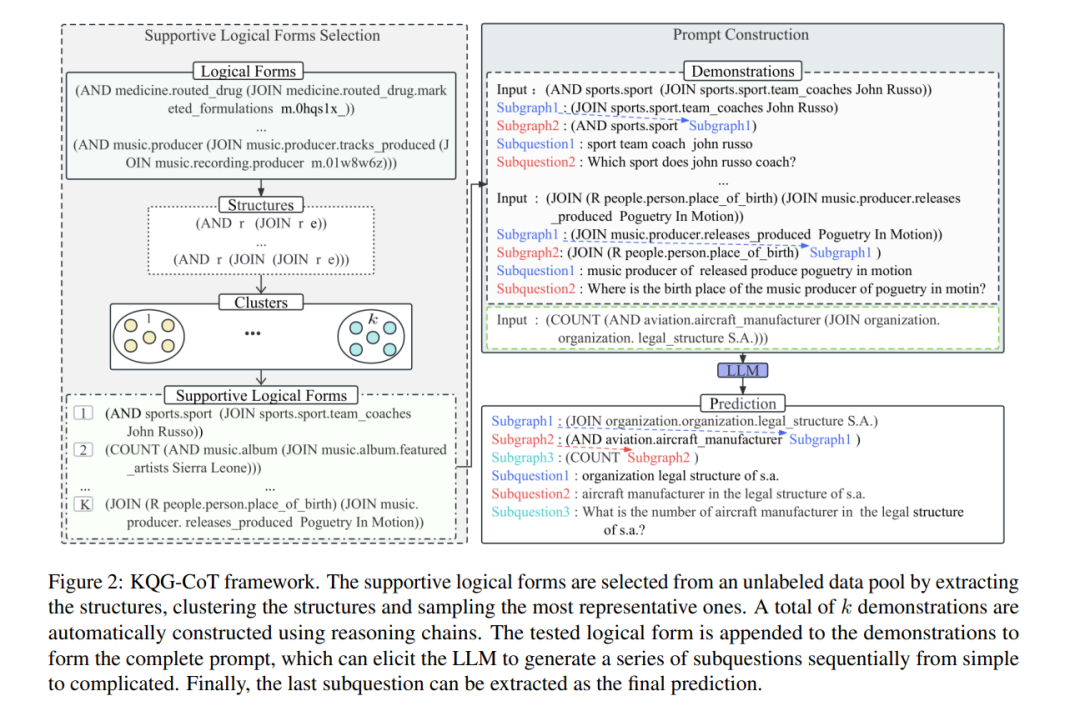

基于知识库的问题生成(KBQG)任务旨在将逻辑形式转换为自然语言问题。由于大规模问题标注的成本昂贵,迫切需要开发低资源场景下的KBQG方法。然而,现有方法严重依赖于标注数据进行微调,不适合少样本问题生成。大型语言模型(LLM)的出现在小样本任务中表现出了令人印象深刻的泛化能力。受思维链(CoT)提示的启发,该文将KBQG任务表述为一个推理问题,将一个完整问题的生成分解为一系列子问题的生成。所提出的提示方法KQG-CoT首先考虑逻辑形式的特征,从未标记的数据池中选择支持逻辑形式。然后,构建一个特定于任务的提示,以指导LLM基于所选逻辑形式生成复杂的问题。为了进一步确保提示质量,我们通过对逻辑形式的复杂性进行排序,将KQG-CoT扩展为KQG-CoT+。在三个公开的KBQG数据集上进行了广泛的实验。结果表明,我们的提示方法在评估数据集上始终优于其他提示基线。值得注意的是,我们的KQG-CoT+方法可以在BLEU-4、METEOR和ROUGE-L上分别超过PathQuestions数据集现有的少样本SoTA结果18.25、10.72和10.18个绝对点。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年11月29日

Arxiv

0+阅读 · 2023年11月25日

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日