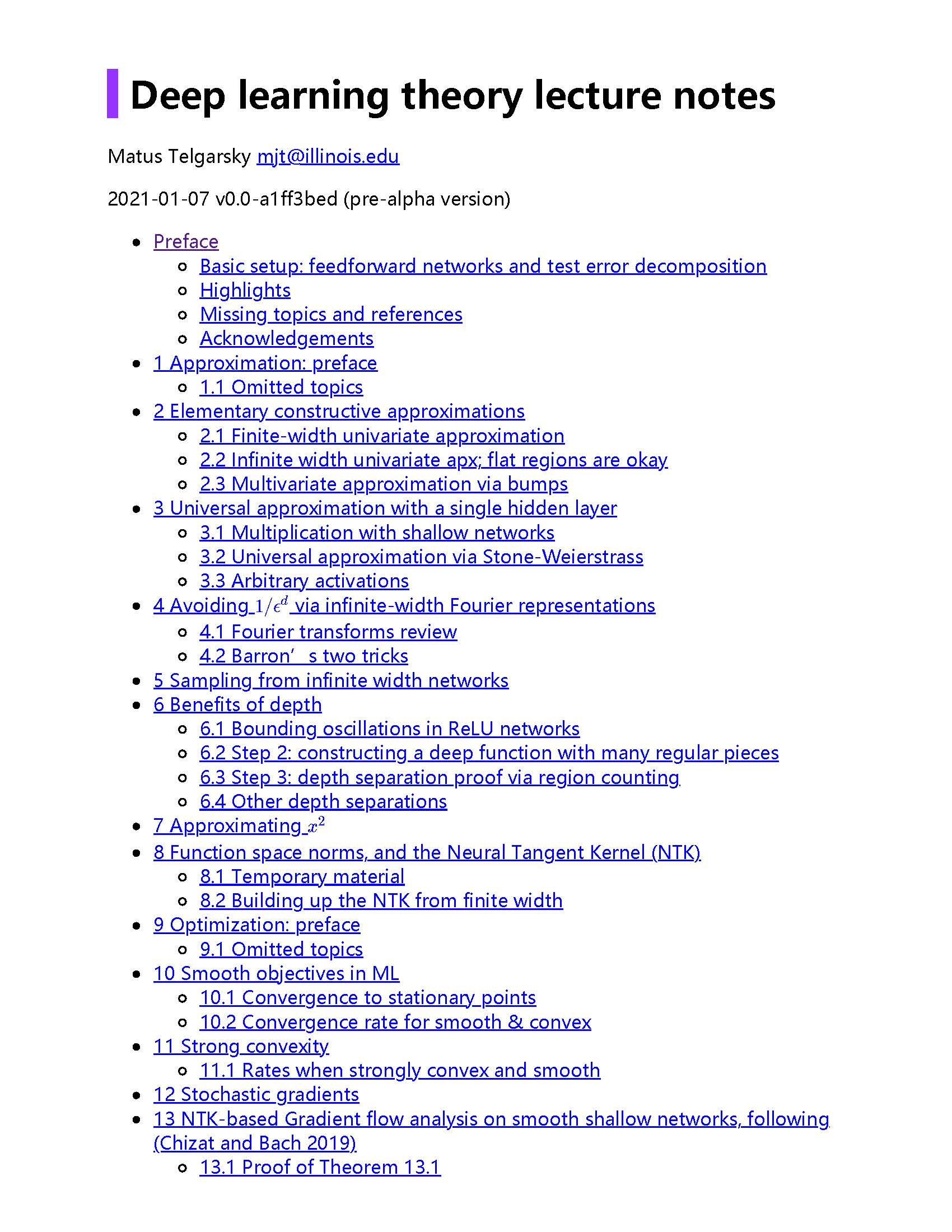

深度学习的研究在许多机器学习任务上产生了最先进的结果。大多数的进步都是由直觉和通过试验和错误进行的大规模探索推动的。因此,目前理论落后于实践。ML社区并不完全理解为什么最好的方法是有效的。来自UIUC Matus Telgarsky教授撰写了关于深度学习理论笔记,值得关注。

地址: https://mjt.cs.illinois.edu/dlt/

这些笔记的哲学。两个关键的观点决定了到目前为止所包含的内容。 我的目标是对文献中出现的东西提供简化的证明,理想情况下,把困难的东西简化成适合一节课的东西。 我主要关注通过标准(通常是ReLU)前馈网络实现IID数据的二进制分类的低测试误差的经典观点。

内容组织:

-

近似 (从第1节开始): 给定一个分类问题,存在一个深度网络,在分布上实现低误差。

-

优化 (从第9节开始): 对于一个分类问题,给定一个有限的训练集,存在寻找低训练误差和低复杂度的预测器的算法。

-

泛化 (从第16节开始): 对于低复杂度的网络,训练和测试误差之间的差距很小。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2021年3月4日