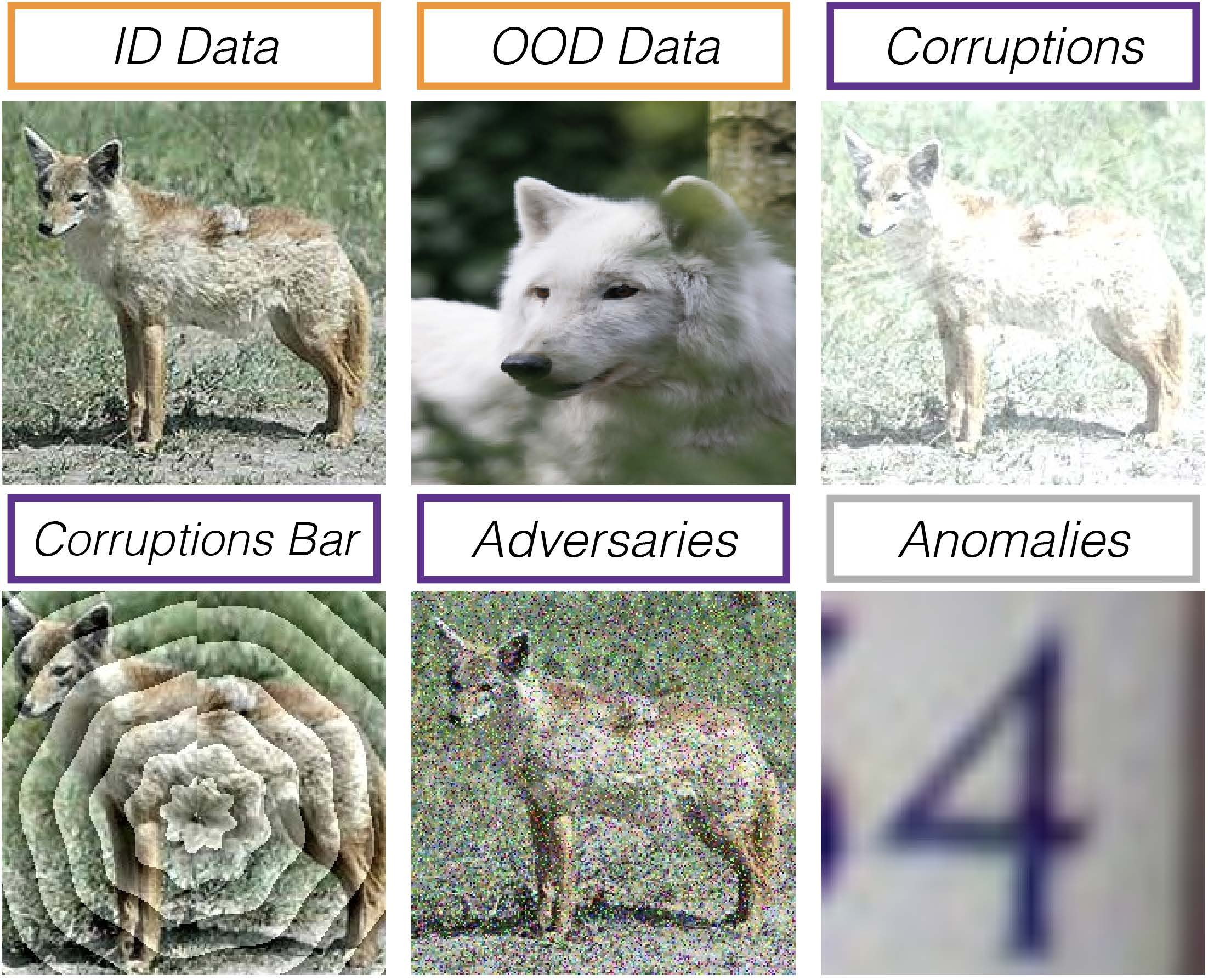

Advances in the expressivity of pretrained models have increased interest in the design of adaptation protocols which enable safe and effective transfer learning. Going beyond conventional linear probing (LP) and fine tuning (FT) strategies, protocols that can effectively control feature distortion, i.e., the failure to update features orthogonal to the in-distribution, have been found to achieve improved out-of-distribution generalization (OOD). In order to limit this distortion, the LP+FT protocol, which first learns a linear probe and then uses this initialization for subsequent FT, was proposed. However, in this paper, we find when adaptation protocols (LP, FT, LP+FT) are also evaluated on a variety of safety objectives (e.g., calibration, robustness, etc.), a complementary perspective to feature distortion is helpful to explain protocol behavior. To this end, we study the susceptibility of protocols to simplicity bias (SB), i.e. the well-known propensity of deep neural networks to rely upon simple features, as SB has recently been shown to underlie several problems in robust generalization. Using a synthetic dataset, we demonstrate the susceptibility of existing protocols to SB. Given the strong effectiveness of LP+FT, we then propose modified linear probes that help mitigate SB, and lead to better initializations for subsequent FT. We verify the effectiveness of the proposed LP+FT variants for decreasing SB in a controlled setting, and their ability to improve OOD generalization and safety on three adaptation datasets.

翻译:预训练模型表达能力的提高增加了对安全有效的转移学习自适应协议的设计的兴趣。除了传统的线性探测(LP)和微调(FT)策略外,发现能够有效控制特征扭曲(即更新正交于所在分布的特征的能力)的协议可实现改进的越界泛化。为了限制此类扭曲,提出了LP + FT协议,该协议首先学习线性探针,然后使用此初始化进行后续的微调。然而,在本文中,当也考虑了协议的多种安全目标(例如校准、健壮性等)时,从特征扭曲的补充角度来解释协议的行为是有帮助的。因此,我们研究了协议容易受到简单性偏差(SB)的影响,即深度神经网络倾向于依赖于简单特征,因为SB最近被发现是一些健壮性普遍问题的根源。使用一个合成的数据集,我们展示了现有协议对SB的敏感性。鉴于LP + FT的强大有效性,我们提出了修改后的线性探测器,有助于减少SB,并为后续的FT提供更好的初始化,我们在受控环境中验证了所提出的LP + FT变体在减少SB方面的有效性,并且在三个自适应数据集上证明了它们提高越界泛化和安全性的能力。