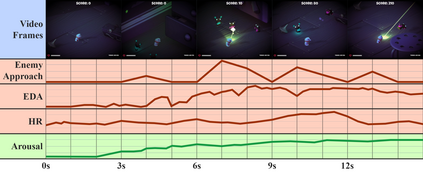

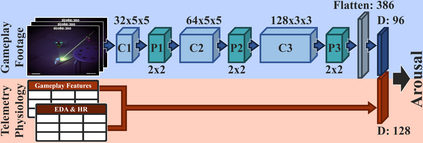

A key challenge of affective computing research is discovering ways to reliably transfer affect models that are built in the laboratory to real world settings, namely in the wild. The existing gap between in vitro and in vivo affect applications is mainly caused by limitations related to affect sensing including intrusiveness, hardware malfunctions, availability of sensors, but also privacy and security. As a response to these limitations in this paper we are inspired by recent advances in machine learning and introduce the concept of privileged information for operating affect models in the wild. The presence of privileged information enables affect models to be trained across multiple modalities available in a lab setting and ignore modalities that are not available in the wild with no significant drop in their modeling performance. The proposed privileged information framework is tested in a game arousal corpus that contains physiological signals in the form of heart rate and electrodermal activity, game telemetry, and pixels of footage from two dissimilar games that are annotated with arousal traces. By training our arousal models using all modalities (in vitro) and using solely pixels for testing the models (in vivo), we reach levels of accuracy obtained from models that fuse all modalities both for training and testing. The findings of this paper make a decisive step towards realizing affect interaction in the wild.

翻译:电动计算研究的一个关键挑战是如何可靠地将实验室中建于实验室中的模型转移到现实世界环境中,即野生环境中的模型。体外和体外之间的现有差距影响应用,主要是由于与感知有关的限制,包括侵扰性、硬件故障、传感器的可用性、以及隐私和安全。为了应对本文件中的这些限制,我们受到机器学习方面的最新进展的启发,并引入了用于操作野生模型的特权信息概念。特权信息的存在使得影响模型的模型能够通过实验室设置中现有的多种模式和在野外得不到的、其模型性能没有显著下降的忽视模式来接受培训。拟议特惠信息框架是在一个游戏中测试的,该游戏包含以心率和电极活动、游戏遥测法和两场不同游戏的画面的像素。通过培训我们使用各种模式(体外)和仅使用像素来测试模型,我们达到了从模型中获得的准确度水平,这些模型将所有方式结合起来,从而实现对结果进行决定性的培训和测试。