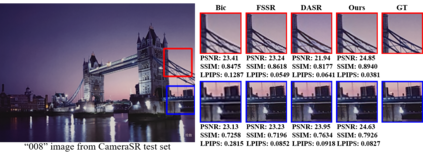

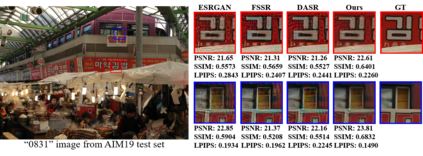

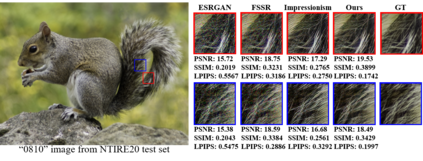

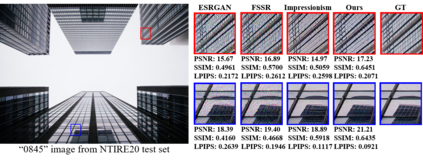

Real-world image super-resolution is a practical image restoration problem that aims to obtain high-quality images from in-the-wild input, has recently received considerable attention with regard to its tremendous application potentials. Although deep learning-based methods have achieved promising restoration quality on real-world image super-resolution datasets, they ignore the relationship between L1- and perceptual- minimization and roughly adopt auxiliary large-scale datasets for pre-training. In this paper, we discuss the image types within a corrupted image and the property of perceptual- and Euclidean- based evaluation protocols. Then we propose a method, Real-World image Super-Resolution by Exclusionary Dual-Learning (RWSR-EDL) to address the feature diversity in perceptual- and L1- based cooperative learning. Moreover, a noise-guidance data collection strategy is developed to address the training time consumption in multiple datasets optimization. When an auxiliary dataset is incorporated, RWSR-EDL achieves promising results and repulses any training time increment by adopting the noise-guidance data collection strategy. Extensive experiments show that RWSR-EDL achieves competitive performance over state-of-the-art methods on four in-the-wild image super-resolution datasets.

翻译:现实世界图像超分辨率是一个实用的图像恢复问题,目的是从网上输入获得高质量的图像,最近由于应用潜力巨大而受到相当重视。尽管深层次的学习方法在现实世界图像超分辨率数据集中实现了大有希望的恢复质量,但它们忽视了L1和概念最小化之间的关系,并大致采用了培训前使用的辅助大型数据集。在本文件中,我们讨论了腐败图像中的图像类型以及概念和Euclidean评估协议的属性。然后,我们提出了一种方法,即通过排除性双重学习(RWSR-EDL)实现真实世界图像超级解析,以解决概念和L1合作学习中的特征多样性。此外,还制定了噪音指导数据收集战略,以解决多个数据集的培训消耗问题。在纳入辅助数据集时,RWSR-EDL将取得有希望的结果,并通过采用噪音指导数据收集战略来抵消任何培训时间的增加。广泛的实验显示,RWSR-ED-L在四度分辨率上取得了竞争性的超分辨率。