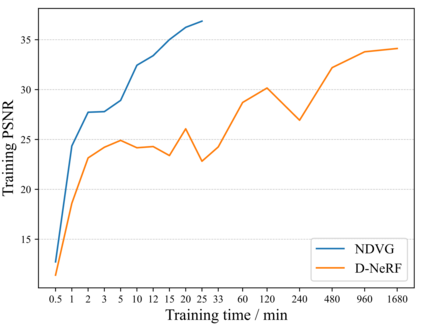

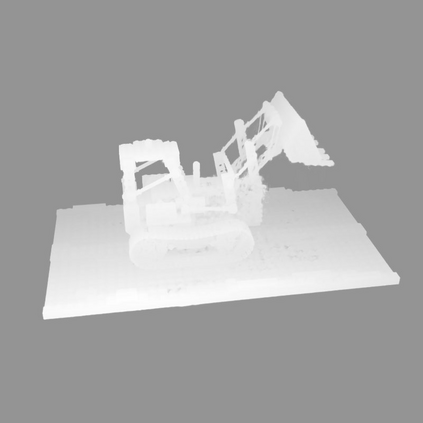

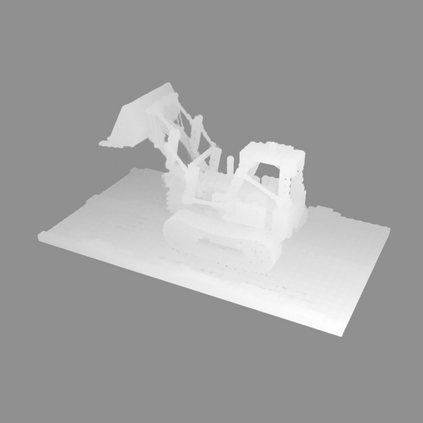

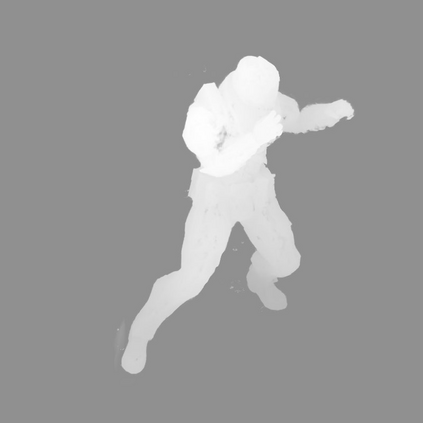

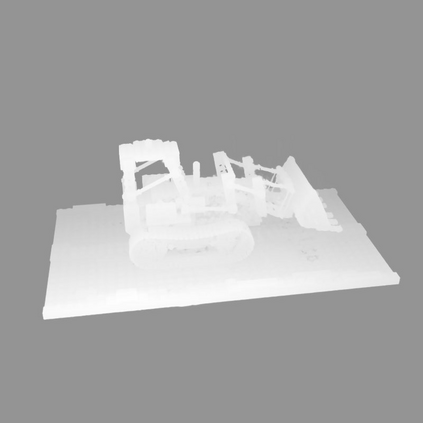

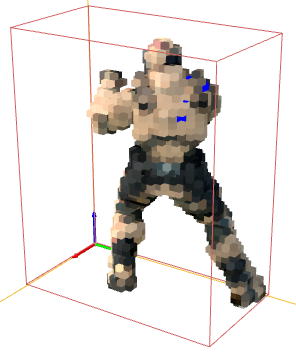

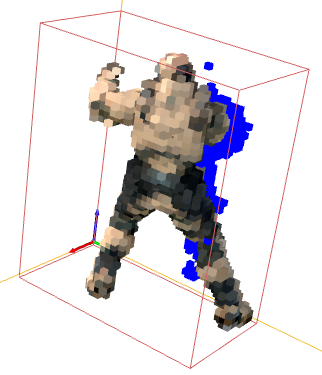

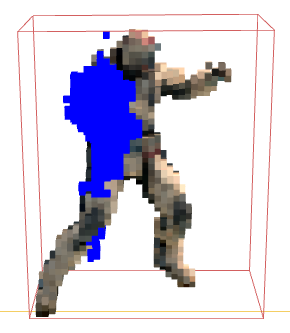

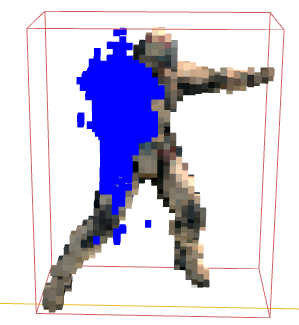

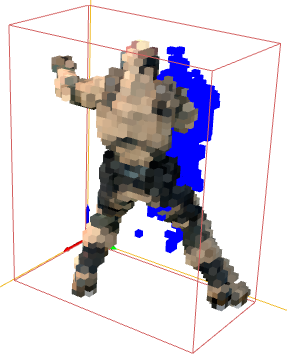

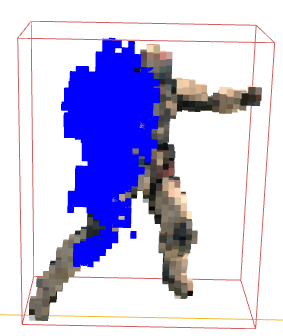

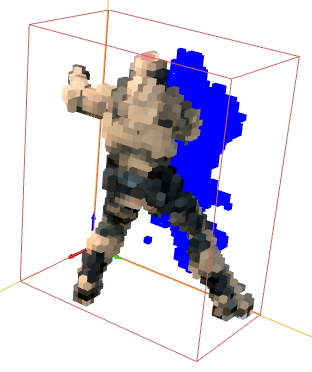

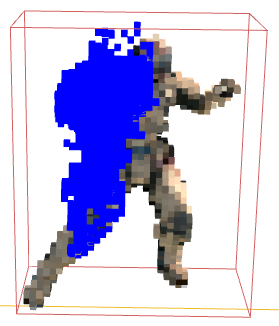

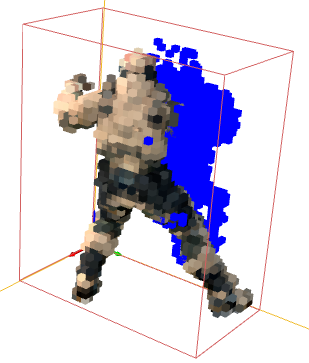

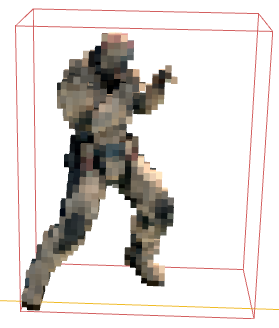

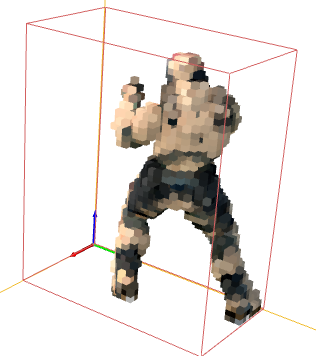

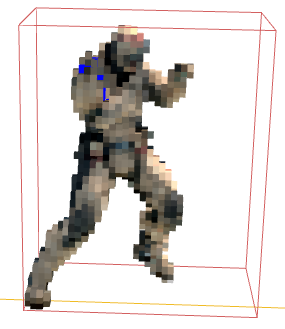

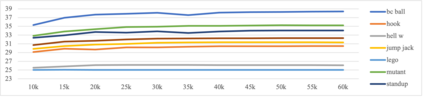

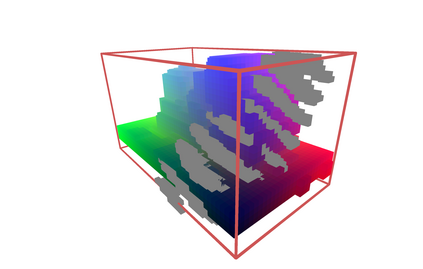

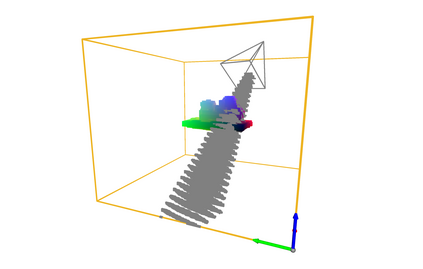

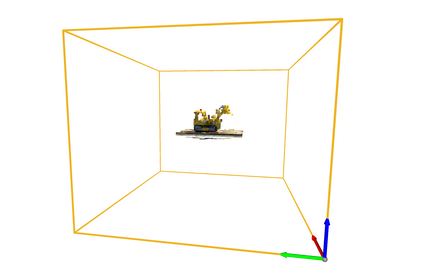

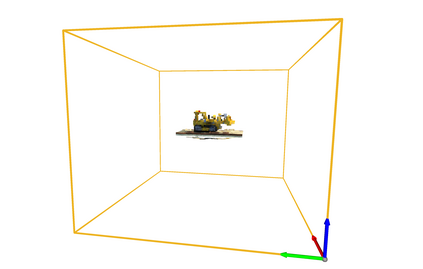

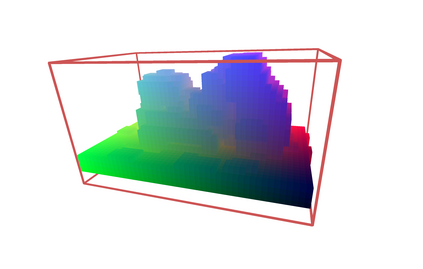

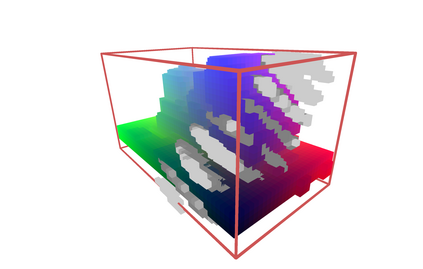

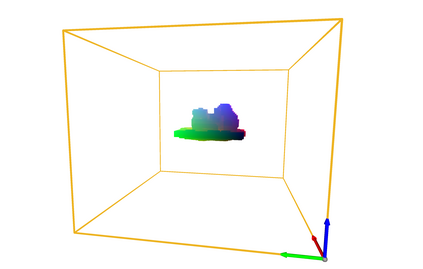

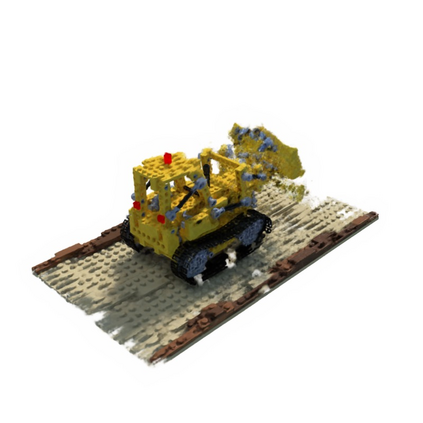

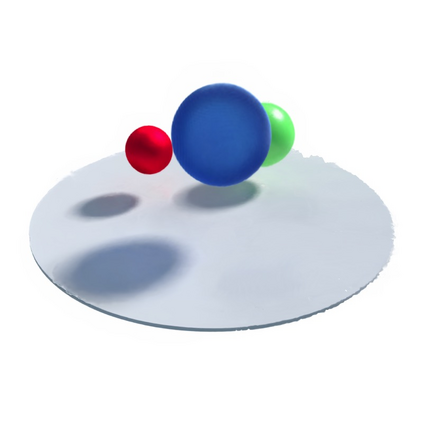

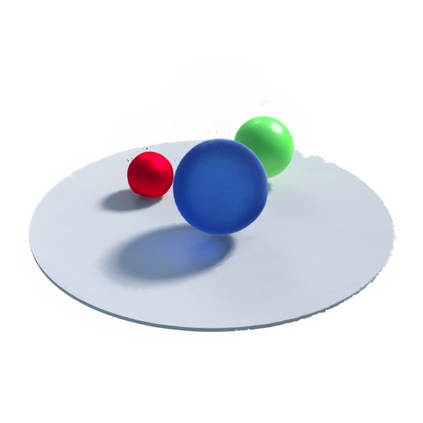

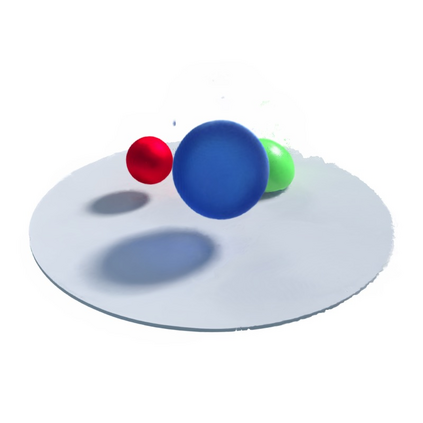

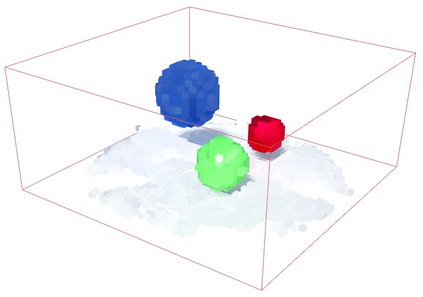

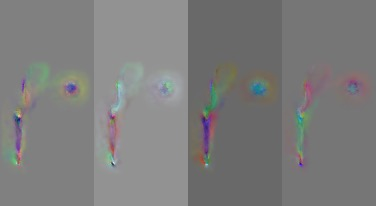

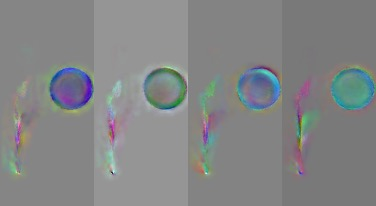

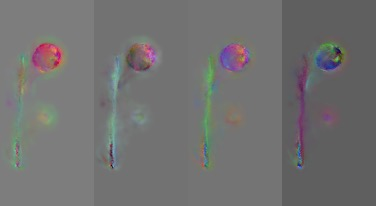

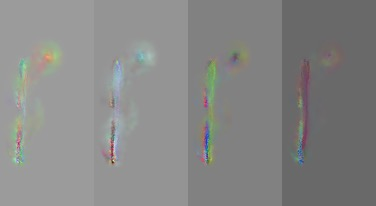

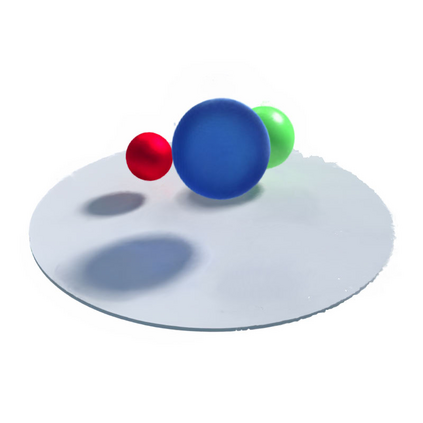

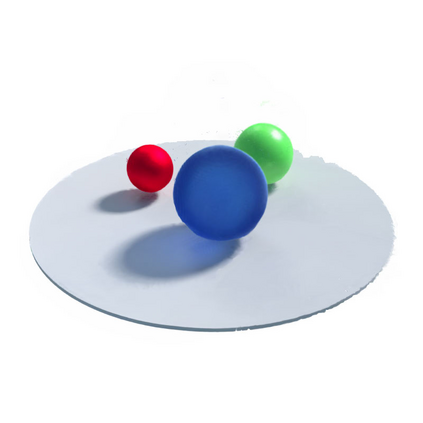

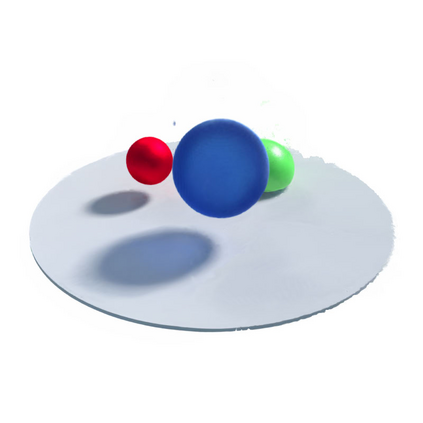

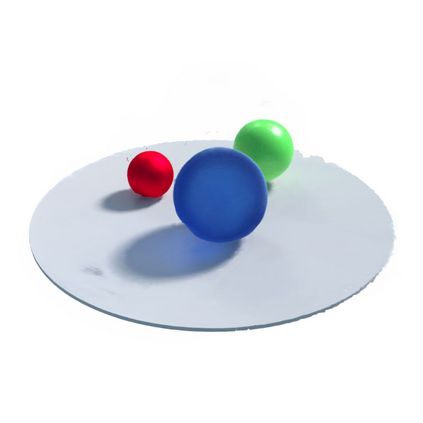

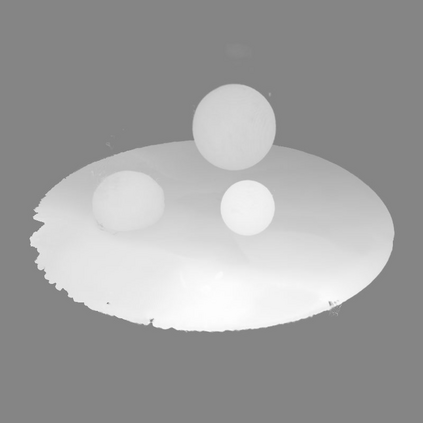

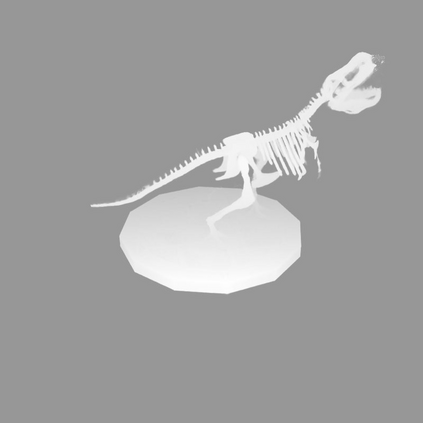

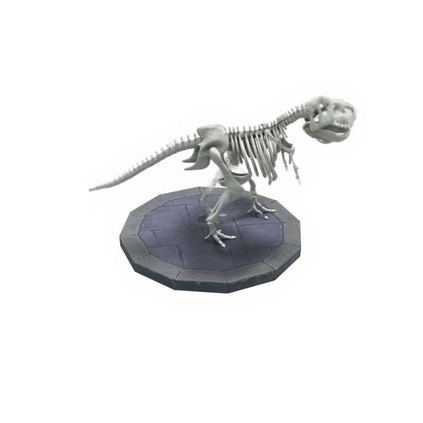

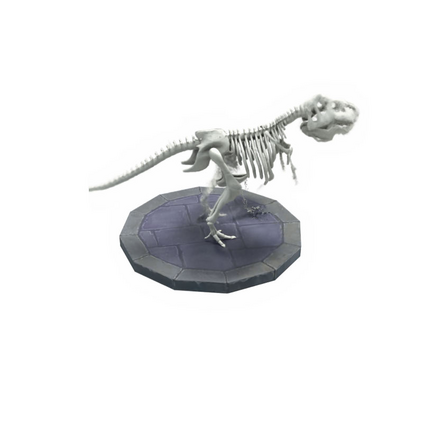

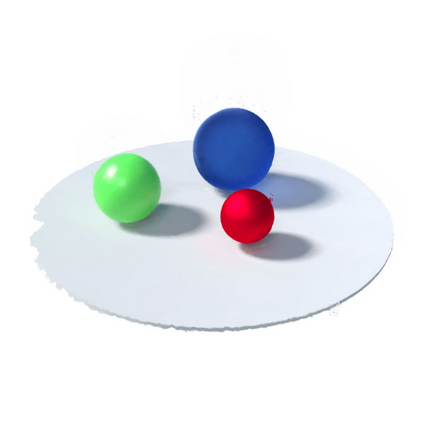

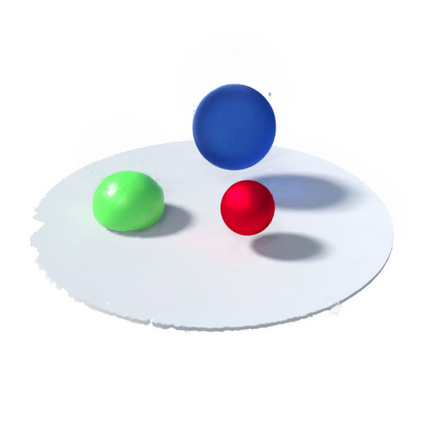

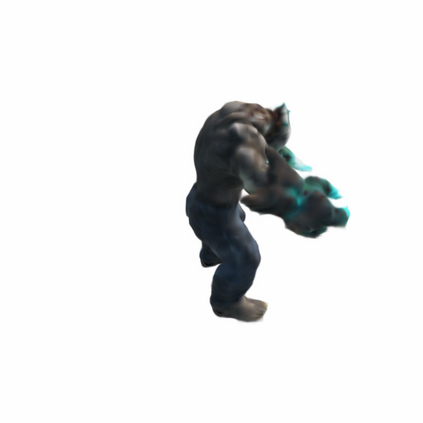

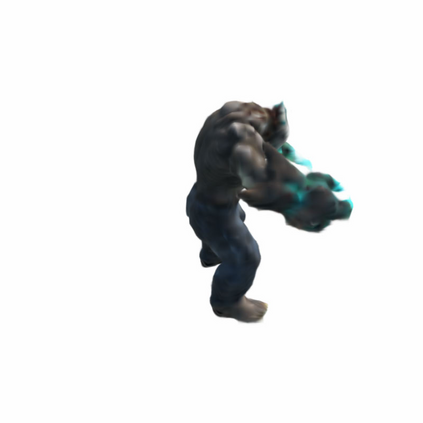

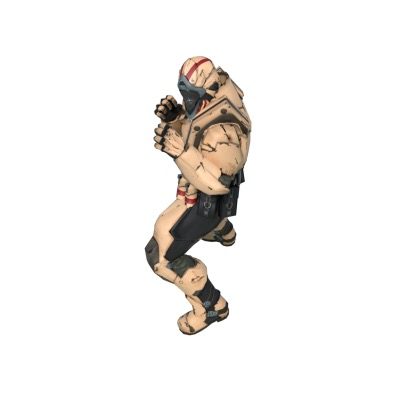

Recently, Neural Radiance Fields (NeRF) is revolutionizing the task of novel view synthesis (NVS) for its superior performance. However, NeRF and its variants generally require a lengthy per-scene training procedure, where a multi-layer perceptron (MLP) is fitted to the captured images. To remedy the challenge, the voxel-grid representation has been proposed to significantly speed up the training. However, these existing methods can only deal with static scenes. How to develop an efficient and accurate dynamic view synthesis method remains an open problem. Extending the methods for static scenes to dynamic scenes is not straightforward as both the scene geometry and appearance change over time. In this paper, built on top of the recent advances in voxel-grid optimization, we propose a fast deformable radiance field method to handle dynamic scenes. Our method consists of two modules. The first module adopts a deformation grid to store 3D dynamic features, and a light-weight MLP for decoding the deformation that maps a 3D point in observation space to the canonical space using the interpolated features. The second module contains a density and a color grid to model the geometry and density of the scene. The occlusion is explicitly modeled to further improve the rendering quality. Experimental results show that our method achieves comparable performance to D-NeRF using only 20 minutes for training, which is more than 70x faster than D-NeRF, clearly demonstrating the efficiency of our proposed method.

翻译:最近,Neoral Radiance Fields(NeRF)正在使新视觉合成(NVS)的任务发生革命,以取得优异的性能。然而,NeRF及其变体通常需要冗长的每层培训程序,多层光谱(MLP)与所捕捉的图像相匹配。为了克服挑战,我们提议了 voxel-grid 表示方式,以大大加快培训速度。然而,这些现有方法只能处理静态场景。如何开发高效和准确的动态视图合成方法仍是一个开放的问题。将静态场的方法推广到动态场景并非直截了当的,因为场景的几何色测量和外观随着时间的变化而变化。在本文中,在Voxel-grid优化的最新进展的基础上,我们提出了一种快速变形光场方法。我们的方法由两个模块组成。第一个模块采用变形格格格来存储 3D 动态特性,而一个轻度的MLP,只是解码的MLP,用来用内部的3D点绘制观测空间的观测空间,使用内部结构特性和外观特性特性的特征特征的特征并非直观特性,因为地貌特征特征特征特征特征特征特征特征的特性和外观,第二个模块显示的模型的模化方法是更精确的模化方法,而更精确的模化方法是更精确的模型。