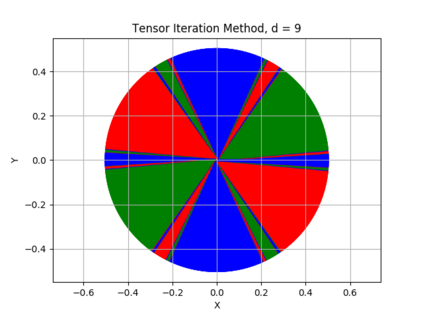

The {\em tensor power method} generalizes the matrix power method to higher order arrays, or tensors. Like in the matrix case, the fixed points of the tensor power method are the eigenvectors of the tensor. While every real symmetric matrix has an eigendecomposition, the vectors generating a symmetric decomposition of a real symmetric tensor are not always eigenvectors of the tensor. In this paper we show that whenever an eigenvector {\em is} a generator of the symmetric decomposition of a symmetric tensor, then (if the order of the tensor is sufficiently high) this eigenvector is {\em robust} , i.e., it is an attracting fixed point of the tensor power method. We exhibit new classes of symmetric tensors whose symmetric decomposition consists of eigenvectors. Generalizing orthogonally decomposable tensors, we consider {\em equiangular tight frame decomposable} and {\em equiangular set decomposable} tensors. Our main result implies that such tensors can be decomposed using the tensor power method.

翻译:~ em 振动功率法} 将矩阵功率法一般化为高排序阵列或高压阵列。 和矩阵一样, 高压功率法的固定点是高压阵列的振动源。 虽然每个真实的对称矩阵都具有eigendecomposition, 但产生真实对称强力阵列的对称分解的矢量并非始终是高压阵列的对称分解器。 在本文中, 我们显示每当一个静脉冲阵列 ~ 或高压阵列 } 一个对称分解阵列的生成器, 然后( 如果高压阵列的顺序足够高) 这个对称矩阵的固定点是振动的振动。 也就是说, 它是一个吸引对称对称强力阵列法的对称分解点。 我们展示了新型的对称强力阵列电压阵列, 其对称分解的分解作用由易分解的振动体组成。 我们考虑用可反向的阵阵阵阵阵阵阵式主结果解, 我们的阵阵式主阵列变的反制式变变变的压制式制式变的压制式制式制式制式式式式式式式式式式式式式式式式式式式式式式式式式式式的压压压压压制制制制制制制制制。