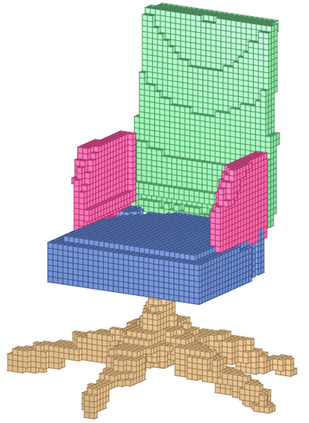

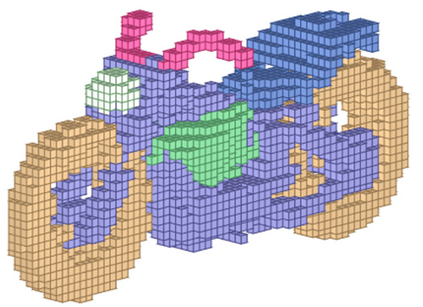

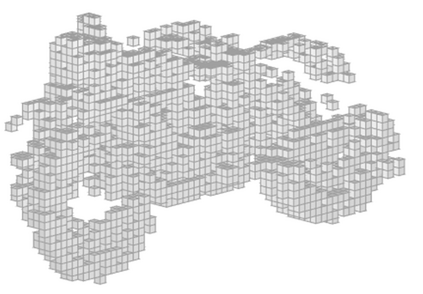

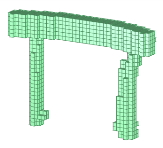

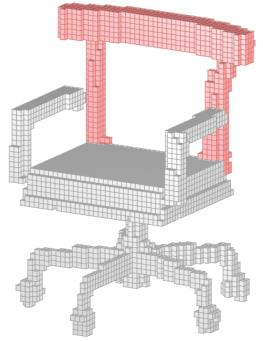

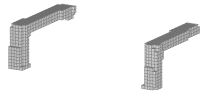

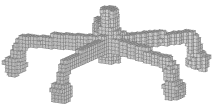

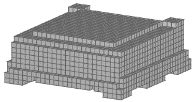

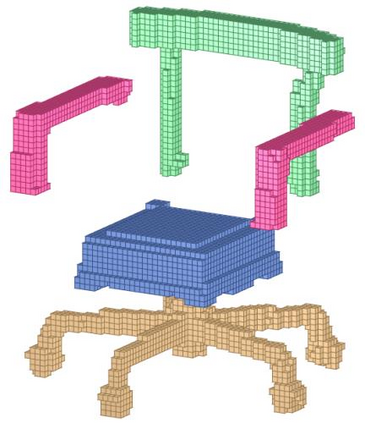

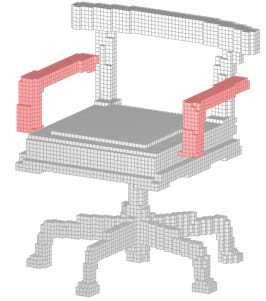

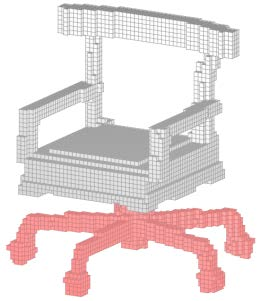

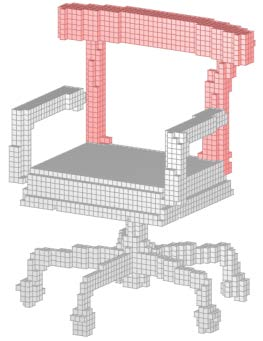

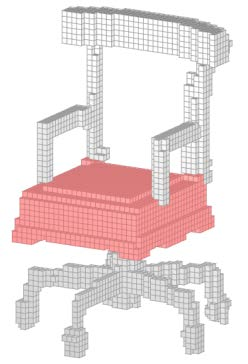

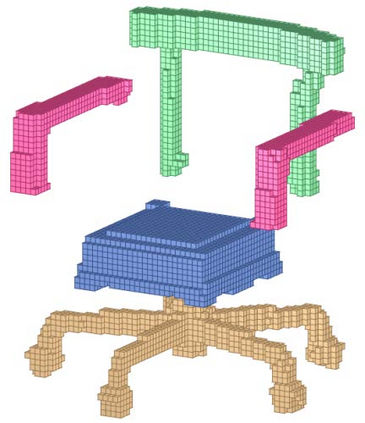

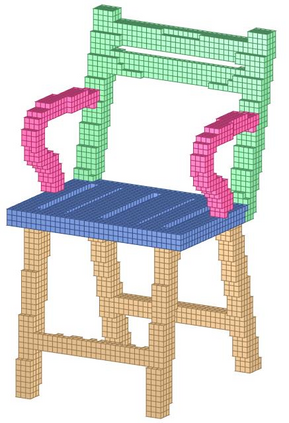

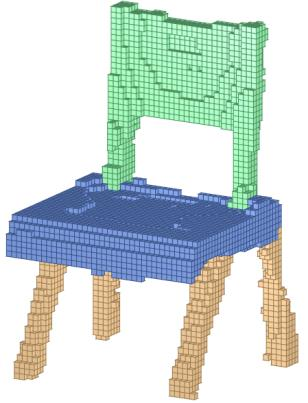

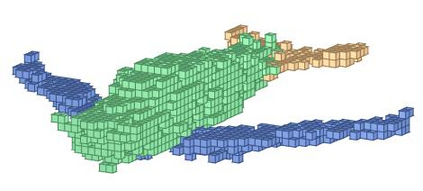

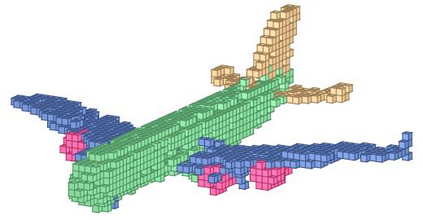

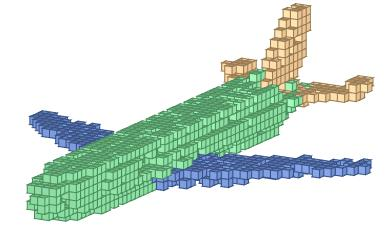

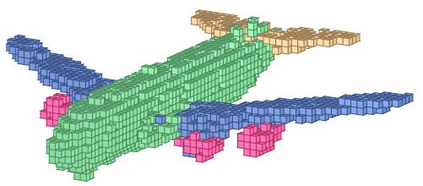

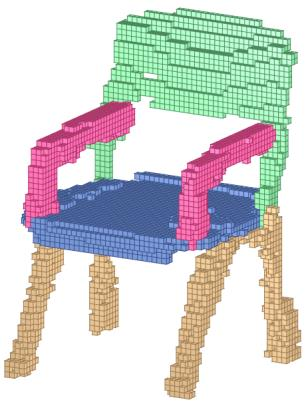

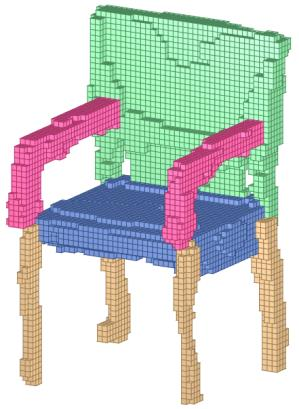

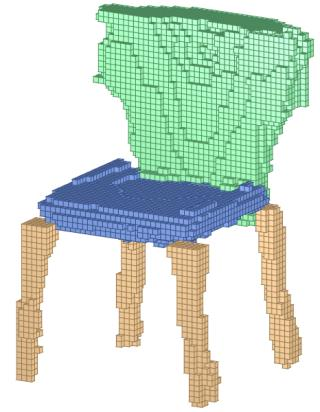

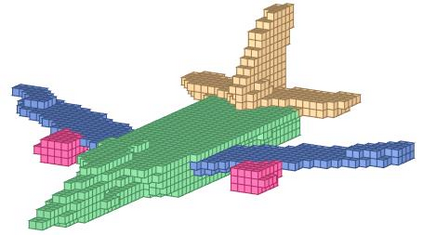

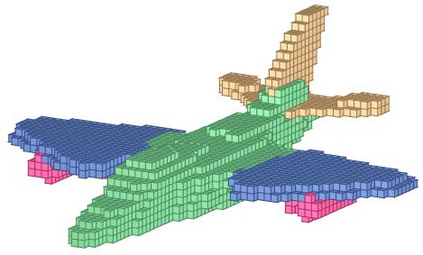

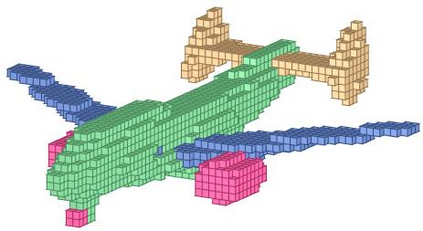

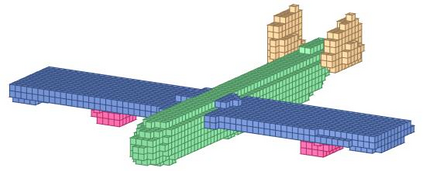

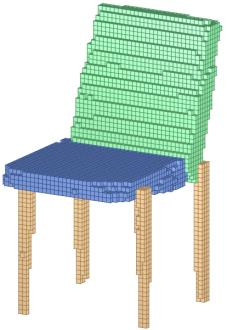

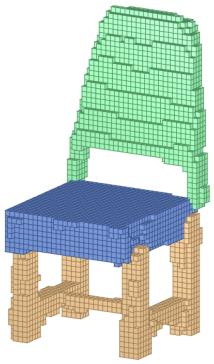

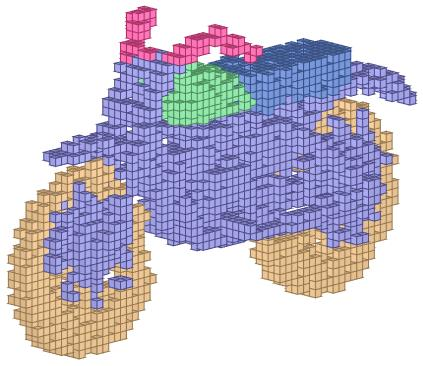

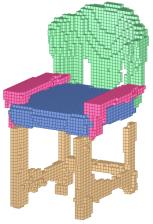

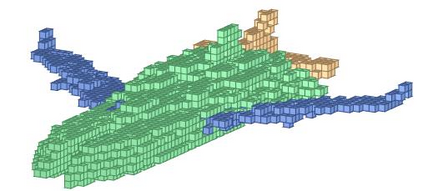

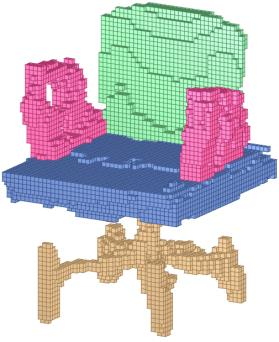

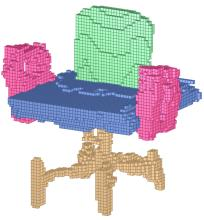

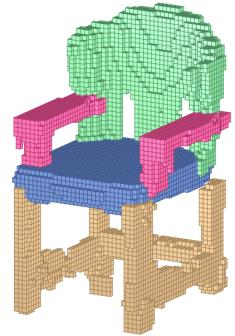

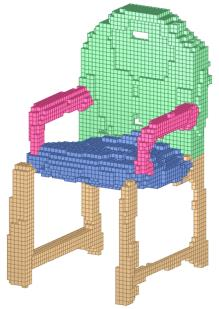

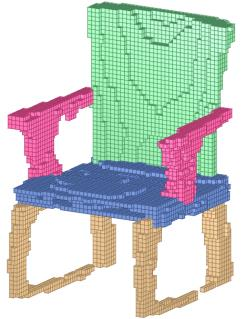

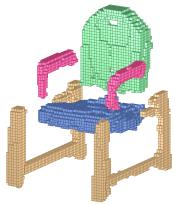

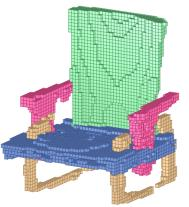

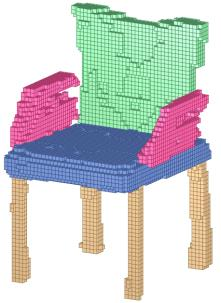

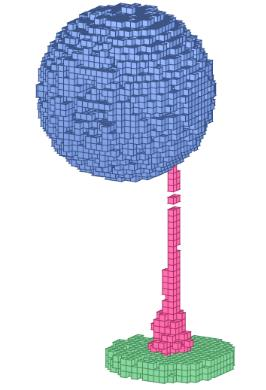

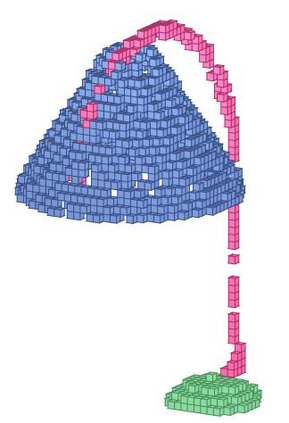

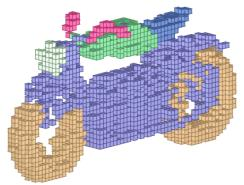

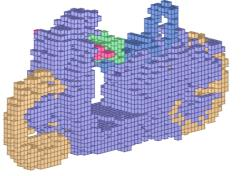

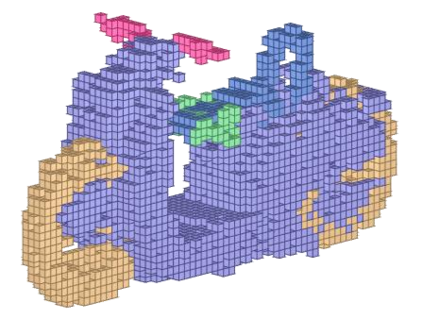

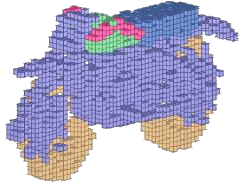

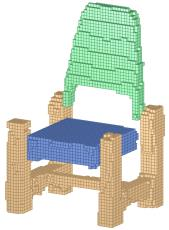

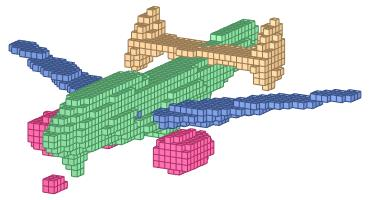

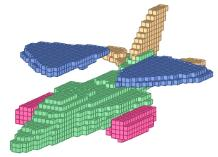

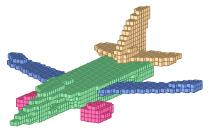

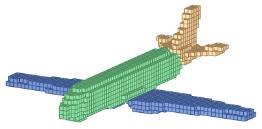

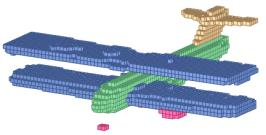

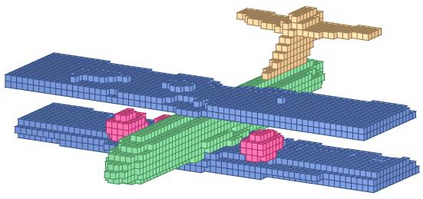

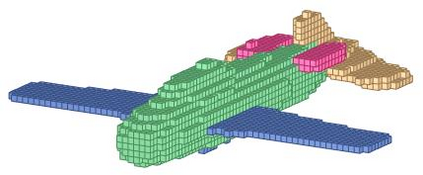

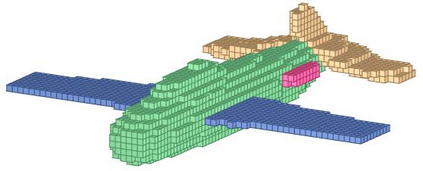

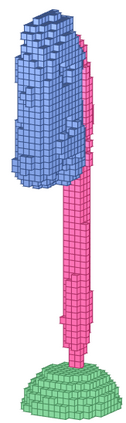

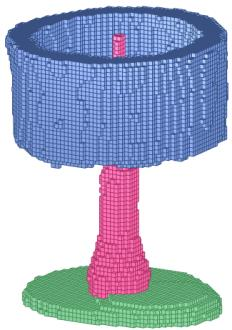

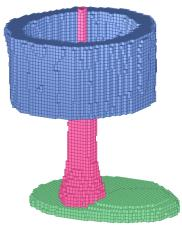

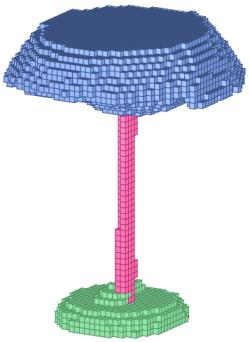

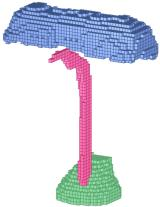

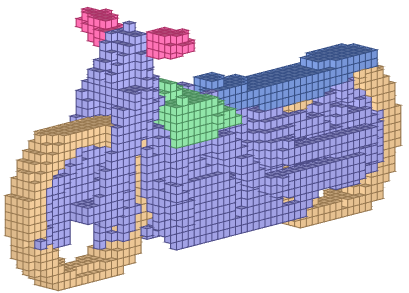

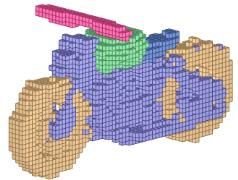

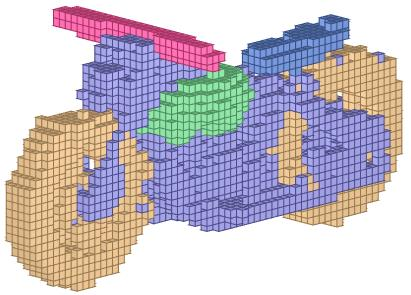

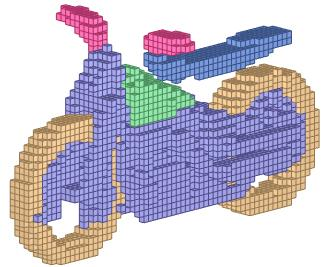

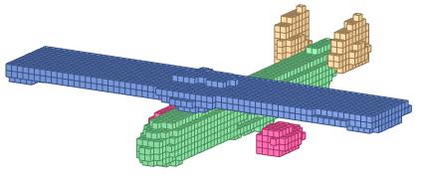

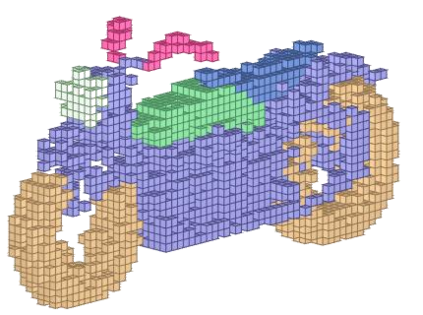

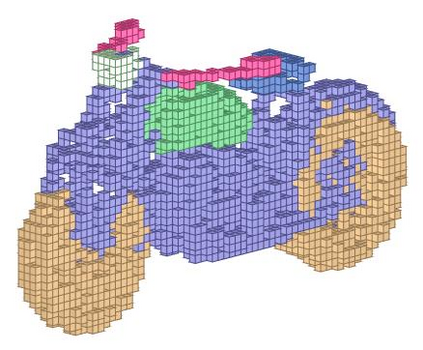

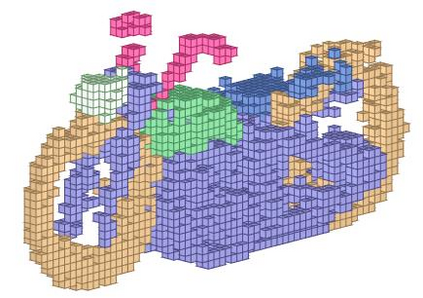

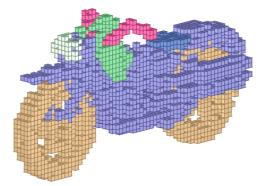

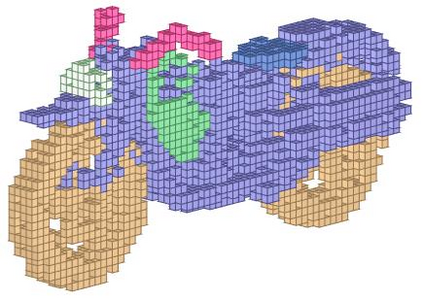

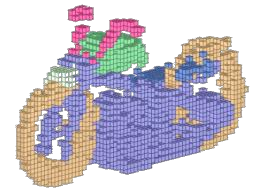

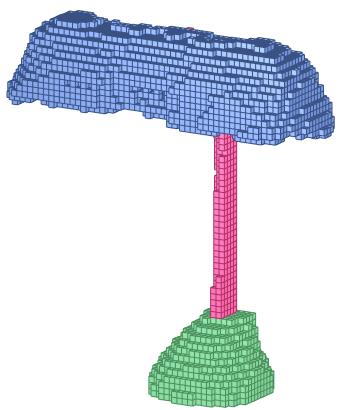

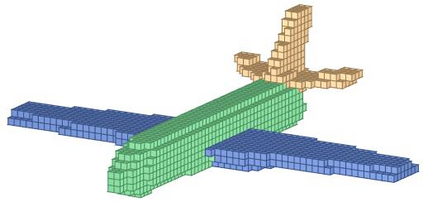

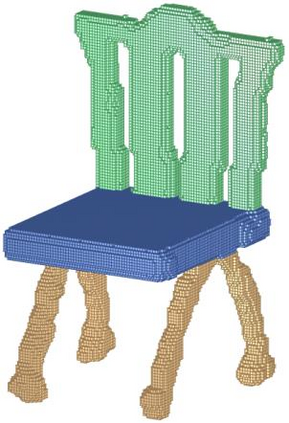

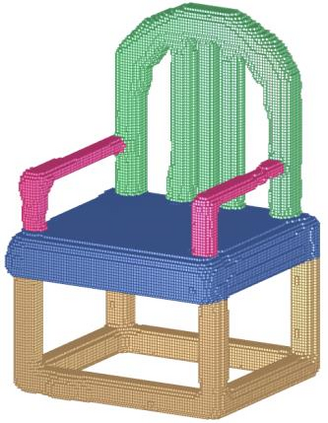

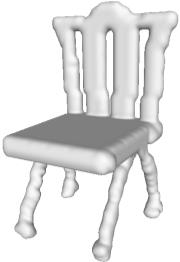

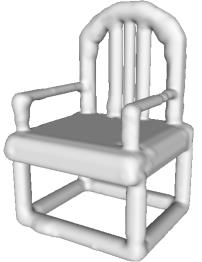

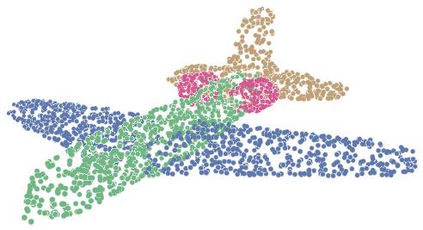

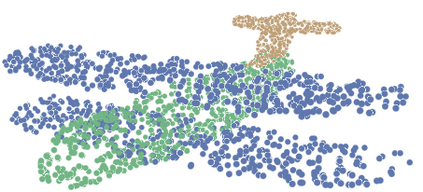

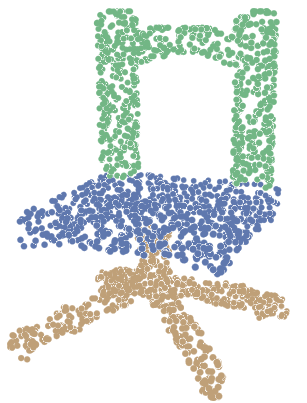

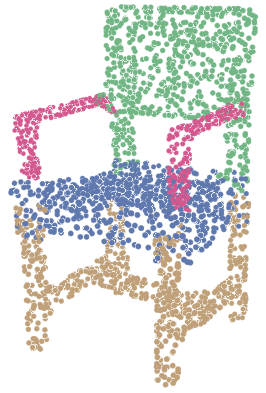

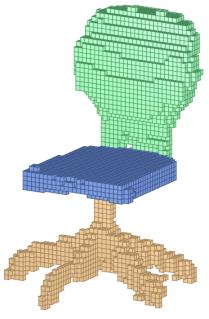

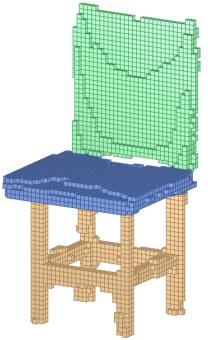

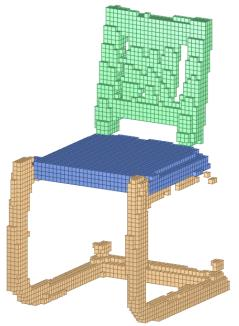

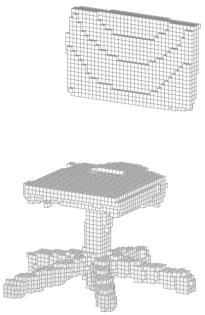

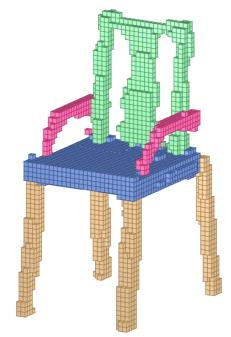

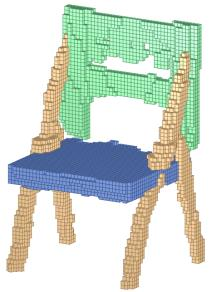

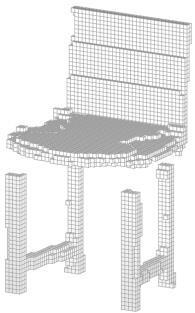

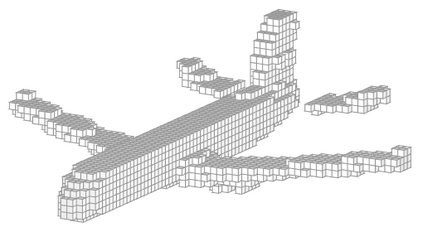

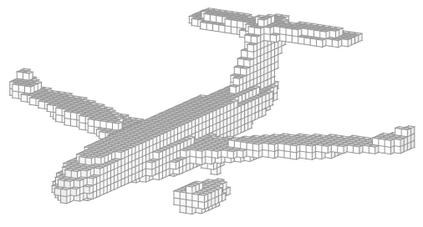

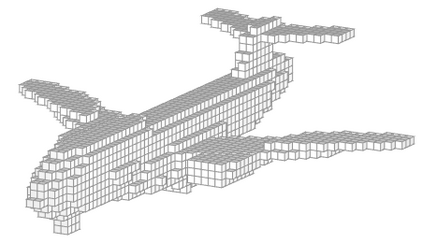

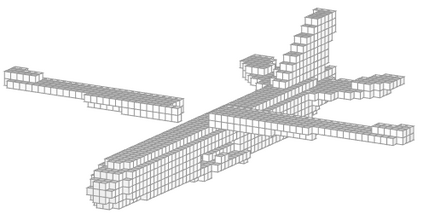

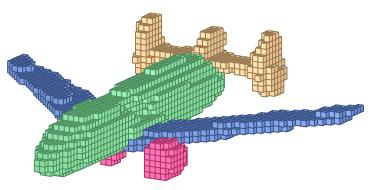

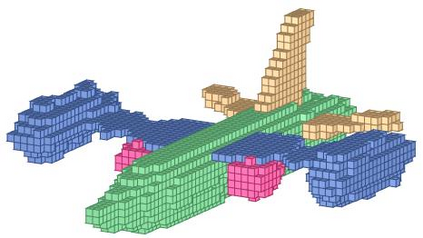

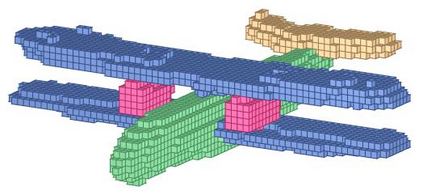

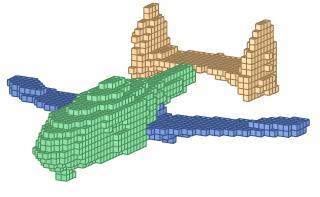

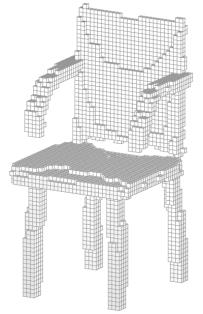

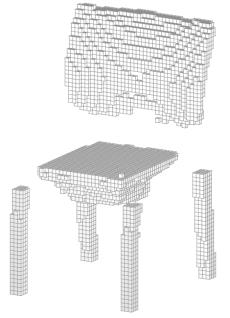

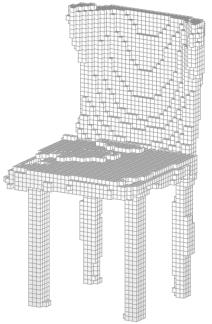

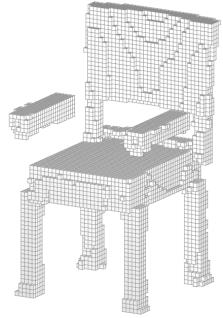

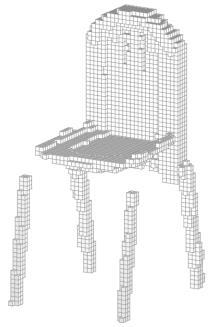

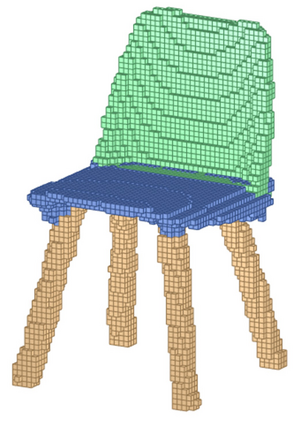

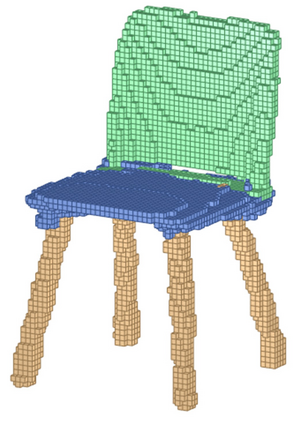

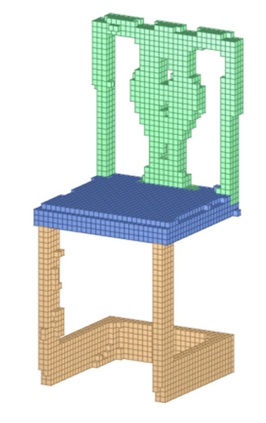

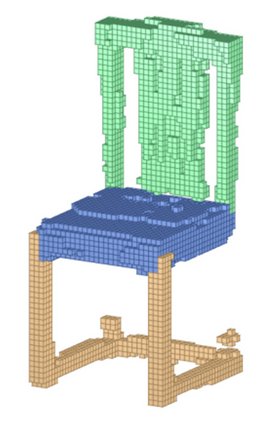

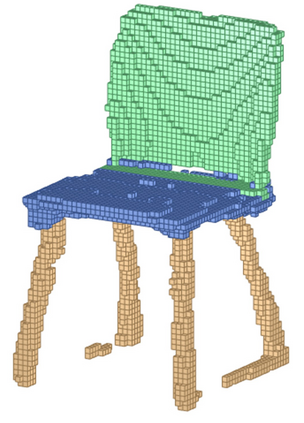

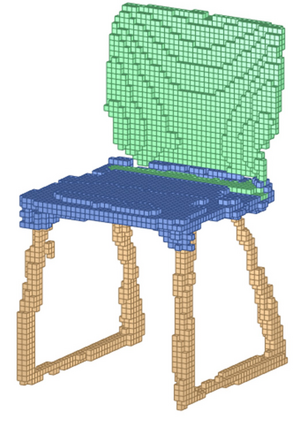

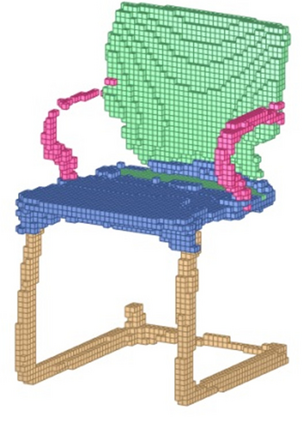

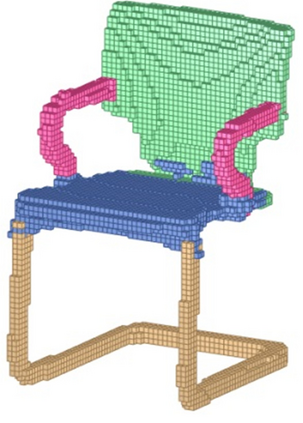

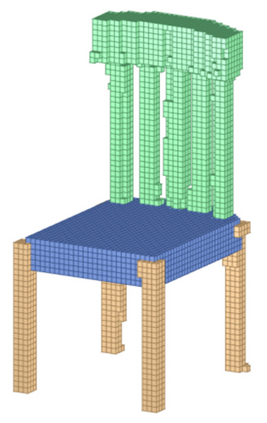

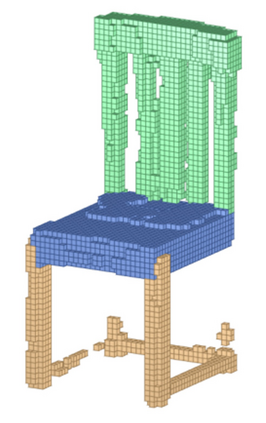

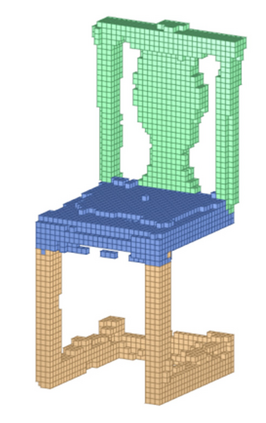

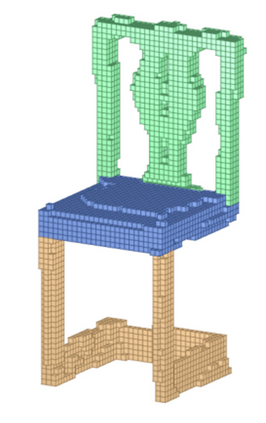

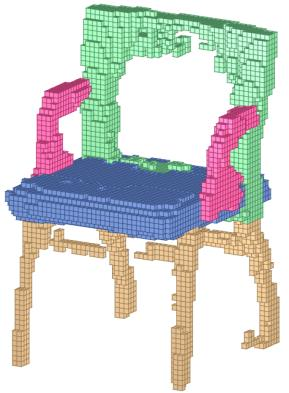

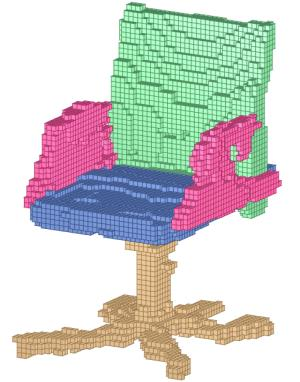

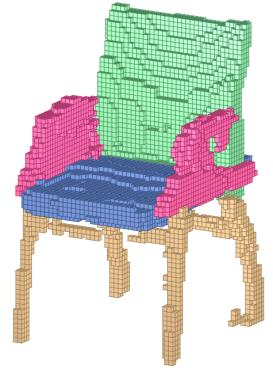

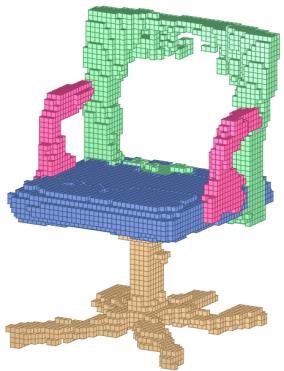

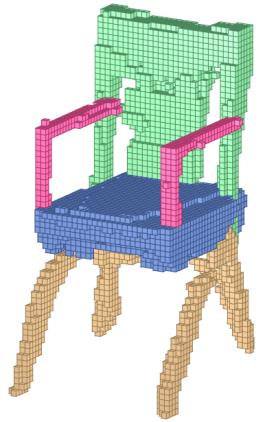

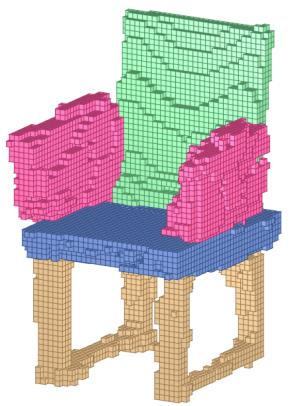

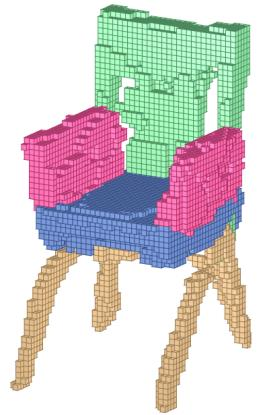

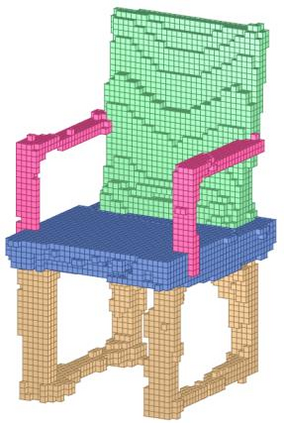

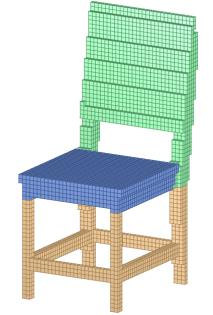

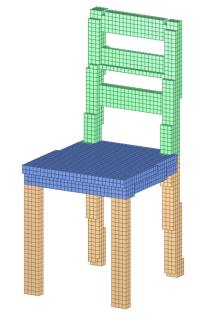

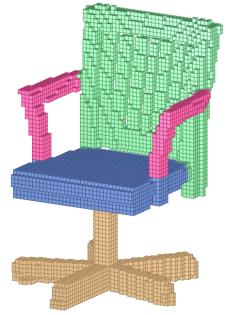

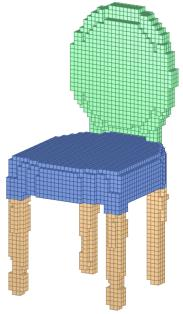

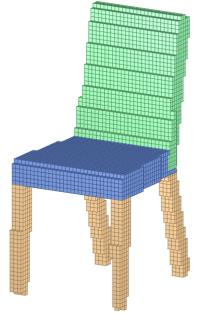

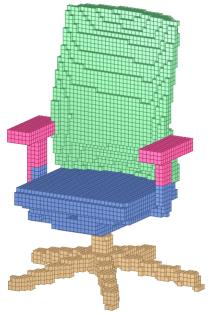

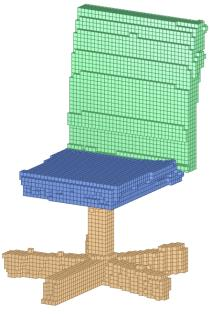

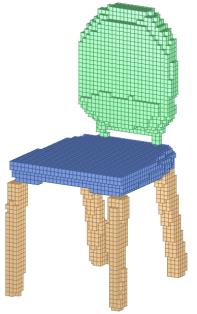

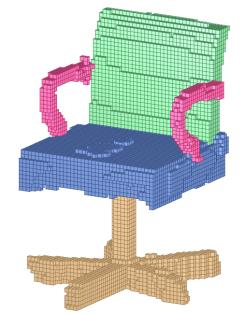

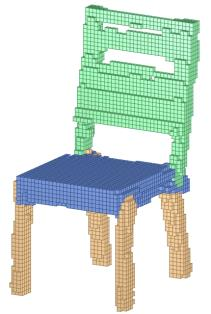

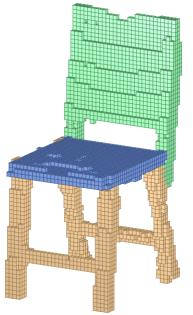

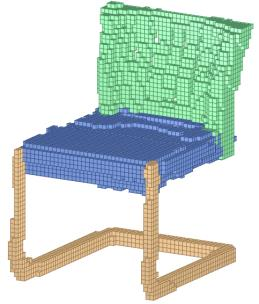

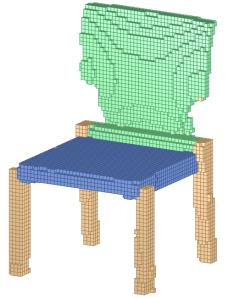

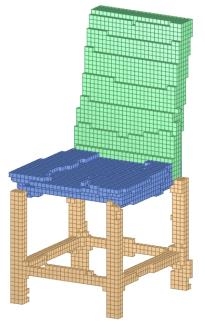

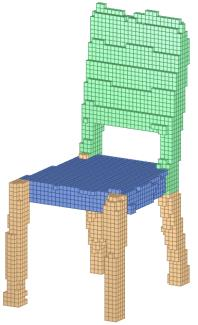

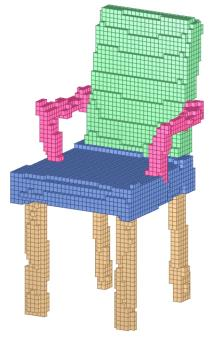

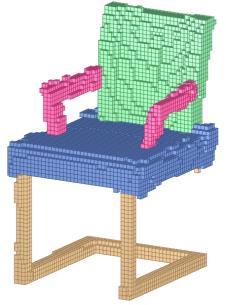

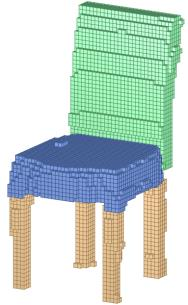

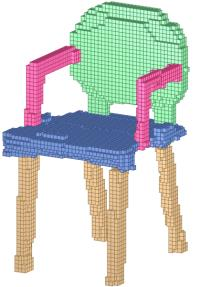

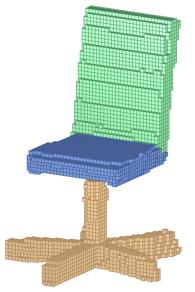

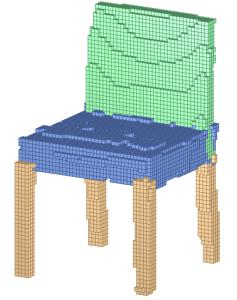

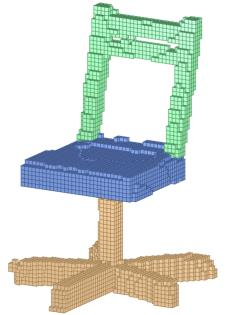

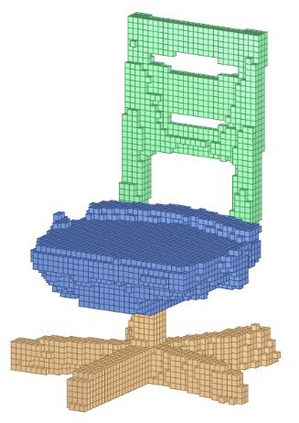

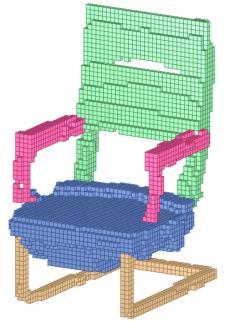

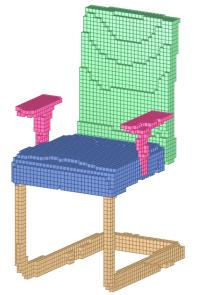

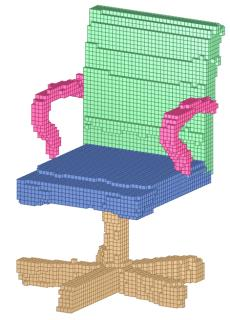

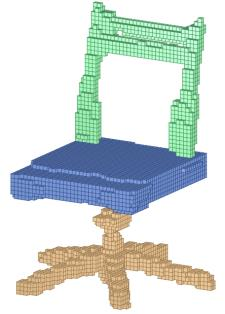

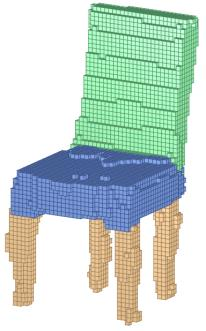

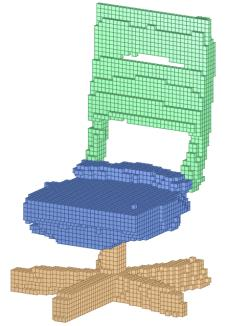

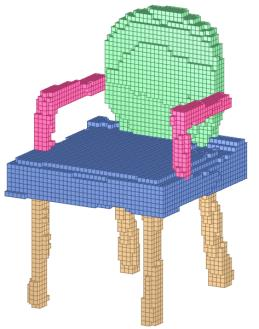

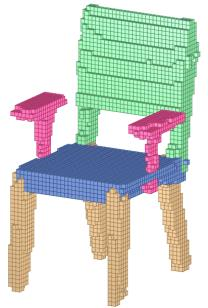

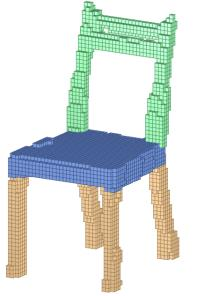

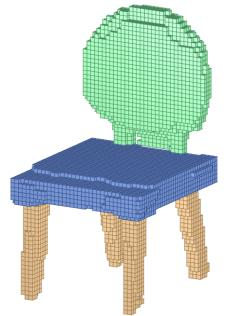

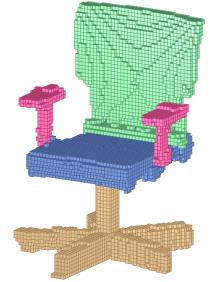

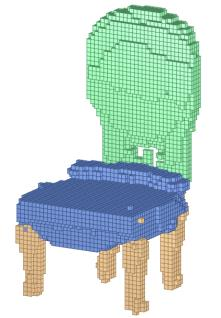

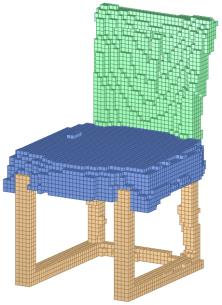

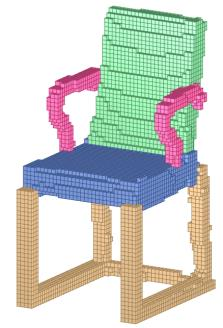

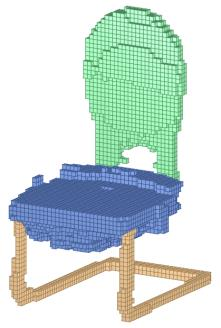

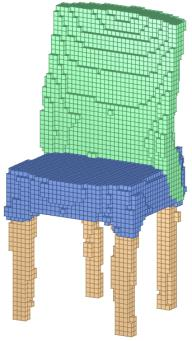

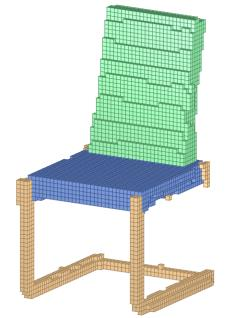

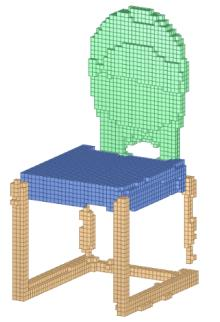

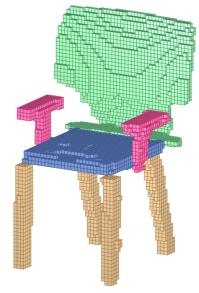

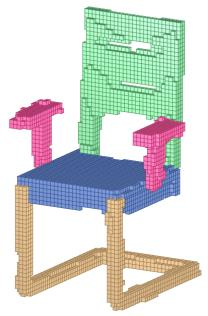

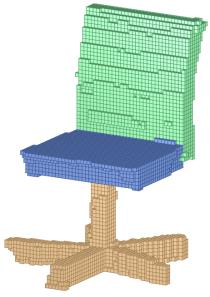

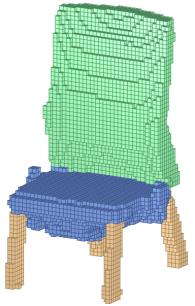

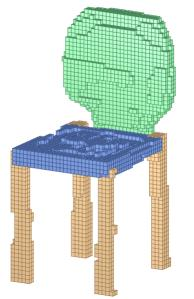

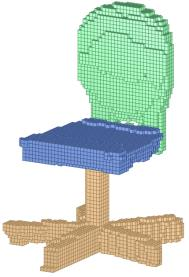

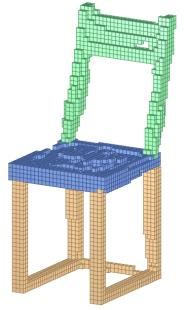

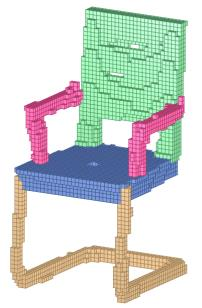

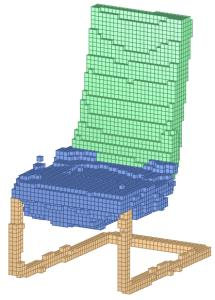

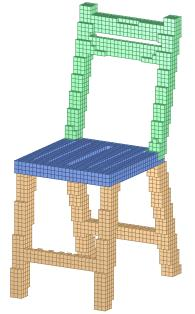

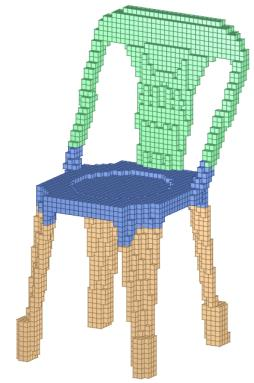

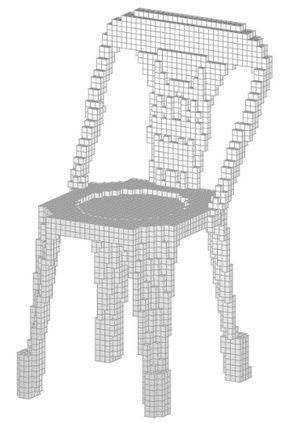

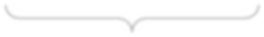

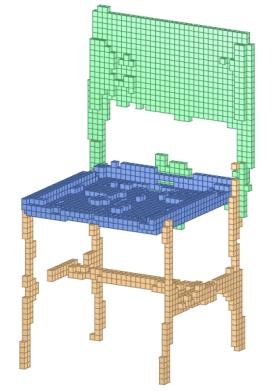

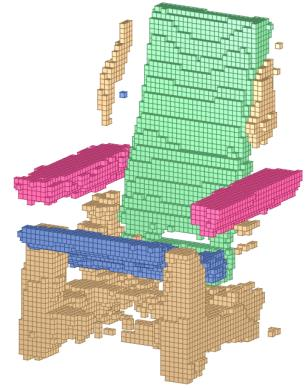

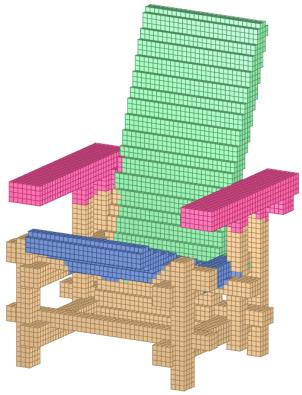

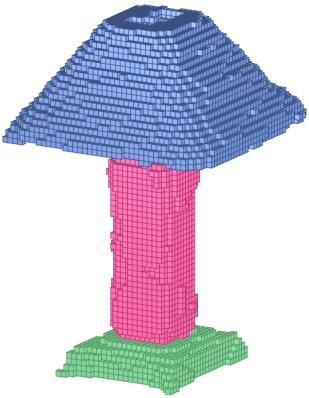

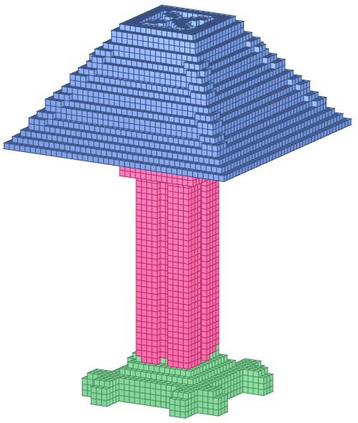

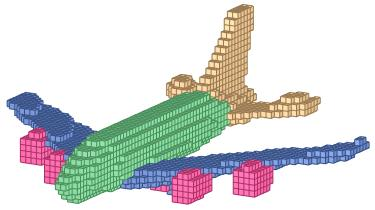

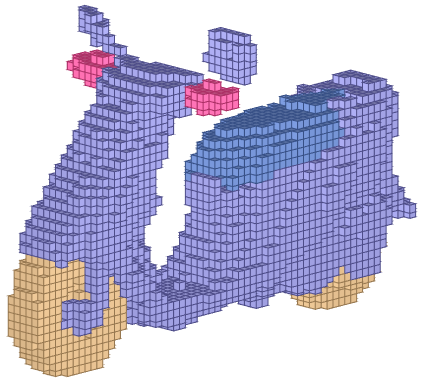

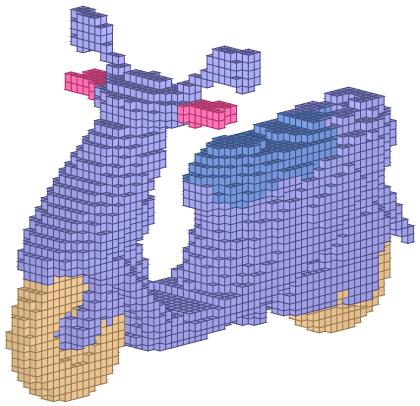

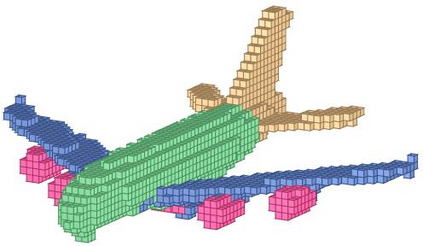

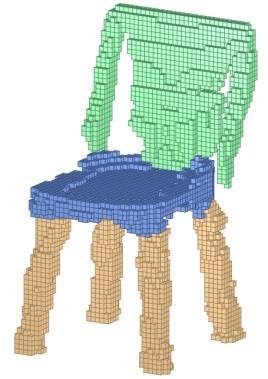

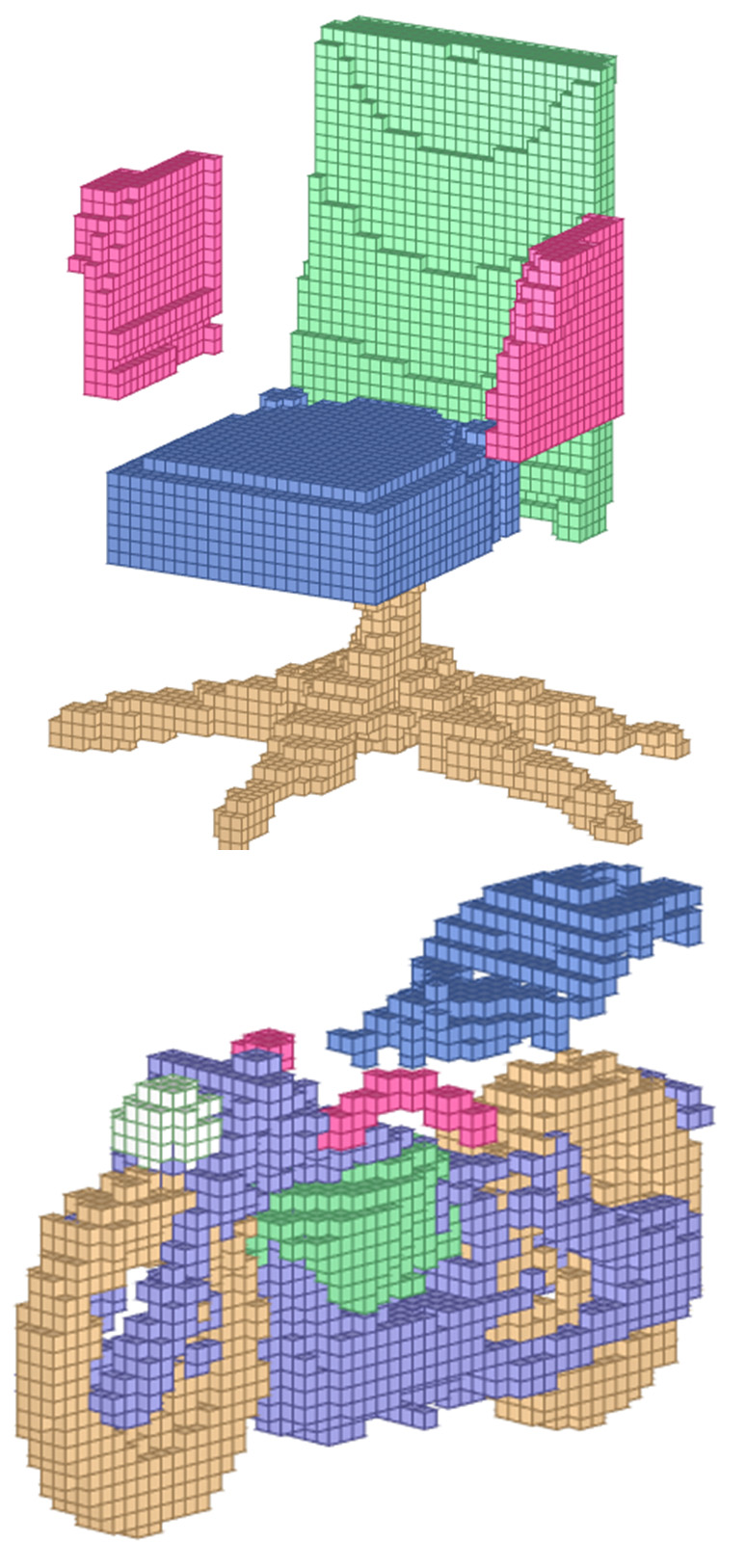

Learning deep generative models for 3D shape synthesis is largely limited by the difficulty of generating plausible shapes with correct topology and reasonable geometry. Indeed, learning the distribution of plausible 3D shapes seems a daunting task for most existing, structure-oblivious shape representation, given the significant topological variations of 3D objects even within the same shape category. Based on the consensus from 3D shape analysis that shape structure is defined as part composition and mutual relations between parts, we propose to model 3D shape variations with a deep generative network being both Part-Aware and Relation-Aware, named PARANet. The network is composed of an array of per-part VAE-GANs, generating semantic parts composing a complete shape, followed by a part assembly module that estimates a transformation for each part to correlate and assemble them into a plausible structure. Through splitting the generation of part composition and part relations into separate networks, the difficulty of modeling structural variations of 3D shapes is greatly reduced. We demonstrate through extensive experiments that PARANet generates 3D shapes with plausible, diverse and detailed structure, and show two prototype applications: semantic shape segmentation and shape set evolution.

翻译:3D 形状合成的深层基因化模型主要由于难以生成具有正确地形学和合理几何特征的貌似正象形状而基本受到限制。事实上,学习可信的3D形状的分布对于大多数现有的、结构上明显可见的形状代表体来说似乎是一项艰巨的任务,因为即使在同一形状类别中,3D 物体也存在着巨大的地形变异。基于3D 形状分析所达成的共识,即形状结构的形成被定义为组成部分的构成和各个部分之间的关系,我们建议模型3D 形状变异,一个深层次的基因变异网络,即称为PARANet的Part-Aware和Relation-Aware。这个网络由每部分VAE-GANs组成的一组阵列组成,产生完全形状的语义化部分,然后形成一个部分组合单元,估计每个部分的变异性,将其组合成一个合理的结构结构。通过将部件的构成和部分关系的形成分开的网络,将3D形状变形的模型化难度大为减少。我们通过广泛的实验证明,PARNet产生3D 形状的形状是合理、多样化和详细的结构。