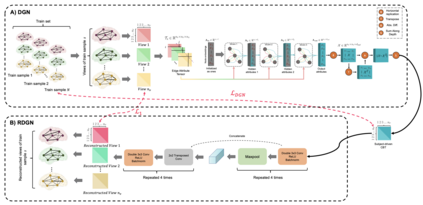

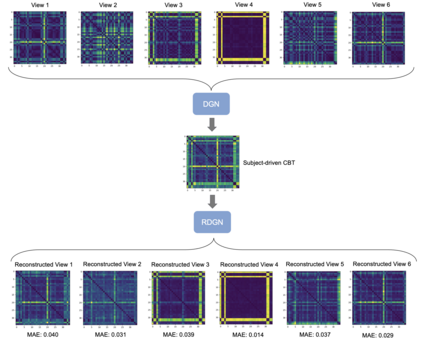

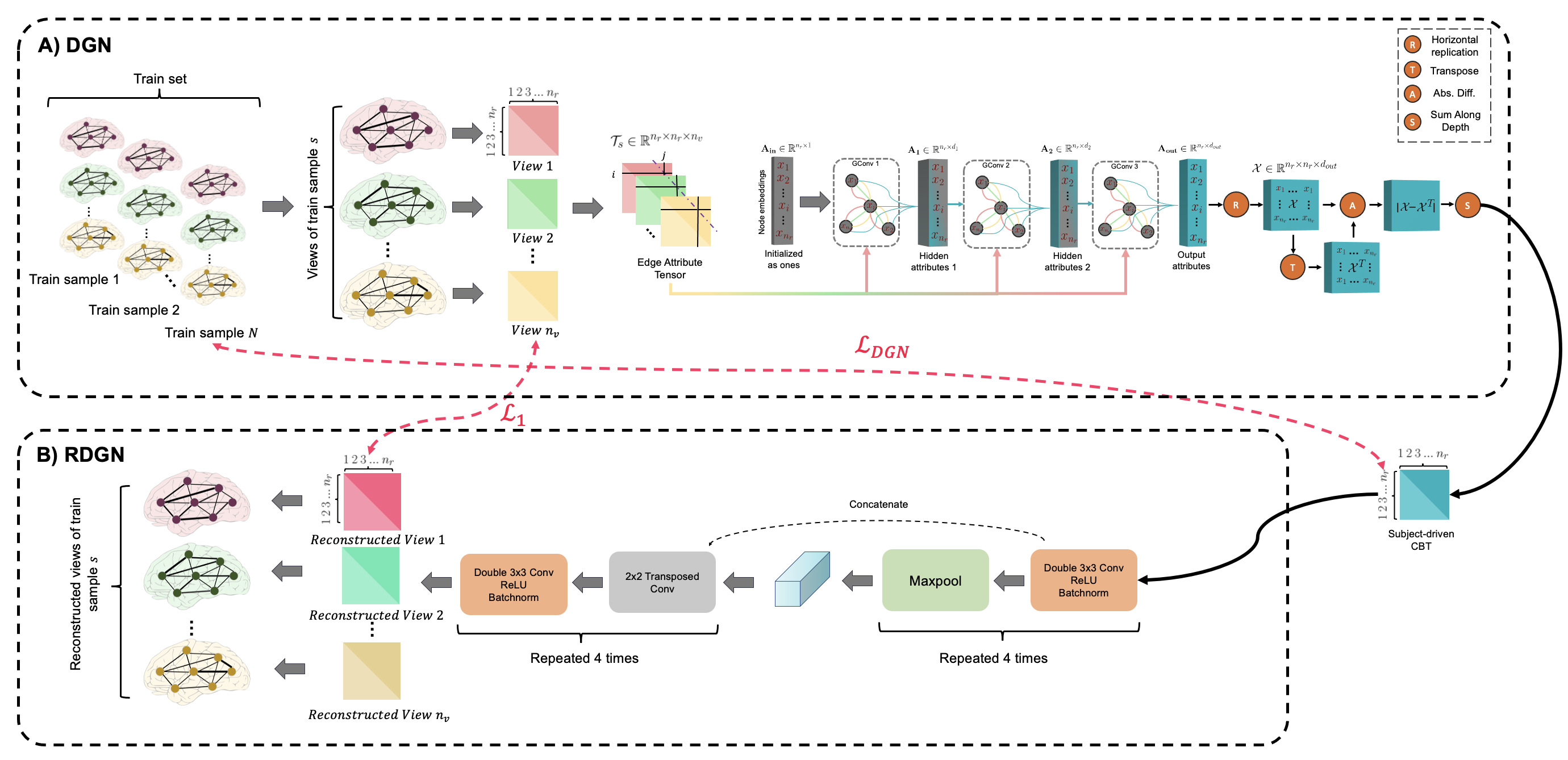

A central challenge in training one-shot learning models is the limited representativeness of the available shots of the data space. Particularly in the field of network neuroscience where the brain is represented as a graph, such models may lead to low performance when classifying brain states (e.g., typical vs. autistic). To cope with this, most of the existing works involve a data augmentation step to increase the size of the training set, its diversity and representativeness. Though effective, such augmentation methods are limited to generating samples with the same size as the input shots (e.g., generating brain connectivity matrices from a single shot matrix). To the best of our knowledge, the problem of generating brain multigraphs capturing multiple types of connectivity between pairs of nodes (i.e., anatomical regions) from a single brain graph remains unsolved. In this paper, we unprecedentedly propose a hybrid graph neural network (GNN) architecture, namely Multigraph Generator Network or briefly MultigraphGNet, comprising two subnetworks: (1) a many-to-one GNN which integrates an input population of brain multigraphs into a single template graph, namely a connectional brain temple (CBT), and (2) a reverse one-to-many U-Net network which takes the learned CBT in each training step and outputs the reconstructed input multigraph population. Both networks are trained in an end-to-end way using a cyclic loss. Experimental results demonstrate that our MultigraphGNet boosts the performance of an independent classifier when trained on the augmented brain multigraphs in comparison with training on a single CBT from each class. We hope that our framework can shed some light on the future research of multigraph augmentation from a single graph. Our MultigraphGNet source code is available at https://github.com/basiralab/MultigraphGNet.

翻译:培训一发学习模型的一个中心挑战在于数据空间现有镜头的代表性有限。 特别是在网络神经科学领域, 大脑以图表形式呈现, 这样的模型在对大脑状态进行分类( 例如典型对自闭症) 时可能导致性能低。 要解决这个问题, 大部分现有作品都包含数据增强步骤, 以增加培训数据集的规模、 其多样性和代表性。 尽管这种增强方法有效, 仅限于生成与输入镜头大小相同的样本( 例如, 从单一镜头矩阵中生成脑连接矩阵矩阵矩阵矩阵矩阵矩阵 ) 。 据我们所知, 生成从单一大脑状态( 典型对自闭症( 典型对自闭症区域) 进行分类时, 生成大脑多面图的多种类型连接问题。 在本文中, 我们史前所未有的混合图形网络( GNNN) 架构, 即多面图像生成网络, 由两个子网络组成的多面网络组成:(1) 从一个直径网络中生成一个直径直径网络, 从一个直径直径网络到一个直径网络, 将一个直径直径直径直径网络连接到一个直径直径网络。