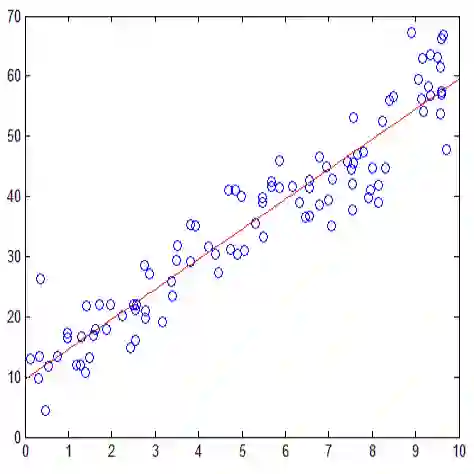

Regression models that ignore measurement error in predictors may produce highly biased estimates leading to erroneous inferences. It is well known that it is extremely difficult to take measurement error into account in Gaussian nonparametric regression. This problem becomes tremendously more difficult when considering other families such as logistic regression, Poisson and negative-binomial. For the first time, we present a method aiming to correct for measurement error when estimating regression functions flexibly covering virtually all distributions and link functions regularly considered in generalized linear models. This approach depends on approximating the first and the second moment of the response after integrating out the true unobserved predictors in a semiparametric generalized linear model. Unlike previous methods, this method is not restricted to truncated splines and can utilize various basis functions. Through extensive simulation studies, we study the performance of our method under many scenarios.

翻译:众所周知,在高西亚的非参数回归中,很难将测量错误考虑在内。这个问题在考虑后勤回归、Poisson和负二成形等其他家庭时变得极为困难。我们第一次提出一种方法,旨在纠正测量错误,因为要灵活地估计在一般线性模型中经常考虑的几乎所有分布和连接功能的回归功能。这种方法取决于在将真实的未观测到的预测器纳入半参数通用线性模型后,对反应的第一和第二时刻进行近似一致。与以往的方法不同,这种方法不局限于断裂的样条,而是可以使用各种基础功能。我们通过广泛的模拟研究,研究我们在许多情景下的方法的性能。