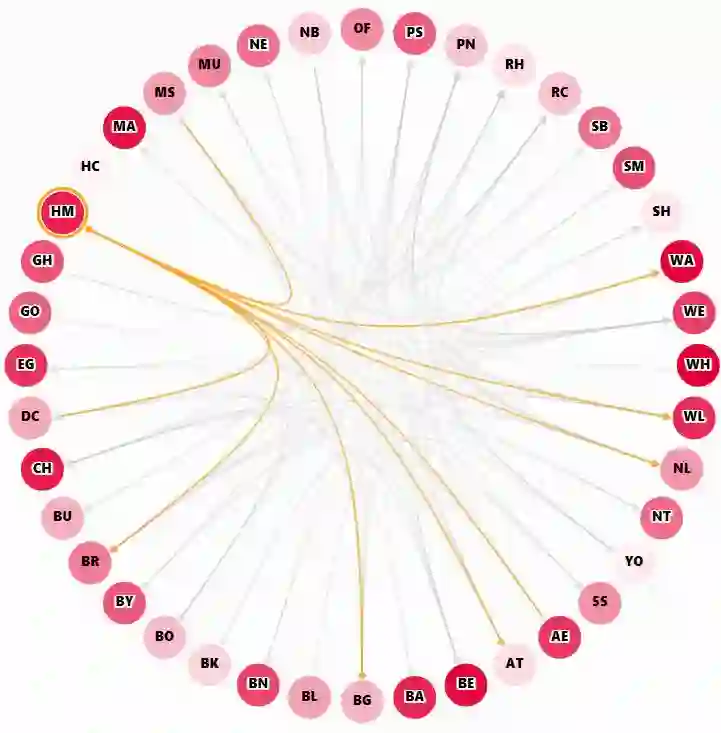

Objects are usually associated with multiple attributes, and these attributes often exhibit high correlations. Modeling complex relationships between attributes poses a great challenge for multi-attribute learning. This paper proposes a simple yet generic framework named Label2Label to exploit the complex attribute correlations. Label2Label is the first attempt for multi-attribute prediction from the perspective of language modeling. Specifically, it treats each attribute label as a "word" describing the sample. As each sample is annotated with multiple attribute labels, these "words" will naturally form an unordered but meaningful "sentence", which depicts the semantic information of the corresponding sample. Inspired by the remarkable success of pre-training language models in NLP, Label2Label introduces an image-conditioned masked language model, which randomly masks some of the "word" tokens from the label "sentence" and aims to recover them based on the masked "sentence" and the context conveyed by image features. Our intuition is that the instance-wise attribute relations are well grasped if the neural net can infer the missing attributes based on the context and the remaining attribute hints. Label2Label is conceptually simple and empirically powerful. Without incorporating task-specific prior knowledge and highly specialized network designs, our approach achieves state-of-the-art results on three different multi-attribute learning tasks, compared to highly customized domain-specific methods. Code is available at https://github.com/Li-Wanhua/Label2Label.

翻译:对象通常与多个属性相关, 这些属性通常显示高关联性 。 建模属性之间的复杂关系会给多个属性学习带来巨大的挑战 。 本文提出一个简单而通用的框架, 名为 Label2Label, 以利用复杂的属性关联。 Label2Label 是首次尝试从语言建模的角度进行多属性预测。 具体地说, 它将每个属性标签作为描述样本的“ 字” 。 由于每个样本都带有多个属性标签附加说明, 这些“ 字” 自然会形成一个未排序但有意义的“ 表示 ”, 描述相应样本的语义信息。 受到NLP、 Label2Label 预培训语言模型的显著成功启发, 利用复合属性关联关系。 Label 2 引入了一个以图像为条件的隐蔽语言模型, 随机遮盖了标签“ 字典” 的“ 字典” 标语义, 目的是根据隐藏的“ 感官” 和图像特征传递的语义, 我们的直觉显示频带关系会很好地理解, 如果线网网内网内网内可以比较缺失的属性, 、 基础化、 和高级域域域域域域里、 学习、 、 、 、 和深域里、 、 、 分解、 等、 、 等、 、 等、 、 、 等、 、 、 、 、 、 等、 、 、 、 、 、 、 等、 等、 等、 、 、 、 、 、 、 、 、 等、 、 、 、 、 、 、 等、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 等、 、 、 、 、 、 、 、 、 、 、 、 、 等、 、 、 、 、 、 、 、 、 、 、 、 、 、 、 等、 、 、