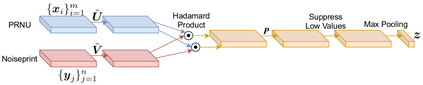

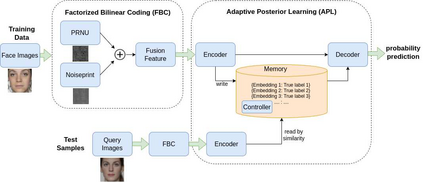

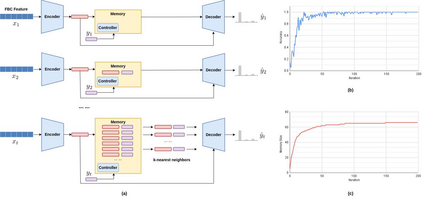

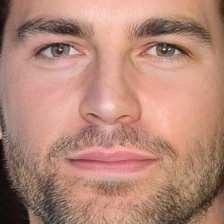

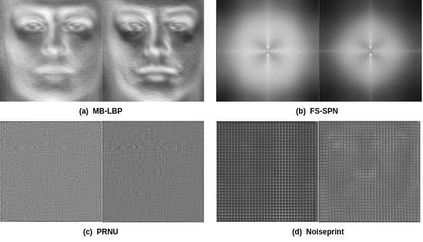

The vulnerability of face recognition systems to morphing attacks has posed a serious security threat due to the wide adoption of face biometrics in the real world. Most existing morphing attack detection (MAD) methods require a large amount of training data and have only been tested on a few predefined attack models. The lack of good generalization properties, especially in view of the growing interest in developing novel morphing attacks, is a critical limitation with existing MAD research. To address this issue, we propose to extend MAD from supervised learning to few-shot learning and from binary detection to multiclass fingerprinting in this paper. Our technical contributions include: 1) We propose a fusion-based few-shot learning (FSL) method to learn discriminative features that can generalize to unseen morphing attack types from predefined presentation attacks; 2) The proposed FSL based on the fusion of the PRNU model and Noiseprint network is extended from binary MAD to multiclass morphing attack fingerprinting (MAF). 3) We have collected a large-scale database, which contains five face datasets and eight different morphing algorithms, to benchmark the proposed few-shot MAF (FS-MAF) method. Extensive experimental results show the outstanding performance of our fusion-based FS-MAF. The code and data will be publicly available at https://github.com/nz0001na/mad maf.

翻译:由于在现实世界中广泛采用面对面生物鉴别技术,面部识别系统对变形攻击的脆弱性已构成严重的安全威胁。大多数现有的变形攻击探测方法需要大量的训练数据,并且仅用几个预先定义的攻击模型进行测试。缺乏良好的概括性特性,特别是鉴于人们越来越关注发展新的变形攻击,这是现有MAD研究的一个严重限制。为了解决这一问题,我们建议将MAD从监督学习扩大到少发的学习,从二进制检测扩大到本文中的多级指纹。我们的技术贡献包括:(1) 我们建议采用基于聚变的点数检测方法,以学习能够概括为隐蔽的变形攻击类型与预定义的攻击模型进行测试的区别性特征;(2) 以PRNU模型和Niseprint网络的融合为基础的拟议FSLFSL扩大至多级变形攻击指纹(MAF)。我们收集了一个大型数据库,其中包含五张面数据集和八种不同的变形图解。我们提出的FSFSMM-MA的模型模型将用来测定我们现有的杰出的MFS-MA结果。