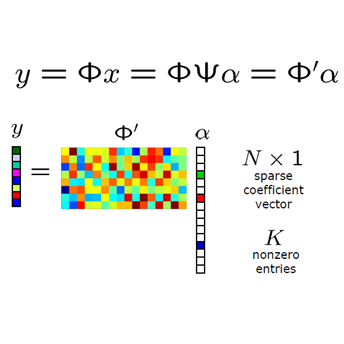

By integrating certain optimization solvers with deep neural network, deep unfolding network (DUN) has attracted much attention in recent years for image compressed sensing (CS). However, there still exist several issues in existing DUNs: 1) For each iteration, a simple stacked convolutional network is usually adopted, which apparently limits the expressiveness of these models. 2) Once the training is completed, most hyperparameters of existing DUNs are fixed for any input content, which significantly weakens their adaptability. In this paper, by unfolding the Fast Iterative Shrinkage-Thresholding Algorithm (FISTA), a novel fast hierarchical DUN, dubbed FHDUN, is proposed for image compressed sensing, in which a well-designed hierarchical unfolding architecture is developed to cooperatively explore richer contextual prior information in multi-scale spaces. To further enhance the adaptability, series of hyperparametric generation networks are developed in our framework to dynamically produce the corresponding optimal hyperparameters according to the input content. Furthermore, due to the accelerated policy in FISTA, the newly embedded acceleration module makes the proposed FHDUN save more than 50% of the iterative loops against recent DUNs. Extensive CS experiments manifest that the proposed FHDUN outperforms existing state-of-the-art CS methods, while maintaining fewer iterations.

翻译:通过将某些优化求解器与深神经网络相结合,深显网络近年来在图像压缩感测方面引起了许多关注。然而,现有DUN中仍然存在若干问题:1)对于每个迭代,通常采用简单的堆叠式连锁网络,这显然限制了这些模型的清晰度。 2)培训完成后,现有DUN的大多数超光度计都固定在任何输入内容上,这大大削弱了其适应性。在本文件中,通过推出快速超超常缩小度-微积分控Algorithm(FISTA),为图像压缩感测提议了一个新型快速级DUN(称为FHDUN),其中提出了设计完善的层次扩展结构,以便在多尺度空间合作探索更丰富的先前背景信息。为了进一步加强适应性,在我们的框架中开发了一系列超光度生成网络,以便根据输入内容动态生成相应的最佳超光度度计。此外,由于FISTA的加速政策,新嵌入的加速度加速度DUN模块使得拟议的FHDUN加速度模块能够比现有的CMLFDS模型保存比现有的50 %。