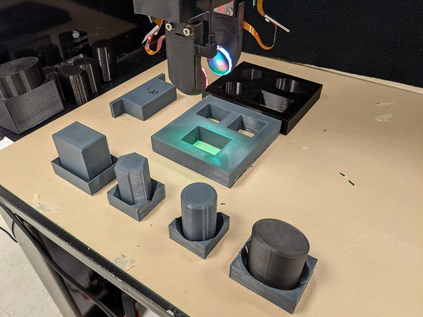

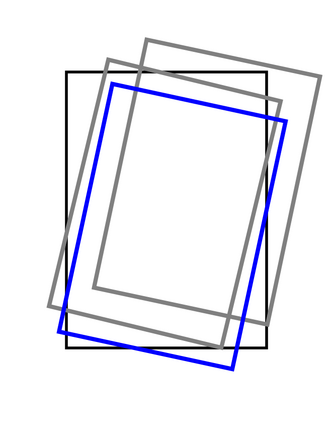

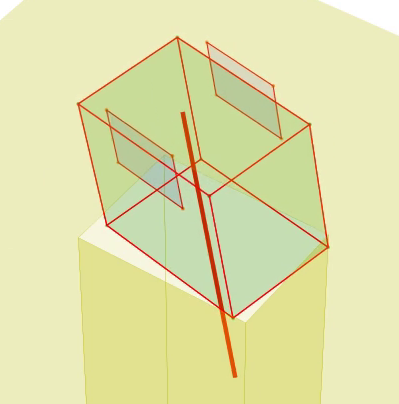

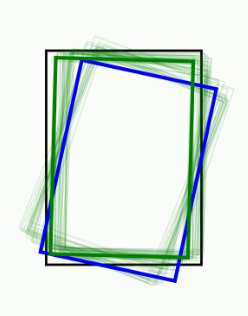

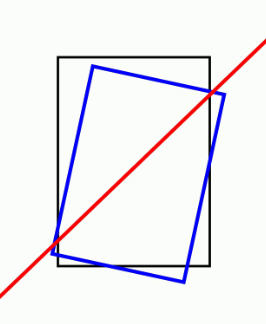

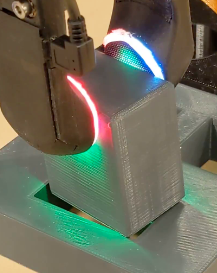

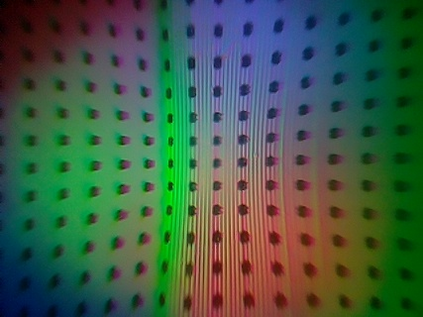

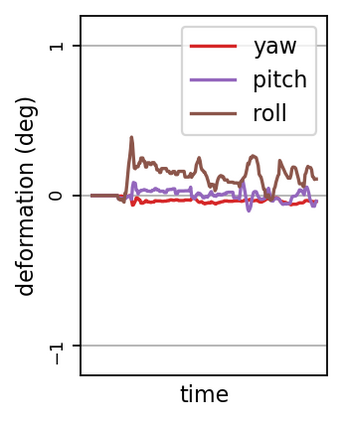

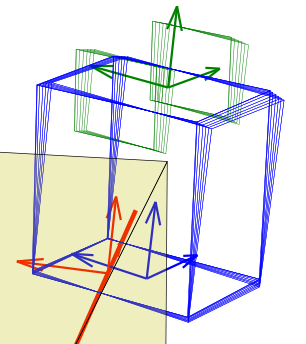

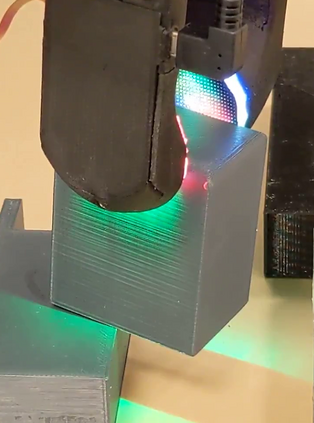

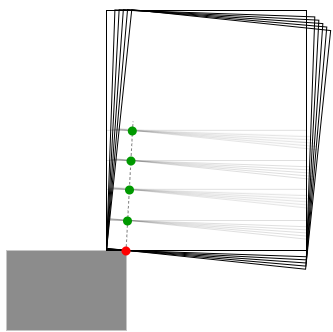

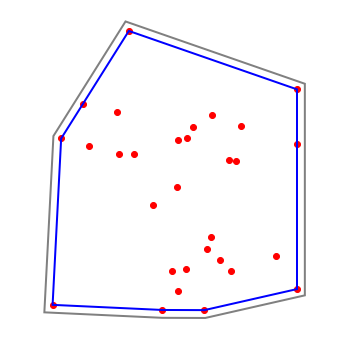

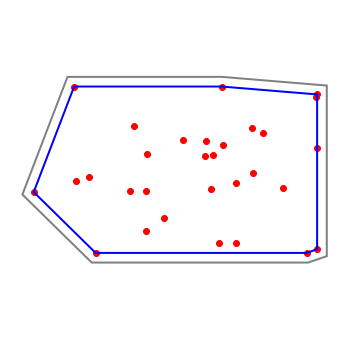

We propose a method that actively estimates the location of contact between a grasped rigid object and its environment, and uses this as input to a peg-in-hole insertion policy. An estimation model and an active tactile feedback controller work collaboratively to get an accurate estimate of the external contacts. The controller helps the estimation model get a better estimate by regulating a consistent contact mode. The better estimation makes it easier for the controller to regulate the contact. To utilize this contact estimate, we train an object-agnostic insertion policy that learns to make use of the series of contact estimates to guide the insertion. In contrast with previous works that learn a policy directly from tactile signals, since this policy is in contact configuration space, can be learned directly in simulation. Lastly, we demonstrate and evaluate the active extrinsic contact line estimation and the trained insertion policy together in a real experiment. We show that the proposed method inserts various-shaped test objects with higher success rates and fewer insertion attempts than previous work with end-to-end approaches. See supplementary video and results at https://sites.google.com/view/active-extrinsic-contact.

翻译:我们提出一种方法,积极估计被抓住的僵硬物体及其环境之间的接触位置,并将这一方法作为输入输入嵌入孔内插入政策。一个估计模型和一个活跃的触觉反馈控制器协作工作,以获得对外部接触的准确估计。控制器通过管理一个一致的接触模式,帮助估计模型得到更好的估计。更好的估计使控制器更容易调节接触。为了利用这一接触估计,我们培训了一种对象-神学插入政策,该政策学会使用一系列接触估计来指导插入。与以前直接从触觉信号中学习政策的工作形成对比的是,由于该政策处于接触配置空间,因此可以在模拟中直接学习。最后,我们演示和评价活跃的外部接触线估计和经过培训的插入政策,在真正的实验中,我们显示拟议的方法插入了不同形状的测试对象,成功率较高,插入的插入尝试次数少于以往与终端-终端方法相比。见以下网站的补充视频和结果:https://sites.gogle.com/active/explins-contactact。