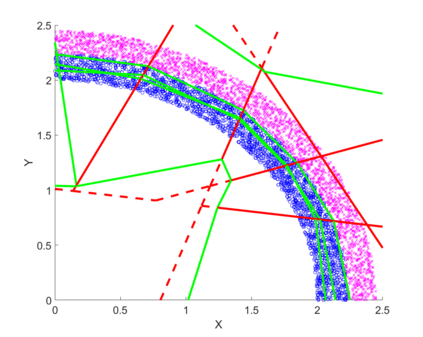

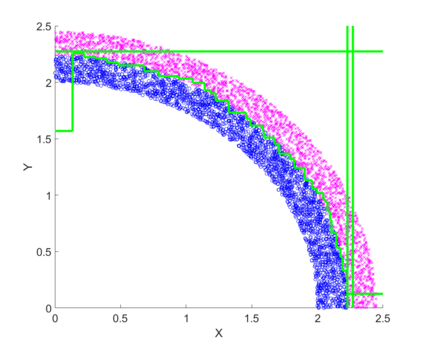

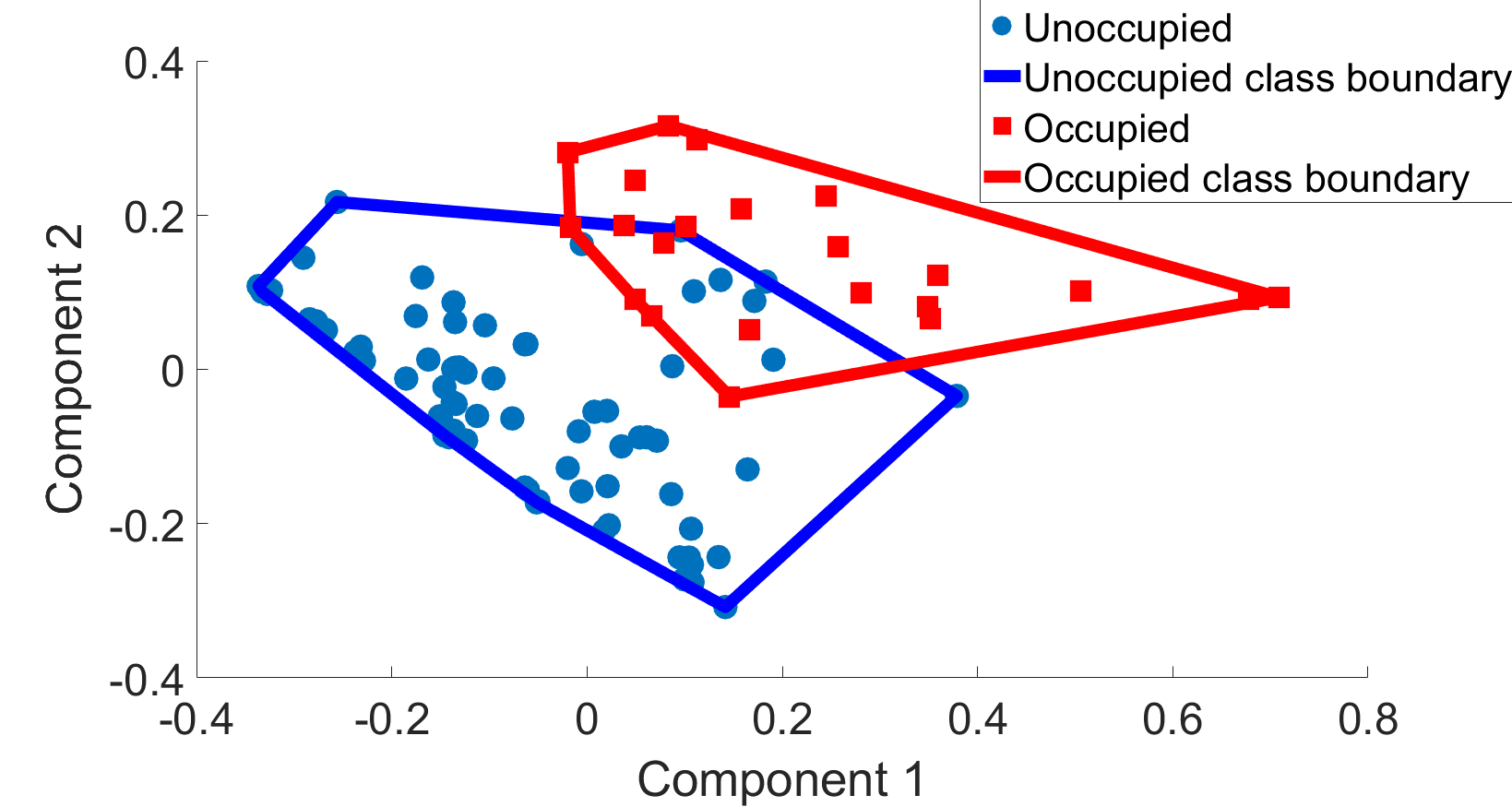

Deep neural networks (DNNs) are commonly labelled as black-boxes lacking interpretability; thus, hindering human's understanding of DNNs' behaviors. A need exists to generate a meaningful sequential logic for the production of a specific output. Decision trees exhibit better interpretability and expressive power due to their representation language and the existence of efficient algorithms to generate rules. Growing a decision tree based on the available data could produce larger than necessary trees or trees that do not generalise well. In this paper, we introduce two novel multivariate decision tree (MDT) algorithms for rule extraction from a DNN: an Exact-Convertible Decision Tree (EC-DT) and a Deep C-Net algorithm to transform a neural network with Rectified Linear Unit activation functions into a representative tree which can be used to extract multivariate rules for reasoning. While the EC-DT translates the DNN in a layer-wise manner to represent exactly the decision boundaries implicitly learned by the hidden layers of the network, the Deep C-Net inherits the decompositional approach from EC-DT and combines with a C5 tree learning algorithm to construct the decision rules. The results suggest that while EC-DT is superior in preserving the structure and the accuracy of DNN, C-Net generates the most compact and highly effective trees from DNN. Both proposed MDT algorithms generate rules including combinations of multiple attributes for precise interpretation of decision-making processes.

翻译:深心神经网络(DNNS)通常被贴上缺乏可解释性的黑盒子;因此,阻碍人类理解DNNs的行为。需要为生产具体产出产生有意义的连续逻辑。决策树因其代表语言和存在高效的逻辑来产生规则,因此显示更清楚和表达能力。在现有数据的基础上种植决策树可以产生大于必要的树木或树木,但不能很好地概括。在本文件中,我们引入了两种新的多变量决定树(MDT)算法,用于从DNN(DN)中提取规则:一种可撤销的决定树(EC-DT)和深C-Net算法,以将具有校正线性线性单位激活功能的线性网络转换为具有代表性的树。这可以用来为推理提取多变量规则。EC-DDDD将DNN值翻译成一个精确的C-NF规则,同时将EC-NT和C-ND的高级解释结果与C-ND规则的C-NF解释结果结合起来。