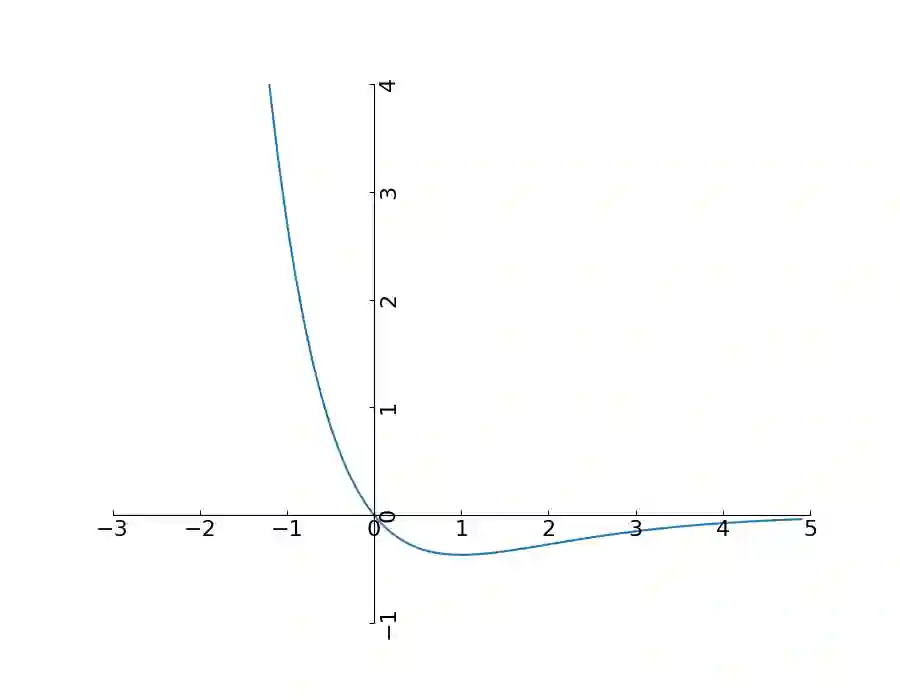

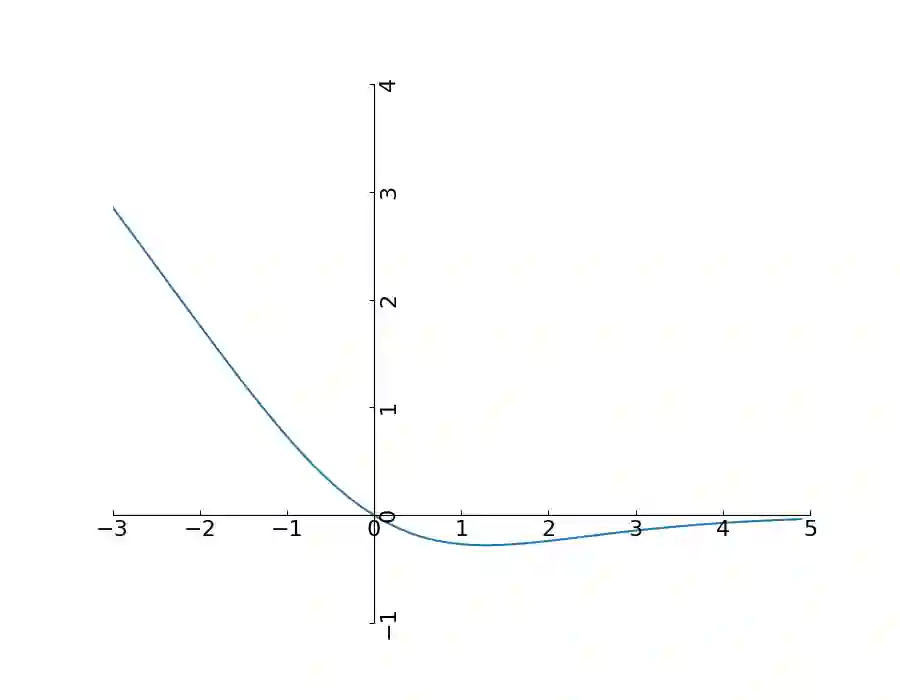

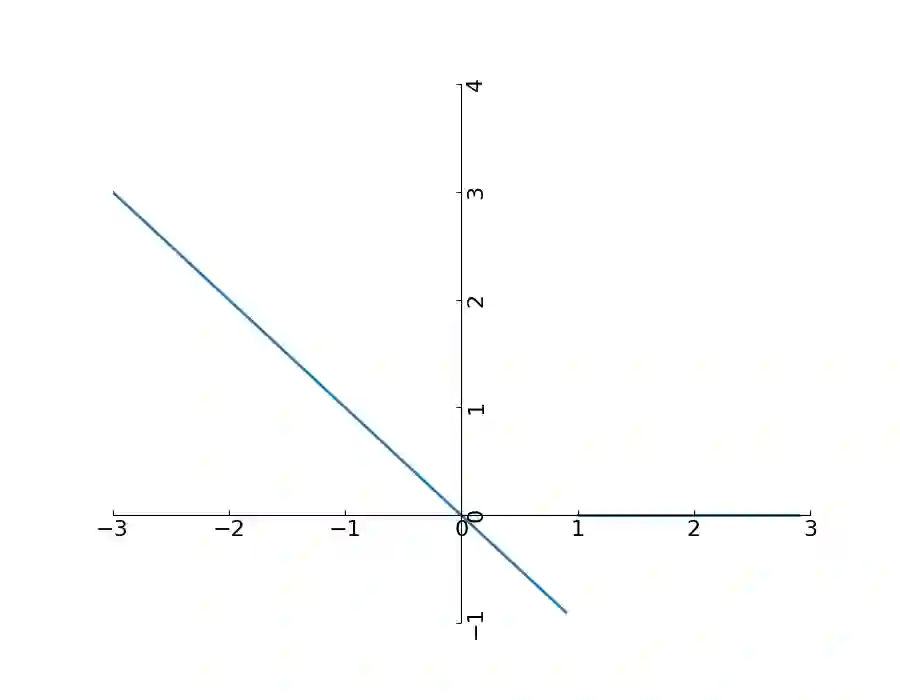

Federated learning frameworks have been regarded as a promising approach to break the dilemma between demands on privacy and the promise of learning from large collections of distributed data. Many such frameworks only ask collaborators to share their local update of a common model, i.e. gradients with respect to locally stored data, instead of exposing their raw data to other collaborators. However, recent optimization-based gradient attacks show that raw data can often be accurately recovered from gradients. It has been shown that minimizing the Euclidean distance between true gradients and those calculated from estimated data is often effective in fully recovering private data. However, there is a fundamental lack of theoretical understanding of how and when gradients can lead to unique recovery of original data. Our research fills this gap by providing a closed-form recursive procedure to recover data from gradients in deep neural networks. We demonstrate that gradient attacks consist of recursively solving a sequence of systems of linear equations. Furthermore, our closed-form approach works as well as or even better than optimization-based approaches at a fraction of the computation, we name it Recursive Gradient Attack on Privacy (R-GAP). Additionally, we propose a rank analysis method, which can be used to estimate a network architecture's risk of a gradient attack. Experimental results demonstrate the validity of the closed-form attack and rank analysis, while demonstrating its superior computational properties and lack of susceptibility to local optima vis a vis optimization-based attacks. Source code is available for download from https://github.com/JunyiZhu-AI/R-GAP.

翻译:联邦学习框架被认为是打破对隐私的需求与从大量收集的分布式数据中学习的希望之间的两难困境的一个很有希望的方法。许多这样的框架只是要求合作者分享其当地对共同模型的更新,即当地储存数据的梯度,而不是将其原始数据暴露给其他合作者。然而,最近基于优化的梯度袭击表明,原始数据往往可以从梯度中准确恢复。事实表明,尽可能缩小真实梯度与估计数据计算出的梯度之间的欧西里德距离,往往能够有效地完全恢复私人数据。然而,对于梯度如何和何时导致独特的原始数据恢复,根本缺乏理论理解。我们的研究填补了这一差距,提供了从深层神经网络的梯度恢复数据的封闭式递归程序。我们证明,基于优化的梯度袭击是反复解决一系列的线性方程式。此外,我们的封闭式方法在部分计算中起作用,甚至比基于优化的方法更好。我们称,对于梯度的梯度是如何导致隐私(R-GAP) 原始数据恢复独特的原始数据。我们提出的一个从系统递增性递增性递增性递增性网络,用来显示其相对性攻击性的递增性结构的递增性分析。我们提出一个从一个系统对地平级的递增性攻击的递增性结构的递增性分析。我们提出了一种方法,用来展示的递增性分析。我们用一种压式的递增级的递增性地级的递增性地的递增性平级的递增性分析。