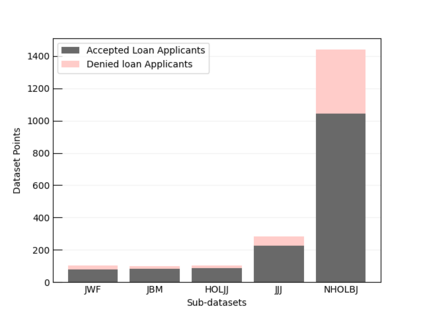

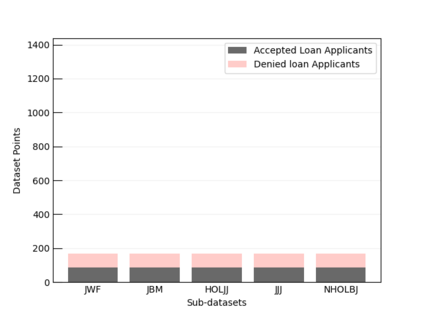

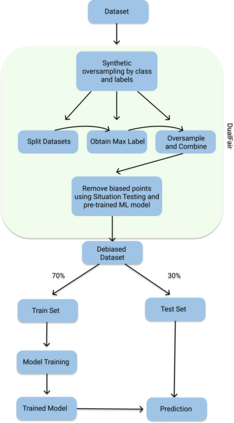

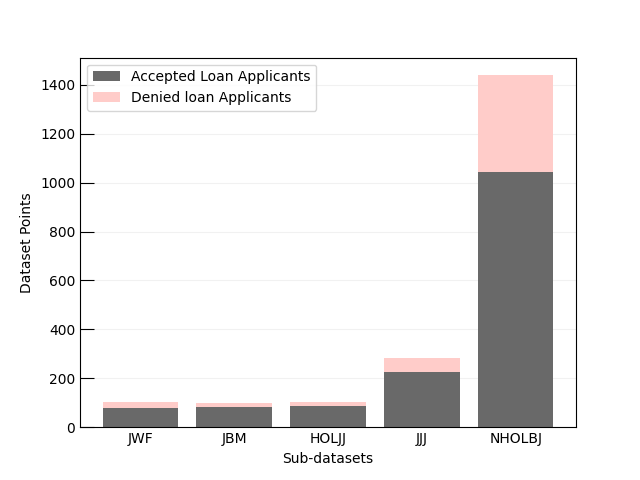

Machine learning (ML) models are increasingly used for high-stake applications that can greatly impact people's lives. Despite their use, these models have the potential to be biased towards certain social groups on the basis of race, gender, or ethnicity. Many prior works have attempted to mitigate this "model discrimination" by updating the training data (pre-processing), altering the model learning process (in-processing), or manipulating model output (post-processing). However, these works have not yet been extended to the realm of multi-sensitive parameters and sensitive options (MSPSO), where sensitive parameters are attributes that can be discriminated against (e.g race) and sensitive options are options within sensitive parameters (e.g black or white), thus giving them limited real-world usability. Prior work in fairness has also suffered from an accuracy-fairness tradeoff that prevents both the accuracy and fairness from being high. Moreover, previous literature has failed to provide holistic fairness metrics that work with MSPSO. In this paper, we solve all three of these problems by (a) creating a novel bias mitigation technique called DualFair and (b) developing a new fairness metric (i.e. AWI) that can handle MSPSO. Lastly, we test our novel mitigation method using a comprehensive U.S mortgage lending dataset and show that our classifier, or fair loan predictor, obtains better fairness and accuracy metrics than current state-of-the-art models.

翻译:机器学习模式(ML)越来越多地用于能够极大地影响人们生活的高级应用。尽管使用这些模式,但这些模式有可能因种族、性别或族裔而偏向某些社会群体。许多以前的工作都试图通过更新培训数据(预处理)、改变示范学习进程(处理中)或操纵模型产出(处理后)来减轻这种“典型歧视 ” 。然而,这些工程尚未扩展到多敏感参数和敏感选项领域(MSPSO),其中敏感参数是可歧视(例如种族)的属性,而敏感选项则是敏感参数(例如黑人或白人)的选项,因此在敏感参数(例如黑人或白人)中具有偏向性,从而使它们具有有限的真实世界可用性。先前的公平工作也因准确性交易(预处理)、改变示范学习进程(处理中处理中)或操纵模型输出(处理后处理)。然而,这些工程尚未扩展到多敏感参数和敏感选项领域(MSPSO)的所有三个问题,即:(a) 创建新的减少偏见技术,而敏感选项则是在敏感参数(例如黑人或白人)之内选择公平性选项,从而获得新的公平度衡量标准(i.