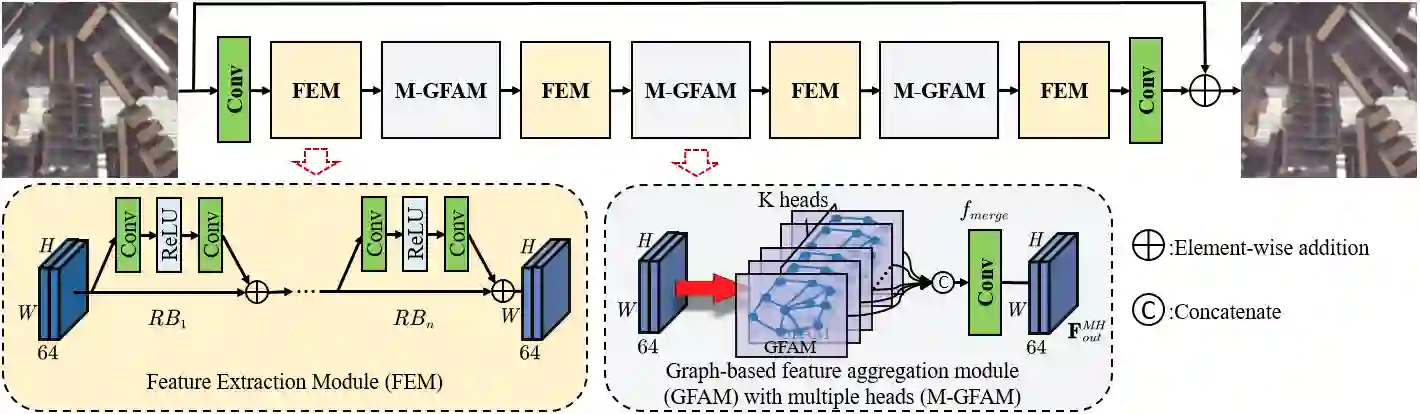

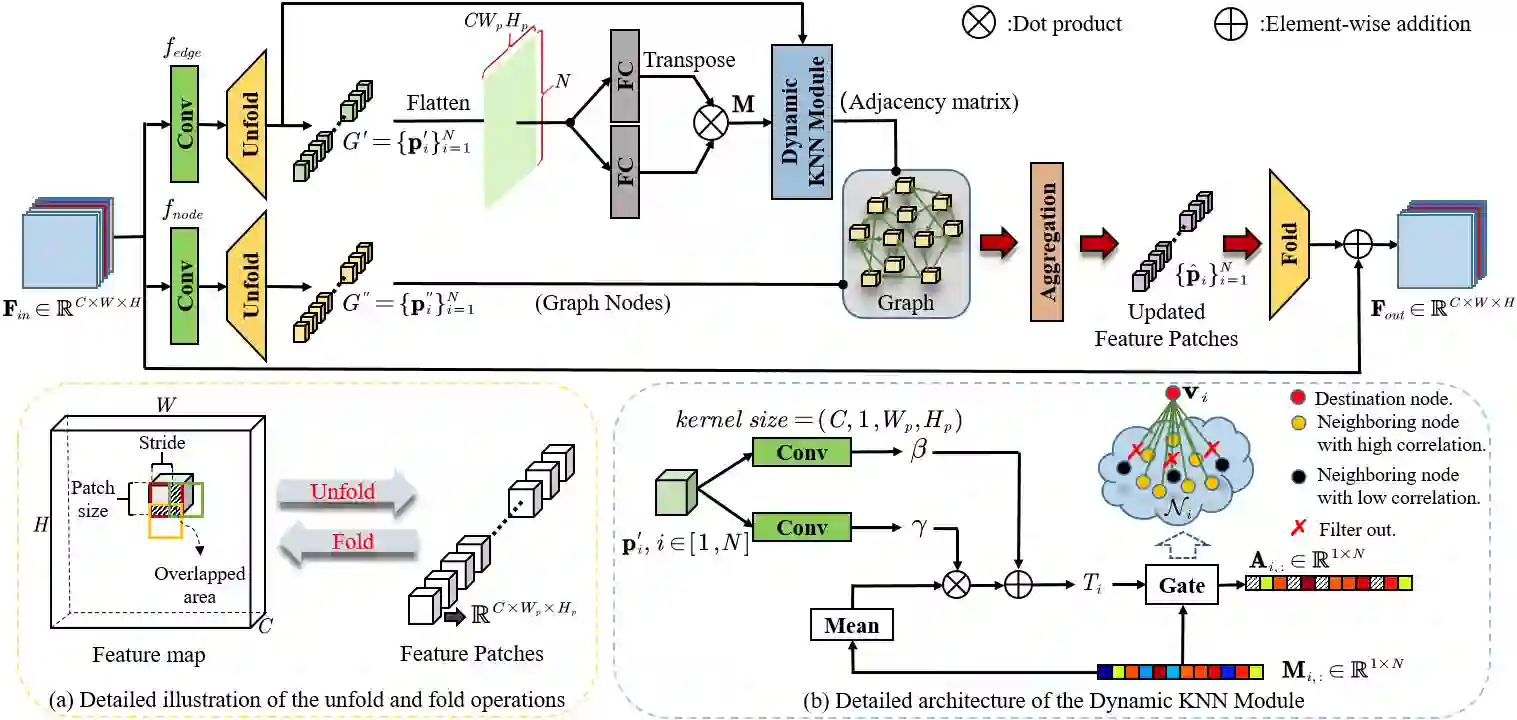

Non-local self-similarity in natural images has been verified to be an effective prior for image restoration. However, most existing deep non-local methods assign a fixed number of neighbors for each query item, neglecting the dynamics of non-local correlations. Moreover, the non-local correlations are usually based on pixels, prone to be biased due to image degradation. To rectify these weaknesses, in this paper, we propose a dynamic attentive graph learning model (DAGL) to explore the dynamic non-local property on patch level for image restoration. Specifically, we propose an improved graph model to perform patch-wise graph convolution with a dynamic and adaptive number of neighbors for each node. In this way, image content can adaptively balance over-smooth and over-sharp artifacts through the number of its connected neighbors, and the patch-wise non-local correlations can enhance the message passing process. Experimental results on various image restoration tasks: synthetic image denoising, real image denoising, image demosaicing, and compression artifact reduction show that our DAGL can produce state-of-the-art results with superior accuracy and visual quality. The source code is available at https://github.com/jianzhangcs/DAGL.

翻译:自然图像的非本地自我相似性已被证实为图像恢复前的有效前程。 然而,大多数现有的深非本地方法都为每个查询项指定固定的邻居数目,忽略了非本地关联的动态。 此外,非本地关联通常基于像素, 容易因图像退化而产生偏差。 为了纠正这些弱点,我们在本文件中提议了一个动态关注图解模型( DAGL), 以探索在图像恢复的补丁水平上的动态非本地属性。 具体地说, 我们提议了一个改进的图形模型, 以对每个节点进行有动态和适应性的相邻点来进行匹配。 这样, 图像内容可以通过连接的邻居数目来适应性地平衡超模和超正版的艺术品, 而偏差的非本地关联可以加强信息传递过程。 各种图像恢复任务的实验结果: 合成图像脱色、 真实图像脱色、 图像解色、 解色、 压缩工艺品减少, 显示我们的 DAGL 能够产生高精度和视觉质量的状态图像结果。 源码源代码可以在 http上 http://qhang/ 。