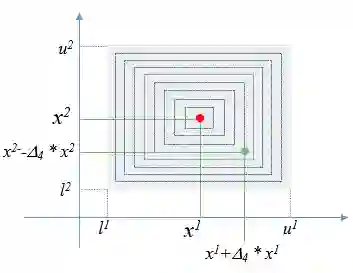

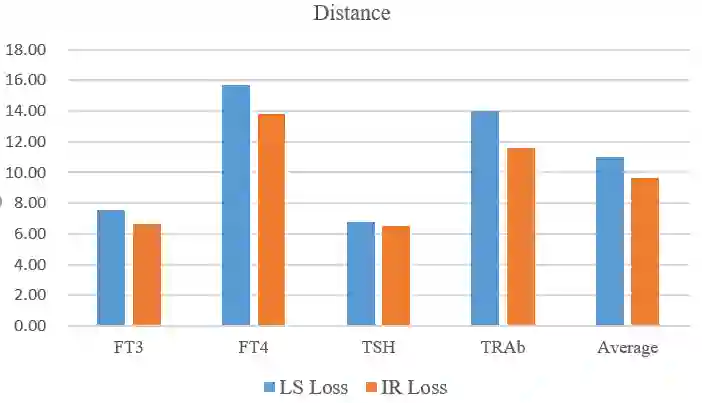

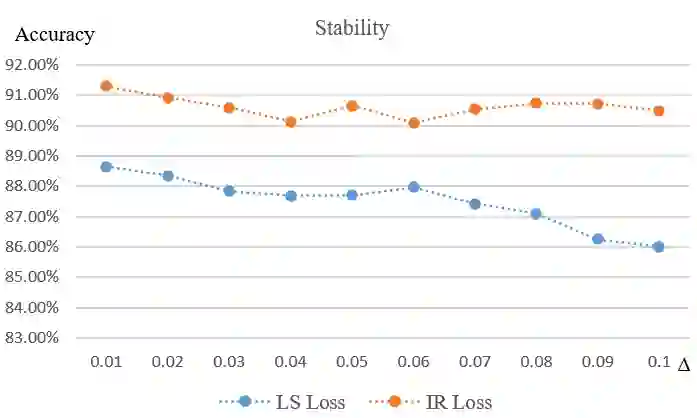

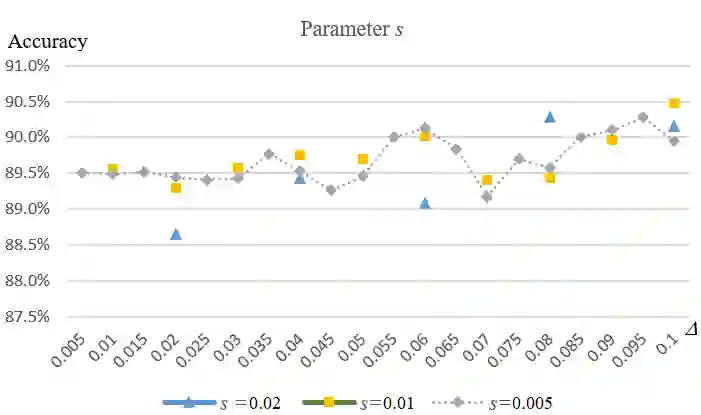

In existing deep learning methods, almost all loss functions assume that sample data values used to be predicted are the only correct ones. This assumption does not hold for laboratory test data. Test results are often within tolerable or imprecision ranges, with all values in the ranges acceptable. By considering imprecision samples, we propose an imprecision range loss (IR loss) method and incorporate it into Long Short Term Memory (LSTM) model for disease progress prediction. In this method, each sample in imprecision range space has a certain probability to be the real value, participating in the loss calculation. The loss is defined as the integral of the error of each point in the impression range space. A sampling method for imprecision space is formulated. The continuous imprecision space is discretized, and a sequence of imprecise data sets are obtained, which is convenient for gradient descent learning. A heuristic learning algorithm is developed to learn the model parameters based on the imprecise data sets. Experimental results on real data show that the prediction method based on IR loss can provide more stable and consistent prediction result when test samples are generated from imprecision range.

翻译:在现有的深层学习方法中,几乎所有损失功能都假定,用于预测的样本数据值是唯一正确的数据值。这一假设对于实验室测试数据来说并不正确。测试结果往往在可容忍或不精确的范围范围内,所有数值都可接受。通过考虑不精确的样本,我们建议采用不精确范围损失(IR损失)方法,并将其纳入长期短期内存模型,用于疾病进展预测。在这种方法中,不精确范围内的每个样本都有一定的概率是实际值,参与损失计算。损失被定义为印象范围内每个点的错误。不精确空间的取样方法得到制定。连续不精确空间是分离的,并获得不精确的数据集序列,这便于梯度脱落学习。开发了超常学习算法,以学习基于不精确的数据集的模型参数。根据真实数据得出的实验结果显示,在测试样品从不精确范围产生时,基于IR损失的预测方法可以提供更稳定、更一致的预测结果。