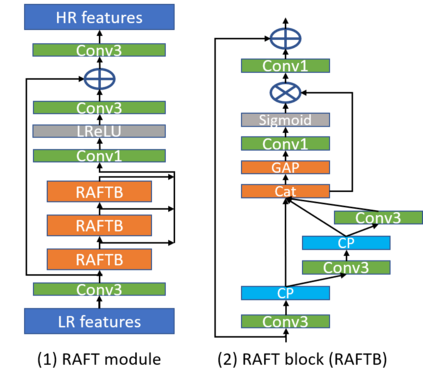

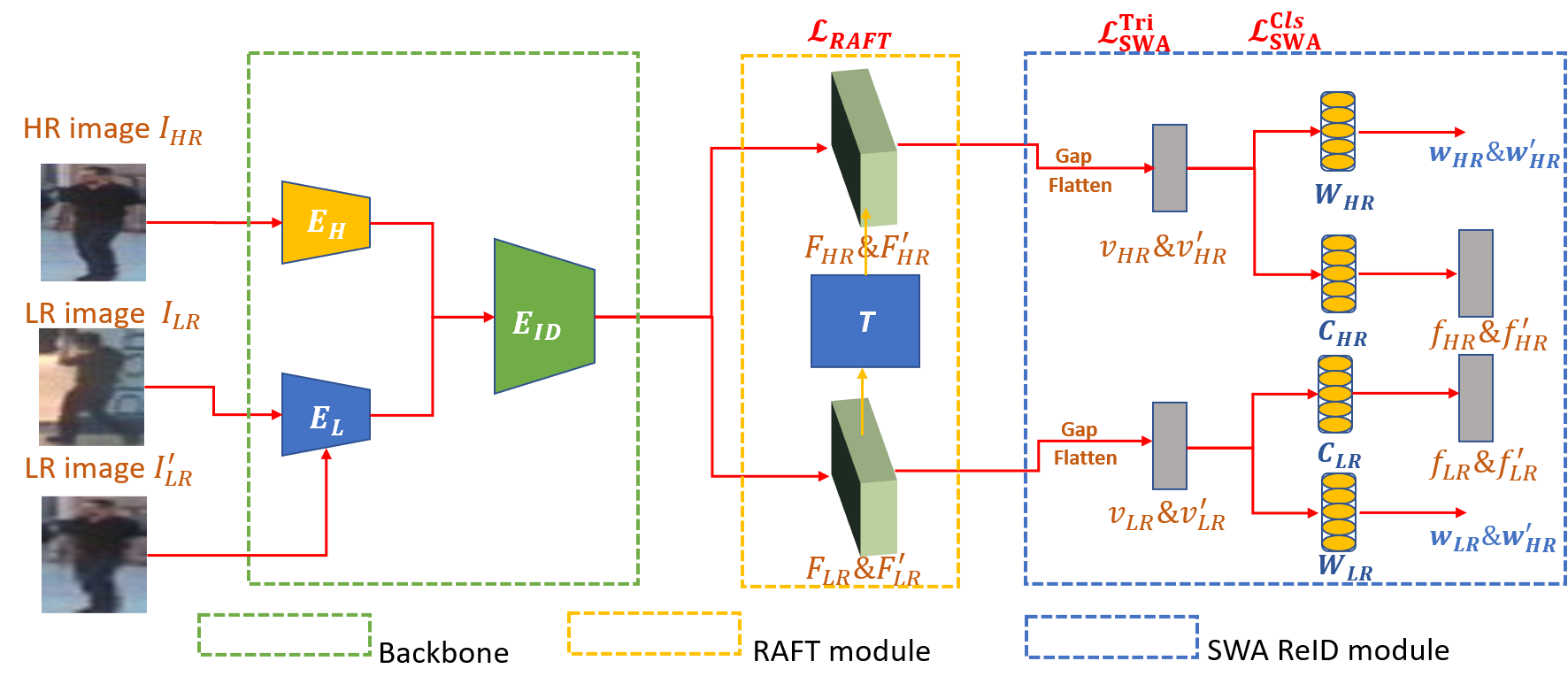

Person Re-identification (ReID) is a critical computer vision task that aims to match the same person in images or video sequences. Most current works focus on settings where resolution is kept the same. However, the resolution is a crucial factor in person ReID when the cameras are at different distances from the person or the camera's model are different from each other. In this paper, we propose a novel two-stream network with a lightweight resolution association ReID feature transformation (RAFT) module and a self-weighted attention (SWA) ReID module to evaluate features under different resolutions. RAFT transforms the low resolution features to corresponding high resolution features. SWA evaluates both features to get weight factors for the person ReID. Both modules are jointly trained to get a resolution invariant representation. Extensive experiments on five benchmark datasets show the effectiveness of our method. For instance, we achieve Rank-1 accuracy of 43.3% and 83.2% on CAVIAR and MLR-CUHK03, outperforming the state-of-the-art.

翻译:个人再识别(ReID)是一项关键的计算机愿景任务,目的是在图像或视频序列中匹配同一个人。当前大多数工作都侧重于分辨率保持不变的设置。然而,当相机与人相距不同或相机模型彼此不同时,分辨率是个人再识别的一个关键因素。在本文中,我们提议建立一个新型双流网络,配有轻量分辨关联 ReID特征变换模块和自加权重力再识别模块,以评价不同分辨率下的特征。RAFT将低分辨率特征转换为相应的高分辨率特征。SWA评估这两个特征,以获得个人再识别的重量系数。两个模块都经过联合培训,以获得分辨率变式表示。对五个基准数据集进行的广泛实验显示了我们的方法的有效性。例如,我们在CAVIAR和MLR-CUHK03上实现了43.3%和83.2%的中位精确度,超过了最新技术。