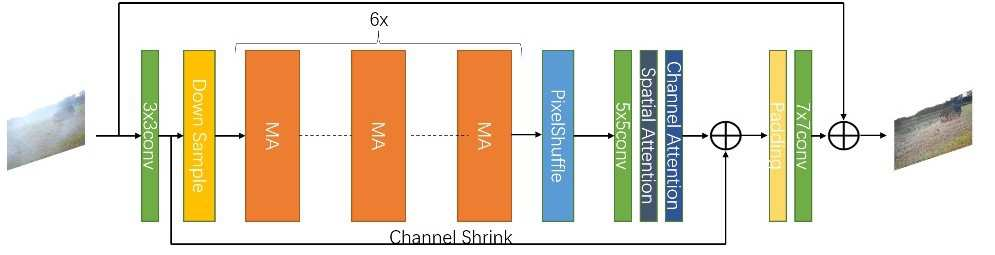

This paper proposes an end-to-end Efficient Re-parameterizationResidual Attention Network(ERRA-Net) to directly restore the nonhomogeneous hazy image. The contribution of this paper mainly has the following three aspects: 1) A novel Multi-branch Attention (MA) block. The spatial attention mechanism better reconstructs high-frequency features, and the channel attention mechanism treats the features of different channels differently. Multi-branch structure dramatically improves the representation ability of the model and can be changed into a single path structure after re-parameterization to speed up the process of inference. Local Residual Connection allows the low-frequency information in the nonhomogeneous area to pass through the block without processing so that the block can focus on detailed features. 2) A lightweight network structure. We use cascaded MA blocks to extract high-frequency features step by step, and the Multi-layer attention fusion tail combines the shallow and deep features of the model to get the residual of the clean image finally. 3)We propose two novel loss functions to help reconstruct the hazy image ColorAttenuation loss and Laplace Pyramid loss. ERRA-Net has an impressive speed, processing 1200x1600 HD quality images with an average runtime of 166.11 fps. Extensive evaluations demonstrate that ERSANet performs favorably against the SOTA approaches on the real-world hazy images.

翻译:本文建议建立一个端到端高效的再校准恢复关注网络(ERRA-Net),以直接恢复非相容的模糊图像。本文件的贡献主要有三个方面:(1) 一个新的多部门注意(MA)块。空间注意机制更好地重建高频特征,频道注意机制对不同频道的特点有不同处理方式。多部门结构极大地提高了模型的代表性能力,在重新校准后可以转换成单一路径结构,以加快推断过程。本地残留连接使非相容图像区中的低频信息能够通过块块,而无需处理,使块子能够专注于详细的特征。(2) 轻量网络结构。我们使用级联式MA块一步一步地提取高频特征,多层注意尾部结合模型的浅深层特征,以最终获得清洁图像的残存。(3) 我们提出两个新的损失功能,以帮助重建湿润图像Colatnuation损失实时图像,并展示SARISA质量图像的平均处理速度。