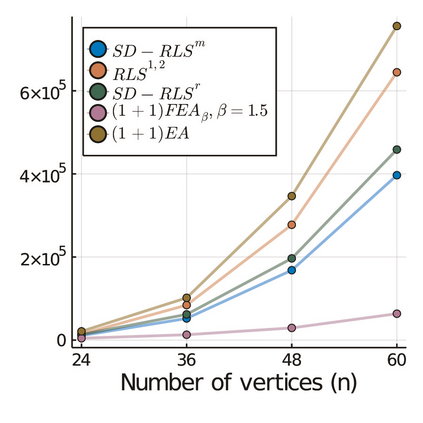

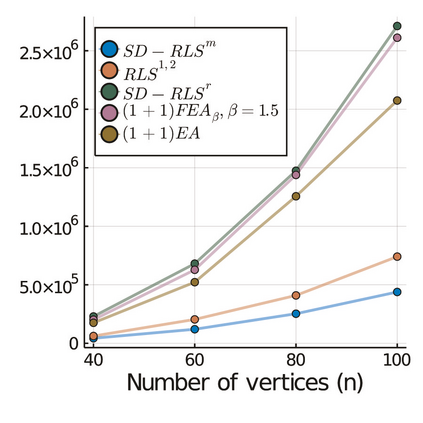

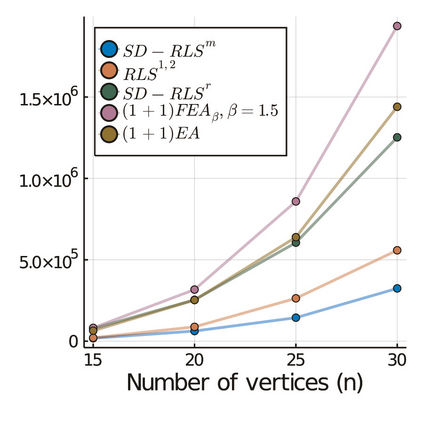

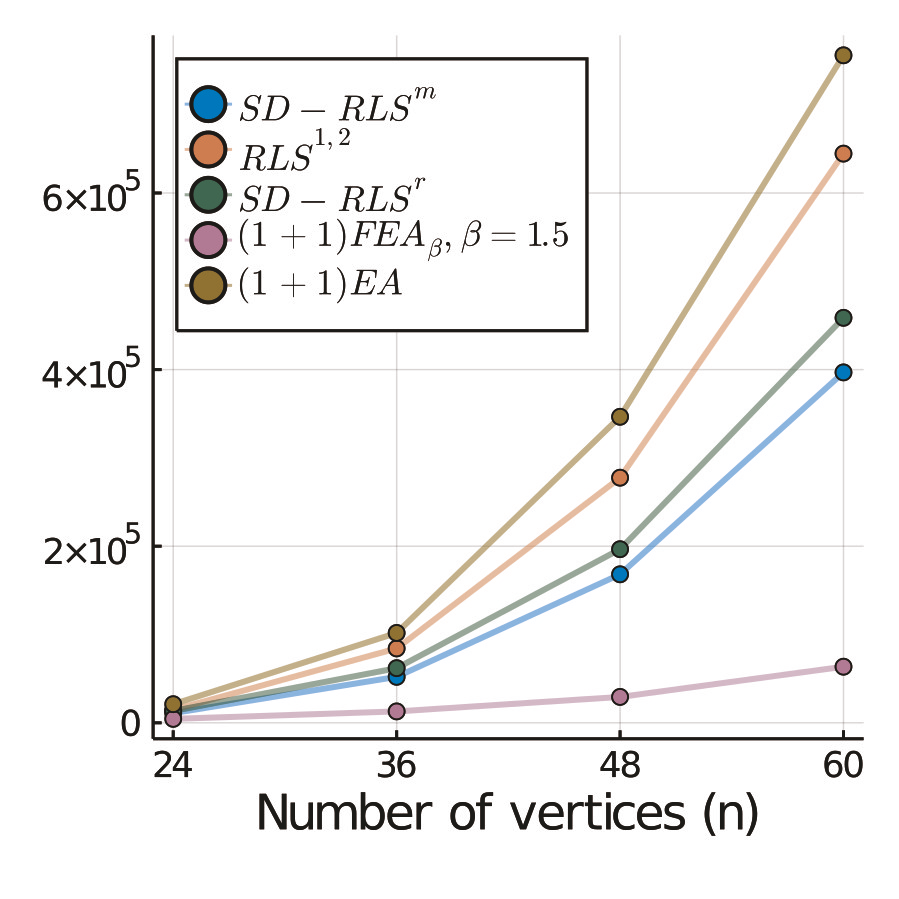

Stagnation detection has been proposed as a mechanism for randomized search heuristics to escape from local optima by automatically increasing the size of the neighborhood to find the so-called gap size, i.e., the distance to the next improvement. Its usefulness has mostly been considered in simple multimodal landscapes with few local optima that could be crossed one after another. In multimodal landscapes with a more complex location of optima of similar gap size, stagnation detection suffers from the fact that the neighborhood size is frequently reset to $1$ without using gap sizes that were promising in the past. In this paper, we investigate a new mechanism called radius memory which can be added to stagnation detection to manage the search radius for each search point based on the last success. We implement this idea in an algorithm called SD-RLS$^{\text{m}}$ and show compared to previous variants of stagnation detection that it yields speed-ups for linear functions under uniform constraints and the minimum spanning tree. Moreover, its running time does not significantly deteriorate on unimodal functions and a generalization of the Jump benchmark. Finally, we present experimental results carried out to study SD-RLS$^{\text{m}}$ and compare it with other algorithms.

翻译:提议检测停滞状态,作为随机随机的搜索超常现象的机制,通过自动增加邻居的体积,找到所谓的差距大小,即距离到下一个改进的距离,从而逃离本地的偏差,以摆脱本地的偏差。其效用大多在简单的多式联运环境中得到考虑,因为本地的偏差很少,可以相互交叉。在比较复杂的偏差大小相似的多式联运环境中,检测停滞状态的特征是,邻里大小经常被重新设置为1美元,而没有使用过去充满希望的空白大小。在本文中,我们调查一个称为半径内存的新机制,可以添加到停滞探测中,以管理基于最后成功结果的每个搜索点的搜索半径。我们用一种称为SD-RLS${text{m ⁇ {m ⁇ $的算法来实施这一想法,并与以往的停滞检测变式相比显示,在统一限制和最小的树线性功能下,其运行时间不会因单式功能和跳动基准而大大恶化。最后,我们提出实验结果,以SD-RLS${text{{{{{{{{{{{{{{{{{{{{{{{{{{{{{}